Jak scrapować Goodreads: Kompletny przewodnik po web scrapingu 2025

Dowiedz się, jak scrapować dane o książkach, recenzje i oceny z Goodreads w 2025 roku. Przewodnik obejmuje obchodzenie systemów anti-bot, przykłady kodu Python...

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- DataDome

- Wykrywanie botów w czasie rzeczywistym za pomocą modeli ML. Analizuje odcisk urządzenia, sygnały sieciowe i wzorce zachowań. Częsty na stronach e-commerce.

- Google reCAPTCHA

- System CAPTCHA Google. v2 wymaga interakcji użytkownika, v3 działa cicho z oceną ryzyka. Można rozwiązać za pomocą usług CAPTCHA.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

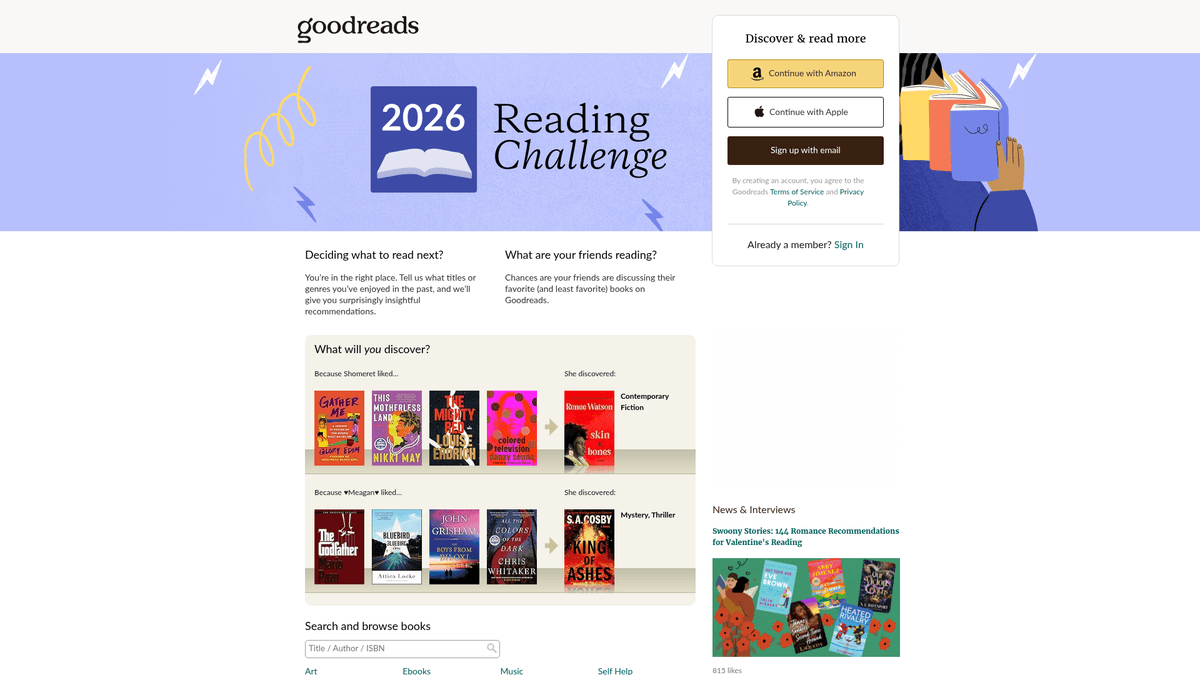

O Goodreads

Odkryj, co oferuje Goodreads i jakie cenne dane można wyodrębnić.

Największa na świecie platforma do katalogowania społecznościowego

Goodreads to czołowa platforma społecznościowa dla miłośników książek, należąca do firmy Amazon. Służy jako potężne repozytorium danych literackich, zawierające miliony wpisów o książkach, recenzje generowane przez użytkowników, adnotacje i listy lektur. Platforma jest zorganizowana według gatunków i tworzonych przez użytkowników „półek”, co zapewnia głęboki wgląd w globalne nawyki czytelnicze i trendy literackie.

Skarbnica danych literackich

Platforma zawiera szczegółowe dane, w tym numery ISBN, gatunki, bibliografie autorów oraz szczegółowe opinie czytelników. Dla firm i badaczy dane te oferują głęboki wgląd w trendy rynkowe i preferencje konsumentów. Dane pozyskane z Goodreads są nieocenione dla wydawców, autorów i badaczy do przeprowadzania analizy konkurencji i identyfikowania pojawiających się motywów literackich.

Dlaczego warto scrapować dane z Goodreads?

Scrapowanie tej witryny zapewnia dostęp do wskaźników popularności w czasie rzeczywistym, analizy konkurencji dla autorów oraz wysokiej jakości zestawów danych do trenowania systemów rekomendacji lub prowadzenia badań akademickich w naukach humanistycznych. Pozwala użytkownikom przeszukiwać ogromną bazę danych przy jednoczesnym śledzeniu postępów w czytaniu, oferując unikalne spojrzenie na to, jak różne grupy demograficzne wchodzą w interakcję z książkami.

Dlaczego Scrapować Goodreads?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Goodreads.

Prowadzenie badań rynkowych pod kątem trendów w branży wydawniczej

Przeprowadzanie analizy sentymentu recenzji czytelników

Monitorowanie popularności trendujących tytułów w czasie rzeczywistym

Budowanie zaawansowanych silników rekomendacji w oparciu o wzorce czytelnicze

Agregowanie metadanych do badań akademickich i kulturowych

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Goodreads.

Agresywne systemy bot mitigation od Cloudflare i DataDome

Silna zależność od JavaScript w renderowaniu nowoczesnego UI

Niespójność UI między starszymi a nowymi projektami stron opartymi na React

Rygorystyczny rate limiting wymagający wyrafinowanej rotacji proxy

Scrapuj Goodreads z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Goodreads. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Goodreads, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Goodreads bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Goodreads. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Goodreads, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Budowanie złożonych scraperów książek bez użycia kodu (no-code)

- Automatyczna obsługa systemów Cloudflare i anti-bot

- Wykonywanie zadań w chmurze dla ekstrakcji danych na dużą skalę

- Zaplanowane uruchomienia do monitorowania dziennych zmian w rankingach

- Łatwa obsługa treści dynamicznych i infinite scroll

Scrapery No-Code dla Goodreads

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Goodreads bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Goodreads

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Goodreads bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Adres URL dla konkretnej książki

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Niezbędne nagłówki, aby uniknąć natychmiastowego blokowania

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Użyj data-testid dla nowoczesnego UI opartego na React

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Goodreads za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Adres URL dla konkretnej książki

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Niezbędne nagłówki, aby uniknąć natychmiastowego blokowania

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Użyj data-testid dla nowoczesnego UI opartego na React

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Uruchomienie przeglądarki jest niezbędne dla stron Cloudflare/JS

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Czekaj na wyrenderowanie konkretnego atrybutu danych

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Targetuj znaczników schema.org dla bardziej stabilnych selektorów

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Standardowa obsługa paginacji

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads używa nowoczesnego JS, więc czekamy na konkretne komponenty

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi Goodreads

Poznaj praktyczne zastosowania i wnioski z danych Goodreads.

Przewidująca analiza bestsellerów

Wydawcy analizują sentyment wczesnych recenzji i dynamikę dodawania na półki, aby przewidzieć nadchodzące hity.

Jak wdrożyć:

- 1Monitoruj liczbę oznaczeń 'Chcę przeczytać' dla nadchodzących książek.

- 2Scrapuj wczesne recenzje egzemplarzy recenzenckich (ARC).

- 3Porównuj sentyment z historycznymi danymi o bestsellerach.

Użyj Automatio do wyodrębnienia danych z Goodreads i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Goodreads

- Przewidująca analiza bestsellerów

Wydawcy analizują sentyment wczesnych recenzji i dynamikę dodawania na półki, aby przewidzieć nadchodzące hity.

- Monitoruj liczbę oznaczeń 'Chcę przeczytać' dla nadchodzących książek.

- Scrapuj wczesne recenzje egzemplarzy recenzenckich (ARC).

- Porównuj sentyment z historycznymi danymi o bestsellerach.

- Konkurencyjna analityka dla autorów

Autorzy śledzą motywy gatunkowe i trendy w ocenach, aby optymalizować własną twórczość i działania marketingowe.

- Scrapuj najwyżej oceniane książki z konkretnej półki gatunkowej.

- Wyodrębniaj powtarzające się motywy z recenzji czytelników.

- Analizuj dynamikę ocen po kampaniach marketingowych.

- Niszowe silniki rekomendacji

Deweloperzy budują narzędzia do znajdowania książek spełniających specyficzne, złożone kryteria, których nie obsługuje główna witryna.

- Scrapuj tagi zdefiniowane przez użytkowników i twórz korelacje.

- Mapuj oceny, aby znaleźć unikalne powiązania między autorami.

- Przesyłaj wyniki przez API do aplikacji webowej.

- Filtrowanie książek na podstawie sentymentu

Badacze wykorzystują NLP w recenzjach, aby kategoryzować książki na podstawie wpływu emocjonalnego, a nie tylko gatunku.

- Wyodrębnij tysiące recenzji użytkowników dla konkretnej kategorii.

- Przeprowadź analizę sentymentu i ekstrakcję słów kluczowych.

- Zbuduj zbiór danych dla machine learning models.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Goodreads

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Goodreads.

Zawsze używaj residential proxies, aby ominąć blokady Cloudflare 403.

Targetuj stabilne atrybuty data-testid zamiast losowych nazw klas CSS.

Parsuj tag skryptu JSON __NEXT_DATA__, aby uzyskać niezawodną ekstrakcję metadanych.

Wdrażaj losowe opóźnienia od 3 do 7 sekund, aby naśladować zachowanie człowieka.

Scrapuj w godzinach mniejszego ruchu, aby zmniejszyć ryzyko aktywacji rate limits.

Monitoruj zmiany w UI między starszymi stronami PHP a nowszym układem opartym na React.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

Często Zadawane Pytania o Goodreads

Znajdź odpowiedzi na częste pytania o Goodreads