Jak scrapować jup.ag: Przewodnik po web scraperze Jupiter DEX

Dowiedz się, jak scrapować jup.ag, aby uzyskać ceny tokenów Solana, trasy swap i wolumeny rynkowe w czasie rzeczywistym. Poznaj oficjalne API Jupiter i dowiedz...

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Fingerprinting przeglądarki

- Identyfikuje boty po cechach przeglądarki: canvas, WebGL, czcionki, wtyczki. Wymaga spoofingu lub prawdziwych profili przeglądarki.

- Fingerprinting przeglądarki

- Identyfikuje boty po cechach przeglądarki: canvas, WebGL, czcionki, wtyczki. Wymaga spoofingu lub prawdziwych profili przeglądarki.

O Jupiter

Odkryj, co oferuje Jupiter i jakie cenne dane można wyodrębnić.

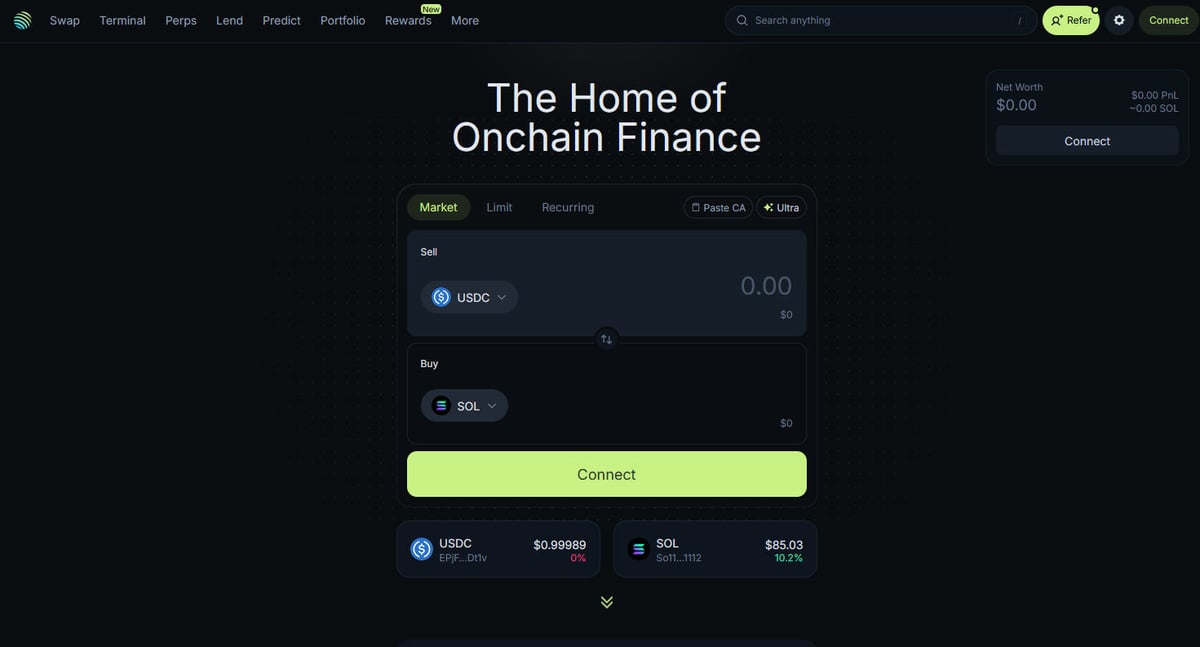

Centrum Solana DeFi

Jupiter jest głównym agregatorem płynności dla blockchaina Solana, działającym jako „DeFi Superapp”, która optymalizuje trasowanie transakcji przez setki pul płynności, aby zapewnić użytkownikom najlepsze ceny i minimalny poślizg (slippage). Jest to centralny węzeł finansów on-chain na Solanie, oferujący usługi od prostych swapów tokenów po zaawansowane funkcje, takie jak handel perpetual z dźwignią do 250x, zlecenia limit oraz dollar-cost averaging (DCA). Platforma dostarcza krytycznych danych dla ekosystemu, w tym ceny w czasie rzeczywistym, głębokość płynności i kompleksowe metryki rynkowe dla tysięcy aktywów.

Architektura Techniczna

Witryna została zbudowana na nowoczesnym stosie technologicznym z wykorzystaniem Next.js i React, co czyni ją wysoce dynamiczną aplikacją jednostronicową (SPA). Ponieważ ceny i trasy są obliczane w czasie rzeczywistym na podstawie bieżącego stanu blockchaina, frontend jest stale aktualizowany za pomocą WebSockets i wysokoczęstotliwościowych wywołań API. Dla badaczy danych, deweloperów i traderów, dane z Jupiter są uważane za złoty standard śledzenia sentymentu rynkowego i przesunięć płynności w całym ekosystemie Solana.

Dlaczego te dane są ważne

Dostęp do tych danych jest niezbędny do budowania botów handlowych, dashboardów rynkowych i przeprowadzania analiz historycznych na jednej z najszybciej rozwijających się sieci blockchain. Scrapery często celują w Jupiter, aby monitorować nowe notowania tokenów, śledzić ruchy „wielorybów” na rynkach perpetual lub identyfikować rozbieżności cenowe dla arbitrażu. Chociaż platforma oferuje oficjalne API, bezpośredni web scraping jest często używany do uchwycenia dokładnego stanu UI i specyficznych danych o trasowaniu, które mogą nie być w pełni ujawnione w publicznych punktach końcowych.

Dlaczego Scrapować Jupiter?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Jupiter.

Monitorowanie cen tokenów Solana w czasie rzeczywistym

Tworzenie botów do arbitrażu między giełdami DEX

Śledzenie trendów wolumenu rynku i płynności

Identyfikacja nowych notowań tokenów i sentymentu rynkowego

Agregowanie stóp zwrotu z pożyczek i stawek finansowania perpetuals

Analiza historycznego wpływu ceny dla dużych transakcji

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Jupiter.

Agresywne zabezpieczenia anty-bot Cloudflare

Wymóg pełnego renderowania JavaScript (React/Next.js)

Agresywne ograniczanie liczby żądań (rate limiting) na publicznych endpointach

Dynamiczne i zaciemnione selektory CSS w interfejsie

Szybkie aktualizacje danych wymagające połączeń o niskim opóźnieniu (latency)

Scrapuj Jupiter z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Jupiter. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Jupiter, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Jupiter bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Jupiter. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Jupiter, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Ekstrakcja danych bez użycia kodu z dynamicznych SPA

- Automatyczna obsługa Cloudflare i fingerprinting przeglądarki

- Zaplanowana ekstrakcja dla ciągłego monitorowania rynku

- Bezpośredni eksport danych do Webhooków lub Google Sheets

Scrapery No-Code dla Jupiter

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Jupiter bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Jupiter

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Jupiter bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Jupiter za pomocą kodu

Python + Requests

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Launch a browser that can render the Next.js frontend

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Wait for the token list items to render in the DOM

# Note: Selectors must be updated based on the current UI build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Directly hitting the token list JSON endpoint used by the frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# The response is a raw JSON list of all verified tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent to help bypass basic filters

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigate to the main swap page

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Example of extracting a price element using a partial selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Price not found';

});

console.log(`Live SOL Price observed in UI: ${solPrice}`);

await browser.close();

})();Co Możesz Zrobić Z Danymi Jupiter

Poznaj praktyczne zastosowania i wnioski z danych Jupiter.

System alertów o arbitrażu cenowym

Identyfikuj różnice cenowe między Jupiter a innymi Solana DEX w celu zawierania zyskownych transakcji.

Jak wdrożyć:

- 1Scrapuj kursy wymiany w czasie rzeczywistym z Price API Jupiter.

- 2Porównaj kursy z pulami płynności Orca i Raydium.

- 3Skonfiguruj automatyczne alerty lub haki wykonawcze dla okazji arbitrażowych.

Użyj Automatio do wyodrębnienia danych z Jupiter i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Jupiter

- System alertów o arbitrażu cenowym

Identyfikuj różnice cenowe między Jupiter a innymi Solana DEX w celu zawierania zyskownych transakcji.

- Scrapuj kursy wymiany w czasie rzeczywistym z Price API Jupiter.

- Porównaj kursy z pulami płynności Orca i Raydium.

- Skonfiguruj automatyczne alerty lub haki wykonawcze dla okazji arbitrażowych.

- Dashboard kondycji rynku Solana

Zbuduj makropoziomowy widok aktywności Solana DeFi dla inwestorów.

- Agreguj dane o 24-godzinnym wolumenie i TVL dla najpopularniejszych tokenów.

- Kategoryzuj tokeny według sektorów (Meme, AI, RWA).

- Wizualizuj zmiany płynności w różnych klasach aktywów w czasie.

- Snajper nowych notowań tokenów

Natychmiast wykrywaj i analizuj nowe tokeny pojawiające się na zweryfikowanej liście Jupiter.

- Regularnie scrapuj punkt końcowy listy tokenów.

- Porównuj nowe wyniki z lokalną bazą danych, aby znaleźć nowe pozycje.

- Analizuj początkową płynność i wolumen, aby ocenić potencjał tokena.

- Tracker wielorybów i Perps

Monitoruj duże pozycje i stawki finansowania na rynku Jupiter Perpetuals.

- Scrapuj dane o open interest i funding rate z sekcji Perps.

- Śledź logi dużych transakcji, aby zidentyfikować zachowania portfeli.

- Buduj modele sentymentu oparte na stosunkach long/short dla głównych aktywów.

- Usługa agregacji plonów (Yield Aggregation)

Zapewnij użytkownikom najlepsze dostępne stawki pożyczkowe w skarbcach Jupiter Lend.

- Scrapuj dane o APY dla różnych stablecoinów i par SOL.

- Obliczaj zysk netto po uwzględnieniu szacowanych opłat platformy.

- Automatyzuj rekomendacje rebalansowania w celu optymalizacji portfela.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Jupiter

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Jupiter.

Zawsze traktuj priorytetowo oficjalne API pod adresem api.jup.ag przed próbami scrapowania frontendowego HTML.

Używaj residential proxies, aby zminimalizować blokady Cloudflare, ponieważ adresy IP z datacenter są często na czarnej liście.

Włącz HTTP2 w swoim scraperze, aby dopasować się do standardowych odcisków palców (fingerprints) przeglądarek i uniknąć wykrycia.

Sprawdzaj połączenia WebSocket (wss

//) w zakładce network, aby uzyskać najbardziej efektywny streaming cen w czasie rzeczywistym.

Zaimplementuj solidną obsługę błędów dla odpowiedzi 403 Forbidden, które wskazują na blokowanie przez Cloudflare.

Celuj w endpoint https

//token.jup.ag/all, jeśli potrzebujesz tylko statycznej listy zweryfikowanych adresów tokenów.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Często Zadawane Pytania o Jupiter

Znajdź odpowiedzi na częste pytania o Jupiter