Jak scrapować Kleinanzeigen | Największy marketplace w Niemczech

Dowiedz się, jak scrapować Kleinanzeigen do monitorowania cen, trendów nieruchomości i generowania leadów. Wyodrębniaj tytuły i ceny z największej witryny w...

Wykryto ochronę przed botami

- Akamai Bot Manager

- Zaawansowane wykrywanie botów za pomocą fingerprintingu urządzenia, analizy zachowania i uczenia maszynowego. Jeden z najbardziej zaawansowanych systemów anty-botowych.

- DataDome

- Wykrywanie botów w czasie rzeczywistym za pomocą modeli ML. Analizuje odcisk urządzenia, sygnały sieciowe i wzorce zachowań. Częsty na stronach e-commerce.

- Google reCAPTCHA

- System CAPTCHA Google. v2 wymaga interakcji użytkownika, v3 działa cicho z oceną ryzyka. Można rozwiązać za pomocą usług CAPTCHA.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- Fingerprinting przeglądarki

- Identyfikuje boty po cechach przeglądarki: canvas, WebGL, czcionki, wtyczki. Wymaga spoofingu lub prawdziwych profili przeglądarki.

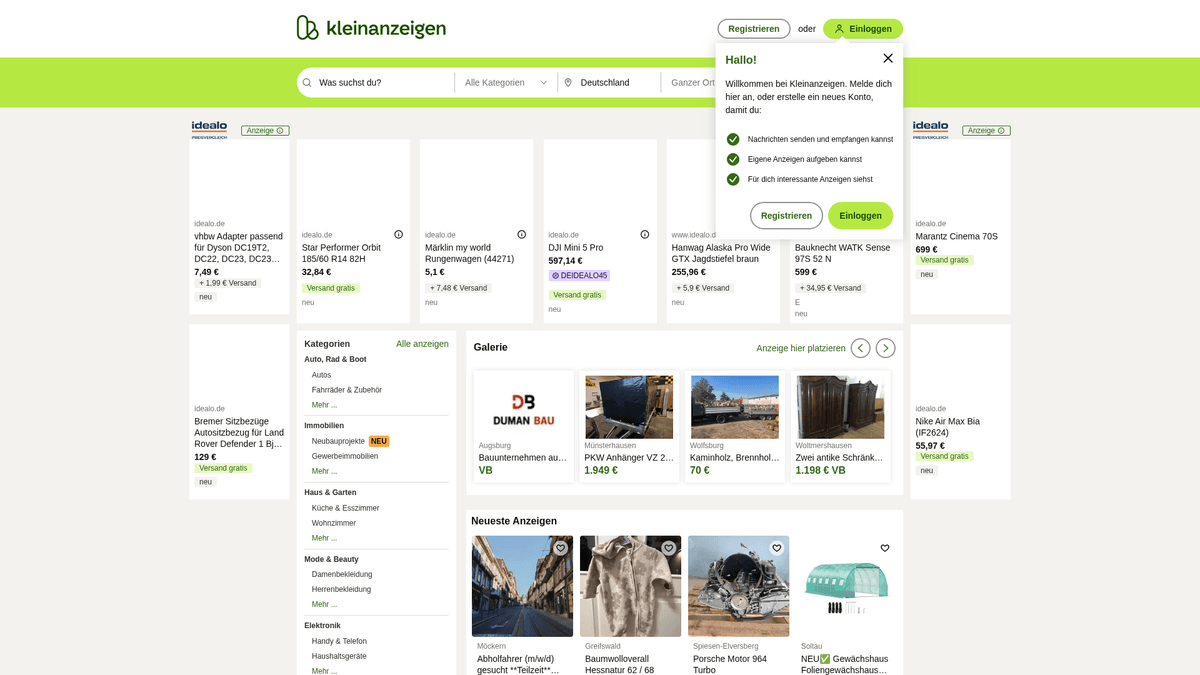

O Kleinanzeigen

Odkryj, co oferuje Kleinanzeigen i jakie cenne dane można wyodrębnić.

Główne centrum ogłoszeniowe Niemiec

Kleinanzeigen, dawniej znane jako eBay Kleinanzeigen, jest najważniejszym internetowym rynkiem ogłoszeniowym w Niemczech. Obsługuje miliony aktywnych użytkowników dziennie, ułatwiając transakcje obejmujące wszystko – od luksusowych nieruchomości i pojazdów, po meble domowe i specjalistyczne usługi lokalne. Ze względu na swoją ogromną skalę i głęboko zakorzenioną obecność na niemieckim rynku, platforma służy jako lustro gospodarki wtórnej kraju i lokalnego popytu na mieszkania.

Dlaczego scrapowanie Kleinanzeigen ma znaczenie

Dostęp do ustrukturyzowanych danych na Kleinanzeigen jest kluczowy dla firm dążących do zrozumienia wahań rynkowych w Europie Środkowej. Platforma zawiera lokalne informacje, które nie są dostępne w globalnych serwisach sprzedażowych, co czyni ją skarbnicą wiedzy dla regionalnego benchmarkingu cenowego i analizy trendów. Niezależnie od tego, czy śledzisz wartość odsprzedaży elektroniki, czy monitorujesz skoki cen wynajmu w Berlinie, scraping dostarcza szczegółowych danych niezbędnych do podejmowania świadomych decyzji.

Dlaczego Scrapować Kleinanzeigen?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Kleinanzeigen.

Monitorowanie cen nieruchomości i trendów wynajmu w różnych regionach Niemiec pod kątem inwestycji.

Przeprowadzanie analizy konkurencji dla sprzedaży używanych samochodów i zapasów części motoryzacyjnych.

Generowanie leadów o wysokiej intencji dla dostawców usług, takich jak firmy przeprowadzkowe i ekipy remontowe.

Śledzenie wartości odsprzedaży elektroniki użytkowej w celu optymalizacji strategii cenowych odkupu.

Analiza lokalnych trendów na rynku pracy w sektorach takich jak gastronomia, handel detaliczny i budownictwo.

Zbieranie danych historycznych do badań akademickich nad zachowaniami ekonomicznymi na rynkach wtórnych.

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Kleinanzeigen.

Agresywna ochrona anty-bot (Akamai i DataDome) wykrywająca sygnatury zautomatyzowanych przeglądarek.

Rygorystyczna polityka geo-blockingu wymagająca wysokiej jakości niemieckich rezydencjalnych proxy do dostępu do treści.

Dynamiczne selektory CSS i częste aktualizacje układu strony, które psują tradycyjne statyczne scrapery.

Silny rate limiting, który wyzwala złożone mechanizmy CAPTCHA nawet przy umiarkowanej liczbie zapytań.

Techniki obfuskacji danych stosowane w przypadku informacji kontaktowych i danych sprzedawcy.

Scrapuj Kleinanzeigen z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Kleinanzeigen. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Kleinanzeigen, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Kleinanzeigen bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Kleinanzeigen. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Kleinanzeigen, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Automatycznie omija wyrafinowane środki anty-botowe, takie jak Akamai, bez konieczności pisania niestandardowych skryptów.

- Wizualny interfejs no-code pozwala na szybkie aktualizacje w przypadku zmiany selektorów witryny.

- Wykonywanie zadań w chmurze zapewnia monitorowanie danych 24/7 bez obciążania lokalnej infrastruktury.

- Zintegrowana rotacja proxy płynnie obsługuje ograniczenia geograficzne i blokady IP.

- Automatyzuje złożoną paginację i nawigację po głębokich linkach bez wymaganego kodowania.

Scrapery No-Code dla Kleinanzeigen

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Kleinanzeigen bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Kleinanzeigen

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Kleinanzeigen bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Uwaga: Ta strona korzysta z Akamai/DataDome. Proste żądania mogą zwrócić 403 Forbidden.

url = 'https://www.kleinanzeigen.de/s-berlin/c0-l3331'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'de-DE,de;q=0.9'

}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

for item in soup.select('article.aditem'):

title = item.select_one('.aditem-main--title-line a').text.strip()

price = item.select_one('.aditem-main--middle--price-shipping--price').text.strip()

print(f'Ad: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Kleinanzeigen za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Uwaga: Ta strona korzysta z Akamai/DataDome. Proste żądania mogą zwrócić 403 Forbidden.

url = 'https://www.kleinanzeigen.de/s-berlin/c0-l3331'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'de-DE,de;q=0.9'

}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

for item in soup.select('article.aditem'):

title = item.select_one('.aditem-main--title-line a').text.strip()

price = item.select_one('.aditem-main--middle--price-shipping--price').text.strip()

print(f'Ad: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent='Mozilla/5.0', locale='de-DE')

page = context.new_page()

# Navigate to a listing page

page.goto('https://www.kleinanzeigen.de/s-anzeige/beispiel', wait_until='networkidle')

# Extract details

title = page.locator('h1#viewad-title').inner_text()

price = page.locator('#viewad-price').inner_text()

print({'title': title.strip(), 'price': price.strip()})

browser.close()

run()Python + Scrapy

import scrapy

class KleinanzeigenSpider(scrapy.Spider):

name = 'kleinanzeigen'

start_urls = ['https://www.kleinanzeigen.de/s-berlin/c0-l3331']

def parse(self, response):

for ad in response.css('article.aditem'):

yield {

'title': ad.css('.aditem-main--title-line a::text').get(),

'price': ad.css('.aditem-main--middle--price-shipping--price::text').get(),

'location': ad.css('.aditem-main--top--left::text').get()

}

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.setExtraHTTPHeaders({'Accept-Language': 'de-DE'});

await page.goto('https://www.kleinanzeigen.de/s-berlin/c0-l3331');

const ads = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.aditem')).map(el => ({

title: el.querySelector('.aditem-main--title-line a')?.innerText,

price: el.querySelector('.aditem-main--middle--price-shipping--price')?.innerText

}));

});

console.log(ads);

await browser.close();

})();Co Możesz Zrobić Z Danymi Kleinanzeigen

Poznaj praktyczne zastosowania i wnioski z danych Kleinanzeigen.

Indeksowanie rynku nieruchomości

Inwestorzy mogą śledzić ceny wynajmu i sprzedaży, aby identyfikować niedoszacowane dzielnice.

Jak wdrożyć:

- 1Codziennie scrapuj kategorię 'Immobilien' (Nieruchomości).

- 2Wyodrębnij kody pocztowe i ceny za metr kwadratowy.

- 3Agreguj dane w tygodniowy indeks cenowy.

- 4Porównuj trendy z oficjalnymi rządowymi raportami mieszkaniowymi.

Użyj Automatio do wyodrębnienia danych z Kleinanzeigen i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Kleinanzeigen

- Indeksowanie rynku nieruchomości

Inwestorzy mogą śledzić ceny wynajmu i sprzedaży, aby identyfikować niedoszacowane dzielnice.

- Codziennie scrapuj kategorię 'Immobilien' (Nieruchomości).

- Wyodrębnij kody pocztowe i ceny za metr kwadratowy.

- Agreguj dane w tygodniowy indeks cenowy.

- Porównuj trendy z oficjalnymi rządowymi raportami mieszkaniowymi.

- Monitorowanie stanów magazynowych w motoryzacji

Dealerzy używanych samochodów mogą w czasie rzeczywistym monitorować ceny konkurencji i rotację zapasów.

- Obierz za cel konkretne marki i modele samochodów w sekcji 'Auto'.

- Wyodrębnij przebieg, rok rejestracji i cenę.

- Zidentyfikuj ogłoszenia pozostające aktywne przez długi czas, aby wykryć zawyżone ceny.

- Automatyzuj alerty o nowo opublikowanych ofertach poniżej wartości rynkowej.

- Generowanie leadów dla usług

Firmy przeprowadzkowe i sprzątające mogą znaleźć klientów dokładnie wtedy, gdy potrzebują oni ich usług.

- Monitoruj kategorię 'Möbel & Wohnen' pod kątem wyprzedaży mebli wskazujących na przeprowadzkę.

- Wyodrębnij dzielnicę i miasto sprzedawcy.

- Filtruj ogłoszenia na podstawie słów kluczowych takich jak 'Umzug' (przeprowadzka).

- Dostarczaj leady zespołom sprzedaży do lokalnego kontaktu.

- Śledzenie cen elektroniki użytkowej

Sprzedawcy mogą dostosowywać oferty odkupu, monitorując aktualne wartości rynkowe używanego sprzętu.

- Scrapuj kategorie takie jak 'Handy & Telecom' lub 'Konsole'.

- Oczyść ciągi cenowe, usuwając znaczniki 'VB' (do negocjacji) lub 'Günstig' (tanio).

- Oblicz średnią wartość odsprzedaży dla konkretnych modeli, takich jak iPhone czy PlayStation.

- Dynamicznie aktualizuj ceny skupu w e-commerce na podstawie wyników.

- Analiza popytu regionalnego

Analitycy rynkowi mogą zidentyfikować, które rodzaje towarów cieszą się dużym popytem w konkretnych krajach związkowych Niemiec.

- Scrapuj liczbę ogłoszeń w różnych niemieckich miastach (np. Monachium vs. Berlin).

- Porównuj wolumeny kategorii w czasie.

- Zidentyfikuj sezonowe skoki w kategoriach takich jak 'Garten' (Ogród) czy 'Wintersport' (Sporty zimowe).

- Generuj raporty dla firm planujących regionalną dystrybucję zapasów.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Kleinanzeigen

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Kleinanzeigen.

Zawsze używaj niemieckich rezydencjalnych proxy, aby zapobiec natychmiastowemu blokowaniu IP wyzwalanemu przez ruch zagraniczny.

Ustaw język przeglądarki na 'de-DE', aby zapewnić poprawne renderowanie witryny i uniknąć podejrzeń o bycie botem.

Zaimplementuj losowe opóźnienia (sleep timers) między 10 a 30 sekundami, aby symulować naturalne zachowanie użytkownika.

Przeprowadzaj scraping w nocy (czasu CET), gdy ruch jest mniejszy, aby zredukować intensywność rate limiting.

Używaj przeglądarek headless z wtyczkami stealth, aby omijać kontrole TLS fingerprinting stosowane przez Akamai.

Unikaj scrapowania stron wymagających logowania, chyba że jest to konieczne, ponieważ scraping oparty na kontach jest bardzo podatny na bany.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Często Zadawane Pytania o Kleinanzeigen

Znajdź odpowiedzi na częste pytania o Kleinanzeigen