Jak scrapować Signal NFX | Przewodnik po scrapowaniu bazy danych inwestorów i VC

Dowiedz się, jak scrapować profile inwestorów, dane firm VC i listy leadów z Signal NFX. Poznaj techniczne strategie dla fundraising i badań rynkowych.

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- Login Wall

- Google reCAPTCHA

- System CAPTCHA Google. v2 wymaga interakcji użytkownika, v3 działa cicho z oceną ryzyka. Można rozwiązać za pomocą usług CAPTCHA.

O Signal (by NFX)

Odkryj, co oferuje Signal (by NFX) i jakie cenne dane można wyodrębnić.

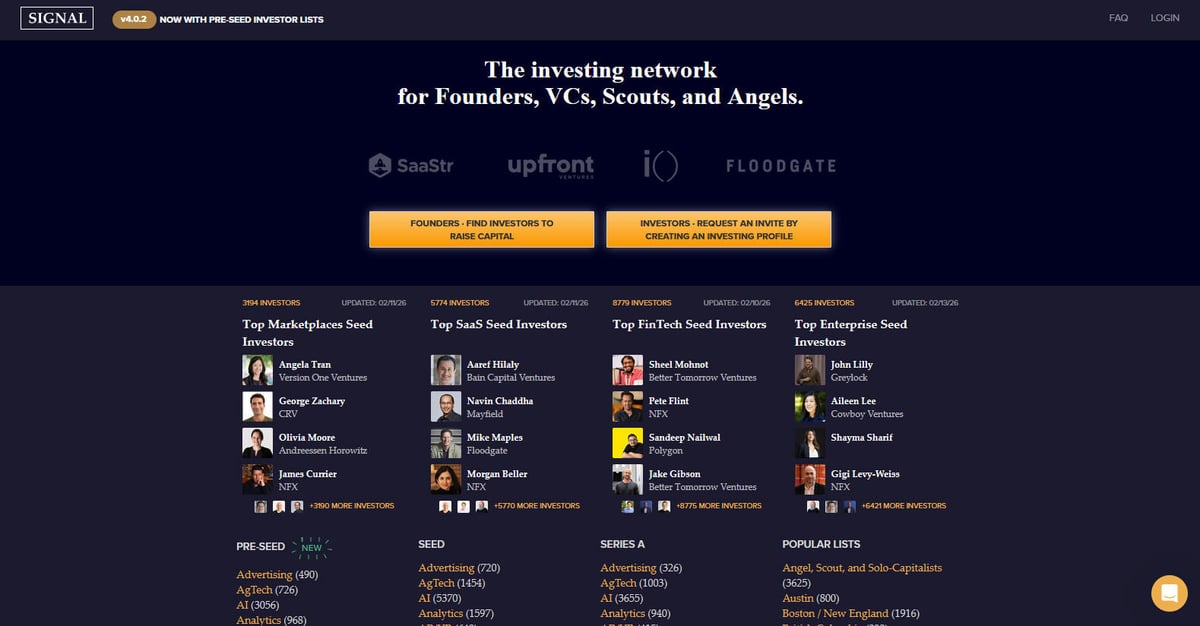

Signal to potężna sieć inwestycyjna zaprojektowana specjalnie dla founderów, VC, scoutów i aniołów biznesu. Stworzona i utrzymywana przez NFX, wybitną firmę venture capital na etapie seed, platforma służy jako ogromny katalog i narzędzie networkingowe ułatwiające pozyskiwanie funduszy przez startupy. Ma na celu uczynienie ekosystemu venture bardziej przejrzystym poprzez mapowanie powiązań między inwestorami a przedsiębiorcami, skutecznie zastępując ręczne arkusze kalkulacyjne dynamicznym, bogatym w dane środowiskiem.

Platforma zawiera tysiące profili inwestorów, skategoryzowanych według preferowanego etapu inwestycji (od Pre-Seed do Series B), sektorów branżowych, takich jak AI, SaaS i FinTech, oraz regionów geograficznych. Użytkownicy mogą znaleźć szczegółowe informacje o firmach venture capital, poszczególnych partnerach i ich konkretnych obszarach zainteresowań, które są często aktualizowane, aby odzwierciedlać obecny krajobraz rynkowy. Każdy wpis zazwyczaj zawiera specjalizację inwestora, preferowane etapy inwestycji, konkretne tezy inwestycyjne oraz preferencje dotyczące bezpośrednich rekomendacji od founderów.

Scrapowanie Signal jest niezwykle wartościowe dla founderów, którzy muszą budować ukierunkowane listy leadów inwestorskich bez ręcznego przeglądania tysięcy wpisów. Dostarcza również krytycznych danych dla badaczy rynku śledzących trendy venture capital, analizy konkurencji dla innych firm VC oraz danych dla zespołów sprzedaży celujących w ekosystem startupowy poprzez mapowanie relacji i rekomendacji.

Dlaczego Scrapować Signal (by NFX)?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Signal (by NFX).

Celowany fundraising

Buduj precyzyjne listy inwestorów, którzy prowadzą rundy seed lub pre-seed w Twojej konkretnej branży.

Badania rynkowe

Analizuj, które sektory cieszą się największym zainteresowaniem czołowych VC, takich jak Andreessen Horowitz czy Greylock.

Generowanie leadów

Identyfikuj nowe firmy VC i indywidualnych inwestorów wchodzących na specyficzne rynki geograficzne, takie jak LATAM czy Azja Południowo-Wschodnia.

Analiza konkurencji

Monitoruj portfele i obszary zainteresowań konkurencyjnych firm venture, aby zrozumieć ich strategię ekspansji.

Agregacja danych

Stwórz kompleksową wewnętrzną bazę danych ekosystemu venture capital do analiz akademickich lub biznesowych.

Mapowanie relacji

Wyodrębniaj dane o połączeniach, aby znaleźć najkrótszą ścieżkę do ciepłych poleceń (warm intros) do wpływowych VC.

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Signal (by NFX).

Wymóg logowania

Większość szczegółowych informacji o inwestorach jest ukryta za logowaniem, co wymusza zarządzanie sesjami lub automatyczną autentykację.

Renderowanie JavaScript

Strona wykorzystuje dynamiczne ładowanie list inwestorów (Infinite Scroll), co wymaga scrapera opartego na przeglądarce do wykonania JS.

Środki anty-botowe

Korzystanie z Cloudflare WAF i specyficznych punktów końcowych API do pobierania danych oznacza, że standardowe żądania mogą być blokowane bez odpowiednich nagłówków.

Limity zapytań (Rate Limits)

Scraping o wysokiej częstotliwości może wywołać blokady IP lub CAPTCHA ze względu na profesjonalny i zabezpieczony charakter sieci.

Złożona struktura DOM

Strona korzysta z dynamicznych elementów i niestandardowych komponentów frontendowych, co wymaga stabilnych selektorów do niezawodnej ekstrakcji danych.

Scrapuj Signal (by NFX) z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Signal (by NFX). Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Signal (by NFX), obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Signal (by NFX) bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Signal (by NFX). Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Signal (by NFX), obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Konfiguracja No-Code: Zbuduj scraper Signal wizualnie, bez pisania skomplikowanych skryptów do autentykacji czy renderowania JS.

- Zautomatyzowane logowanie: Łatwo obsługuj proces logowania do Signal w ramach przepływu Automatio, aby uzyskać dostęp do chronionych profili.

- Obsługa dynamicznej treści: Automatycznie czeka i wyodrębnia dane z dynamicznych list i elementów nieskończonego przewijania.

- Zaplanowane aktualizacje: Ustaw scraper, aby uruchamiał się co tydzień w celu znalezienia nowo dodanych inwestorów lub zaktualizowanych list sektorowych bez ręcznej interwencji.

- Eksport danych: Bezpośrednia integracja w celu eksportu leadów inwestorskich do Google Sheets, CSV lub Webhooks do natychmiastowego wykorzystania.

Scrapery No-Code dla Signal (by NFX)

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Signal (by NFX) bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Signal (by NFX)

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Signal (by NFX) bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Signal wymaga logowania dla pełnego dostępu do danych. Ten przykład używa sesji.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# W rzeczywistym scenariuszu najpierw należałoby wysłać dane logowania metodą POST

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Znajdź karty inwestorów na liście

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Inwestor: {name} | Firma: {firm}')

except Exception as e:

print(f'Błąd podczas scrapowania Signal: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Signal (by NFX) za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signal wymaga logowania dla pełnego dostępu do danych. Ten przykład używa sesji.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# W rzeczywistym scenariuszu najpierw należałoby wysłać dane logowania metodą POST

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Znajdź karty inwestorów na liście

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Inwestor: {name} | Firma: {firm}')

except Exception as e:

print(f'Błąd podczas scrapowania Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Przejdź do logowania

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'twój_email@example.com')

page.fill('input[name="password"]', 'twoje_haslo')

page.click('button:has-text("Log In")')

# Czekaj na załadowanie strony z listą po zalogowaniu

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Przewijaj, aby załadować dynamiczną treść

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Znaleziono inwestora: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# Uwaga: Wymaga scrapy-playwright do renderowania JavaScript

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# Logika Scrapy dla nieskończonego przewijania wymagałaby niestandardowego handlera Playwright

# do przewinięcia w dół przed przekazaniem odpowiedzi z powrotem do metody parseNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// Najpierw obsłuż logowanie

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'twój_email');

await page.type('#user_password', 'twoje_haslo');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();Co Możesz Zrobić Z Danymi Signal (by NFX)

Poznaj praktyczne zastosowania i wnioski z danych Signal (by NFX).

Automatyzacja pozyskiwania funduszy (Fundraising)

Founderzy mogą wykorzystać dane do identyfikacji i hierarchizacji inwestorów, którzy najprawdopodobniej zainwestują w ich konkretny etap i sektor.

Jak wdrożyć:

- 1Scrapuj listy inwestorów w Twojej branży (np. „Top AI Seed Investors”).

- 2Filtruj wyniki według „Last Updated”, aby znaleźć aktywnych uczestników aktualnie finansujących projekty.

- 3Eksportuj do CRM, takiego jak HubSpot lub Pipedrive, aby śledzić outreach.

- 4Użyj linków do profili, aby zidentyfikować wspólne połączenia dla „warm intros”.

Użyj Automatio do wyodrębnienia danych z Signal (by NFX) i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Signal (by NFX)

- Automatyzacja pozyskiwania funduszy (Fundraising)

Founderzy mogą wykorzystać dane do identyfikacji i hierarchizacji inwestorów, którzy najprawdopodobniej zainwestują w ich konkretny etap i sektor.

- Scrapuj listy inwestorów w Twojej branży (np. „Top AI Seed Investors”).

- Filtruj wyniki według „Last Updated”, aby znaleźć aktywnych uczestników aktualnie finansujących projekty.

- Eksportuj do CRM, takiego jak HubSpot lub Pipedrive, aby śledzić outreach.

- Użyj linków do profili, aby zidentyfikować wspólne połączenia dla „warm intros”.

- Analiza otoczenia konkurencyjnego VC

Firmy venture capital mogą monitorować obszary zainteresowań i rozszerzenia zespołów innych firm, aby pozostać konkurencyjnymi w ekosystemie.

- Okresowo scrapuj sekcję „Firms” na Signal, aby śledzić zmiany.

- Zidentyfikuj, które firmy dodają nowych „scoutów” lub „aniołów” do swojej sieci.

- Śledź zmiany w koncentracji inwestycyjnej, monitorując zmiany w liczbie sektorów na listach w czasie.

- Strategia ekspansji geograficznej

Firmy lub inwestorzy chcący wejść na nowe rynki mogą zidentyfikować kluczowych graczy finansowych w konkretnych regionach.

- Scrapuj listy specyficzne dla regionu, takie jak „LatAm”, „Israel” lub „MENA”.

- Kategoryzuj inwestorów według typu firmy (VC vs Anioł Biznesu), aby zrozumieć strukturę kapitału.

- Zmapuj lokalne środowisko finansowania, aby zidentyfikować potencjalnych inwestorów prowadzących (lead investors) przy wejściu na rynek.

- Mapowanie relacji i rekomendacji

Analizuj połączenia społecznościowe, aby znaleźć najkrótszą drogę do uzyskania ciepłego polecenia (warm intro) do wysokiej rangi przedstawicieli VC.

- Wyodrębnij dane o wspólnych połączeniach i informacje o grafie społecznościowym z profili inwestorów.

- Skonfrontuj zeskrapowane połączenia z własną siecią LinkedIn.

- Priorytetyzuj outreach na podstawie siły istniejących węzłów sieci.

- Badania rynkowe nad wschodzącymi sektorami

Analizuj, które nowe branże zyskują największą gęstość w grafie venture, aby przewidzieć kolejny trend.

- Scrapuj specyficzne tagi sektorowe i ich liczebność na różnych etapach finansowania.

- Oblicz wzrost zainteresowania inwestorów konkretnymi kategoriami w odstępach kwartalnych.

- Twórz raporty dla interesariuszy o tym, dokąd obecnie płyną „inteligentne pieniądze” (smart money).

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Signal (by NFX)

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Signal (by NFX).

Zarządzanie sesjami

Ponieważ pełne profile wymagają logowania, należy przechwytywać i ponownie wykorzystywać ciasteczka (cookies), aby uniknąć powtarzających się prób logowania, które wyzwalają alerty bezpieczeństwa.

Wybór proxy

Używaj wysokiej jakości residential proxies. Adresy IP z centrów danych (data center) są często flagowane przez ochronę botów Cloudflare w sieciach profesjonalnych.

Przestrzeganie Robots.txt

Sprawdź plik robots.txt serwisu Signal, aby zobaczyć, które ścieżki są ograniczone, i ustaw rozsądne opóźnienie crawlera (crawl delay), aby uniknąć dławienia ruchu (throttling).

Naśladowanie zachowań ludzkich

Dodaj losowe 2-5 sekundowe opóźnienia między ładowaniem stron i symuluj ruchy myszy lub przewijanie, aby pozostać niewykrytym.

Scraping poza godzinami szczytu

Wykonuj scraping na dużą skalę w okresach niskiego natężenia ruchu, np. w weekendy, aby zmniejszyć obciążenie i prawdopodobieństwo wykrycia.

Stabilność selektorów

Szukaj stabilnych wzorców ID lub atrybutów danych (data-testid), jeśli są dostępne, ponieważ wewnętrzne nazwy klas Signal mogą zmieniać się wraz z nowymi wdrożeniami.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Często Zadawane Pytania o Signal (by NFX)

Znajdź odpowiedzi na częste pytania o Signal (by NFX)