Cum să colectezi date de pe Goodreads: Ghidul suprem de web scraping 2025

Învață cum să colectezi date de pe Goodreads pentru cărți, recenzii și rating-uri în 2025. Acest ghid acoperă evitarea sistemelor anti-bot, exemple de cod...

Protecție anti-bot detectată

- Cloudflare

- WAF și gestionare bot de nivel enterprise. Folosește provocări JavaScript, CAPTCHA și analiză comportamentală. Necesită automatizare browser cu setări stealth.

- DataDome

- Detectare de boți în timp real cu modele ML. Analizează amprenta dispozitivului, semnale de rețea și tipare comportamentale. Comun pe site-urile de e-commerce.

- Google reCAPTCHA

- Sistemul CAPTCHA al Google. v2 necesită interacțiunea utilizatorului, v3 rulează silențios cu scor de risc. Poate fi rezolvat cu servicii CAPTCHA.

- Limitarea ratei

- Limitează cererile per IP/sesiune în timp. Poate fi ocolit cu proxy-uri rotative, întârzieri ale cererilor și scraping distribuit.

- Blocare IP

- Blochează IP-urile cunoscute ale centrelor de date și adresele semnalate. Necesită proxy-uri rezidențiale sau mobile pentru ocolire eficientă.

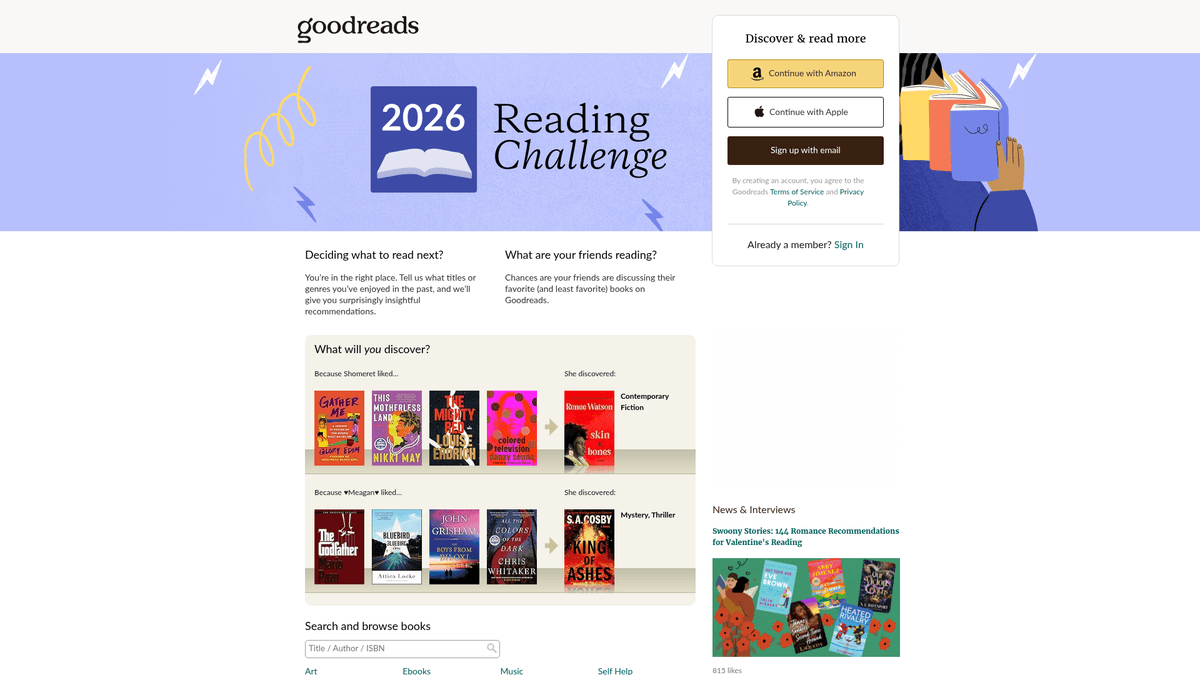

Despre Goodreads

Descoperiți ce oferă Goodreads și ce date valoroase pot fi extrase.

Cea mai mare platformă de catalogare socială din lume

Goodreads este principala platformă de social media pentru iubitorii de cărți, deținută și operată de Amazon. Aceasta servește ca un depozit masiv de date literare, oferind milioane de listări de cărți, recenzii generate de utilizatori, adnotări și liste de lectură. Platforma este organizată pe genuri și „rafturi” generate de utilizatori, oferind perspective profunde asupra obiceiurilor de lectură globale și a tendințelor literare.

O comoară de date literare

Platforma conține date granulare, inclusiv ISBN-uri, genuri, bibliografii ale autorilor și sentimente detaliate ale cititorilor. Pentru companii și cercetători, aceste date oferă perspective profunde asupra tendințelor pieței și preferințelor consumatorilor. Datele colectate de pe Goodreads sunt inestimabile pentru edituri, autori și cercetători pentru a efectua analize competitive și a identifica tropi emergenți.

De ce să colectezi date de pe Goodreads?

Scraping-ul acestui site oferă acces la metrici de popularitate în timp real, analiză competitivă pentru autori și seturi de date de înaltă calitate pentru antrenarea sistemelor de recomandare sau efectuarea cercetărilor academice în domeniul umanist. Permite utilizatorilor să caute în baza sa masivă de date, monitorizând în același timp progresul lecturii, oferind o perspectivă unică asupra modului în care diferite segmente demografice interacționează cu cărțile.

De Ce Să Faceți Scraping La Goodreads?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din Goodreads.

Efectuarea cercetărilor de piață pentru tendințele din industria editorială

Realizarea analizei de sentiment pe recenziile cititorilor

Monitorizarea popularității în timp real a titlurilor în tendințe

Construirea unor motoare de recomandare avansate bazate pe tiparele de adăugare la raft

Agregarea metadatelor pentru cercetare academică și culturală

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la Goodreads.

Atenuarea agresivă a bot-urilor de către Cloudflare și DataDome

Dependența mare de JavaScript pentru redarea interfeței moderne

Inconsistența UI între designul paginilor vechi și cele bazate pe React

Limitarea strictă a ratei (rate limiting) care necesită rotarea sofisticată a proxy-urilor

Extrage date din Goodreads cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din Goodreads. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează Goodreads, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din Goodreads fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din Goodreads. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează Goodreads, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Construirea de scrapper-e complexe pentru cărți fără cod (no-code)

- Gestionarea automată a sistemelor Cloudflare și anti-bot

- Execuție în cloud pentru extracția de date de mare volum

- Rulări programate pentru monitorizarea zilnică a schimbărilor de rang

- Gestionarea ușoară a conținutului dinamic și a scroll-ului infinit

Scrapere Web No-Code pentru Goodreads

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Goodreads fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru Goodreads

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Goodreads fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape Goodreads with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Launching a browser is necessary for Cloudflare/JS pages

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Wait for the specific data attribute to render

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Target the schema.org markup for more stable selectors

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Standard pagination handling

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads uses modern JS, so we wait for specific components

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();Ce Puteți Face Cu Datele Goodreads

Explorați aplicațiile practice și informațiile din datele Goodreads.

Analiza predictivă a bestseller-urilor

Editurile analizează sentimentul recenziilor timpurii și viteza de adăugare la raft pentru a prezice viitoarele hituri.

Cum se implementează:

- 1Monitorizează numărul de marcaje 'Want to Read' pentru cărțile viitoare.

- 2Colectează recenziile timpurii pentru Advance Reader Copy (ARC).

- 3Compară sentimentul cu datele istorice ale bestseller-urilor.

Folosiți Automatio pentru a extrage date din Goodreads și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele Goodreads

- Analiza predictivă a bestseller-urilor

Editurile analizează sentimentul recenziilor timpurii și viteza de adăugare la raft pentru a prezice viitoarele hituri.

- Monitorizează numărul de marcaje 'Want to Read' pentru cărțile viitoare.

- Colectează recenziile timpurii pentru Advance Reader Copy (ARC).

- Compară sentimentul cu datele istorice ale bestseller-urilor.

- Inteligență competitivă pentru autori

Autorii urmăresc tropii genului și tendințele de rating pentru a-și optimiza propria scriere și strategie de marketing.

- Colectează cărțile de top dintr-un raft specific unui gen.

- Extrage tropii recurenți din recenziile cititorilor.

- Analizează viteza de rating după campaniile de marketing.

- Motoare de recomandare de nișă

Developerii construiesc instrumente pentru a găsi cărți care corespund unor criterii specifice și complexe, neacceptate de site-ul principal.

- Colectează tag-urile definite de utilizatori și corelează-le.

- Hărțuiește rating-urile pentru a găsi corelații unice între autori.

- Livrează rezultatele printr-un API către o aplicație web.

- Filtrarea cărților pe baza analizei de sentiment

Cercetătorii folosesc procesarea limbajului natural (NLP) pe recenzii pentru a categorisi cărțile în funcție de impactul emoțional, nu doar de gen.

- Extrage mii de recenzii ale utilizatorilor pentru o categorie specifică.

- Rulează analiza de sentiment și extracția de cuvinte cheie.

- Construiește un set de date pentru machine learning modele.

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La Goodreads

Sfaturi de la experți pentru extragerea cu succes a datelor din Goodreads.

Folosește întotdeauna proxy-uri rezidențiale pentru a evita blocările Cloudflare 403.

Vizează atribute data-testid stabile în locul numelor de clase CSS generate aleatoriu.

Extrage datele din tag-ul de script JSON __NEXT_DATA__ pentru o colectare de metadate mai fiabilă.

Implementează întârzieri aleatorii între 3 și 7 secunde pentru a simula comportamentul de navigare uman.

Realizează scraping-ul în afara orelor de vârf pentru a reduce riscul de a declanșa limitări de rată (rate limits).

Monitorizează schimbările de interfață între paginile vechi în PHP și noul layout bazat pe React.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

Intrebari frecvente despre Goodreads

Gaseste raspunsuri la intrebarile comune despre Goodreads