Cum să extragi date de pe jup.ag: Ghid de web scraping pentru Jupiter DEX

Învață cum să extragi date de pe jup.ag pentru prețuri de token-uri Solana în timp real, rute de swap și volume de piață. Descoperă API-urile oficiale Jupiter...

Protecție anti-bot detectată

- Cloudflare

- WAF și gestionare bot de nivel enterprise. Folosește provocări JavaScript, CAPTCHA și analiză comportamentală. Necesită automatizare browser cu setări stealth.

- Limitarea ratei

- Limitează cererile per IP/sesiune în timp. Poate fi ocolit cu proxy-uri rotative, întârzieri ale cererilor și scraping distribuit.

- Amprentă browser

- Identifică boții prin caracteristicile browserului: canvas, WebGL, fonturi, pluginuri. Necesită spoofing sau profiluri reale de browser.

- Amprentă browser

- Identifică boții prin caracteristicile browserului: canvas, WebGL, fonturi, pluginuri. Necesită spoofing sau profiluri reale de browser.

Despre Jupiter

Descoperiți ce oferă Jupiter și ce date valoroase pot fi extrase.

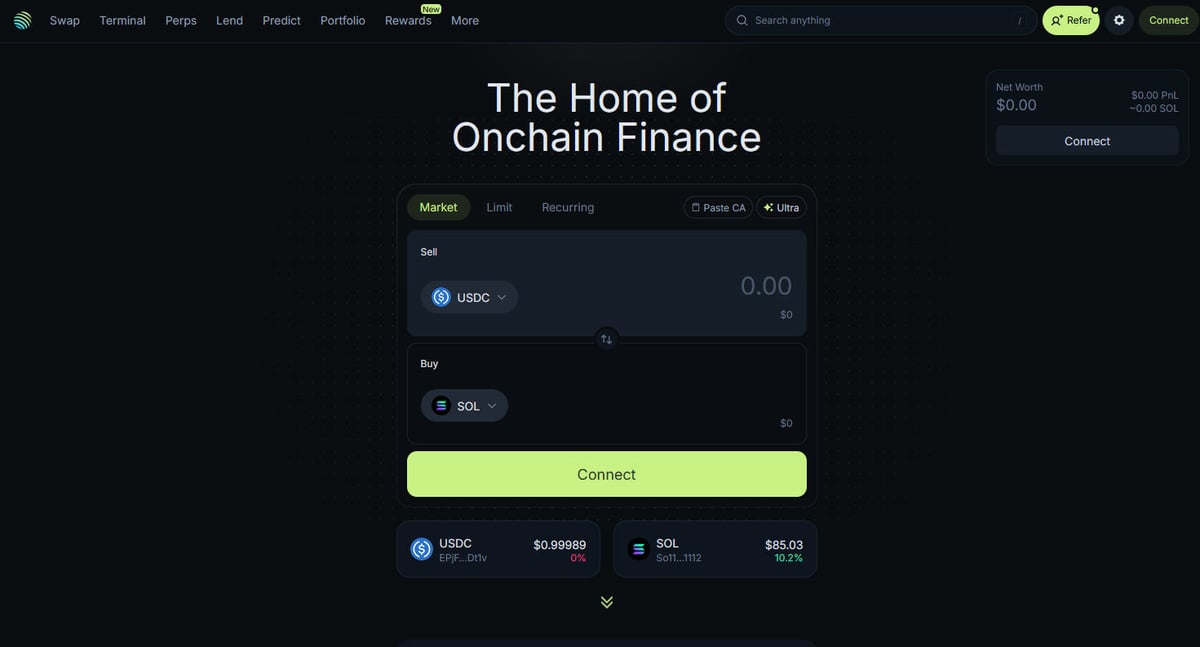

Hub-ul DeFi pe Solana

Jupiter este principalul agregator de lichiditate pentru blockchain-ul Solana, acționând ca un „DeFi Superapp” care optimizează rutele de tranzacționare prin sute de pool-uri de lichiditate pentru a oferi utilizatorilor cele mai bune prețuri și slippage minim. Este centrul finanțelor on-chain de pe Solana, oferind servicii variind de la swap-uri simple de token-uri până la funcții avansate precum tranzacționarea de perpetuals cu efect de levier de până la 250x, limit orders și dollar-cost averaging (DCA). Platforma furnizează date critice pentru ecosistem, inclusiv prețuri în timp real, adâncimea lichidității și metrici de piață cuprinzătoare pentru mii de active.

Arhitectura Tehnică

Site-ul este construit pe un stack tehnic modern folosind Next.js și React, fiind o aplicație de tip single-page (SPA) extrem de dinamică. Deoarece prețurile și rutele sunt calculate în timp real pe baza stării actuale a blockchain-ului, frontend-ul se actualizează constant prin WebSockets și apeluri API de înaltă frecvență. Pentru cercetătorii de date, developeri și traderi, datele Jupiter sunt considerate standardul de aur pentru urmărirea sentimentului pieței Solana și a fluxurilor de lichiditate în întregul ecosistem.

De ce sunt importante datele

Accesul la aceste date este esențial pentru construirea de bot-uri de tranzacționare, dashboard-uri de piață și efectuarea analizelor istorice pe una dintre rețelele blockchain cu cea mai rapidă creștere. Scraper-ele vizează adesea Jupiter pentru a monitoriza listările noi de token-uri, pentru a urmări mișcările „balenelor” pe piețele de perpetuals sau pentru a identifica discrepanțele de preț pentru arbitraj. Deși platforma oferă API-uri oficiale, scraping-ul web direct este frecvent utilizat pentru a capta starea exactă a interfeței UI și datele specifice de rutare care pot să nu fie expuse complet în endpoint-urile publice.

De Ce Să Faceți Scraping La Jupiter?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din Jupiter.

Monitorizarea prețurilor în timp real pentru token-urile Solana

Dezvoltarea de bot-uri de tranzacționare prin arbitraj între DEX-uri

Urmărirea tendințelor de volum și lichiditate de pe piață

Identificarea noilor listări de token-uri și a sentimentului pieței

Agregarea randamentelor de lending și a ratelor de finanțare perpetual

Analiza impactului istoric al prețului pentru tranzacții mari

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la Jupiter.

Protecții anti-bot Cloudflare agresive

Necesitatea randării complete JavaScript (React/Next.js)

Limitarea agresivă a ratei (rate limiting) pe bază de IP pe endpoint-urile publice

Selectoare CSS dinamice și ofuscate în interfața UI

Actualizări de date de mare viteză care necesită conexiuni cu latență scăzută

Extrage date din Jupiter cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din Jupiter. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează Jupiter, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din Jupiter fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din Jupiter. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează Jupiter, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Extragere de date no-code din SPA-uri dinamice

- Gestionarea automată a Cloudflare și a amprentelor de browser

- Extragere programată pentru monitorizarea continuă a pieței

- Export direct de date către Webhooks sau Google Sheets

Scrapere Web No-Code pentru Jupiter

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Jupiter fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru Jupiter

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Jupiter fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

def get_jupiter_price(token_address):

# Utilizarea API-ului oficial Jupiter Price V2 este cea mai fiabilă metodă

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Preț: ${price_info['price']}")

except Exception as e:

print(f"A apărut o eroare: {e}")

# Exemplu: Preluarea prețului SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape Jupiter with Code

Python + Requests

import requests

def get_jupiter_price(token_address):

# Utilizarea API-ului oficial Jupiter Price V2 este cea mai fiabilă metodă

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Preț: ${price_info['price']}")

except Exception as e:

print(f"A apărut o eroare: {e}")

# Exemplu: Preluarea prețului SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Lansează un browser care poate randa frontend-ul Next.js

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Așteaptă ca elementele listei de token-uri să fie randate în DOM

# Notă: Selectoarele trebuie actualizate în funcție de build-ul curent al UI-ului

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Accesarea directă a endpoint-ului JSON pentru lista de token-uri utilizat de frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Răspunsul este o listă JSON brută cu toate token-urile verificate

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Setează un User-Agent realist pentru a ajuta la ocolirea filtrelor de bază

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navighează către pagina principală de swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Exemplu de extragere a unui element de preț folosind un selector parțial

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Preț negăsit';

});

console.log(`Preț SOL live observat în UI: ${solPrice}`);

await browser.close();

})();Ce Puteți Face Cu Datele Jupiter

Explorați aplicațiile practice și informațiile din datele Jupiter.

Sistem de Alerte pentru Arbitraj de Preț

Identifică diferențele de preț între Jupiter și alte DEX-uri de pe Solana pentru a executa tranzacții profitabile.

Cum se implementează:

- 1Extrage ratele de swap în timp real din API-ul de preț Jupiter.

- 2Compară ratele cu pool-urile de lichiditate Orca și Raydium.

- 3Configurează alerte automate sau hook-uri de execuție pentru oportunități de arbitraj.

Folosiți Automatio pentru a extrage date din Jupiter și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele Jupiter

- Sistem de Alerte pentru Arbitraj de Preț

Identifică diferențele de preț între Jupiter și alte DEX-uri de pe Solana pentru a executa tranzacții profitabile.

- Extrage ratele de swap în timp real din API-ul de preț Jupiter.

- Compară ratele cu pool-urile de lichiditate Orca și Raydium.

- Configurează alerte automate sau hook-uri de execuție pentru oportunități de arbitraj.

- Dashboard pentru Starea Pieței Solana

Construiește o vedere macro a activității DeFi pe Solana pentru investitori.

- Agregă volumul pe 24h și datele TVL pentru cele mai importante token-uri.

- Categorisește token-urile pe sectoare (Meme, AI, RWA).

- Vizualizează schimbările de lichiditate între diferite clase de active în timp.

- Sniper pentru Listări de Token Noi

Detectează și analizează imediat token-urile noi care apar în lista verificată de pe Jupiter.

- Extrage regulat date de la endpoint-ul listei de token-uri.

- Compară noile rezultate cu o bază de date locală pentru a găsi adăugirile noi.

- Analizează lichiditatea inițială și volumul pentru a evalua potențialul token-ului.

- Tracker pentru Balene (Whales) și Perps

Monitorizează pozițiile mari și ratele de finanțare pe piața Jupiter Perpetuals.

- Extrage datele despre open interest și funding rate din secțiunea Perps.

- Urmărește log-urile tranzacțiilor mari pentru a identifica comportamentul portofelelor.

- Construiește modele de sentiment bazate pe ratiile long/short ale activelor majore.

- Serviciu de Agregare a Randamentului (Yield)

Oferă utilizatorilor cele mai bune rate de împrumut disponibile în vault-urile Jupiter Lend.

- Extrage datele APY pentru diverse stablecoins și perechi SOL.

- Calculează randamentul net după taxele estimate ale platformei.

- Automatizează recomandările de reechilibrare pentru optimizarea portofoliului.

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La Jupiter

Sfaturi de la experți pentru extragerea cu succes a datelor din Jupiter.

Acordă întotdeauna prioritate API-ului oficial la api.jup.ag înainte de a încerca să faci scraping pe frontend-ul HTML.

Folosește proxy-uri rezidențiale pentru a minimiza blocările Cloudflare, deoarece IP-urile din datacenter sunt adesea pe lista neagră.

Activează HTTP2 în scraper-ul tău pentru a se potrivi cu amprentele standard de browser și pentru a evita detecția.

Inspectează conexiunile WebSocket (wss

//) în tab-ul Network pentru cel mai eficient streaming de prețuri în timp real.

Implementează un management robust al erorilor pentru răspunsurile 403 Forbidden, care indică blocarea de către Cloudflare.

Targetează endpoint-ul https

//token.jup.ag/all dacă ai nevoie doar de lista statică de adrese de token-uri verificate.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Intrebari frecvente despre Jupiter

Gaseste raspunsuri la intrebarile comune despre Jupiter