Как парсить Goodreads: Полное руководство по веб-скрапингу 2025

Узнайте, как парсить Goodreads для получения данных о книгах, отзывов и рейтингов в 2025 году. В руководстве: обход антиботов, примеры на Python и...

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- DataDome

- Обнаружение ботов в реальном времени с помощью ML-моделей. Анализирует цифровой отпечаток устройства, сетевые сигналы и паттерны поведения. Часто используется на сайтах электронной коммерции.

- Google reCAPTCHA

- Система CAPTCHA от Google. v2 требует взаимодействия пользователя, v3 работает скрыто с оценкой рисков. Можно решить с помощью сервисов CAPTCHA.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

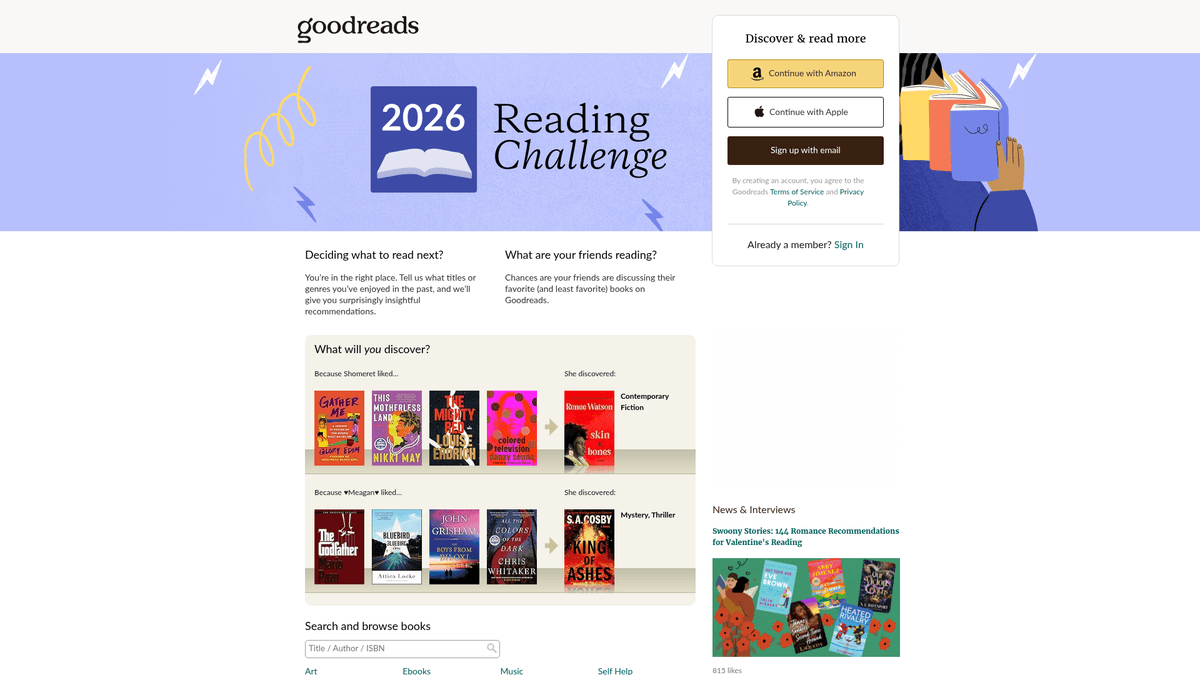

О Goodreads

Узнайте, что предлагает Goodreads и какие ценные данные можно извлечь.

Крупнейшая в мире платформа для социальной каталогизации

Goodreads — это ведущая социальная сеть для любителей книг, принадлежащая и управляемая Amazon. Она служит массивным хранилищем литературных данных, содержащим миллионы списков книг, пользовательских обзоров, аннотаций и списков чтения. Платформа организована по жанрам и пользовательским «полкам», что дает глубокое понимание глобальных читательских привычек и литературных тенденций.

Сокровищница литературных данных

Платформа содержит детализированные данные, включая ISBN, жанры, библиографии авторов и подробные мнения читателей. Для бизнеса и исследователей эти данные открывают глубокое понимание рыночных тенденций и потребительских предпочтений. Данные, полученные с Goodreads, бесценны для издателей, авторов и аналитиков для проведения конкурентного анализа и выявления новых популярных тропов.

Зачем парсить данные Goodreads?

Парсинг этого сайта обеспечивает доступ к метрикам популярности в реальном времени, позволяет проводить конкурентный анализ для авторов и собирать высококачественные датасеты для обучения рекомендательных систем или проведения академических исследований в области гуманитарных наук. Это позволяет пользователям искать информацию в огромной базе данных, отслеживая прогресс чтения и предлагая уникальный взгляд на то, как различные демографические группы взаимодействуют с книгами.

Зачем Парсить Goodreads?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Goodreads.

Проведение исследований рынка для выявления тенденций в издательской индустрии

Анализ тональности (sentiment analysis) отзывов читателей

Мониторинг популярности трендовых произведений в реальном времени

Создание продвинутых рекомендательных систем на основе паттернов книжных полок

Агрегация метаданных для академических и культурных исследований

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Goodreads.

Агрессивные системы защиты от ботов Cloudflare и DataDome

Сильная зависимость от JavaScript для рендеринга современного интерфейса

Несоответствие интерфейса между старыми и новыми (на React) дизайнами страниц

Строгие лимиты (rate limiting), требующие сложной ротации прокси

Скрапинг Goodreads с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Goodreads. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Goodreads, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Goodreads без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Goodreads. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Goodreads, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Создание сложных парсеров книг без написания кода (no-code)

- Автоматическая обработка систем Cloudflare и антибот-защиты

- Облачное исполнение для высокообъемного извлечения данных

- Запуск по расписанию для мониторинга ежедневных изменений рейтинга

- Удобная работа с динамическим контентом и бесконечной прокруткой

No-Code Парсеры для Goodreads

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Goodreads без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Goodreads

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Goodreads без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

# URL конкретной книги

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Необходимые заголовки, чтобы избежать мгновенной блокировки

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Используем data-testid для современного интерфейса на React

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Название: {title}, Автор: {author}')

except Exception as e:

print(f'Ошибка парсинга: {e}')Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Goodreads с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL конкретной книги

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Необходимые заголовки, чтобы избежать мгновенной блокировки

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Используем data-testid для современного интерфейса на React

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Название: {title}, Автор: {author}')

except Exception as e:

print(f'Ошибка парсинга: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Запуск браузера необходим для обхода Cloudflare и рендеринга JS-страниц

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Ожидаем отрисовки конкретного data-атрибута

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Ориентируемся на разметку schema.org для более стабильных селекторов

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Стандартная обработка пагинации

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads использует современный JS, поэтому ждем загрузки конкретных компонентов

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();Что Можно Делать С Данными Goodreads

Изучите практические применения и инсайты из данных Goodreads.

Прогнозный анализ бестселлеров

Издатели анализируют тональность ранних отзывов и скорость добавления на полки, чтобы предсказать будущие хиты.

Как реализовать:

- 1Мониторинг счетчиков «Хочу прочитать» для грядущих книг.

- 2Парсинг ранних отзывов на предварительные копии (ARC).

- 3Сравнение тональности отзывов с историческими данными о бестселлерах.

Используйте Automatio для извлечения данных из Goodreads и создания этих приложений без написания кода.

Что Можно Делать С Данными Goodreads

- Прогнозный анализ бестселлеров

Издатели анализируют тональность ранних отзывов и скорость добавления на полки, чтобы предсказать будущие хиты.

- Мониторинг счетчиков «Хочу прочитать» для грядущих книг.

- Парсинг ранних отзывов на предварительные копии (ARC).

- Сравнение тональности отзывов с историческими данными о бестселлерах.

- Конкурентная разведка для авторов

Авторы отслеживают жанровые тропы и тенденции рейтингов, чтобы оптимизировать собственное творчество и маркетинг.

- Парсинг книг с самым высоким рейтингом на полке конкретного жанра.

- Извлечение повторяющихся тропов из отзывов читателей.

- Анализ динамики рейтинга после маркетинговых кампаний.

- Нишевые рекомендательные системы

Разработчики создают инструменты для поиска книг по специфическим, сложным критериям, которые не поддерживаются основным сайтом.

- Парсинг пользовательских тегов и их перекрестная проверка.

- Сопоставление рейтингов для поиска уникальных корреляций между авторами.

- Вывод результатов через API в веб-приложение.

- Фильтрация книг на основе эмоционального окраса

Исследователи используют NLP для анализа отзывов, чтобы классифицировать книги на основе эмоционального воздействия, а не только жанра.

- Извлечение тысяч пользовательских отзывов для определенной категории.

- Проведение анализа тональности и извлечение ключевых слов.

- Создание датасета для моделей machine learning.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Goodreads

Экспертные советы для успешного извлечения данных из Goodreads.

Всегда используйте резидентные прокси, чтобы обходить блокировки Cloudflare 403.

Ориентируйтесь на стабильные атрибуты data-testid, а не на рандомизированные названия CSS-классов.

Парсите тег сценария JSON __NEXT_DATA__ для надежного извлечения метаданных.

Реализуйте случайные задержки от 3 до 7 секунд, чтобы имитировать поведение реального пользователя.

Выполняйте парсинг в часы низкой нагрузки, чтобы снизить риск срабатывания лимитов запросов.

Следите за изменениями в интерфейсе между устаревшими PHP-страницами и новой версткой на React.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

Часто задаваемые вопросы о Goodreads

Найдите ответы на частые вопросы о Goodreads