Как скрепить jup.ag: Руководство по веб-скрепингу Jupiter DEX

Узнайте, как скрепить jup.ag для получения цен token Solana в реальном времени, маршрутов обмена и объемов рынка. Изучите официальные API Jupiter и методы...

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Цифровой отпечаток браузера

- Идентифицирует ботов по характеристикам браузера: canvas, WebGL, шрифты, плагины. Требует подмены или реальных профилей браузера.

- Цифровой отпечаток браузера

- Идентифицирует ботов по характеристикам браузера: canvas, WebGL, шрифты, плагины. Требует подмены или реальных профилей браузера.

О Jupiter

Узнайте, что предлагает Jupiter и какие ценные данные можно извлечь.

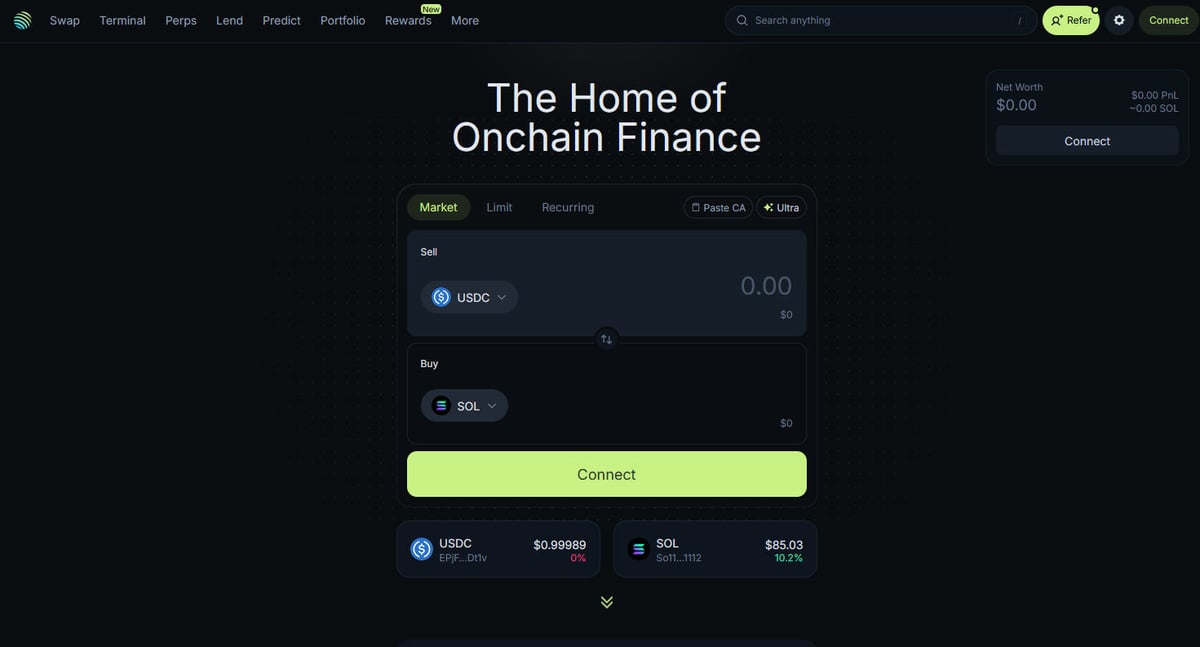

Центр DeFi на Solana

Jupiter — это основной агрегатор ликвидности для блокчейна Solana, выступающий в роли «супер-приложения DeFi». Он оптимизирует маршрутизацию сделок через сотни пулов ликвидности, обеспечивая пользователям лучшие цены и минимальное проскальзывание. Это центральный узел для on-chain финансов Solana, предлагающий услуги от простых свопов до продвинутых функций, таких как торговля бессрочными контрактами с плечом до 250x, лимитные ордера и усреднение долларовой стоимости (DCA). Платформа предоставляет критически важные данные для экосистемы, включая котировки в реальном времени, глубину ликвидности и комплексные рыночные метрики для тысяч активов.

Техническая архитектура

Сайт построен на современном технологическом стеке с использованием Next.js и React, что делает его высокодинамичным одностраничным приложением (SPA). Поскольку цены и маршруты рассчитываются в реальном времени на основе текущего состояния блокчейна, фронтенд постоянно обновляется через WebSockets и высокочастотные вызовы API. Для аналитиков данных, разработчиков и трейдеров данные Jupiter считаются золотым стандартом для отслеживания рыночных настроений и смещения ликвидности в экосистеме Solana.

Почему эти данные важны

Доступ к этим данным необходим для создания торговых ботов, рыночных дашбордов и проведения исторического анализа в одной из самых быстрорастущих блокчейн-сетей. Скреперы часто нацелены на Jupiter для мониторинга листинга новых token, отслеживания движений «китов» на рынках фьючерсов или выявления ценовых расхождений для арбитража. Хотя платформа предлагает официальные API, прямой веб-скрепинг часто используется для фиксации точного состояния UI и специфических данных маршрутизации, которые могут быть не полностью представлены в публичных эндпоинтах.

Зачем Парсить Jupiter?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Jupiter.

Мониторинг цен на token Solana в реальном времени

Разработка ботов для арбитражной торговли между DEX

Отслеживание тенденций рыночного объема и ликвидности

Идентификация новых листингов token и рыночных настроений

Агрегация доходности кредитования и ставок финансирования фьючерсов

Анализ исторического влияния цены для крупных сделок

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Jupiter.

Агрессивная анти-бот защита Cloudflare

Требование полного рендеринга JavaScript (React/Next.js)

Жесткие ограничения частоты запросов по IP на публичных эндпоинтах

Динамические и обфусцированные селекторы CSS в UI

Высокая скорость обновления данных, требующая соединений с низкой latency

Скрапинг Jupiter с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Jupiter. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Jupiter, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Jupiter без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Jupiter. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Jupiter, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Извлечение данных из динамических SPA без написания кода

- Автоматическая обработка Cloudflare и отпечатков браузера

- Запланированное извлечение для непрерывного мониторинга рынка

- Прямой экспорт данных в Webhooks или Google Таблицы

No-Code Парсеры для Jupiter

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Jupiter без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Jupiter

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Jupiter без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

def get_jupiter_price(token_address):

# Использование официального Jupiter Price API V2 — самый надежный метод

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Токен: {token_address} | Цена: ${price_info['price']}")

except Exception as e:

print(f"Произошла ошибка: {e}")

# Пример: Получение цены SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Jupiter с помощью кода

Python + Requests

import requests

def get_jupiter_price(token_address):

# Использование официального Jupiter Price API V2 — самый надежный метод

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Токен: {token_address} | Цена: ${price_info['price']}")

except Exception as e:

print(f"Произошла ошибка: {e}")

# Пример: Получение цены SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Запуск браузера, способного рендерить фронтенд Next.js

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Ожидание рендеринга элементов списка токенов в DOM

# Примечание: Селекторы должны обновляться в соответствии с текущей сборкой UI

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Прямое обращение к JSON-эндпоинту списка токенов, используемому фронтендом

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Ответ представляет собой необработанный список JSON всех проверенных токенов

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Установка реалистичного User-Agent для обхода базовых фильтров

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Переход на главную страницу свопов

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Пример извлечения элемента цены с использованием частичного селектора

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Цена не найдена';

});

console.log(`Текущая цена SOL в UI: ${solPrice}`);

await browser.close();

})();Что Можно Делать С Данными Jupiter

Изучите практические применения и инсайты из данных Jupiter.

Система оповещения о ценовом арбитраже

Выявление разницы в ценах между Jupiter и другими DEX на Solana для совершения прибыльных сделок.

Как реализовать:

- 1Скрепинг курсов обмена в реальном времени через Price API Jupiter.

- 2Сравнение курсов с пулами ликвидности Orca и Raydium.

- 3Настройка автоматических уведомлений или хуков исполнения для арбитражных возможностей.

Используйте Automatio для извлечения данных из Jupiter и создания этих приложений без написания кода.

Что Можно Делать С Данными Jupiter

- Система оповещения о ценовом арбитраже

Выявление разницы в ценах между Jupiter и другими DEX на Solana для совершения прибыльных сделок.

- Скрепинг курсов обмена в реальном времени через Price API Jupiter.

- Сравнение курсов с пулами ликвидности Orca и Raydium.

- Настройка автоматических уведомлений или хуков исполнения для арбитражных возможностей.

- Дашборд состояния рынка Solana

Создание макроуровневого обзора активности Solana DeFi для инвесторов.

- Агрегация данных о 24-часовом объеме и TVL для топовых token.

- Категоризация token по секторам (Meme, AI, RWA).

- Визуализация смещения ликвидности между различными классами активов с течением времени.

- Снайпер новых листингов token

Немедленное обнаружение и анализ новых token, появляющихся в проверенном списке Jupiter.

- Регулярный скрепинг эндпоинта списка token.

- Сравнение новых результатов с локальной базой данных для поиска новых добавлений.

- Анализ начальной ликвидности и объема для оценки потенциала token.

- Трекер «китов» и бессрочных контрактов

Мониторинг крупных позиций и ставок финансирования на рынке Jupiter Perpetuals.

- Скрепинг данных об открытом интересе и ставках финансирования из раздела Perps.

- Отслеживание логов крупных транзакций для идентификации поведения кошельков.

- Построение моделей настроений на основе соотношения лонг/шорт позиций по основным активам.

- Сервис агрегации доходности

Предоставление пользователям лучших ставок по кредитованию в хранилищах Jupiter Lend.

- Скрепинг данных APY для различных стейблкоинов и пар с SOL.

- Расчет чистой доходности после учета расчетных комиссий платформы.

- Автоматизация рекомендаций по ребалансировке для оптимизации портфеля.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Jupiter

Экспертные советы для успешного извлечения данных из Jupiter.

Всегда отдавайте приоритет официальному API по адресу api.jup.ag перед попытками скрепинга HTML-фронтенда.

Используйте резидентные прокси, чтобы минимизировать блокировки Cloudflare, так как IP дата-центров часто попадают в черный список.

Включите HTTP2 в вашем скрепере, чтобы соответствовать стандартным отпечаткам браузера и избежать обнаружения.

Изучайте WebSocket-соединения (wss

//) во вкладке Network для наиболее эффективного стриминга цен в реальном времени.

Настройте надежную обработку ошибок для ответов 403 Forbidden, которые указывают на блокировку Cloudflare.

Используйте эндпоинт https

//token.jup.ag/all, если вам нужен только статический список проверенных адресов token.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Часто задаваемые вопросы о Jupiter

Найдите ответы на частые вопросы о Jupiter