Hur man skrapar jup.ag: Guide för Jupiter DEX web scraper

Lär dig hur du skrapar jup.ag för real-time Solana token-priser, swap-rutter och marknadsvolymer. Upptäck Jupiters officiella API:er och kringgå Cloudflare...

Anti-bot-skydd upptäckt

- Cloudflare

- WAF och bothantering på företagsnivå. Använder JavaScript-utmaningar, CAPTCHA och beteendeanalys. Kräver webbläsarautomatisering med stealth-inställningar.

- Hastighetsbegränsning

- Begränsar förfrågningar per IP/session över tid. Kan kringgås med roterande proxyservrar, fördröjda förfrågningar och distribuerad skrapning.

- Webbläsarfingeravtryck

- Identifierar botar genom webbläsaregenskaper: canvas, WebGL, typsnitt, plugins. Kräver förfalskning eller riktiga webbläsarprofiler.

- Webbläsarfingeravtryck

- Identifierar botar genom webbläsaregenskaper: canvas, WebGL, typsnitt, plugins. Kräver förfalskning eller riktiga webbläsarprofiler.

Om Jupiter

Upptäck vad Jupiter erbjuder och vilka värdefulla data som kan extraheras.

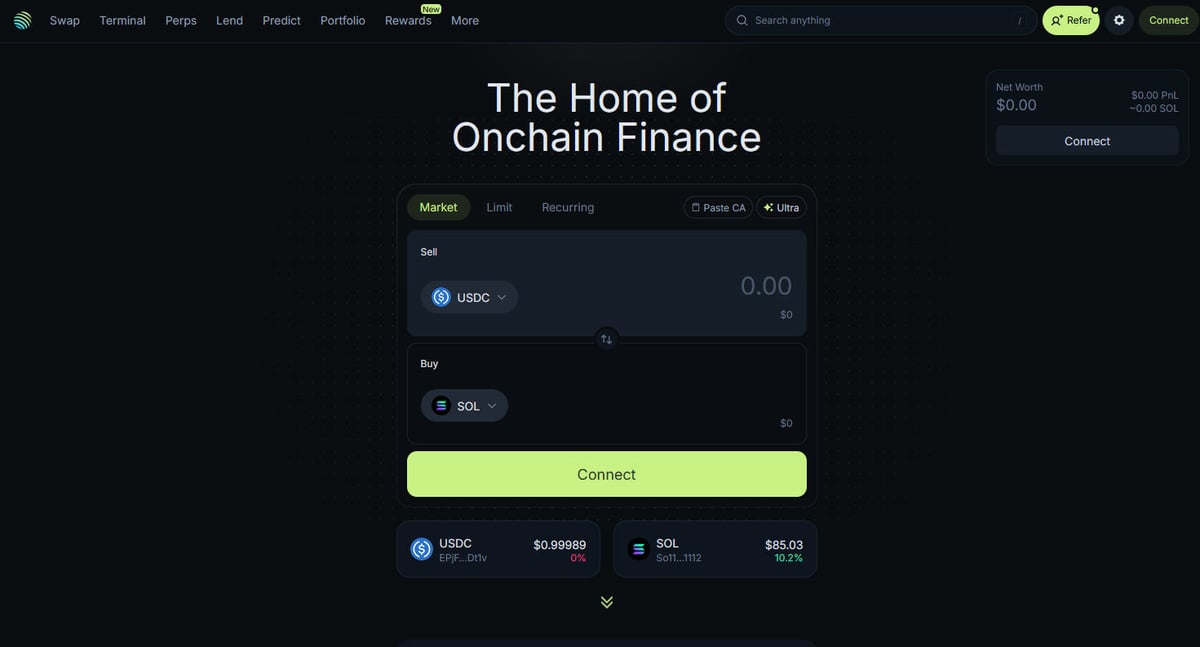

Navet för Solana DeFi

Jupiter är den primära likviditetsaggregatorn för Solana-blockchain, och fungerar som en "DeFi Superapp" som optimerar handelsrutter över hundratals likviditetspooler för att ge användare bästa möjliga priser och minimal slippage. Det är det centrala navet för Solanas on-chain-finansiering och erbjuder tjänster från enkla token-swaps till avancerade funktioner som perpetual trading med upp till 250x leverage, limit orders och dollar-cost averaging (DCA). Plattformen tillhandahåller kritisk data för ekosystemet, inklusive real-time prissättning, likviditetsdjup och omfattande marknadsmått för tusentals tillgångar.

Teknisk arkitektur

Webbplatsen är byggd på en modern teknisk stack med Next.js och React, vilket gör den till en mycket dynamisk single-page application (SPA). Eftersom priser och rutter beräknas i real-time baserat på aktuellt blockchain-tillstånd, uppdateras frontenden ständigt via WebSockets och högfrekventa API-anrop. För data scientists, utvecklare och traders anses Jupiters data vara guldstandarden för att spåra marknadssentiment på Solana och likviditetsförändringar över hela ekosystemet.

Varför datan är viktig

Tillgång till denna data är avgörande för att bygga trading bots, marknadsinstrumentpaneler och för att genomföra historisk analys på ett av de snabbast växande blockchain-nätverken. Scrapers riktar ofta in sig på Jupiter för att övervaka nya token-listningar, spåra "valars" rörelser på perpetual-marknader eller identifiera prisskillnader för arbitrage. Även om plattformen erbjuder officiella API:er, används direkt webbskrapning ofta för att fånga det exakta UI-tillståndet och specifika ruttdata som kanske inte är fullt exponerade i publika endpoints.

Varför Skrapa Jupiter?

Upptäck affärsvärdet och användningsfallen för dataextraktion från Jupiter.

Real-time prisövervakning för Solana-tokens

Utveckling av arbitrage-trading bots mellan DEX

er

Spårning av marknadsvolym och likviditetstrender

Identifiering av nya token-listningar och marknadssentiment

Aggregering av lending yields och perpetual funding rates

Analys av historisk prispåverkan för stora affärer

Skrapningsutmaningar

Tekniska utmaningar du kan stöta på när du skrapar Jupiter.

Aggressiva Cloudflare anti-bot-skydd

Krav på full JavaScript-rendering (React/Next.js)

Aggressiv IP-baserad rate limiting på publika endpoints

Dynamiska och maskerade CSS-selektorer i UI

et

Datauppdateringar i hög hastighet som kräver låg-latency-anslutningar

Skrapa Jupiter med AI

Ingen kod krävs. Extrahera data på minuter med AI-driven automatisering.

Hur det fungerar

Beskriv vad du behöver

Berätta för AI vilka data du vill extrahera från Jupiter. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

AI extraherar datan

Vår artificiella intelligens navigerar Jupiter, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

Få dina data

Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Varför använda AI för skrapning

AI gör det enkelt att skrapa Jupiter utan att skriva kod. Vår AI-drivna plattform använder artificiell intelligens för att förstå vilka data du vill ha — beskriv det bara på vanligt språk och AI extraherar dem automatiskt.

How to scrape with AI:

- Beskriv vad du behöver: Berätta för AI vilka data du vill extrahera från Jupiter. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

- AI extraherar datan: Vår artificiella intelligens navigerar Jupiter, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

- Få dina data: Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Why use AI for scraping:

- No-code-extrahering av data från dynamiska SPA:er

- Automatisk hantering av Cloudflare och browser fingerprints

- Schemalagd extrahering för kontinuerlig marknadsövervakning

- Direkt dataexport till Webhooks eller Google Sheets

No-code webbskrapare för Jupiter

Peka-och-klicka-alternativ till AI-driven skrapning

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa Jupiter utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

Vanliga utmaningar

Inlärningskurva

Att förstå selektorer och extraktionslogik tar tid

Selektorer går sönder

Webbplatsändringar kan förstöra hela ditt arbetsflöde

Problem med dynamiskt innehåll

JavaScript-tunga sidor kräver komplexa lösningar

CAPTCHA-begränsningar

De flesta verktyg kräver manuell hantering av CAPTCHAs

IP-blockering

Aggressiv scraping kan leda till att din IP blockeras

No-code webbskrapare för Jupiter

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa Jupiter utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

- Installera webbläsartillägg eller registrera dig på plattformen

- Navigera till målwebbplatsen och öppna verktyget

- Välj dataelement att extrahera med point-and-click

- Konfigurera CSS-selektorer för varje datafält

- Ställ in pagineringsregler för att scrapa flera sidor

- Hantera CAPTCHAs (kräver ofta manuell lösning)

- Konfigurera schemaläggning för automatiska körningar

- Exportera data till CSV, JSON eller anslut via API

Vanliga utmaningar

- Inlärningskurva: Att förstå selektorer och extraktionslogik tar tid

- Selektorer går sönder: Webbplatsändringar kan förstöra hela ditt arbetsflöde

- Problem med dynamiskt innehåll: JavaScript-tunga sidor kräver komplexa lösningar

- CAPTCHA-begränsningar: De flesta verktyg kräver manuell hantering av CAPTCHAs

- IP-blockering: Aggressiv scraping kan leda till att din IP blockeras

Kodexempel

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")När ska det användas

Bäst för statiska HTML-sidor med minimal JavaScript. Idealiskt för bloggar, nyhetssidor och enkla e-handelsproduktsidor.

Fördelar

- ●Snabbaste exekveringen (ingen webbläsaröverhead)

- ●Lägsta resursförbrukning

- ●Lätt att parallellisera med asyncio

- ●Utmärkt för API:er och statiska sidor

Begränsningar

- ●Kan inte köra JavaScript

- ●Misslyckas på SPA:er och dynamiskt innehåll

- ●Kan ha problem med komplexa anti-bot-system

Hur man skrapar Jupiter med kod

Python + Requests

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Launch a browser that can render the Next.js frontend

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Wait for the token list items to render in the DOM

# Note: Selectors must be updated based on the current UI build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Directly hitting the token list JSON endpoint used by the frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# The response is a raw JSON list of all verified tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent to help bypass basic filters

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigate to the main swap page

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Example of extracting a price element using a partial selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Price not found';

});

console.log(`Live SOL Price observed in UI: ${solPrice}`);

await browser.close();

})();Vad Du Kan Göra Med Jupiter-Data

Utforska praktiska tillämpningar och insikter från Jupiter-data.

Larmsystem för pris-arbitrage

Identifiera prisskillnader mellan Jupiter och andra Solana DEX:er för att utföra lönsamma affärer.

Så här implementerar du:

- 1Skrapa swap-kurser i real-time från Jupiters Price API.

- 2Jämför kurser med likviditetspooler hos Orca och Raydium.

- 3Ställ in automatiserade larm eller exekverings-hooks för arbitrage-möjligheter.

Använd Automatio för att extrahera data från Jupiter och bygga dessa applikationer utan att skriva kod.

Vad Du Kan Göra Med Jupiter-Data

- Larmsystem för pris-arbitrage

Identifiera prisskillnader mellan Jupiter och andra Solana DEX:er för att utföra lönsamma affärer.

- Skrapa swap-kurser i real-time från Jupiters Price API.

- Jämför kurser med likviditetspooler hos Orca och Raydium.

- Ställ in automatiserade larm eller exekverings-hooks för arbitrage-möjligheter.

- Instrumentpanel för Solana-marknadens hälsa

Bygg en makrovy av Solana DeFi-aktivitet för investerare.

- Aggregera 24h volym och TVL-data för de främsta tokens.

- Kategorisera tokens efter sektorer (Meme, AI, RWA).

- Visualisera likviditetsförändringar över olika tillgångsklasser över tid.

- Sniper för nya token-listningar

Upptäck och analysera nya tokens som dyker upp på Jupiters verifierade lista omedelbart.

- Skrapa regelbundet token-listans endpoint.

- Jämför de nya resultaten mot en lokal databas för att hitta nya tillägg.

- Analysera initial likviditet och volym för att bedöma en tokens potential.

- Spårare för valar och Perps

Övervaka stora positioner och funding rates på Jupiter Perpetuals-marknaden.

- Skrapa open interest och funding rate-data från Perps-sektionen.

- Spåra loggar för stora transaktioner för att identifiera plånboksbeteenden.

- Bygg sentiment-modeller baserat på long/short-ratios för stora tillgångar.

- Tjänst för yield-aggregering

Ge användare de bästa utlåningsräntorna tillgängliga via Jupiter Lend-valv.

- Skrapa APY-data för olika stablecoins och SOL-par.

- Beräkna nettoavkastning efter uppskattade plattformavgifter.

- Automatisera rekommendationer för rebalansering för att optimera portföljen.

Superladda ditt arbetsflode med AI-automatisering

Automatio kombinerar kraften av AI-agenter, webbautomatisering och smarta integrationer for att hjalpa dig astadkomma mer pa kortare tid.

Proffstips för Skrapning av Jupiter

Expertråd för framgångsrik dataextraktion från Jupiter.

Prioritera alltid den officiella API

en på api.jup.ag innan du försöker skrapa HTML-frontenden.

Använd residential proxies för att minimera Cloudflare-blockeringar, eftersom datacenter-IP:er ofta är svartlistade.

Aktivera HTTP2 i din scraper för att matcha vanliga browser fingerprints och undvika upptäckt.

Inspektera WebSocket-anslutningar (wss

//) i nätverksfliken för effektiv real-time pris-streaming.

Implementera robust felhantering för 403 Forbidden-svar, vilket indikerar Cloudflare-blockering.

Använd https

//token.jup.ag/all-endpointen om du bara behöver den statiska listan över verifierade token-adresser.

Omdomen

Vad vara anvandare sager

Ga med tusentals nojda anvandare som har transformerat sitt arbetsflode

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relaterat Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Vanliga fragor om Jupiter

Hitta svar pa vanliga fragor om Jupiter