วิธีดึงข้อมูล jup.ag: คู่มือการใช้ Web Scraper สำหรับ Jupiter DEX

เรียนรู้วิธีดึงข้อมูล jup.ag สำหรับราคา Solana token แบบเรียลไทม์, เส้นทางการ swap และปริมาณการซื้อขาย ตรวจสอบ API อย่างเป็นทางการของ Jupiter...

ตรวจพบการป้องกันบอท

- Cloudflare

- WAF และการจัดการบอทระดับองค์กร ใช้ JavaScript challenges, CAPTCHAs และการวิเคราะห์พฤติกรรม ต้องมีระบบอัตโนมัติของเบราว์เซอร์พร้อมการตั้งค่าซ่อนตัว

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- ลายนิ้วมือเบราว์เซอร์

- ระบุบอทผ่านลักษณะเฉพาะของเบราว์เซอร์: canvas, WebGL, ฟอนต์, ปลั๊กอิน ต้องมีการปลอมแปลงหรือโปรไฟล์เบราว์เซอร์จริง

- ลายนิ้วมือเบราว์เซอร์

- ระบุบอทผ่านลักษณะเฉพาะของเบราว์เซอร์: canvas, WebGL, ฟอนต์, ปลั๊กอิน ต้องมีการปลอมแปลงหรือโปรไฟล์เบราว์เซอร์จริง

เกี่ยวกับ Jupiter

ค้นพบสิ่งที่ Jupiter นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

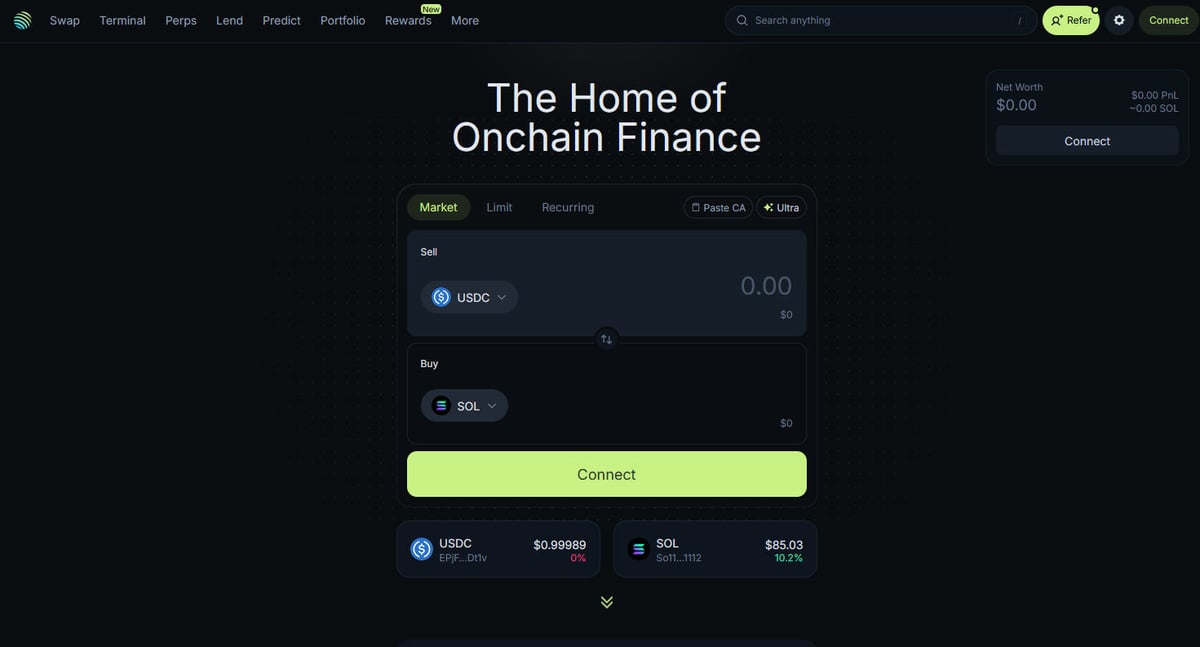

ศูนย์กลางของ Solana DeFi

Jupiter เป็นตัวรวบรวมสภาพคล่อง (liquidity aggregator) หลักสำหรับบล็อกเชน Solana โดยทำหน้าที่เป็น "DeFi Superapp" ที่ช่วยเพิ่มประสิทธิภาพการกำหนดเส้นทางการเทรดผ่านแหล่งสภาพคล่องหลายร้อยแห่ง เพื่อให้ผู้ใช้ได้รับราคาที่ดีที่สุดและมี slippage ต่ำที่สุด เป็นศูนย์กลางสำหรับการเงินบนเชนของ Solana ที่ให้บริการตั้งแต่การ swap token แบบง่ายไปจนถึงฟีเจอร์ขั้นสูง เช่น การเทรดแบบ perpetual ที่มีเลเวอเรจสูงสุด 250 เท่า, limit orders และ dollar-cost averaging (DCA) แพลตฟอร์มนี้ให้ข้อมูลที่สำคัญสำหรับระบบนิเวศ รวมถึงราคาแบบเรียลไทม์ ความลึกของสภาพคล่อง และตัวชี้วัดตลาดที่ครอบคลุมสำหรับสินทรัพย์นับพันรายการ

สถาปัตยกรรมทางเทคนิค

เว็บไซต์ถูกสร้างขึ้นบนเทคโนโลยีสมัยใหม่โดยใช้ Next.js และ React ทำให้เป็น single-page application (SPA) ที่มีความคล่องตัวสูง เนื่องจากราคาและเส้นทางจะถูกคำนวณแบบเรียลไทม์ตามสถานะปัจจุบันของบล็อกเชน หน้าบ้านจึงมีการอัปเดตอยู่ตลอดเวลาผ่าน WebSockets และการเรียกใช้ API ความถี่สูง สำหรับนักวิทยาศาสตร์ข้อมูล นักพัฒนา และนักเทรด ข้อมูลของ Jupiter ถือเป็นมาตรฐานทองคำสำหรับการติดตามความเชื่อมั่นของตลาด Solana และการเปลี่ยนแปลงของสภาพคล่องในระบบนิเวศทั้งหมด

ทำไมข้อมูลนี้จึงสำคัญ

การเข้าถึงข้อมูลนี้เป็นสิ่งจำเป็นสำหรับการสร้างบอทเทรด, แดชบอร์ดตลาด และการวิเคราะห์ย้อนหลังบนเครือข่ายบล็อกเชนที่เติบโตเร็วที่สุดแห่งหนึ่ง Scrapers มักจะตั้งเป้าไปที่ Jupiter เพื่อตรวจสอบการลิสต์ token ใหม่ ติดตามการเคลื่อนไหวของ "whale" ในตลาด perpetual หรือระบุความแตกต่างของราคาสำหรับการทำ arbitrage แม้ว่าแพลตฟอร์มจะมี API อย่างเป็นทางการ แต่การทำ web scraping โดยตรงมักถูกใช้เพื่อเก็บสถานะ UI ที่แน่นอนและข้อมูลการเลือกเส้นทางเฉพาะที่อาจไม่แสดงผลทั้งหมดใน public endpoints

ทำไมต้อง Scrape Jupiter?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก Jupiter

ติดตามราคาแบบเรียลไทม์สำหรับ Solana tokens

พัฒนาบอทเทรดเพื่อทำ arbitrage ระหว่าง DEXs

ติดตามปริมาณการซื้อขายในตลาดและแนวโน้มสภาพคล่อง

ระบุการลิสต์ token ใหม่และความเชื่อมั่นของตลาด

รวบรวมอัตราผลตอบแทนจากการกู้ยืมและ perpetual funding rates

วิเคราะห์ผลกระทบของราคาย้อนหลังสำหรับการเทรดขนาดใหญ่

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape Jupiter

ระบบป้องกัน anti-bot ที่เข้มงวดของ Cloudflare

ความต้องการการเรนเดอร์ JavaScript อย่างสมบูรณ์ (React/Next.js)

การจำกัดอัตรา (rate limiting) ตาม IP ที่เข้มงวดบน endpoint สาธารณะ

CSS selectors ใน UI ที่มีการเปลี่ยนแปลงและถูกปิดบัง (obfuscated)

การอัปเดตข้อมูลความเร็วสูงที่ต้องการการเชื่อมต่อแบบ latency ต่ำ

สกัดข้อมูลจาก Jupiter ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Jupiter แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง Jupiter จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก Jupiter เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Jupiter แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง Jupiter จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- การดึงข้อมูลแบบ no-code จาก SPAs ที่มีความยืดหยุ่นสูง

- จัดการ Cloudflare และ browser fingerprints โดยอัตโนมัติ

- ตั้งเวลาการดึงข้อมูลเพื่อการตรวจสอบตลาดอย่างต่อเนื่อง

- ส่งออกข้อมูลโดยตรงไปยัง Webhooks หรือ Google Sheets

No-code web scrapers สำหรับ Jupiter

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Jupiter โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ Jupiter

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Jupiter โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

def get_jupiter_price(token_address):

# การใช้ Jupiter Price API V2 อย่างเป็นทางการเป็นวิธีที่น่าเชื่อถือที่สุด

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | ราคา: ${price_info['price']}")

except Exception as e:

print(f"เกิดข้อผิดพลาด: {e}")

# ตัวอย่าง: การดึงราคา SOL

get_jupiter_price("So11111111111111111111111111111111111111112")เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล Jupiter ด้วยโค้ด

Python + Requests

import requests

def get_jupiter_price(token_address):

# การใช้ Jupiter Price API V2 อย่างเป็นทางการเป็นวิธีที่น่าเชื่อถือที่สุด

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | ราคา: ${price_info['price']}")

except Exception as e:

print(f"เกิดข้อผิดพลาด: {e}")

# ตัวอย่าง: การดึงราคา SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# เริ่มต้นเบราว์เซอร์ที่สามารถเรนเดอร์ Next.js frontend ได้

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# รอให้รายการ token เรนเดอร์ใน DOM

# หมายเหตุ: Selector ต้องได้รับการอัปเดตตามโครงสร้าง UI ปัจจุบัน

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# เข้าถึง endpoint JSON ของรายการ token ที่ frontend ใช้งานโดยตรง

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# ผลลัพธ์คือรายการ JSON ของ tokens ทั้งหมดที่ได้รับการตรวจสอบแล้ว

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// ตั้งค่า User-Agent ที่เหมือนจริงเพื่อช่วยข้ามการกรองเบื้องต้น

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// ไปยังหน้าหลักสำหรับการ swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// ตัวอย่างการดึงองค์ประกอบราคาโดยใช้ partial selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'ไม่พบราคา';

});

console.log(`ราคา SOL สดที่พบใน UI: ${solPrice}`);

await browser.close();

})();คุณสามารถทำอะไรกับข้อมูล Jupiter

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล Jupiter

ระบบแจ้งเตือนการทำกำไรจากส่วนต่างราคา (Price Arbitrage Alert System)

ระบุความแตกต่างของราคาระหว่าง Jupiter และ Solana DEX อื่นๆ เพื่อดำเนินการเทรดที่ทำกำไร

วิธีการนำไปใช้:

- 1ดึงอัตราการ swap แบบเรียลไทม์จาก Price API ของ Jupiter

- 2เปรียบเทียบอัตรากับแหล่งสภาพคล่องของ Orca และ Raydium

- 3ตั้งค่าการแจ้งเตือนอัตโนมัติหรือจุดเชื่อมต่อการทำงานเพื่อโอกาสในการทำ arbitrage

ใช้ Automatio เพื่อดึงข้อมูลจาก Jupiter และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล Jupiter

- ระบบแจ้งเตือนการทำกำไรจากส่วนต่างราคา (Price Arbitrage Alert System)

ระบุความแตกต่างของราคาระหว่าง Jupiter และ Solana DEX อื่นๆ เพื่อดำเนินการเทรดที่ทำกำไร

- ดึงอัตราการ swap แบบเรียลไทม์จาก Price API ของ Jupiter

- เปรียบเทียบอัตรากับแหล่งสภาพคล่องของ Orca และ Raydium

- ตั้งค่าการแจ้งเตือนอัตโนมัติหรือจุดเชื่อมต่อการทำงานเพื่อโอกาสในการทำ arbitrage

- แดชบอร์ดสุขภาพตลาด Solana

สร้างภาพรวมระดับมหภาคของกิจกรรม Solana DeFi สำหรับนักลงทุน

- รวบรวมข้อมูลปริมาณการซื้อขายใน 24 ชั่วโมง และ TVL สำหรับ token ชั้นนำ

- จัดหมวดหมู่ token ตามภาคส่วน (Meme, AI, RWA)

- สร้างภาพข้อมูลการเปลี่ยนแปลงสภาพคล่องในสินทรัพย์ประเภทต่างๆ เมื่อเวลาผ่านไป

- ระบบตรวจจับการลิสต์ Token ใหม่

ตรวจจับและวิเคราะห์ token ใหม่ที่ปรากฏในรายการที่ได้รับการตรวจสอบของ Jupiter ทันที

- ดึงข้อมูลจาก endpoint รายชื่อ token อย่างสม่ำเสมอ

- เปรียบเทียบผลลัพธ์ใหม่กับฐานข้อมูลในเครื่องเพื่อค้นหารายการที่เพิ่มเข้ามาใหม่

- วิเคราะห์สภาพคล่องเริ่มต้นและปริมาณการซื้อขายเพื่อประเมินศักยภาพของ token

- ตัวติดตาม Whale และ Perps

ตรวจสอบสถานะขนาดใหญ่และค่า funding rates ในตลาด Jupiter Perpetuals

- ดึงข้อมูล open interest และ funding rate จากส่วน Perps

- ติดตามประวัติการทำธุรกรรมขนาดใหญ่เพื่อระบุพฤติกรรมของ wallet

- สร้าง model ความเชื่อมั่นตามอัตราส่วน long/short ของสินทรัพย์หลัก

- บริการรวบรวมผลตอบแทน (Yield Aggregation)

ให้อัตราดอกเบี้ยเงินกู้ที่ดีที่สุดแก่ผู้ใช้ผ่าน Jupiter Lend vaults

- ดึงข้อมูล APY สำหรับ stablecoins ต่างๆ และคู่เทรด SOL

- คำนวณผลตอบแทนสุทธิหลังจากหักค่าธรรมเนียมแพลตฟอร์มโดยประมาณ

- สร้างคำแนะนำการปรับพอร์ตอัตโนมัติเพื่อเพิ่มประสิทธิภาพพอร์ตโฟลิโอ

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape Jupiter

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก Jupiter อย่างประสบความสำเร็จ

ให้ความสำคัญกับ API อย่างเป็นทางการที่ api.jup.ag ก่อนเสมอ แทนที่จะพยายามดึงข้อมูลจากหน้าบ้าน (HTML frontend)

ใช้ residential proxies เพื่อลดการถูกบล็อกโดย Cloudflare เนื่องจาก IP ของศูนย์ข้อมูล (datacenter) มักจะติดบัญชีดำ

เปิดใช้งาน HTTP2 ใน scraper ของคุณเพื่อให้ตรงกับ fingerprints ของเบราว์เซอร์มาตรฐานและหลีกเลี่ยงการถูกตรวจจับ

ตรวจสอบการเชื่อมต่อ WebSocket (wss

//) ในแถบ network สำหรับการทำ streaming ราคาแบบ real-time ที่มีประสิทธิภาพสูงสุด

ใช้การจัดการข้อผิดพลาด (error handling) ที่แข็งแกร่งสำหรับคำตอบ 403 Forbidden ซึ่งบ่งบอกว่าถูก Cloudflare บล็อก

เป้าหมายไปที่ endpoint https

//token.jup.ag/all หากคุณต้องการเพียงรายการที่อยู่ token ที่ได้รับการตรวจสอบแล้ว

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

คำถามที่พบบ่อยเกี่ยวกับ Jupiter

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ Jupiter