วิธีดึงข้อมูล (Scrape) Signal NFX | คู่มือการดึงข้อมูลฐานข้อมูลนักลงทุน & VC

เรียนรู้วิธีดึงข้อมูลโปรไฟล์นักลงทุน, ข้อมูลบริษัท VC และรายชื่อกลุ่มเป้าหมายจาก Signal NFX ค้นพบกลยุทธ์ทางเทคนิคสำหรับการระดมทุนและการวิจัยตลาด

ตรวจพบการป้องกันบอท

- Cloudflare

- WAF และการจัดการบอทระดับองค์กร ใช้ JavaScript challenges, CAPTCHAs และการวิเคราะห์พฤติกรรม ต้องมีระบบอัตโนมัติของเบราว์เซอร์พร้อมการตั้งค่าซ่อนตัว

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- การบล็อก IP

- บล็อก IP ของศูนย์ข้อมูลที่รู้จักและที่อยู่ที่ถูกทำเครื่องหมาย ต้องใช้พร็อกซีที่อยู่อาศัยหรือมือถือเพื่อหลีกเลี่ยงอย่างมีประสิทธิภาพ

- Login Wall

- Google reCAPTCHA

- ระบบ CAPTCHA ของ Google v2 ต้องมีการโต้ตอบของผู้ใช้ v3 ทำงานเงียบๆ ด้วยคะแนนความเสี่ยง สามารถแก้ได้ด้วยบริการ CAPTCHA

เกี่ยวกับ Signal (โดย NFX)

ค้นพบสิ่งที่ Signal (โดย NFX) นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

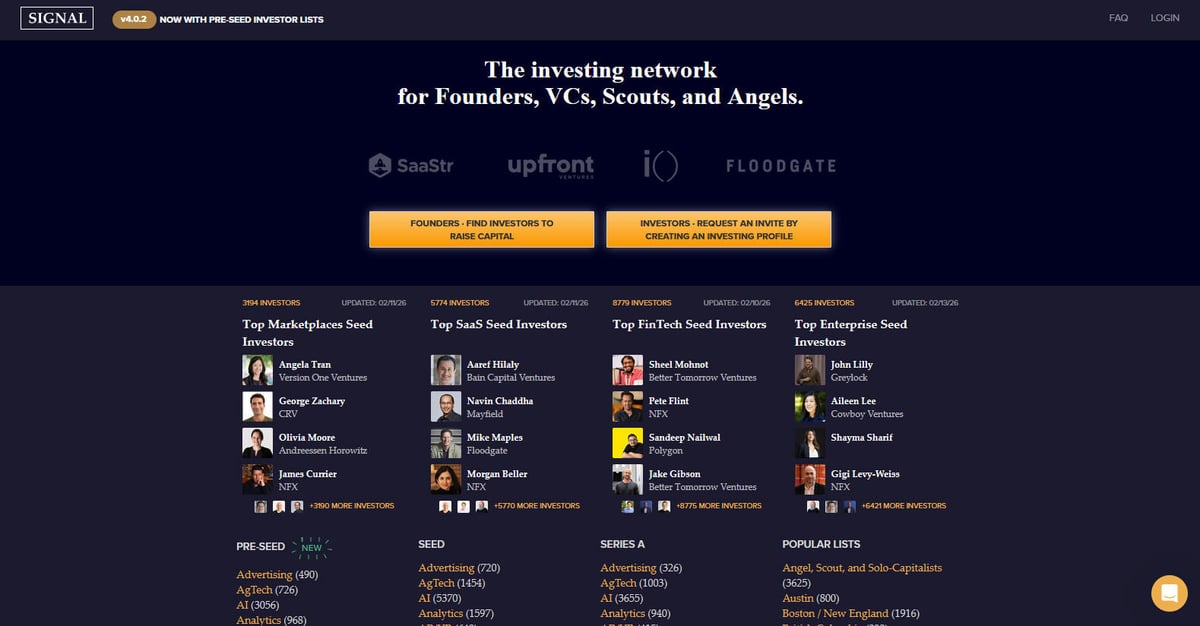

Signal คือเครือข่ายการลงทุนที่ทรงพลังซึ่งออกแบบมาโดยเฉพาะสำหรับ founders, VCs, scouts และ angel investors แพลตฟอร์มนี้สร้างและดูแลโดย NFX ซึ่งเป็นบริษัท venture capital ชั้นนำในระดับ seed-stage โดยทำหน้าที่เป็นไดเรกทอรีขนาดใหญ่และเครื่องมือสร้างเครือข่ายเพื่ออำนวยความสะดวกในการระดมทุนของ startup มีเป้าหมายเพื่อสร้างความโปร่งใสในระบบนิเวศการลงทุนโดยการแสดงแผนผังความสัมพันธ์ระหว่างนักลงทุนและผู้ประกอบการ แทนที่การใช้สเปรดชีตแบบเดิมด้วยสภาพแวดล้อมที่ขับเคลื่อนด้วยข้อมูลแบบไดนามิก

แพลตฟอร์มนี้ประกอบด้วยโปรไฟล์นักลงทุนหลายพันคน แบ่งหมวดหมู่ตามระยะการลงทุนที่ต้องการ (ตั้งแต่ Pre-Seed ถึง Series B), กลุ่มอุตสาหกรรม เช่น AI, SaaS, และ FinTech รวมถึงภูมิภาคทางภูมิศาสตร์ ผู้ใช้สามารถค้นหาข้อมูลโดยละเอียดเกี่ยวกับบริษัท venture capital, พาร์ทเนอร์แต่ละราย และจุดเน้นการลงทุนเฉพาะด้าน ซึ่งมีการอัปเดตบ่อยครั้งเพื่อให้สะท้อนถึงภาพรวมตลาดในปัจจุบัน ข้อมูลแต่ละรายการมักจะประกอบด้วยเป้าหมายของนักลงทุน, ระยะการลงทุนที่ชอบ, วิสัยทัศน์การลงทุน (investment theses) และความพึงพอใจในการเข้าหาจาก founder โดยตรง

การดึงข้อมูลจาก Signal มีค่าอย่างยิ่งสำหรับ founders ที่ต้องการสร้างรายชื่อนักลงทุนเป้าหมายโดยไม่ต้องเสียเวลานั่งไล่ดูทีละรายการด้วยตนเอง นอกจากนี้ยังให้ข้อมูลสำคัญสำหรับนักวิจัยตลาดที่ติดตามแนวโน้มของ venture capital, ข้อมูลเชิงลึกด้านการแข่งขันสำหรับบริษัท VC อื่นๆ และข้อมูลสำหรับทีมขายที่ต้องการเจาะกลุ่มระบบนิเวศ startup ผ่านการทำแผนที่ความสัมพันธ์และช่องทางการแนะนำตัว

ทำไมต้อง Scrape Signal (โดย NFX)?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก Signal (โดย NFX)

การระดมทุนที่ตรงเป้าหมาย

สร้างรายชื่อนักลงทุนที่แม่นยำซึ่งเป็นผู้นำในรอบ seed หรือ pre-seed ในอุตสาหกรรมเฉพาะของคุณ

การวิจัยตลาด

วิเคราะห์ว่าอุตสาหกรรมใดได้รับความสนใจมากที่สุดจาก VCs ระดับแนวหน้าอย่าง Andreessen Horowitz หรือ Greylock

การหาลูกค้าเป้าหมาย (Lead Generation)

ระบุบริษัท VC และนักลงทุนรายบุคคลรายใหม่ที่เข้าสู่ตลาดภูมิภาคเฉพาะ เช่น LATAM หรือเอเชียตะวันออกเฉียงใต้

ข้อมูลเชิงแข่งขัน

ติดตามพอร์ตโฟลิโอและจุดเน้นของบริษัทร่วมลงทุนคู่แข่งเพื่อทำความเข้าใจกลยุทธ์การขยายตัวของพวกเขา

การรวบรวมข้อมูล

สร้างฐานข้อมูลภายในที่ครอบคลุมของระบบนิเวศ venture capital สำหรับการวิเคราะห์เชิงวิชาการหรือธุรกิจ

การทำแผนที่ความสัมพันธ์

ดึงข้อมูลการเชื่อมต่อเพื่อค้นหาเส้นทางที่มีแรงต้านน้อยที่สุดสำหรับการแนะนำตัวไปยัง VCs ชื่อดัง

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape Signal (โดย NFX)

ความจำเป็นในการ Login

ข้อมูลนักลงทุนที่ละเอียดที่สุดส่วนใหญ่จะถูกซ่อนไว้หลังกำแพง login ซึ่งต้องมีการจัดการ session หรือการยืนยันตัวตนแบบอัตโนมัติ

การแสดงผล JavaScript

ไซต์นี้ใช้การโหลดข้อมูลแบบไดนามิกสำหรับรายชื่อนักลงทุน (Infinite Scroll) ซึ่งต้องใช้ browser-based scraper ในการรัน JS

มาตรการป้องกัน Bot

การใช้ Cloudflare WAF และ API endpoints เฉพาะสำหรับการดึงข้อมูล หมายความว่าคำขอปกติอาจถูกบล็อกหากไม่มี headers ที่ถูกต้อง

การจำกัดอัตรา (Rate Limits)

การดึงข้อมูลด้วยความถี่สูงอาจทำให้เกิดการแบน IP หรือเจอ CAPTCHA เนื่องจากลักษณะเครือข่ายที่เป็นแบบมืออาชีพและปลอดภัยสูง

โครงสร้าง DOM ที่ซับซ้อน

ไซต์ใช้องค์ประกอบแบบไดนามิกและส่วนประกอบ frontend แบบกำหนดเอง ซึ่งต้องใช้ selectors ที่เสถียรเพื่อการดึงข้อมูลที่เชื่อถือได้

สกัดข้อมูลจาก Signal (โดย NFX) ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Signal (โดย NFX) แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง Signal (โดย NFX) จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก Signal (โดย NFX) เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก Signal (โดย NFX) แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง Signal (โดย NFX) จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- การตั้งค่าแบบ No-Code: สร้างตัวดึงข้อมูล Signal ได้ด้วยภาพโดยไม่ต้องเขียนสคริปต์ที่ซับซ้อนสำหรับการยืนยันตัวตนหรือการรัน JS

- การ Login อัตโนมัติ: จัดการขั้นตอนการ login ของ Signal ได้อย่างง่ายดายภายในเวิร์กโฟลว์ของ Automatio เพื่อเข้าถึงโปรไฟล์ที่ถูกจำกัดไว้

- การจัดการเนื้อหาแบบไดนามิก: รอและดึงข้อมูลจากรายการแบบไดนามิกและองค์ประกอบ infinite scroll โดยอัตโนมัติ

- การอัปเดตตามกำหนดเวลา: ตั้งค่าให้ scraper ทำงานรายสัปดาห์เพื่อค้นหานักลงทุนที่เพิ่มเข้ามาใหม่หรือรายชื่อหมวดหมู่อุตสาหกรรมที่อัปเดตโดยไม่ต้องทำเอง

- การส่งออกข้อมูล: เชื่อมต่อโดยตรงเพื่อส่งออกรายชื่อนักลงทุนไปยัง Google Sheets, CSV หรือ Webhooks เพื่อการใช้งานต่อในทันที

No-code web scrapers สำหรับ Signal (โดย NFX)

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Signal (โดย NFX) โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ Signal (โดย NFX)

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape Signal (โดย NFX) โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

from bs4 import BeautifulSoup

# Signal ต้องทำการ login เพื่อเข้าถึงข้อมูลแบบเต็ม ตัวอย่างนี้ใช้ session

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# ในสถานการณ์จริง คุณต้องทำการ POST ข้อมูล login ที่นี่ก่อน

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ค้นหาการ์ดนักลงทุนในรายการ

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'นักลงทุน: {name} | บริษัท: {firm}')

except Exception as e:

print(f'เกิดข้อผิดพลาดในการดึงข้อมูล Signal: {e}')เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล Signal (โดย NFX) ด้วยโค้ด

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signal ต้องทำการ login เพื่อเข้าถึงข้อมูลแบบเต็ม ตัวอย่างนี้ใช้ session

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# ในสถานการณ์จริง คุณต้องทำการ POST ข้อมูล login ที่นี่ก่อน

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# ค้นหาการ์ดนักลงทุนในรายการ

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'นักลงทุน: {name} | บริษัท: {firm}')

except Exception as e:

print(f'เกิดข้อผิดพลาดในการดึงข้อมูล Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# ไปที่หน้า login

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'your_email@example.com')

page.fill('input[name="password"]', 'your_password')

page.click('button:has-text("Log In")')

# รอให้หน้าแสดงรายชื่อโหลดหลังจาก login

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Scroll เพื่อโหลดเนื้อหาแบบ infinite

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'พบนักลงทุน: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# หมายเหตุ: จำเป็นต้องใช้ scrapy-playwright สำหรับการแสดงผล JavaScript

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# ตรรกะของ Scrapy สำหรับ infinite scroll จะต้องใช้ Playwright handler แบบกำหนดเอง

# เพื่อเลื่อนลงด้านล่างก่อนจะส่ง response กลับมาที่ parseNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// จัดการการ Login ก่อน

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'your_email');

await page.type('#user_password', 'your_password');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();คุณสามารถทำอะไรกับข้อมูล Signal (โดย NFX)

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล Signal (โดย NFX)

การระดมทุนอัตโนมัติ (Fundraising Outreach Automation)

Founders สามารถใช้ข้อมูลเพื่อระบุและจัดลำดับความสำคัญของนักลงทุนที่มีแนวโน้มจะลงทุนในระยะและกลุ่มอุตสาหกรรมของตนมากที่สุด

วิธีการนำไปใช้:

- 1ดึงข้อมูลรายชื่อนักลงทุนในอุตสาหกรรมของคุณ (เช่น 'Top AI Seed Investors')

- 2กรองผลลัพธ์ตาม 'Last Updated' เพื่อค้นหาผู้ที่กำลังมีความเคลื่อนไหวในการให้ทุน

- 3ส่งออกข้อมูลไปยัง CRM เช่น HubSpot หรือ Pipedrive เพื่อติดตามการเข้าหา

- 4ใช้ลิงก์โปรไฟล์เพื่อระบุการเชื่อมต่อร่วมกันสำหรับการแนะนำตัวแบบ warm introductions

ใช้ Automatio เพื่อดึงข้อมูลจาก Signal (โดย NFX) และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล Signal (โดย NFX)

- การระดมทุนอัตโนมัติ (Fundraising Outreach Automation)

Founders สามารถใช้ข้อมูลเพื่อระบุและจัดลำดับความสำคัญของนักลงทุนที่มีแนวโน้มจะลงทุนในระยะและกลุ่มอุตสาหกรรมของตนมากที่สุด

- ดึงข้อมูลรายชื่อนักลงทุนในอุตสาหกรรมของคุณ (เช่น 'Top AI Seed Investors')

- กรองผลลัพธ์ตาม 'Last Updated' เพื่อค้นหาผู้ที่กำลังมีความเคลื่อนไหวในการให้ทุน

- ส่งออกข้อมูลไปยัง CRM เช่น HubSpot หรือ Pipedrive เพื่อติดตามการเข้าหา

- ใช้ลิงก์โปรไฟล์เพื่อระบุการเชื่อมต่อร่วมกันสำหรับการแนะนำตัวแบบ warm introductions

- การวิเคราะห์คู่แข่งในสาย VC (VC Competitive Landscape Analysis)

บริษัทร่วมลงทุนสามารถติดตามความสนใจและการขยายทีมของบริษัทอื่นเพื่อรักษาความสามารถในการแข่งขันในระบบนิเวศ

- ดึงข้อมูลส่วน 'Firms' ของ Signal เป็นระยะเพื่อติดตามการเปลี่ยนแปลง

- ระบุว่าบริษัทใดกำลังเพิ่ม 'Scouts' หรือ 'Angels' รายใหม่เข้าสู่เครือข่าย

- ติดตามการเปลี่ยนทิศทางการลงทุนโดยตรวจสอบการเปลี่ยนแปลงของจำนวนรายชื่อในแต่ละกลุ่มอุตสาหกรรมเมื่อเวลาผ่านไป

- กลยุทธ์การขยายตัวตามภูมิศาสตร์ (Geographic Expansion Strategy)

บริษัทหรือนักลงทุนที่ต้องการเข้าสู่ตลาดใหม่สามารถระบุตัวละครทางการเงินหลักในภูมิภาคเฉพาะได้

- ดึงข้อมูลรายชื่อเฉพาะภูมิภาค เช่น 'LatAm', 'Israel' หรือ 'MENA'

- จัดหมวดหมู่นักลงทุนตามประเภทบริษัท (VC เทียบกับ Angel) เพื่อทำความเข้าใจสัดส่วนเงินทุน

- ทำแผนที่สภาพแวดล้อมการให้ทุนในท้องถิ่นเพื่อระบุผู้ลงทุนหลักที่มีศักยภาพสำหรับการเข้าสู่ตลาด

- การทำแผนผังความสัมพันธ์และการแนะนำตัว (Relationship and Intro Mapping)

วิเคราะห์ความสัมพันธ์ทางสังคมเพื่อค้นหาเส้นทางที่ง่ายที่สุดสำหรับการแนะนำตัวไปยัง VCs ระดับสูง

- ดึงข้อมูลการเชื่อมต่อร่วมกันและข้อมูลโครงข่ายสังคมจากโปรไฟล์นักลงทุน

- นำการเชื่อมต่อที่ดึงมาได้ไปตรวจสอบร่วมกับเครือข่าย LinkedIn ของคุณเอง

- จัดลำดับความสำคัญในการติดต่อตามความแข็งแกร่งของจุดเชื่อมต่อที่มีอยู่

- การวิจัยตลาดในกลุ่มอุตสาหกรรมใหม่ (Market Research on Emerging Sectors)

วิเคราะห์ว่าอุตสาหกรรมใหม่ใดกำลังมีความหนาแน่นเพิ่มขึ้นในแผนผังการลงทุนเพื่อทำนายแนวโน้มต่อไป

- ดึงข้อมูล tags เฉพาะกลุ่มอุตสาหกรรมและจำนวนในแต่ละระยะการระดมทุน

- คำนวณการเติบโตของความสนใจของนักลงทุนในหมวดหมู่เฉพาะตามช่วงไตรมาส

- สร้างรายงานสำหรับผู้มีส่วนได้ส่วนเสียว่ากระแสเงินลงทุนอัจฉริยะ ('smart money') กำลังไหลไปที่ใดในปัจจุบัน

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape Signal (โดย NFX)

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก Signal (โดย NFX) อย่างประสบความสำเร็จ

การจัดการ Session

เนื่องจากการดูโปรไฟล์แบบเต็มจำเป็นต้อง login ควรทำการเก็บและนำ cookies กลับมาใช้ใหม่เพื่อหลีกเลี่ยงความพยายามในการ login ซ้ำๆ ซึ่งอาจไปกระตุ้นการแจ้งเตือนด้านความปลอดภัย

การเลือก Proxy

ควรใช้ residential proxies คุณภาพสูง เนื่องจาก IP ของ data center มักถูกตรวจจับโดยระบบ bot protection ของ Cloudflare บนเครือข่ายระดับมืออาชีพ

เคารพ Robots.txt

ตรวจสอบไฟล์ robots.txt ของ Signal เพื่อดูว่าเส้นทางใดถูกจำกัด และตั้งค่าหน่วงเวลาการ crawl (crawl delay) ที่เหมาะสมเพื่อหลีกเลี่ยงการถูกจำกัดความเร็ว

เลียนแบบพฤติกรรมมนุษย์

เพิ่มการหน่วงเวลาแบบสุ่ม 2-5 วินาทีระหว่างการโหลดหน้าเว็บ และจำลองการเคลื่อนไหวของเมาส์หรือการ scroll เพื่อไม่ให้ถูกตรวจจับ

Scrape ในช่วงเวลาที่มีทราฟฟิกน้อย

ดำเนินการดึงข้อมูลขนาดใหญ่ในช่วงที่มีการใช้งานต่ำ เช่น วันหยุดสุดสัปดาห์ เพื่อลดภาระของเซิร์ฟเวอร์และลดโอกาสในการถูกตรวจจับ

ความเสถียรของ Selector

มองหารูปแบบ ID ที่เสถียรหรือ data attributes (เช่น data-testid) หากมี เนื่องจากชื่อ class ภายในของ Signal อาจเปลี่ยนไปตามการอัปเดตระบบ

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

คำถามที่พบบ่อยเกี่ยวกับ Signal (โดย NFX)

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ Signal (โดย NFX)