jup.ag Nasıl Scrape Edilir: Jupiter DEX Web Scraper Rehberi

Gerçek zamanlı Solana token fiyatları, swap rotaları ve piyasa hacimleri için jup.ag'yi nasıl scrape edeceğinizi öğrenin. Jupiter'in resmi API'lerini keşfedin...

Anti-Bot Koruması Tespit Edildi

- Cloudflare

- Kurumsal düzey WAF ve bot yönetimi. JavaScript zorlukları, CAPTCHA'lar ve davranış analizi kullanır. Gizli ayarlarla tarayıcı otomasyonu gerektirir.

- Hız sınırlama

- IP/oturum başına zamana bağlı istek sayısını sınırlar. Dönen proxy'ler, istek gecikmeleri ve dağıtılmış kazıma ile atlatılabilir.

- Tarayıcı parmak izi

- Tarayıcı özelliklerine göre botları tanımlar: canvas, WebGL, yazı tipleri, eklentiler. Taklit veya gerçek tarayıcı profilleri gerektirir.

- Tarayıcı parmak izi

- Tarayıcı özelliklerine göre botları tanımlar: canvas, WebGL, yazı tipleri, eklentiler. Taklit veya gerçek tarayıcı profilleri gerektirir.

Jupiter Hakkında

Jupiter'in sunduklarını ve çıkarılabilecek değerli verileri keşfedin.

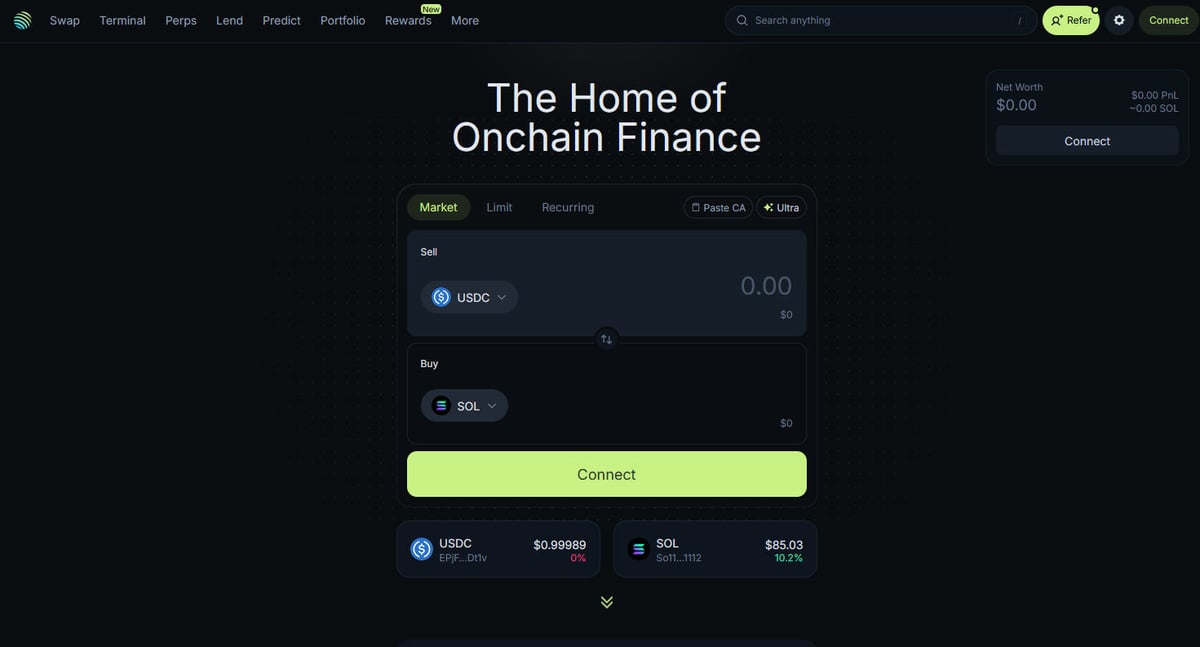

Solana DeFi'nin Merkezi

Jupiter, Solana blockchain'i için birincil likidite agregatörüdür; yüzlerce likidite havuzu arasında işlem rotalamasını optimize ederek kullanıcılara en iyi fiyatları ve minimum slippage'ı sağlayan bir "DeFi Süper Uygulaması" (Superapp) olarak görev yapar. Solana'nın on-chain finansının merkezi olan platform, basit token swap işlemlerinden 250x kaldıraca kadar perpetual trading, limit emirleri ve dolar maliyeti ortalaması (DCA) gibi gelişmiş özelliklere kadar geniş bir hizmet yelpazesi sunar. Platform; binlerce varlık için gerçek zamanlı fiyatlandırma, likidite derinliği ve kapsamlı piyasa metrikleri dahil olmak üzere ekosistem için kritik veriler sağlar.

Teknik Mimari

Web sitesi, Next.js ve React kullanan modern bir teknik yığın üzerine inşa edilmiştir ve bu da onu oldukça dinamik bir tek sayfalık uygulama (SPA) haline getirir. Fiyatlar ve rotalar mevcut blockchain durumuna göre gerçek zamanlı olarak hesaplandığı için, frontend sürekli olarak WebSockets ve yüksek frekanslı API çağrıları aracılığıyla güncellenir. Veri bilimcileri, geliştiriciler ve trader'lar için Jupiter'in verileri, tüm ekosistemdeki Solana piyasa duyarlılığını ve likidite kaymalarını takip etmek için altın standart olarak kabul edilir.

Veriler Neden Önemli

Bu verilere erişmek, en hızlı büyüyen blockchain ağlarından birinde işlem botları, piyasa panoları oluşturmak ve geçmiş analizleri yapmak için temeldir. Scraper'lar genellikle yeni token listelemelerini izlemek, perpetual piyasalardaki "whale" hareketlerini takip etmek veya arbitraj için fiyat farklılıklarını belirlemek amacıyla Jupiter'i hedef alır. Platform resmi API'ler sunsa da, doğrudan web scraping, UI durumunu ve halka açık endpoint'lerde tam olarak sunulmayan özel rotalama verilerini yakalamak için sıklıkla kullanılır.

Neden Jupiter Kazımalı?

Jupiter'den veri çıkarmanın iş değerini ve kullanım durumlarını keşfedin.

Solana token'ları için gerçek zamanlı fiyat izleme

DEX'ler arası arbitraj trading botları geliştirme

Piyasa hacmi ve likidite trendlerini takip etme

Yeni token listelemelerini ve piyasa duyarlılığını belirleme

Lending getirilerini ve perpetual funding rate'leri toplama

Büyük işlemler için geçmiş fiyat etkisini analiz etme

Kazıma Zorlukları

Jupiter kazırken karşılaşabileceğiniz teknik zorluklar.

Agresif Cloudflare anti-bot korumaları

Tam JavaScript rendering gereksinimi (React/Next.js)

Genel endpoint'lerde IP tabanlı agresif rate limiting

UI içindeki dinamik ve gizlenmiş CSS seçicileri

Düşük gecikmeli bağlantı gerektiren yüksek hızlı veri güncellemeleri

AI ile Jupiter Kazıyın

Kod gerekmez. AI destekli otomasyonla dakikalar içinde veri çıkarın.

Nasıl Çalışır

İhtiyacınızı tanımlayın

AI'ya Jupiter üzerinden hangi verileri çıkarmak istediğinizi söyleyin. Doğal dilde yazmanız yeterli — kod veya seçiciler gerekmez.

AI verileri çıkarır

Yapay zekamız Jupiter'i dolaşır, dinamik içerikleri işler ve tam olarak istediğiniz verileri çıkarır.

Verilerinizi alın

CSV, JSON olarak dışa aktarmaya veya doğrudan uygulamalarınıza göndermeye hazır temiz, yapılandırılmış veriler alın.

Kazıma için neden AI kullanmalısınız

AI, kod yazmadan Jupiter'i kazımayı kolaylaştırır. Yapay zeka destekli platformumuz hangi verileri istediğinizi anlar — doğal dilde tanımlayın, AI otomatik olarak çıkarsın.

How to scrape with AI:

- İhtiyacınızı tanımlayın: AI'ya Jupiter üzerinden hangi verileri çıkarmak istediğinizi söyleyin. Doğal dilde yazmanız yeterli — kod veya seçiciler gerekmez.

- AI verileri çıkarır: Yapay zekamız Jupiter'i dolaşır, dinamik içerikleri işler ve tam olarak istediğiniz verileri çıkarır.

- Verilerinizi alın: CSV, JSON olarak dışa aktarmaya veya doğrudan uygulamalarınıza göndermeye hazır temiz, yapılandırılmış veriler alın.

Why use AI for scraping:

- Dinamik SPA'lardan kod yazmadan veri çıkarma

- Cloudflare ve tarayıcı parmak izlerinin otomatik yönetimi

- Sürekli piyasa takibi için planlanmış veri çekme

- Webhooks veya Google Sheets'e doğrudan veri aktarımı

Jupiter için Kodsuz Web Kazıyıcılar

AI destekli kazımaya tıkla ve seç alternatifleri

Browse.ai, Octoparse, Axiom ve ParseHub gibi birçok kodsuz araç, kod yazmadan Jupiter kazımanıza yardımcı olabilir. Bu araçlar genellikle veri seçmek için görsel arayüzler kullanır, ancak karmaşık dinamik içerik veya anti-bot önlemleriyle zorlanabilirler.

Kodsuz Araçlarla Tipik İş Akışı

Yaygın Zorluklar

Öğrenme eğrisi

Seçicileri ve çıkarma mantığını anlamak zaman alır

Seçiciler bozulur

Web sitesi değişiklikleri tüm iş akışınızı bozabilir

Dinamik içerik sorunları

JavaScript ağırlıklı siteler karmaşık çözümler gerektirir

CAPTCHA sınırlamaları

Çoğu araç CAPTCHA için manuel müdahale gerektirir

IP engelleme

Agresif scraping IP'nizin engellenmesine yol açabilir

Jupiter için Kodsuz Web Kazıyıcılar

Browse.ai, Octoparse, Axiom ve ParseHub gibi birçok kodsuz araç, kod yazmadan Jupiter kazımanıza yardımcı olabilir. Bu araçlar genellikle veri seçmek için görsel arayüzler kullanır, ancak karmaşık dinamik içerik veya anti-bot önlemleriyle zorlanabilirler.

Kodsuz Araçlarla Tipik İş Akışı

- Tarayıcı eklentisini kurun veya platforma kaydolun

- Hedef web sitesine gidin ve aracı açın

- Çıkarmak istediğiniz veri öğelerini tıklayarak seçin

- Her veri alanı için CSS seçicileri yapılandırın

- Birden fazla sayfayı scrape etmek için sayfalama kuralları ayarlayın

- CAPTCHA'ları yönetin (genellikle manuel çözüm gerektirir)

- Otomatik çalıştırmalar için zamanlama yapılandırın

- Verileri CSV, JSON'a aktarın veya API ile bağlanın

Yaygın Zorluklar

- Öğrenme eğrisi: Seçicileri ve çıkarma mantığını anlamak zaman alır

- Seçiciler bozulur: Web sitesi değişiklikleri tüm iş akışınızı bozabilir

- Dinamik içerik sorunları: JavaScript ağırlıklı siteler karmaşık çözümler gerektirir

- CAPTCHA sınırlamaları: Çoğu araç CAPTCHA için manuel müdahale gerektirir

- IP engelleme: Agresif scraping IP'nizin engellenmesine yol açabilir

Kod Örnekleri

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Ne Zaman Kullanılır

Minimal JavaScript içeren statik HTML sayfaları için en iyisi. Bloglar, haber siteleri ve basit e-ticaret ürün sayfaları için idealdir.

Avantajlar

- ●En hızlı çalışma (tarayıcı yükü yok)

- ●En düşük kaynak tüketimi

- ●asyncio ile kolayca paralelleştirilebilir

- ●API'ler ve statik sayfalar için harika

Sınırlamalar

- ●JavaScript çalıştıramaz

- ●SPA'larda ve dinamik içerikte başarısız olur

- ●Karmaşık anti-bot sistemleriyle zorlanabilir

Kod ile Jupiter Nasıl Kazınır

Python + Requests

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Launch a browser that can render the Next.js frontend

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Wait for the token list items to render in the DOM

# Note: Selectors must be updated based on the current UI build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Directly hitting the token list JSON endpoint used by the frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# The response is a raw JSON list of all verified tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent to help bypass basic filters

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigate to the main swap page

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Example of extracting a price element using a partial selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Price not found';

});

console.log(`Live SOL Price observed in UI: ${solPrice}`);

await browser.close();

})();Jupiter Verileriyle Neler Yapabilirsiniz

Jupiter verilerinden pratik uygulamaları ve içgörüleri keşfedin.

Fiyat Arbitrajı Alarm Sistemi

Kârlı işlemler gerçekleştirmek için Jupiter ve diğer Solana DEX'leri arasındaki fiyat farklarını belirleyin.

Nasıl uygulanır:

- 1Jupiter Price API'den gerçek zamanlı swap oranlarını scrape edin.

- 2Oranları Orca ve Raydium likidite havuzlarıyla karşılaştırın.

- 3Arbitraj fırsatları için otomatik alarmlar veya yürütme hook'ları kurun.

Jupiter sitesinden veri çıkarmak ve kod yazmadan bu uygulamaları oluşturmak için Automatio kullanın.

Jupiter Verileriyle Neler Yapabilirsiniz

- Fiyat Arbitrajı Alarm Sistemi

Kârlı işlemler gerçekleştirmek için Jupiter ve diğer Solana DEX'leri arasındaki fiyat farklarını belirleyin.

- Jupiter Price API'den gerçek zamanlı swap oranlarını scrape edin.

- Oranları Orca ve Raydium likidite havuzlarıyla karşılaştırın.

- Arbitraj fırsatları için otomatik alarmlar veya yürütme hook'ları kurun.

- Solana Piyasa Sağlığı Panosu

Yatırımcılar için Solana DeFi faaliyetlerine dair makro düzeyde bir görünüm oluşturun.

- En iyi token'lar için 24 saatlik hacim ve TVL verilerini toplayın.

- Token'ları sektörlere göre kategorize edin (Meme, AI, RWA).

- Farklı varlık sınıfları arasındaki likidite kaymalarını zaman içinde görselleştirin.

- Yeni Token Listeleme Sniper'ı

Jupiter'in doğrulanmış listesinde görünen yeni token'ları anında tespit edin ve analiz edin.

- Token listesi endpoint'ini düzenli olarak scrape edin.

- Yeni eklemeleri bulmak için sonuçları yerel bir veritabanıyla karşılaştırın.

- Token potansiyelini değerlendirmek için başlangıç likiditesini ve hacmini analiz edin.

- Whale ve Perps Takipçisi

Jupiter Perpetuals piyasasındaki büyük pozisyonları ve funding rate'leri izleyin.

- Perps bölümünden open interest ve funding rate verilerini scrape edin.

- Cüzdan davranışlarını belirlemek için büyük işlem loglarını takip edin.

- Büyük varlıkların long/short oranlarına dayalı duyarlılık modelleri oluşturun.

- Getiri Agregasyon Hizmeti

Kullanıcılara Jupiter Lend vault'ları genelinde mevcut olan en iyi borç verme oranlarını sunun.

- Çeşitli stablecoin'ler ve SOL pariteleri için APY verilerini scrape edin.

- Tahmini platform ücretlerinden sonra net getiriyi hesaplayın.

- Portföy optimizasyonu için yeniden dengeleme önerilerini otomatize edin.

İş akışınızı güçlendirin Yapay Zeka Otomasyonu

Automatio, yapay zeka ajanlari, web otomasyonu ve akilli entegrasyonlarin gucunu birlestirerek daha az zamanda daha fazlasini basarmaniza yardimci olur.

Jupiter Kazımak için Pro İpuçları

Jupiter'den başarılı veri çıkarmak için uzman tavsiyeler.

HTML frontend'i scrape etmeye çalışmadan önce her zaman api.jup.ag adresindeki resmi API'ye öncelik verin.

Veri merkezi (datacenter) IP'leri genellikle kara listede olduğu için Cloudflare engellemelerini minimize etmek amacıyla residential proxy'ler kullanın.

Standart tarayıcı parmak izleriyle eşleşmek ve tespitten kaçınmak için scraper yazılımınızda HTTP2'yi etkinleştirin.

En verimli gerçek zamanlı fiyat akışı (streaming) için ağ sekmesindeki WebSocket bağlantılarını (wss://) inceleyin.

Cloudflare engellemesini belirten 403 Forbidden yanıtları için güçlü hata yönetimi mekanizmaları uygulayın.

Yalnızca doğrulanmış token adreslerinin statik listesine ihtiyacınız varsa https://token.jup.ag/all endpoint'ini hedefleyin.

Referanslar

Kullanicilarimiz Ne Diyor

Is akisini donusturen binlerce memnun kullaniciya katilin

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

İlgili Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Jupiter Hakkında Sık Sorulan Sorular

Jupiter hakkında sık sorulan soruların cevaplarını bulun