Як збирати дані з Open Collective: Посібник з отримання фінансових даних та даних контрибуторів

Дізнайтеся, як виконувати scraping Open Collective для отримання фінансових транзакцій, списків контрибуторів та даних про фінансування проектів. Отримуйте...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- WAF

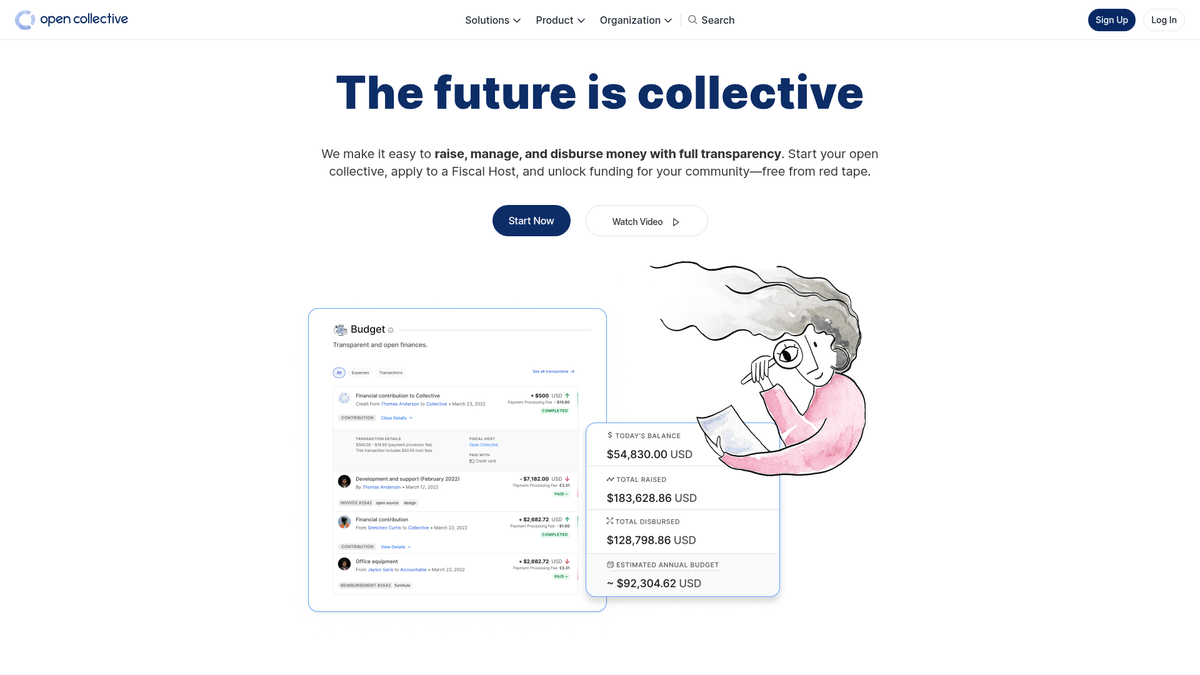

Про Open Collective

Дізнайтеся, що пропонує Open Collective та які цінні дані можна витягнути.

Про Open Collective

Open Collective — це унікальна фінансова та юридична платформа, розроблена для забезпечення прозорості спільнот, open-source проектів та територіальних громад. Працюючи як децентралізований інструмент фінансування, вона дозволяє «колективам» збирати кошти та керувати витратами без необхідності створення офіційної юридичної особи, часто використовуючи фіскальних хостів для адміністративної підтримки. Великі технічні проекти, такі як Babel та Webpack, покладаються на цю платформу для управління своїми екосистемами, що фінансуються спільнотою.

Платформа відома своєю радикальною прозорістю. Кожна транзакція, чи то пожертва від великої корпорації, чи то невелика витрата на зустріч спільноти, реєструється і є публічно видимою. Це надає величезну кількість даних щодо фінансового стану та звичок витрачання коштів деяких із найважливіших у світі open-source проектів.

Scraping Open Collective є надзвичайно цінним для організацій, які прагнуть провести дослідження ринку open-source економіки. Він дозволяє користувачам ідентифікувати потенційних корпоративних спонсорів, відстежувати тенденції фінансування розробників та проводити аудит фінансової стабільності критично важливих програмних проектів. Ці дані слугують прямим вікном у потоки капіталу в межах глобальної спільноти розробників.

Чому Варто Парсити Open Collective?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Open Collective.

Аналіз життєздатності критично важливих open-source залежностей

Пошук потенційних корпоративних спонсорів для B2B послуг

Моніторинг тенденцій децентралізованого фінансування у різних технологічних стеках

Проведення академічних досліджень однорангових (P2P) фінансових систем

Аудит витрат некомерційних організацій та громадських груп для забезпечення прозорості

Відстеження участі конкурентів у спонсорстві проектів спільнот

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Open Collective.

Управління складними GraphQL запитами для витягування глибоко вкладених даних

Робота з динамічною гідратацією Next.js та нескінченною пагінацією (infinite scroll)

Обхід захисту Cloudflare при високочастотних запитах

Дотримання суворих лімітів rate-limiting як для API, так і для веб-ендпоінтів

Скрапінг Open Collective за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Open Collective. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Open Collective, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Open Collective без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Open Collective. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Open Collective, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Витягуйте складні фінансові дані без написання GraphQL запитів

- Автоматично обробляйте рендеринг JavaScript та infinite scroll

- Налаштовуйте регулярні запуски для моніторингу змін у бюджеті проектів

- Обходьте антибот-системи завдяки розподіленому хмарному виконанню

No-code веб-парсери для Open Collective

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Open Collective без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Open Collective

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Open Collective без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

# Ендпоінт Open Collective GraphQL

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL запит для отримання базової інформації про колектив

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Надсилання POST запиту до API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Витягування та виведення назви та балансу

collective = data['data']['collective']

print(f"Назва: {collective['name']}")

print(f"Баланс: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Сталася помилка: {e}")Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Open Collective за допомогою коду

Python + Requests

import requests

# Ендпоінт Open Collective GraphQL

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL запит для отримання базової інформації про колектив

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Надсилання POST запиту до API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Витягування та виведення назви та балансу

collective = data['data']['collective']

print(f"Назва: {collective['name']}")

print(f"Баланс: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Сталася помилка: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Запуск браузера з підтримкою JS

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Очікування завантаження карток колективів

page.wait_for_selector('.CollectiveCard')

# Витягування даних з DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Знайдено проект: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective використовує Next.js; дані часто знаходяться всередині тегу script

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Очікування завантаження динамічного контенту

await page.waitForSelector('.CollectiveCard');

// Перебір елементів для витягування назв

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Що Можна Робити З Даними Open Collective

Досліджуйте практичні застосування та інсайти з даних Open Collective.

Прогнозування росту open-source проектів

Визначайте трендові технології, відстежуючи темпи фінансового зростання конкретних категорій колективів.

Як реалізувати:

- 1Витягніть щомісячний дохід для топових проектів у конкретних категоріях

- 2Розрахуйте сукупні річні темпи зростання (CAGR)

- 3Візуалізуйте фінансове здоров'я проектів для прогнозування впровадження технологій

Використовуйте Automatio для витягування даних з Open Collective та створення цих додатків без написання коду.

Що Можна Робити З Даними Open Collective

- Прогнозування росту open-source проектів

Визначайте трендові технології, відстежуючи темпи фінансового зростання конкретних категорій колективів.

- Витягніть щомісячний дохід для топових проектів у конкретних категоріях

- Розрахуйте сукупні річні темпи зростання (CAGR)

- Візуалізуйте фінансове здоров'я проектів для прогнозування впровадження технологій

- Lead generation для SaaS

Ідентифікуйте добре фінансовані проекти, яким можуть знадобитися інструменти для розробників, хостинг або професійні послуги.

- Фільтруйте колективи за бюджетом та загальною сумою зібраних коштів

- Витягуйте описи проектів та URL зовнішніх вебсайтів

- Перевіряйте стек технологій через пов'язані репозиторії GitHub

- Аудит корпоративної філантропії

Відстежуйте, куди великі корпорації витрачають свої бюджети на підтримку open-source.

- Збирайте списки контрибуторів для топових проектів

- Фільтруйте профілі організацій та індивідуальні профілі

- Агрегуйте суми внесків за корпоративними структурами

- Дослідження соціального впливу

Аналізуйте, як децентралізовані групи розподіляють свої кошти, щоб зрозуміти їхній соціальний вплив.

- Збирайте повну книгу транзакцій для конкретного колективу

- Класифікуйте витрати (поїздки, зарплати, обладнання)

- Генеруйте звіти про розподіл ресурсів у групах спільнот

- Пошук талантів серед розробників

Знаходьте активних лідерів у конкретних екосистемах на основі їхнього досвіду управління спільнотою та внесків.

- Збирайте списки учасників ключових технічних колективів

- Порівнюйте контрибуторів з їхніми публічними профілями в соціальних мережах

- Знаходьте активних мейнтейнерів для стратегічної комунікації

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Open Collective

Експертні поради для успішного витягування даних з Open Collective.

Надавайте пріоритет офіційному GraphQL API перед web scraping для отримання більш стабільних та структурованих результатів.

При виконанні scraping front-end частини використовуйте атрибути 'data-cy' у своїх selectors для кращої стабільності під час оновлень сайту.

Реалізуйте рандомізовану затримку від 2 до 5 секунд, щоб імітувати поведінку людини та уникнути спрацьовування механізмів rate-limiting.

Використовуйте ротаційні резидентські проксі, якщо вам потрібно виконувати великий обсяг пошукових запитів через сторінку /discover.

Перевіряйте файл robots.txt, щоб переконатися, що частота вашого scraping відповідає дозволеним параметрам crawl-delay сайту.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Часті запитання про Open Collective

Знайдіть відповіді на поширені запитання про Open Collective