Як скрапити Seeking Alpha: фінансові дані та транскрипти

Дізнайтеся, як скрапити Seeking Alpha для отримання новин про акції, рейтингів аналітиків та транскриптів прибутків. Навчіться обходити Cloudflare та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- DataDome

- Виявлення ботів у реальному часі з ML-моделями. Аналізує цифровий відбиток пристрою, мережеві сигнали та патерни поведінки. Поширений на сайтах електронної комерції.

- Google reCAPTCHA

- Система CAPTCHA від Google. v2 потребує взаємодії користувача, v3 працює приховано з оцінкою ризиків. Можна вирішити за допомогою сервісів CAPTCHA.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

Про Seeking Alpha

Дізнайтеся, що пропонує Seeking Alpha та які цінні дані можна витягнути.

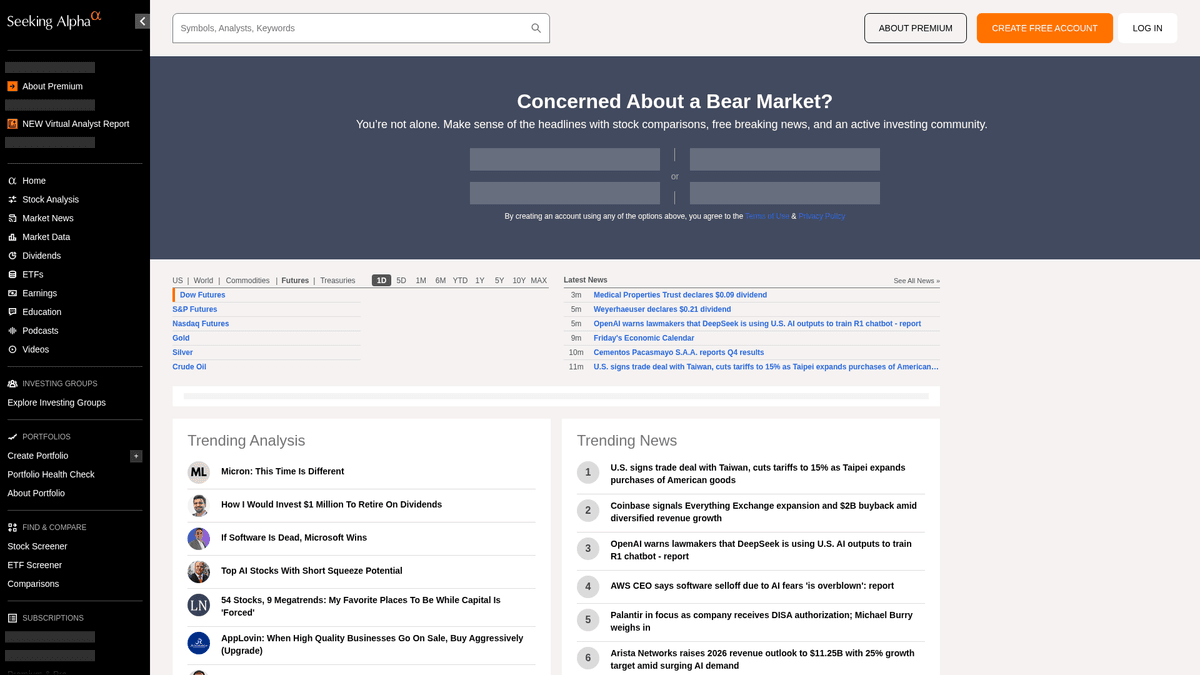

Головний хаб фінансової аналітики

Seeking Alpha — це провідна краудсорсингова платформа фінансових досліджень, яка слугує життєво важливим містком між сирими ринковими даними та дієвими інвестиційними ідеями. Вона містить величезну бібліотеку аналітичних статей, ринкові новини в реальному часі та найповніше в інтернеті сховище транскриптів дзвінків щодо прибутків для тисяч публічних компаній.

Різноманітна екосистема даних

Платформа пропонує безліч структурованих і неструктурованих даних, включаючи інвестиційні ідеї, історії дивідендів та власні рейтинги Quant, що допомагають випереджати ринок. Контент, керований професійною редакційною командою, створюється тисячами незалежних аналітиків, чиї матеріали проходять перевірку на відповідність високим стандартам якості та комплаєнсу перед публікацією.

Стратегічна цінність для витягування даних

Скрапінг Seeking Alpha є важливим для фінансових аналітиків та кількісних трейдерів, які проводять аналіз настроїв (sentiment analysis), відстежують історичні тренди прибутків та моніторять новини за конкретними тікерами. Дані дають детальне уявлення про ринкову психологію та корпоративну ефективність, що можна використовувати для побудови складних фінансових моделей та конкурентної розвідки.

Чому Варто Парсити Seeking Alpha?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Seeking Alpha.

Побудова кількісних рушіїв аналізу настроїв для алгоритмічної торгівлі

Агрегація транскриптів дзвінків про прибутки для фінансових досліджень на базі LLM

Моніторинг змін дивідендів та коефіцієнтів виплат для інвестиційних портфелів

Відстеження ефективності аналітиків та змін рейтингів у конкретних секторах

Розробка панелей новин ринку в реальному часі для інституційних клієнтів

Проведення історичного конкурентного аналізу прогнозів компанії проти реальних результатів

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Seeking Alpha.

Агресивне виявлення ботів за допомогою периметра безпеки Cloudflare та DataDome

Вимоги до авторизації для доступу до повних текстів транскриптів дзвінків про прибутки

Динамічне завантаження даних через AJAX/XHR, що потребує повного рендерингу браузера

Складне обмеження частоти запитів (rate limiting), що призводить до перманентних блокувань IP

Складні структури HTML із CSS-селекторами, що часто змінюються

Скрапінг Seeking Alpha за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Seeking Alpha. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Seeking Alpha, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Seeking Alpha без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Seeking Alpha. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Seeking Alpha, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- No-code середовище усуває необхідність керування складними бібліотеками автоматизації браузера

- Вбудована здатність обробляти сайти з великою кількістю JavaScript та динамічним контентом

- Хмарне виконання дозволяє планувати збір великих обсягів даних без локальних ресурсів

- Автоматична обробка стандартних шаблонів виявлення ботів та відбитків браузера (fingerprinting)

No-code веб-парсери для Seeking Alpha

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Seeking Alpha без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Seeking Alpha

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Seeking Alpha без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# URL для останніх новин ринку

url = 'https://seekingalpha.com/market-news'

# Стандартні заголовки браузера для імітації поведінки людини

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Витягування заголовків за допомогою атрибутів data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Заголовок новини: {item.text.strip()}')

else:

print(f'Заблоковано зі статусом: {response.status_code}')

except Exception as e:

print(f'Сталася помилка: {e}')

if __name__ == "__main__":

scrape_sa_news()Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Seeking Alpha за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL для останніх новин ринку

url = 'https://seekingalpha.com/market-news'

# Стандартні заголовки браузера для імітації поведінки людини

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Витягування заголовків за допомогою атрибутів data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Заголовок новини: {item.text.strip()}')

else:

print(f'Заблоковано зі статусом: {response.status_code}')

except Exception as e:

print(f'Сталася помилка: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Запуск браузера Chromium

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Перехід на сторінку транскриптів конкретного символу акції

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Очікування динамічного рендерингу основного контенту

page.wait_for_selector('article', timeout=15000)

# Пошук та витягування заголовків транскриптів

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Знайдено транскрипт: {title}')

except Exception as e:

print(f'Помилка витягування: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Обробка простої пагінації через посилання 'next'

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Встановлення якісного User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Перехід на головну сторінку Seeking Alpha

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Виконання скриптів у контексті браузера для витягування заголовків

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Трендовий контент:', trending);

} catch (err) {

console.error('Puppeteer виявив помилку:', err);

} finally {

await browser.close();

}

})();Що Можна Робити З Даними Seeking Alpha

Досліджуйте практичні застосування та інсайти з даних Seeking Alpha.

Кількісний аналіз настроїв

Фінансові компанії використовують статті аналітиків для визначення ринкових настроїв у конкретних секторах акцій.

Як реалізувати:

- 1Витягуйте всі аналітичні статті для конкретного галузевого тікера.

- 2Обробіть контент через NLP-рушій для розрахунку полярності настроїв.

- 3Інтегруйте оцінки настроїв в існуючі торгові алгоритми.

- 4Налаштуйте автоматичні сповіщення про купівлю/продаж на основі змін настроїв.

Використовуйте Automatio для витягування даних з Seeking Alpha та створення цих додатків без написання коду.

Що Можна Робити З Даними Seeking Alpha

- Кількісний аналіз настроїв

Фінансові компанії використовують статті аналітиків для визначення ринкових настроїв у конкретних секторах акцій.

- Витягуйте всі аналітичні статті для конкретного галузевого тікера.

- Обробіть контент через NLP-рушій для розрахунку полярності настроїв.

- Інтегруйте оцінки настроїв в існуючі торгові алгоритми.

- Налаштуйте автоматичні сповіщення про купівлю/продаж на основі змін настроїв.

- Витягування інсайтів із транскриптів

Отримуйте критично важливі корпоративні прогнози безпосередньо з транскриптів дзвінків для швидкої звітності.

- Автоматизуйте щоденний скрапінг розділу транскриптів прибутків.

- Шукайте конкретні фінансові ключові слова, такі як 'EBITDA' або 'Outlook'.

- Виділяйте речення, що містять прогнозні показники менеджменту.

- Експортуйте результати у структурований CSV для розгляду інвестиційним комітетом.

- Бенчмаркінг дивідендної дохідності

Порівнюйте показники дивідендів серед тисяч акцій, щоб знайти вигідні можливості для доходу.

- Скрапте історію дивідендів та коефіцієнти виплат для визначеного списку акцій.

- Розрахуйте середню дохідність порівняно з історичними трендами за допомогою зібраних даних.

- Визначте акції, які нещодавно збільшили виплати.

- Оновлюйте приватну панель моніторингу порівняннями дохідності в реальному часі.

- Відстеження ефективності аналітиків

Визначайте найбільш точних авторів, за якими варто стежити для отримання кращих інвестиційних ідей.

- Скрапте історичні рейтинги та статті авторів з найвищим рейтингом.

- Порівнюйте дати публікації статей із динамікою цін на акції.

- Ранжуйте авторів на основі точності їхніх рекомендацій «Купувати» або «Продавати».

- Надсилайте автоматичні повідомлення, коли автори з високим рейтингом публікують нові ідеї.

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Seeking Alpha

Експертні поради для успішного витягування даних з Seeking Alpha.

Використовуйте преміум-резидентські проксі, щоб ефективно обходити захист Cloudflare/DataDome.

Змінюйте (ротуйте) рядки User-Agent та підтримуйте стабільні відбитки браузера (fingerprints) протягом сесії.

Впроваджуйте рандомізовані затримки від 10 до 30 секунд для імітації поведінки реального користувача.

Виконуйте скрапінг під час закриття ринку або у вихідні, щоб зменшити ймовірність обмеження частоти запитів через високий трафік.

Дослідіть вкладку «Network» у DevTools на наявність внутрішніх JSON API ендпоінтів (v3/api) для отримання чистіших даних.

Зберігайте постійні сесійні cookies, якщо вам потрібно скрапити дані, доступні лише після входу в систему.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Часті запитання про Seeking Alpha

Знайдіть відповіді на поширені запитання про Seeking Alpha