Seeking Alpha scrapen: Finanzdaten & Transcripts extrahieren

Erfahren Sie, wie Sie Seeking Alpha für Börsennachrichten, Analysten-Ratings und Earnings-Transkripte scrapen. Lernen Sie, Cloudflare zu umgehen und wertvolle...

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- DataDome

- Echtzeit-Bot-Erkennung mit ML-Modellen. Analysiert Geräte-Fingerabdruck, Netzwerksignale und Verhaltensmuster. Häufig auf E-Commerce-Seiten.

- Google reCAPTCHA

- Googles CAPTCHA-System. v2 erfordert Benutzerinteraktion, v3 läuft unsichtbar mit Risikobewertung. Kann mit CAPTCHA-Diensten gelöst werden.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- IP-Blockierung

- Blockiert bekannte Rechenzentrums-IPs und markierte Adressen. Erfordert Residential- oder Mobile-Proxys zur effektiven Umgehung.

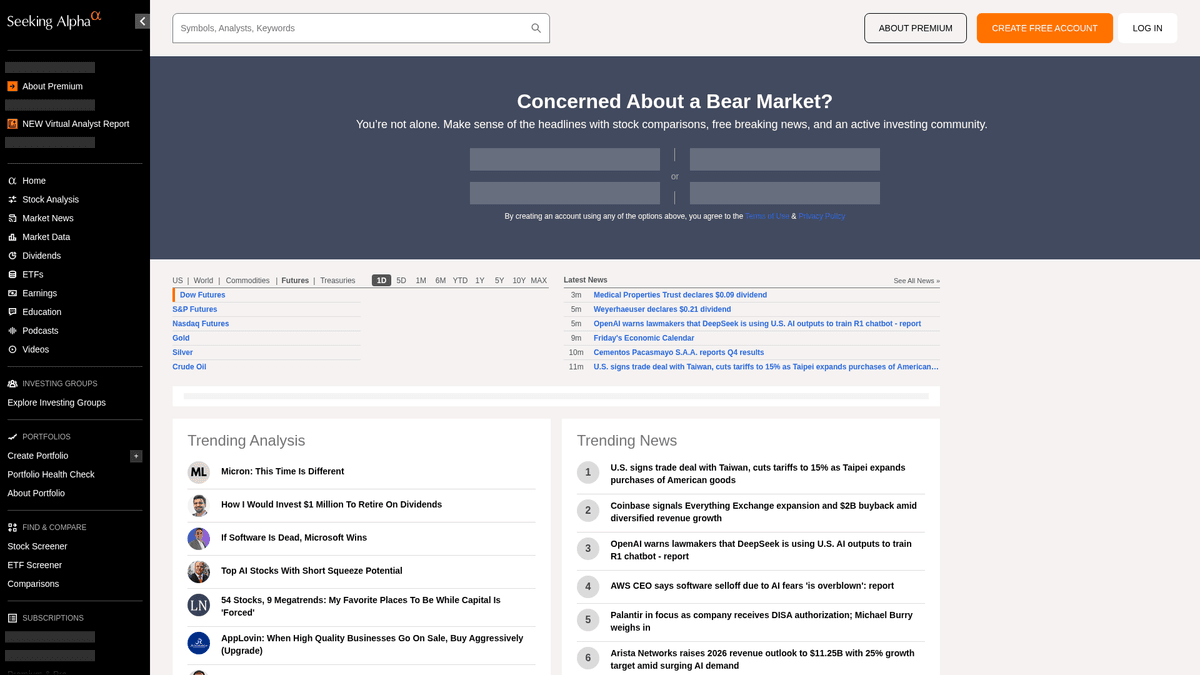

Über Seeking Alpha

Entdecken Sie, was Seeking Alpha bietet und welche wertvollen Daten extrahiert werden können.

Das führende Zentrum für Financial Intelligence

Seeking Alpha ist eine führende Crowdsourcing-Plattform für Finanzanalysen, die als wichtige Brücke zwischen rohen Marktdaten und umsetzbaren Investment-Insights dient. Sie beherbergt eine umfangreiche Bibliothek mit Analyseartikeln, Echtzeit-Marktnachrichten und das umfassendste Verzeichnis im Internet für Earnings Call Transcripts von Tausenden börsennotierten Unternehmen.

Vielfältiges Daten-Ökosystem

Die Plattform bietet eine Fülle von strukturierten und unstrukturierten Daten, einschließlich Stock-Ideen, Dividendenhistorien und den proprietären, marktschlagenden Quant-Ratings. Die Inhalte werden von einem professionellen Redaktionsteam verwaltet und von Tausenden unabhängigen Analysten erstellt, deren Beiträge vor der Veröffentlichung hohe Qualitäts- und Compliance-Standards erfüllen müssen.

Strategischer Wert für die Datenextraktion

Das Scraping von Seeking Alpha ist unerlässlich für Finanzanalysten und quantitative Trader, die Sentiment-Analysen durchführen, historische Ertragstrends verfolgen und Nachrichten zu bestimmten Tickern überwachen. Die Daten liefern detaillierte Einblicke in die Marktpsychologie und die Unternehmensleistung, die genutzt werden können, um anspruchsvolle Finanz-Models zu erstellen und Competitive Intelligence zu betreiben.

Warum Seeking Alpha Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von Seeking Alpha.

Sentiment-Analyse

Extrahieren Sie Crowdsourcing-Artikel und Kommentare, um mittels Natural Language Processing das Markt-Sentiment für spezifische Aktien-Ticker zu messen.

Earnings Intelligence

Sammeln Sie Transkripte von Earnings-Calls, um wichtige Trends in der Unternehmensführung, Finanzausblicke und das Sentiment von Führungskräften über verschiedene Branchen hinweg zu identifizieren.

Proprietäre Quant-Ratings

Überwachen Sie die einzigartigen Quant-Ratings und Analysten-Conviction-Scores von Seeking Alpha, um automatisierte Handelssignale oder Portfolio-Management-Tools zu füttern.

Wettbewerbsanalyse

Verfolgen Sie, was top-bewertete Analysten über Wettbewerber in Ihrem Sektor sagen, um Branchenverschiebungen und Markterwartungen immer einen Schritt voraus zu sein.

Historische Datenarchivierung

Bauen Sie ein privates Repository für Analystenempfehlungen und Aktienkursreaktionen auf, um die langfristige Genauigkeit spezifischer Investment-Autoren zu bewerten.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von Seeking Alpha.

Fortschrittliche Bot-Erkennung

Seeking Alpha nutzt hochentwickelte Sicherheitslösungen wie Cloudflare und PerimeterX, die auf automatisierte Browser-Fingerprints und Verhaltensmuster prüfen.

Paywalls für Premium-Inhalte

Viele wertvolle Datensätze, einschließlich detaillierter Quant-Metriken und historischer Transkripte, befinden sich hinter einer Paywall, die ein sicheres Session-Management erfordert.

Dynamisches Content-Rendering

Die Plattform nutzt ein modernes React-Framework, was bedeutet, dass Daten oft asynchron über XHR-Anfragen geladen werden, anstatt direkt im ursprünglichen HTML-Quellcode zu stehen.

Striktes Rate Limiting

Aggressive Anfragefrequenzen führen schnell zu 403 Forbidden-Fehlern und temporären IP-Sperren, wenn das Scraping-Verhalten nicht einem menschlichen Nutzer entspricht.

Scrape Seeking Alpha mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von Seeking Alpha extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert Seeking Alpha, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, Seeking Alpha zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von Seeking Alpha extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert Seeking Alpha, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Stealth-Fingerprint-Maskierung: Automatio rotiert automatisch Browser-Fingerprints und Header, um Erkennungssysteme wie Cloudflare ohne manuelle Konfiguration zu umgehen.

- Unterstützung für dynamisches Rendering: Die Headless-Browser-Architektur des Tools stellt sicher, dass alle React-basierten Komponenten und Finanz-Charts vollständig gerendert werden, bevor die Datenextraktion beginnt.

- No-Code-Session-Management: Verwalten Sie Logins und persistente Cookies ganz einfach, um auf Premium-Transkripte und Analysten-Ratings zuzugreifen, ohne komplexe Authentifizierungs-Skripte schreiben zu müssen.

- Visuelle Datenauswahl: Wählen Sie komplexe Finanztabellen visuell aus. Dies gewährleistet eine stabile Extraktion, selbst wenn sich die zugrunde liegenden CSS-Klassen oder das Seitenlayout ändern.

No-Code Web Scraper für Seeking Alpha

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Seeking Alpha helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für Seeking Alpha

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Seeking Alpha helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# URL for the latest market news

url = 'https://seekingalpha.com/market-news'

# Standard browser headers to mimic human behavior

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extract headlines using data-test-id attributes

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'News Title: {item.text.strip()}')

else:

print(f'Blocked with status: {response.status_code}')

except Exception as e:

print(f'Error occurred: {e}')

if __name__ == "__main__":

scrape_sa_news()Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man Seeking Alpha mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL for the latest market news

url = 'https://seekingalpha.com/market-news'

# Standard browser headers to mimic human behavior

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extract headlines using data-test-id attributes

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'News Title: {item.text.strip()}')

else:

print(f'Blocked with status: {response.status_code}')

except Exception as e:

print(f'Error occurred: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Launching a Chromium browser

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navigating to a specific stock symbol page

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Wait for the main content to render dynamically

page.wait_for_selector('article', timeout=15000)

# Locate and extract transcript titles

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Found Transcript: {title}')

except Exception as e:

print(f'Extraction failed: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Handle simple pagination via 'next' links

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set high-quality User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navigate to Seeking Alpha homepage

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Evaluate scripts in the browser context to extract titles

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Trending Content:', trending);

} catch (err) {

console.error('Puppeteer encountered an error:', err);

} finally {

await browser.close();

}

})();Was Sie mit Seeking Alpha-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus Seeking Alpha-Daten.

Quantitative Sentiment-Analyse

Finanzunternehmen nutzen Analystenartikel, um das Marktsentiment für spezifische Aktienektoren zu bestimmen.

So implementieren Sie es:

- 1Extrahiere alle Analyseartikel für einen bestimmten Branchen-Ticker.

- 2Verarbeite den Content durch eine NLP-Engine, um die Sentiment-Polarität zu berechnen.

- 3Integriere Sentiment-Scores in bestehende Trading-Algorithmen.

- 4Löse automatisierte Kauf-/Verkaufs-Alerts basierend auf Sentiment-Verschiebungen aus.

Verwenden Sie Automatio, um Daten von Seeking Alpha zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit Seeking Alpha-Daten machen können

- Quantitative Sentiment-Analyse

Finanzunternehmen nutzen Analystenartikel, um das Marktsentiment für spezifische Aktienektoren zu bestimmen.

- Extrahiere alle Analyseartikel für einen bestimmten Branchen-Ticker.

- Verarbeite den Content durch eine NLP-Engine, um die Sentiment-Polarität zu berechnen.

- Integriere Sentiment-Scores in bestehende Trading-Algorithmen.

- Löse automatisierte Kauf-/Verkaufs-Alerts basierend auf Sentiment-Verschiebungen aus.

- Extraktion von Earnings-Insights

Extrahiere kritische Unternehmens-Guidance direkt aus Earnings Transcripts für ein schnelles Reporting.

- Automatisiere ein tägliches Scraping des Bereichs Earnings Transcripts.

- Suche nach spezifischen Finanz-Keywords wie 'EBITDA' oder 'Ausblick'.

- Isoliere die Sätze, die Management-Guidance-Metriken enthalten.

- Exportiere die Ergebnisse in eine strukturierte CSV für die Überprüfung durch das Investmentkomitee.

- Dividend Yield Benchmark-Analyse

Vergleiche die Dividendenperformance über Tausende von Aktien hinweg, um Renditechancen zu finden.

- Scrape die Dividendenhistorie und Ausschüttungsquoten für eine definierte Aktienliste.

- Berechne die durchschnittliche Rendite im Vergleich zu historischen Trends mithilfe der gescrapten Daten.

- Identifiziere Aktien, die ihre Ausschüttung vor Kurzem erhöht haben.

- Aktualisiere ein privates Dashboard mit Echtzeit-Renditevergleichen.

- Tracking der Analysten-Performance

Identifiziere Autoren mit hoher Genauigkeit, um bessere Investmentideen zu erhalten.

- Scrape historische Ratings und Artikel von Top-Autoren.

- Gleiche Artikel-Veröffentlichungsdaten mit der Kursentwicklung der Aktie ab.

- Ranke Autoren basierend auf der Genauigkeit ihrer 'Kauf'- oder 'Verkauf'-Empfehlungen.

- Sende automatisierte Benachrichtigungen, wenn hochgerankte Autoren neue Ideen posten.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von Seeking Alpha

Expertentipps für die erfolgreiche Datenextraktion von Seeking Alpha.

Residential Proxies bevorzugen

Seeking Alpha setzt die meisten Datacenter-IPs auf eine Blacklist. Durch die Verwendung von residential proxies erscheint Ihr Traffic wie der von legitimen privaten Internetnutzern.

Interne API-Endpunkte anvisieren

Untersuchen Sie den Netzwerkverkehr, um JSON-basierte interne API-Aufrufe (v3/api) zu finden. Diese sind oft einfacher zu parsen als rohe HTML-Strukturen.

Menschliche Verzögerungen implementieren

Randomisieren Sie das Timing Ihrer Interaktionen und halten Sie das Anfragevolumen niedrig, um Verhaltenserkennungssysteme zu vermeiden, die nach robotischen Mustern suchen.

Data-Attribute für Selektoren verwenden

Nutzen Sie 'data-test-id'-Attribute in Ihren Selektoren, da sich diese bei Website-Updates seltener ändern als dynamische React-CSS-Klassen.

Scraping in Nebenzeiten durchführen

Führen Sie umfangreiche Datenerfassungen nach Börsenschluss oder am Wochenende durch, um das Risiko zu verringern, in Hochfrequenz-Limits zu laufen.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Häufig gestellte Fragen zu Seeking Alpha

Finden Sie Antworten auf häufige Fragen zu Seeking Alpha