Qwen3.5-397B-A17B

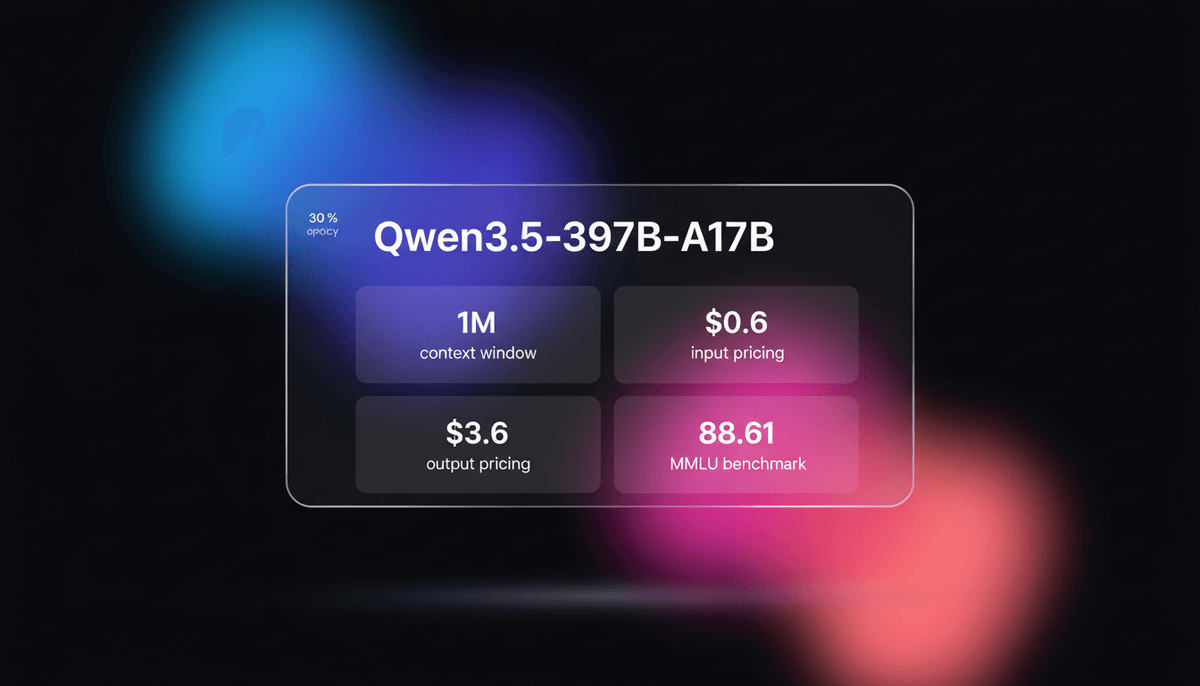

Qwen3.5-397B-A17B ist Alibabas flagship Open-Weight MoE model. Es bietet natives multimodal reasoning, ein 1M context window und einen 19-fachen decoding...

Über Qwen3.5-397B-A17B

Erfahren Sie mehr über die Fähigkeiten, Funktionen und Einsatzmöglichkeiten von Qwen3.5-397B-A17B.

Ein monumentaler Sprung für Open AI

Qwen3.5-397B-A17B stellt einen monumentalen Sprung in der KI-Strategie von Alibaba Cloud dar und markiert den Übergang von einem starken Open-Source-Herausforderer zu einem dominanten System auf frontier model-Niveau, das für die Ära der agentic AI konzipiert wurde. Veröffentlicht am 16. Februar 2026, ist es das flagship der Qwen3.5-Serie und nutzt eine gewaltige Mixture-of-Experts (MoE)-Architektur mit 397 Milliarden parameters. Durch die Aktivierung von nur 17 Milliarden parameters pro token erreicht es einen beispiellosen 19-fachen decoding throughput-Boost im Vergleich zu seinem Vorgänger Qwen3-Max, während es die Performance-Lücke zu den weltweit fortschrittlichsten proprietären Modellen schließt.

Einheitliches Multimodal-Powerhouse

Das model ist ein einheitliches, natives multimodal-Kraftpaket. Im Gegensatz zu früheren Versionen, die separate Vision-Language-Adapter erforderten, bietet Qwen3.5 Early-Fusion-Multimodality, die auf Billionen von multimodal tokens trainiert wurde. Dies ermöglicht es ihm, über zwei Stunden Videoinhalt zu sichten und reasoning anzuwenden, als GUI-agent auf Desktop- und Mobil-Oberflächen zu agieren und komplexe Coding-Aufgaben in seinem spezialisierten Thinking mode zu bewältigen. Mit einem erweiterten Vokabular von 250.000 tokens, das 201 Sprachen unterstützt, ist es die erste Wahl weltweit für multilinguale und multimodal Automatisierung.

Architektonisch bereit für die Agentic-Ära

Über einfaches Chatten hinaus ist Qwen3.5-397B für Tool-Nutzung und autonome Workflows optimiert. Seine hohen Werte in function-calling benchmarks und beim Instruction-Following machen es zum idealen Backbone für Visual Software Engineering und Forschung auf PhD-Niveau. Durch das Angebot von state-of-the-art Performance unter einer Apache 2.0-Lizenz hat Alibaba der Community eine glaubwürdige, hocheffiziente Alternative zu den am stärksten eingeschränkten closed-source-Modellen zur Verfügung gestellt.

Anwendungsfälle für Qwen3.5-397B-A17B

Entdecken Sie die verschiedenen Möglichkeiten, Qwen3.5-397B-A17B für großartige Ergebnisse zu nutzen.

Autonome GUI-Agents

Navigiert durch komplexe PC- und Smartphone-Oberflächen, um mehrstufige Workflows zur Büroautomatisierung abzuschließen.

Long-Form Video Intelligence

Extrahiert tiefgehendes kausales reasoning und Zusammenfassungen aus kontinuierlichen Videodateien von bis zu 120 Minuten Länge.

Vibe Coding & Prototyping

Übersetzt UI-Skizzen direkt in produktionsreifen React- und Frontend-Code in einem einzigen Durchgang.

Forschung auf PhD-Niveau

Löst STEM-Probleme auf Expertenniveau unter Nutzung des spezialisierten internen chain-of-thought Thinking-Modus.

Globaler multilingualer Support

Interagiert mit Nutzern in 201 Sprachen mit überlegener tokenization-Effizienz für nicht-englische Schriften.

Visual Software Engineering

Transformiert Wireframes und Screenshots in sauberen, layout-bewussten HTML-, CSS- und JavaScript-Code.

Stärken

Einschränkungen

API-Schnellstart

alibaba/qwen-3.5-plus

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.DASHSCOPE_API_KEY,

baseURL: 'https://dashscope-intl.aliyuncs.com/compatible-mode/v1',

});

async function main() {

const completion = await client.chat.completions.create({

model: 'qwen-3.5-397b-instruct',

messages: [{ role: 'user', content: 'Analyze this 2-hour video context.' }],

extra_body: { enable_thinking: true },

});

console.log(completion.choices[0].message.content);

}

main();Installieren Sie das SDK und beginnen Sie in wenigen Minuten mit API-Aufrufen.

Was die Leute über Qwen3.5-397B-A17B sagen

Sehen Sie, was die Community über Qwen3.5-397B-A17B denkt

“Qwen3.5-397B ist im Grunde die Antwort der Open-Source-Community auf GPT-4o. Allein die SVG-Fähigkeit ist der Wahnsinn für Webdesign.”

“Durch den 19-fachen throughput-Boost fühlt sich Qwen3.5 deutlich reaktionsschneller an als jedes andere model dieser Größe, das ich getestet habe.”

“Apache 2.0 für ein so großes model ist ein absoluter Gamechanger für lokale KI-Entwicklung und datenschutzorientierte Unternehmen.”

“Das MoE-Routing im 3.5-397B model ist spürbar intelligenter als in der vorherigen 2.5-Generation; es folgt tatsächlich der Logik.”

“Das 1M context window bei einem Open-Weight model dieses Kalibers ist im aktuellen Ökosystem beispiellos.”

“Das Video reasoning erfolgt nicht nur Frame für Frame; es ist ein tatsächliches zeitliches Verständnis, das den aktuellen Vision-LLMs um Meilen voraus zu sein scheint.”

Videos über Qwen3.5-397B-A17B

Schauen Sie Tutorials, Rezensionen und Diskussionen über Qwen3.5-397B-A17B

“Es schlägt Claude Opus 4.5 bei Browser-Aufgaben sowie Gemini 3 Pro in mehreren multimodal Aufgaben.”

“Berichten zufolge 19-mal schneller als das Qwen 3 Max, welches 201 Sprachen und Dialekte unterstützt.”

“Es hat einen ziemlich guten Job bei dem fotorealistischen Schmetterling gemacht... besser als die meisten open-source-Modelle.”

“Das 397B model ist im Wesentlichen das erste Open-Weights-Model, das wirklich an der Grenze zur AGI konkurriert.”

“Das Skalieren mit MoE funktioniert für Alibaba offensichtlich, und ihre neuesten benchmark-Ergebnisse beweisen das.”

“Dieses model erreicht das Niveau von Qwen Max... kann dies aber mit einem bis zu 19-fachen Speed-Boost.”

“Der Tokenizer hat nun ein Vokabular von 250K erreicht... und zieht mit Gemini und dem Google-Tokenizer gleich.”

“Man muss das Qwen-Team als Frontier Lab betrachten... sie widmen sich Aufgaben, auf die sich sonst nur proprietäre Labs konzentrieren.”

“Die tokenization ist für nicht-lateinische Schriften viel effizienter im Vergleich zu früheren Llama-Iterationen.”

“Der Thinking mode sorgt für erhebliche latency, aber der Gewinn an Genauigkeit lohnt sich für Coding und reasoning.”

“Dies ist ein vereinheitlichtes Vision-Language-Model... während frühere Modelle eine spezifische VL-Variante hatten, ist hier alles in einem einzigen model enthalten.”

“Video-Verständnis ermöglicht es ihm, zeitliche Details zu erfassen, die Frame-Extraktions-Methoden übersehen.”

“Beim Coding fühlt es sich so reaktionsschnell an wie das GPT-4o model, aber mit besserem Instruction-Following.”

“Die Desktop-GUI-agent-Fähigkeit ist hier das herausragende Feature für die Automatisierung in der realen Welt.”

“Es verarbeitet 120 Minuten Video, ohne den Kontext zu verlieren, was für Analysen einfach gewaltig ist.”

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Pro-Tipps für Qwen3.5-397B-A17B

Expertentipps, um das Beste aus Qwen3.5-397B-A17B herauszuholen.

Thinking Mode umschalten

Verwenden Sie den enable_thinking parameter für logikintensive Aufgaben, um tiefe interne reasoning-Pfade zu aktivieren.

Native Suche nutzen

Aktivieren Sie den search-body-parameter, um Fakten mit Echtzeit-Webdaten abzugleichen und Python-Code auszuführen.

Video-Prompts optimieren

Geben Sie spezifische Zeitstempel-Anker an, um das 1M token context window auf die relevantesten Segmente zu fokussieren.

Regionale Endpoint-Auswahl

Verwenden Sie den dashscope-intl Endpoint für Nutzer außerhalb von Festlandchina, um die Netzwerk-latency zu verringern.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte AI Models

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Gemini 3 Flash

Gemini 3 Flash is Google's high-speed multimodal model featuring a 1M token context window, elite 90.4% GPQA reasoning, and autonomous browser automation tools.

Claude Opus 4.6

Anthropic

Claude Opus 4.6 is Anthropic's flagship model featuring a 1M token context window, Adaptive Thinking, and world-class coding and reasoning performance.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Häufig gestellte Fragen zu Qwen3.5-397B-A17B

Finden Sie Antworten auf häufige Fragen zu Qwen3.5-397B-A17B