Cómo extraer datos de Animal Corner | Scraper de datos de fauna y naturaleza

Extrae datos de animales, nombres científicos e información de hábitats de Animal Corner. Aprende a crear una base de datos estructurada de vida silvestre para...

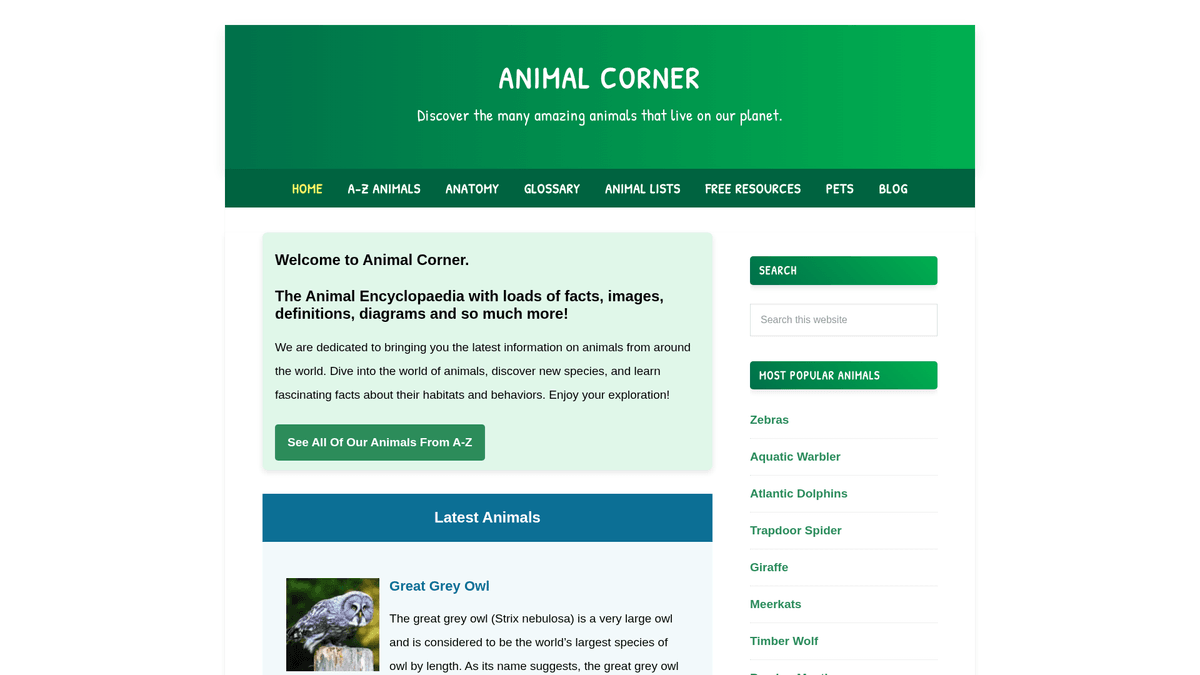

Acerca de Animal Corner

Descubre qué ofrece Animal Corner y qué datos valiosos se pueden extraer.

Animal Corner es una enciclopedia en línea completa dedicada a proporcionar una gran cantidad de información sobre el reino animal. Sirve como un recurso educativo estructurado para estudiantes, profesores y entusiastas de la naturaleza, ofreciendo perfiles detallados sobre una vasta gama de especies, que van desde mascotas comunes hasta fauna en peligro de extinción. La plataforma organiza su contenido en categorías lógicas como mamíferos, aves, reptiles, peces, anfibios e invertebrados.

Cada entrada en el sitio contiene datos biológicos vitales, incluyendo nombres comunes y científicos, características físicas, hábitos alimenticios y distribución geográfica. Para desarrolladores e investigadores, estos datos son increíblemente valiosos para crear datasets estructurados que pueden alimentar aplicaciones educativas, entrenar un model de machine learning para la identificación de especies o apoyar estudios ecológicos a gran escala. Debido a que el sitio se protege con actualizaciones frecuentes sobre nuevas especies y estados de conservación, sigue siendo una fuente primaria para los entusiastas de la biodiversidad.

¿Por Qué Scrapear Animal Corner?

Descubre el valor comercial y los casos de uso para extraer datos de Animal Corner.

Construcción de bases de datos de biodiversidad

Crea una base de datos exhaustiva y consultable de la fauna global para investigación académica, proyectos de conservación o archivos educativos.

Conjuntos de entrenamiento para ML

Utiliza miles de imágenes de animales categorizadas y descripciones biológicas detalladas para entrenar modelos de computer vision y natural language processing.

Generación de contenido educativo

Extrae automáticamente datos sobre animales y sus hábitats para alimentar aplicaciones móviles educativas, juegos de trivia o libros de texto digitales de biología.

Mapeo ecológico

Analiza los datos de distribución geográfica de los perfiles de especies para mapear tendencias de biodiversidad e identificar solapamientos de hábitats en diferentes continentes.

Inteligencia para el cuidado de mascotas

Recopila datos biológicos y de comportamiento detallados sobre razas específicas de aves y pequeños mamíferos para informar el desarrollo de productos en la industria de suministros para mascotas.

Seguimiento del estado de conservación

Monitorea y agrega el estado de conservación de varias especies para construir un panel de control de riesgos en tiempo real para la defensa del medio ambiente.

Desafíos de Scraping

Desafíos técnicos que puedes encontrar al scrapear Animal Corner.

Datos de prosa no estructurados

La mayoría de los datos científicos están incrustados en párrafos largos en lugar de tablas, lo que requiere regex avanzado o NLP para extraer atributos específicos como la dieta o la esperanza de vida.

Estructura de página variable

Los perfiles de especies no son uniformes; algunas entradas contienen tablas taxonómicas detalladas, mientras que otras solo ofrecen información a través de texto descriptivo.

Umbrales de límite de frecuencia

El scraping de alta frecuencia en miles de páginas de perfil puede activar bloqueos temporales de IP en el backend basado en WordPress del sitio.

Lógica de resolución de miniaturas

Las URL de las imágenes a menudo apuntan a miniaturas redimensionadas por WordPress (ej. -150x150), lo que requiere manipulación de strings para recuperar los archivos originales en alta resolución.

Scrapea Animal Corner con IA

Sin código necesario. Extrae datos en minutos con automatización impulsada por IA.

Cómo Funciona

Describe lo que necesitas

Dile a la IA qué datos quieres extraer de Animal Corner. Solo escríbelo en lenguaje natural — sin código ni selectores.

La IA extrae los datos

Nuestra inteligencia artificial navega Animal Corner, maneja contenido dinámico y extrae exactamente lo que pediste.

Obtén tus datos

Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Por Qué Usar IA para el Scraping

La IA facilita el scraping de Animal Corner sin escribir código. Nuestra plataforma impulsada por inteligencia artificial entiende qué datos quieres — solo descríbelo en lenguaje natural y la IA los extrae automáticamente.

How to scrape with AI:

- Describe lo que necesitas: Dile a la IA qué datos quieres extraer de Animal Corner. Solo escríbelo en lenguaje natural — sin código ni selectores.

- La IA extrae los datos: Nuestra inteligencia artificial navega Animal Corner, maneja contenido dinámico y extrae exactamente lo que pediste.

- Obtén tus datos: Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Why use AI for scraping:

- Selección visual de datos: Utiliza la interfaz de apuntar y hacer clic de Automatio para capturar datos de animales ocultos en párrafos sin necesidad de escribir selectores CSS complejos o código.

- Rastreo automatizado de directorios: Configura fácilmente un seguidor de enlaces para navegar por el directorio de animales de la A a la Z y extraer automáticamente cada perfil de especie individual en secuencia.

- Rotación de proxies de alta calidad: Supera los límites de frecuencia y evita bloqueos de IP utilizando proxies residenciales integrados que gestionan la extracción de grandes volúmenes de datos de vida silvestre sin interrupciones.

- Exportación directa a Google Sheets: Sincroniza automáticamente los datos de animales extraídos en Google Sheets para una categorización, filtrado e investigación colaborativa instantánea.

Scrapers Sin Código para Animal Corner

Alternativas de apuntar y clic al scraping con IA

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear Animal Corner. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

Desafíos Comunes

Curva de aprendizaje

Comprender selectores y lógica de extracción lleva tiempo

Los selectores se rompen

Los cambios en el sitio web pueden romper todo el flujo de trabajo

Problemas con contenido dinámico

Los sitios con mucho JavaScript requieren soluciones complejas

Limitaciones de CAPTCHA

La mayoría de herramientas requieren intervención manual para CAPTCHAs

Bloqueo de IP

El scraping agresivo puede resultar en el bloqueo de tu IP

Scrapers Sin Código para Animal Corner

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear Animal Corner. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

- Instalar extensión del navegador o registrarse en la plataforma

- Navegar al sitio web objetivo y abrir la herramienta

- Seleccionar con point-and-click los elementos de datos a extraer

- Configurar selectores CSS para cada campo de datos

- Configurar reglas de paginación para scrapear múltiples páginas

- Resolver CAPTCHAs (frecuentemente requiere intervención manual)

- Configurar programación para ejecuciones automáticas

- Exportar datos a CSV, JSON o conectar vía API

Desafíos Comunes

- Curva de aprendizaje: Comprender selectores y lógica de extracción lleva tiempo

- Los selectores se rompen: Los cambios en el sitio web pueden romper todo el flujo de trabajo

- Problemas con contenido dinámico: Los sitios con mucho JavaScript requieren soluciones complejas

- Limitaciones de CAPTCHA: La mayoría de herramientas requieren intervención manual para CAPTCHAs

- Bloqueo de IP: El scraping agresivo puede resultar en el bloqueo de tu IP

Ejemplos de Código

import requests

from bs4 import BeautifulSoup

# URL de destino para un animal específico

url = 'https://animalcorner.org/animals/african-elephant/'

# Encabezados estándar para imitar un navegador real

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extraer el nombre del animal

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extraer el primer párrafo que suele contener el nombre científico

intro = soup.find('p').text.strip()

print(f'Datos introductorios: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error al extraer datos de Animal Corner: {e}')Cuándo Usar

Mejor para páginas HTML estáticas donde el contenido se carga del lado del servidor. El enfoque más rápido y simple cuando no se requiere renderizado de JavaScript.

Ventajas

- ●Ejecución más rápida (sin sobrecarga del navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar con asyncio

- ●Excelente para APIs y páginas estáticas

Limitaciones

- ●No puede ejecutar JavaScript

- ●Falla en SPAs y contenido dinámico

- ●Puede tener dificultades con sistemas anti-bot complejos

Cómo Scrapear Animal Corner con Código

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL de destino para un animal específico

url = 'https://animalcorner.org/animals/african-elephant/'

# Encabezados estándar para imitar un navegador real

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extraer el nombre del animal

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extraer el primer párrafo que suele contener el nombre científico

intro = soup.find('p').text.strip()

print(f'Datos introductorios: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error al extraer datos de Animal Corner: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_animal_corner():

with sync_playwright() as p:

# Lanzar el navegador en modo headless

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://animalcorner.org/animals/african-elephant/')

# Esperar a que cargue el encabezado principal

title = page.inner_text('h1')

print(f'Nombre del animal: {title}')

# Extraer párrafos de datos específicos

facts = page.query_selector_all('p')

for fact in facts[:3]:

print(f'Dato: {fact.inner_text()}')

browser.close()

if __name__ == "__main__":

scrape_animal_corner()Python + Scrapy

import scrapy

class AnimalSpider(scrapy.Spider):

name = 'animal_spider'

start_urls = ['https://animalcorner.org/animals/']

def parse(self, response):

# Seguir los enlaces a las páginas individuales de animales dentro del directorio

for animal_link in response.css('a[href*="/animals/"]::attr(href)').getall():

yield response.follow(animal_link, self.parse_animal)

def parse_animal(self, response):

# Extraer datos estructurados de los perfiles de animales

yield {

'common_name': response.css('h1::text').get().strip(),

'scientific_name': response.xpath('//p[contains(., "(")]/text()').re_first(r'\((.*?)\)'),

'description': ' '.join(response.css('p::text').getall()[:5])

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://animalcorner.org/animals/african-elephant/');

const data = await page.evaluate(() => {

// Extraer el título y el párrafo introductorio

return {

title: document.querySelector('h1').innerText.trim(),

firstParagraph: document.querySelector('p').innerText.trim()

};

});

console.log('Datos Extraídos:', data);

await browser.close();

})();Qué Puedes Hacer Con Los Datos de Animal Corner

Explora aplicaciones prácticas e insights de los datos de Animal Corner.

App de Tarjetas Educativas

Crea una aplicación de aprendizaje móvil que utilice datos de animales e imágenes de alta calidad para enseñar a los estudiantes sobre la biodiversidad.

Cómo implementar:

- 1Extraer nombres de animales, rasgos físicos e imágenes destacadas

- 2Categorizar los animales por nivel de dificultad o grupo biológico

- 3Diseñar una interfaz de cuestionario interactivo utilizando los datos recopilados

- 4Implementar un seguimiento del progreso para ayudar a los usuarios a dominar la identificación de especies

Usa Automatio para extraer datos de Animal Corner y crear estas aplicaciones sin escribir código.

Qué Puedes Hacer Con Los Datos de Animal Corner

- App de Tarjetas Educativas

Crea una aplicación de aprendizaje móvil que utilice datos de animales e imágenes de alta calidad para enseñar a los estudiantes sobre la biodiversidad.

- Extraer nombres de animales, rasgos físicos e imágenes destacadas

- Categorizar los animales por nivel de dificultad o grupo biológico

- Diseñar una interfaz de cuestionario interactivo utilizando los datos recopilados

- Implementar un seguimiento del progreso para ayudar a los usuarios a dominar la identificación de especies

- Dataset de Investigación Zoológica

Proporciona un dataset estructurado para investigadores que comparan estadísticas anatómicas entre diferentes familias de especies.

- Extraer estadísticas numéricas específicas como el ritmo cardíaco y el periodo de gestación

- Normalizar las unidades de medida (p. ej., kilogramos, metros) mediante la limpieza de datos

- Organizar los datos por clasificación científica (Orden, Familia, Género)

- Exportar el dataset final a CSV para un análisis estadístico avanzado

- Publicador Automático para Blogs de Naturaleza

Genera automáticamente contenido diario para redes sociales o blogs con datos del 'Animal del Día'.

- Extraer un gran conjunto de datos curiosos sobre animales de la enciclopedia

- Programar un script para seleccionar un perfil de animal al azar cada 24 horas

- Formatear el texto extraído en una plantilla de publicación atractiva

- Utilizar las API de redes sociales para publicar el contenido con la imagen del animal

- Herramienta de Monitoreo de Conservación

Construye un dashboard que resalte los animales que figuran actualmente con estado de 'En Peligro' o 'Vulnerable'.

- Extraer nombres de especies junto con su estado de conservación específico

- Filtrar la base de datos para aislar las categorías de especies en alto riesgo

- Mapear estas especies con sus regiones geográficas reportadas

- Configurar ejecuciones de extracción periódicas para rastrear cambios en el estado de conservación

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Scrapear Animal Corner

Consejos expertos para extraer datos exitosamente de Animal Corner.

Aprovecha el índice de la A a la Z

La página de la A a la Z ofrece una jerarquía plana de todas las especies, lo que facilita mucho el scraping en comparación con navegar por categorías regionales profundamente anidadas.

Apunta al Sitemap XML

Accede a /sitemap_index.xml para obtener una lista limpia de todas las URL de las publicaciones, lo cual es más fiable y rápido que un rastreo tradicional de todo el sitio.

Elimina las dimensiones de las miniaturas

Para obtener las imágenes originales, utiliza regex para eliminar las dimensiones finales como '-300x200' de las URL de origen de las imágenes extraídas.

Implementa throttling

Establece un retraso de 2 a 3 segundos entre peticiones para evitar saturar el servidor y mantener un perfil de navegación similar al humano.

Extrae nombres científicos mediante regex

Dado que los nombres científicos suelen estar entre paréntesis cerca del nombre común, utiliza un patrón regex como '\((.*?)\)' en el primer párrafo para una extracción precisa.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Preguntas Frecuentes Sobre Animal Corner

Encuentra respuestas a preguntas comunes sobre Animal Corner