Cómo hacer scraping de jup.ag: Guía del Web Scraper para Jupiter DEX

Aprende a realizar scraping en jup.ag para obtener precios de tokens de Solana, rutas de swap y volúmenes de mercado en tiempo real. Descubre las API oficiales...

Protección Anti-Bot Detectada

- Cloudflare

- WAF y gestión de bots de nivel empresarial. Usa desafíos JavaScript, CAPTCHAs y análisis de comportamiento. Requiere automatización de navegador con configuración sigilosa.

- Limitación de velocidad

- Limita solicitudes por IP/sesión en el tiempo. Se puede eludir con proxies rotativos, retrasos en solicitudes y scraping distribuido.

- Huella del navegador

- Identifica bots por características del navegador: canvas, WebGL, fuentes, plugins. Requiere spoofing o perfiles de navegador reales.

- Huella del navegador

- Identifica bots por características del navegador: canvas, WebGL, fuentes, plugins. Requiere spoofing o perfiles de navegador reales.

Acerca de Jupiter

Descubre qué ofrece Jupiter y qué datos valiosos se pueden extraer.

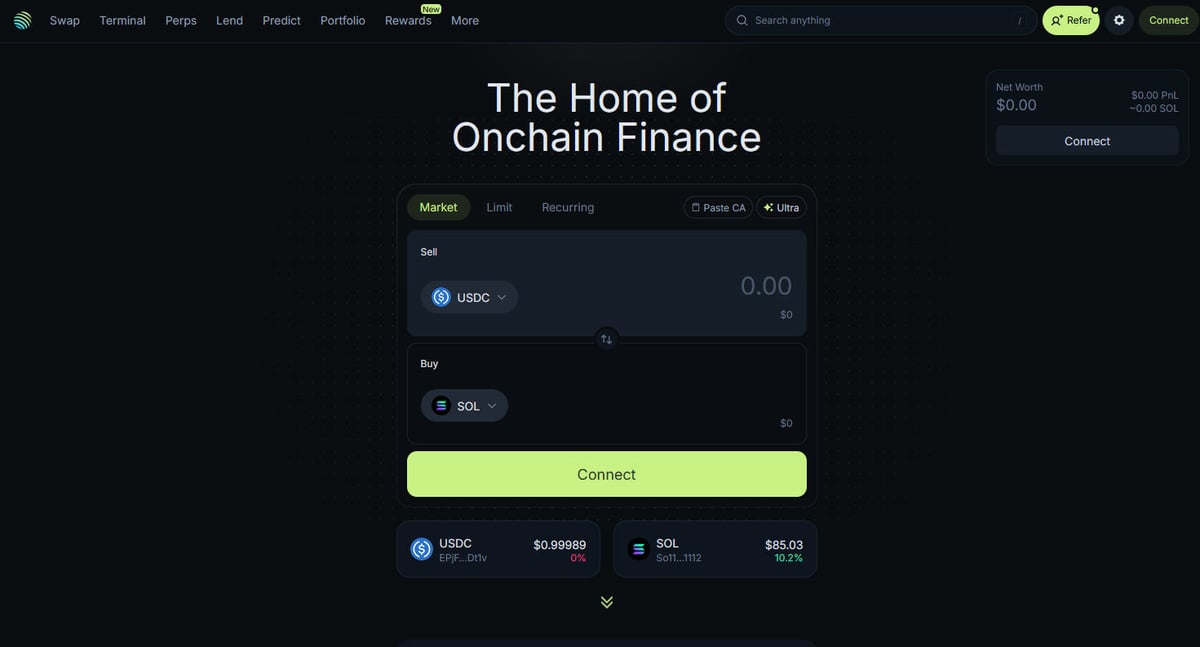

El núcleo de Solana DeFi

Jupiter es el principal agregador de liquidez para la blockchain de Solana, actuando como una "DeFi Superapp" que optimiza el enrutamiento de operaciones a través de cientos de pools de liquidez para proporcionar a los usuarios los mejores precios y el mínimo slippage. Es el centro neurálgico de las finanzas on-chain de Solana, ofreciendo servicios que van desde simples intercambios de token hasta funciones avanzadas como el trading de perpetuos con un apalancamiento de hasta 250x, órdenes límite y promedio de costo en dólares (DCA). La plataforma proporciona datos críticos para el ecosistema, incluyendo precios en tiempo real, profundidad de liquidez y métricas de mercado exhaustivas para miles de activos.

Arquitectura Técnica

El sitio web está construido sobre un stack técnico moderno utilizando Next.js y React, lo que lo convierte en una aplicación de página única (SPA) altamente dinámica. Debido a que los precios y las rutas se calculan en tiempo real basándose en el estado actual de la blockchain, el frontend se actualiza constantemente a través de WebSockets y llamadas a la API de alta frecuencia. Para científicos de datos, desarrolladores y traders, los datos de Jupiter se consideran el estándar de oro para rastrear el sentimiento del mercado de Solana y los cambios de liquidez en todo el ecosistema.

Por qué son importantes los datos

Acceder a estos datos es esencial para construir bots de trading, dashboards de mercado y realizar análisis históricos en una de las redes blockchain de más rápido crecimiento. Los scrapers suelen apuntar a Jupiter para monitorear nuevos listados de token, rastrear movimientos de "ballenas" en mercados de perpetuos o identificar discrepancias de precios para arbitraje. Aunque la plataforma ofrece APIs oficiales, el web scraping directo se utiliza con frecuencia para capturar el estado exacto de la interfaz de usuario y los datos de enrutamiento específicos que pueden no estar totalmente expuestos en los endpoints públicos.

¿Por Qué Scrapear Jupiter?

Descubre el valor comercial y los casos de uso para extraer datos de Jupiter.

Seguimiento de precios en tiempo real

Monitorea los precios de los tokens de Solana en tiempo real para obtener una ventaja en el volátil mercado DeFi. Jupiter agrega liquidez de todo el ecosistema, proporcionando las tasas de mercado más precisas disponibles.

Optimización de bots de trading

Alimenta bots de trading automatizados con datos de rutas de swap de alta frecuencia y price impact para arbitraje o sniping. Esto permite una ejecución más rápida y un mejor descubrimiento de precios en comparación con el trading manual.

Análisis de sentimiento del mercado

Rastrea la adición de nuevos tokens a la lista 'Strict' de Jupiter para identificar proyectos en tendencia y la confianza de la comunidad. Analizar los cambios de volumen entre diferentes activos ayuda a predecir movimientos más amplios del mercado.

Monitoreo de la profundidad de liquidez

Extrae datos de liquidez para determinar la profundidad de mercado de tokens SPL específicos y evaluar el potencial de slippage. Esto es crítico para traders a gran escala y proveedores de liquidez institucionales.

Datos históricos de rendimiento

Recopila el volumen diario y el historial de precios de tokens que podrían no estar listados en exchanges centralizados. Estos datos son esenciales para el backtesting de estrategias de trading y la realización de investigaciones de mercado a largo plazo.

Métricas de crecimiento del ecosistema

Mide el volumen total y el recuento de transacciones en la red Solana utilizando a Jupiter como referencia. Esto ayuda a desarrolladores e inversores a entender la tasa de adopción de DeFi en Solana a lo largo del tiempo.

Desafíos de Scraping

Desafíos técnicos que puedes encontrar al scrapear Jupiter.

Dependencia del renderizado de JavaScript

Jupiter está construido como una Single Page Application (SPA) compleja usando React, lo que significa que los datos no están presentes en el HTML inicial. Debes usar una herramienta capaz de renderizar completamente JavaScript para acceder a los precios y listas de tokens.

Protección agresiva de Cloudflare

El sitio utiliza el Web Application Firewall (WAF) de Cloudflare para bloquear el tráfico que no provenga de un navegador y los scripts automatizados. Superar estos desafíos requiere técnicas avanzadas de fingerprinting del navegador y gestión de headers.

Flujo de datos dinámicos

Los precios y las rutas de swap se actualizan varias veces por segundo a través de WebSockets y llamadas a la API de alta frecuencia. Capturar instantáneas consistentes de estos datos requiere una infraestructura de scraping de baja latencia y una sincronización precisa.

Límites de tasa en endpoints públicos

Los endpoints de la API pública y las rutas web tienen límites de tasa estrictos para prevenir el abuso. Exceder estos límites a menudo resulta en bloqueos de IP temporales o permanentes, lo que hace que los proxies residenciales sean una necesidad.

Volatilidad de los selectores de la UI

Las actualizaciones frecuentes en el frontend de Jupiter pueden causar que las clases CSS y las estructuras del DOM cambien sin previo aviso. Esto requiere que los scrapers tengan selectores robustos y flexibles, o un mantenimiento frecuente para evitar fallos.

Scrapea Jupiter con IA

Sin código necesario. Extrae datos en minutos con automatización impulsada por IA.

Cómo Funciona

Describe lo que necesitas

Dile a la IA qué datos quieres extraer de Jupiter. Solo escríbelo en lenguaje natural — sin código ni selectores.

La IA extrae los datos

Nuestra inteligencia artificial navega Jupiter, maneja contenido dinámico y extrae exactamente lo que pediste.

Obtén tus datos

Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Por Qué Usar IA para el Scraping

La IA facilita el scraping de Jupiter sin escribir código. Nuestra plataforma impulsada por inteligencia artificial entiende qué datos quieres — solo descríbelo en lenguaje natural y la IA los extrae automáticamente.

How to scrape with AI:

- Describe lo que necesitas: Dile a la IA qué datos quieres extraer de Jupiter. Solo escríbelo en lenguaje natural — sin código ni selectores.

- La IA extrae los datos: Nuestra inteligencia artificial navega Jupiter, maneja contenido dinámico y extrae exactamente lo que pediste.

- Obtén tus datos: Recibe datos limpios y estructurados listos para exportar como CSV, JSON o enviar directamente a tus aplicaciones.

Why use AI for scraping:

- Renderizado Headless completo: Automatio maneja de forma nativa el pesado renderizado de JavaScript de la interfaz de Jupiter, asegurando que veas los mismos datos que un usuario humano. No tienes que preocuparte por perder datos que solo se cargan después de la vista inicial de la página.

- Rotación inteligente de proxies: La rotación de proxies residenciales integrada te permite evadir Cloudflare y los límites de tasa basados en IP sin esfuerzo. Esto garantiza que tus sesiones de scraping permanezcan ininterrumpidas incluso al consultar datos con altas frecuencias.

- Selección visual de datos: Selecciona fácilmente los precios de tokens, volúmenes o rutas específicas que deseas extraer mediante una interfaz de apuntar y hacer clic. No es necesario escribir selectores XPath o CSS complejos para apuntar a elementos dinámicos.

- Programación automatizada: Configura tus scrapers de Jupiter para que se ejecuten en un horario preciso, como cada minuto o cada hora, para mantener un conjunto de datos actualizado. Esto es perfecto para construir dashboards en tiempo real o alertas de precios automatizadas.

- Integración directa de datos: Envía tus datos de DeFi extraídos directamente a Google Sheets, Airtable o a tu propia base de datos a través de Webhooks. Esto elimina la entrada manual de datos y optimiza tu flujo de trabajo de trading o investigación.

Scrapers Sin Código para Jupiter

Alternativas de apuntar y clic al scraping con IA

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear Jupiter. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

Desafíos Comunes

Curva de aprendizaje

Comprender selectores y lógica de extracción lleva tiempo

Los selectores se rompen

Los cambios en el sitio web pueden romper todo el flujo de trabajo

Problemas con contenido dinámico

Los sitios con mucho JavaScript requieren soluciones complejas

Limitaciones de CAPTCHA

La mayoría de herramientas requieren intervención manual para CAPTCHAs

Bloqueo de IP

El scraping agresivo puede resultar en el bloqueo de tu IP

Scrapers Sin Código para Jupiter

Varias herramientas sin código como Browse.ai, Octoparse, Axiom y ParseHub pueden ayudarte a scrapear Jupiter. Estas herramientas usan interfaces visuales para seleccionar elementos, pero tienen desventajas comparadas con soluciones con IA.

Flujo de Trabajo Típico con Herramientas Sin Código

- Instalar extensión del navegador o registrarse en la plataforma

- Navegar al sitio web objetivo y abrir la herramienta

- Seleccionar con point-and-click los elementos de datos a extraer

- Configurar selectores CSS para cada campo de datos

- Configurar reglas de paginación para scrapear múltiples páginas

- Resolver CAPTCHAs (frecuentemente requiere intervención manual)

- Configurar programación para ejecuciones automáticas

- Exportar datos a CSV, JSON o conectar vía API

Desafíos Comunes

- Curva de aprendizaje: Comprender selectores y lógica de extracción lleva tiempo

- Los selectores se rompen: Los cambios en el sitio web pueden romper todo el flujo de trabajo

- Problemas con contenido dinámico: Los sitios con mucho JavaScript requieren soluciones complejas

- Limitaciones de CAPTCHA: La mayoría de herramientas requieren intervención manual para CAPTCHAs

- Bloqueo de IP: El scraping agresivo puede resultar en el bloqueo de tu IP

Ejemplos de Código

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Cuándo Usar

Mejor para páginas HTML estáticas donde el contenido se carga del lado del servidor. El enfoque más rápido y simple cuando no se requiere renderizado de JavaScript.

Ventajas

- ●Ejecución más rápida (sin sobrecarga del navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar con asyncio

- ●Excelente para APIs y páginas estáticas

Limitaciones

- ●No puede ejecutar JavaScript

- ●Falla en SPAs y contenido dinámico

- ●Puede tener dificultades con sistemas anti-bot complejos

Cómo Scrapear Jupiter con Código

Python + Requests

import requests

def get_jupiter_price(token_address):

# Using the official Jupiter Price API V2 is the most reliable method

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Price: ${price_info['price']}")

except Exception as e:

print(f"An error occurred: {e}")

# Example: Fetching SOL price

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Launch a browser that can render the Next.js frontend

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Wait for the token list items to render in the DOM

# Note: Selectors must be updated based on the current UI build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Directly hitting the token list JSON endpoint used by the frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# The response is a raw JSON list of all verified tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent to help bypass basic filters

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigate to the main swap page

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Example of extracting a price element using a partial selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Price not found';

});

console.log(`Live SOL Price observed in UI: ${solPrice}`);

await browser.close();

})();Qué Puedes Hacer Con Los Datos de Jupiter

Explora aplicaciones prácticas e insights de los datos de Jupiter.

Sistema de alertas de arbitraje de precios

Identifica diferencias de precios entre Jupiter y otros DEXs de Solana para ejecutar operaciones rentables.

Cómo implementar:

- 1Extrae tasas de intercambio en tiempo real de la Price API de Jupiter.

- 2Compara las tasas con los pools de liquidez de Orca y Raydium.

- 3Configura alertas automáticas o ganchos de ejecución para oportunidades de arbitraje.

Usa Automatio para extraer datos de Jupiter y crear estas aplicaciones sin escribir código.

Qué Puedes Hacer Con Los Datos de Jupiter

- Sistema de alertas de arbitraje de precios

Identifica diferencias de precios entre Jupiter y otros DEXs de Solana para ejecutar operaciones rentables.

- Extrae tasas de intercambio en tiempo real de la Price API de Jupiter.

- Compara las tasas con los pools de liquidez de Orca y Raydium.

- Configura alertas automáticas o ganchos de ejecución para oportunidades de arbitraje.

- Dashboard de salud del mercado de Solana

Construye una visión a nivel macro de la actividad DeFi en Solana para inversores.

- Agrega datos de volumen de 24h y TVL para los principales tokens.

- Categoriza los tokens por sectores (Meme, AI, RWA).

- Visualiza los cambios de liquidez en diferentes clases de activos a lo largo del tiempo.

- Sniper de nuevos listados de tokens

Detecta y analiza nuevos tokens que aparecen en la lista verificada de Jupiter de inmediato.

- Haz scraping regularmente del endpoint de la lista de tokens.

- Compara los nuevos resultados con una base de datos local para encontrar nuevas adiciones.

- Analiza la liquidez inicial y el volumen para evaluar el potencial del token.

- Rastreador de ballenas y perpetuos

Monitorea posiciones grandes y tasas de financiación en el mercado de perpetuos de Jupiter.

- Extrae datos de interés abierto y tasas de financiación de la sección Perps.

- Rastrea registros de transacciones grandes para identificar el comportamiento de las wallets.

- Construye sentiment model basados en los ratios long/short de los principales activos.

- Servicio de agregación de rendimientos

Proporciona a los usuarios las mejores tasas de préstamo disponibles en los depósitos de Jupiter Lend.

- Extrae datos de APY para varias stablecoins y pares de SOL.

- Calcula el rendimiento neto después de las comisiones estimadas de la plataforma.

- Automatiza las recomendaciones de reequilibrio para la optimización de carteras.

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Scrapear Jupiter

Consejos expertos para extraer datos exitosamente de Jupiter.

Prioriza los endpoints de la API oficial

Siempre que sea posible, utiliza las API oficiales V6 de Quote o Price de Jupiter en lugar de hacer scraping de la interfaz de usuario. Estos endpoints están diseñados para un acceso programático de alto rendimiento y suelen ser más estables.

Implementa Exponential Backoff

Cuando tus solicitudes alcancen un límite de tasa (rate limit), utiliza una estrategia que aumente progresivamente el tiempo de espera entre reintentos. Esto ayuda a evitar que la capa de seguridad de Jupiter identifique tu IP como maliciosa.

Filtra mediante la Lista Strict

Realiza el scraping de la lista de tokens 'Strict' de Jupiter para asegurarte de monitorear solo activos verificados. Esta es la mejor forma de filtrar rugpulls de baja liquidez y tokens fraudulentos que aparecen en la lista 'All'.

Utiliza proxies residenciales de alta calidad

Evita el uso de proxies de datacenter, ya que Cloudflare suele tenerlos en listas negras predefinidas. Los proxies residenciales o móviles generan más confianza y tienen menos probabilidades de activar CAPTCHAs o errores 403 Forbidden.

Monitorea el tráfico de WebSocket

Usa el inspector de red de tu navegador para encontrar las conexiones WebSocket que Jupiter utiliza para actualizaciones en vivo. Emular estas conexiones puede ser más eficiente que recargar la página para obtener feeds de precios en tiempo real.

Ten en cuenta los decimales de los tokens

Extrae siempre el campo 'decimals' de los metadatos del token al realizar el scraping de las mint addresses. Esto es crucial para convertir correctamente los enteros crudos on-chain en montos de moneda legibles para humanos.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Preguntas Frecuentes Sobre Jupiter

Encuentra respuestas a preguntas comunes sobre Jupiter