Claude 3.7 Sonnet

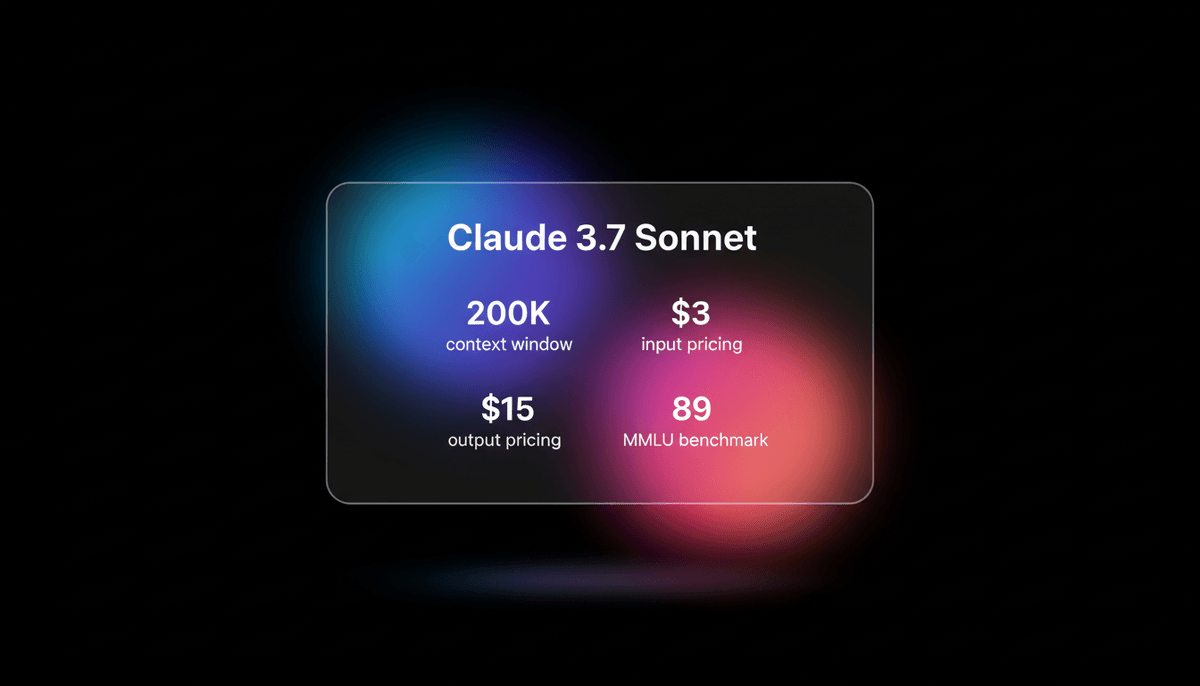

Claude 3.7 Sonnet es el primer model de hybrid reasoning de Anthropic, que ofrece capacidades de programación state-of-the-art, un context window de 200k y...

Acerca de Claude 3.7 Sonnet

Conoce las capacidades, características y formas de uso de Claude 3.7 Sonnet.

Hybrid Reasoning y Transparencia

Claude 3.7 Sonnet representa un cambio histórico en la arquitectura de los LLM al ser el primer model de 'hybrid reasoning' de Anthropic. Permite de forma única a los usuarios alternar entre respuestas estándar de baja latency y un modo de 'extended thinking' que muestra su chain-of-thought interno. Esta transparencia proporciona a los usuarios una ventana clara a la lógica del model, haciéndolo particularmente eficaz para la resolución de problemas complejos y tareas de reasoning críticas.

Maestría en Ingeniería de Software

Diseñado con un fuerte enfoque en la ingeniería de software y en outputs listos para producción, el model ha establecido nuevos estándares en la industria en benchmarks como SWE-Bench Verified. Destaca en el 'vibe coding', donde los desarrolladores describen la intención a alto nivel y el model se encarga de la implementación en múltiples archivos. Gestiona refactorizaciones complejas y decisiones arquitectónicas con una precisión que supera a los anteriores frontier models.

Context Masivo y Herramientas Agentic

Con un masivo context window de 200,000 tokens y un conjunto de herramientas agentic llamado Claude Code, se transforma de un simple chatbot en un socio técnico colaborativo. Es capaz de gestionar ciclos de vida completos de proyectos, desde la revisión inicial de la documentación hasta flujos de trabajo de git automatizados y la ejecución de pruebas, asegurando que el desarrollo sea rápido y esté libre de errores.

Casos de uso de Claude 3.7 Sonnet

Descubre las diferentes formas de usar Claude 3.7 Sonnet para lograr excelentes resultados.

Vibe Coding

Creación de software funcional desde cero describiendo la intención en lenguaje natural.

Debugging avanzado

Uso del extended thinking para analizar logs complejos y proporcionar correcciones precisas en un solo intento.

Análisis de context amplio

Revisión y refactorización de bases de código completas o documentación técnica extensa en un solo prompt.

Desarrollo agentic

Impulso de herramientas basadas en terminal como Claude Code para automatizar flujos de trabajo de git y ejecución de pruebas.

Generación de UI Frontend

Creación de componentes de React y Svelte elegantes y fáciles de mantener con un sentido del diseño integrado.

Investigación factual

Análisis de documentos PDF y conjuntos de datos masivos con alta precisión y bajas tasas de alucinación.

Fortalezas

Limitaciones

Inicio rápido de API

anthropic/claude-3.7-sonnet

import Anthropic from '@anthropic-ai/sdk';

const anthropic = new Anthropic({

apiKey: process.env.ANTHROPIC_API_KEY,

});

const msg = await anthropic.messages.create({

model: "claude-3-7-sonnet-20250219",

max_tokens: 1024,

thinking: { type: "enabled", budget_tokens: 1024 },

messages: [{ role: "user", content: "Write a high-performance Rust function for matrix multiplication." }],

});

console.log(msg.content);Instala el SDK y comienza a hacer llamadas API en minutos.

Lo que la gente dice sobre Claude 3.7 Sonnet

Mira lo que la comunidad piensa sobre Claude 3.7 Sonnet

“Claude 3.7 Sonnet es el mejor model de IA para programación del mundo; me dejó alucinado con tareas desafiantes.”

“Con un solo prompt, resolvió todo perfectamente en un proyecto complejo de TypeScript.”

“Claude Code con Sonnet 3.7 es mucho mejor que Cline y actualmente la mejor herramienta.”

“El salto de calidad con models de primer nivel como el 3.7 ha transformado mi perspectiva.”

“Claude 3.7 es pura potencia, es otro nivel... sencillamente el mejor, sin duda.”

“El modo reasoning de Claude 3.7 es un cambio de paradigma total para el debugging de lógica.”

Videos sobre Claude 3.7 Sonnet

Mira tutoriales, reseñas y discusiones sobre Claude 3.7 Sonnet

“El nuevo model 3.7 arrasó absolutamente con todos los demás... ahora es capaz de resolver el 70.3% de los issues de GitHub”

“Usar un lenguaje fuertemente tipado junto con TDD son formas de que la IA valide que el código que escribe es realmente válido”

“El model es increíblemente inteligente siguiendo instrucciones”

“El rendimiento en SWE-bench es realmente una locura”

“El reasoning visible cambia las reglas del juego en cuanto a transparencia”

“Claude 3.7 Sonnet... es probablemente el mejor LLM para generación de código”

“Si usas la API, puedes generar 128,000 tokens en un solo intento”

“El límite de 128k de output es una mejora masiva”

“Su gusto estético para componentes frontend no tiene rival”

“El uso de herramientas y las capacidades agentic son fundamentales en este model”

“El reasoning debería ser una capacidad integrada de los frontier models en lugar de un model completamente separado”

“Claude 3.7 logra superar a esos models [DeepSeek, o3] por una cantidad bastante significativa”

“La latency es ligeramente mayor en el modo reasoning”

“Supera a DeepSeek R1 en varias tareas de seguimiento de instrucciones”

“Anthropic se centró realmente en outputs listos para producción”

Potencia tu flujo de trabajo con Automatizacion IA

Automatio combina el poder de agentes de IA, automatizacion web e integraciones inteligentes para ayudarte a lograr mas en menos tiempo.

Consejos Pro para Claude 3.7 Sonnet

Consejos de expertos para ayudarte a sacar el máximo provecho de Claude 3.7 Sonnet.

Presupuesto de pensamiento

Utiliza el modo de 'extended thinking' específicamente para lógica compleja o planificación de arquitectura para obtener resultados de mayor calidad.

Control del context

Utiliza /clear regularmente o reinicia los chats para ahorrar costes de context y evitar que el model se vuelva lento.

Verificación

Pide a Claude que escriba y ejecute pruebas para su propio código usando la herramienta Claude Code para asegurar la estabilidad en producción.

Especificaciones en Markdown

Proporciona los requisitos de las funcionalidades en archivos Markdown estructurados para un mejor seguimiento de instrucciones en proyectos grandes.

Testimonios

Lo Que Dicen Nuestros Usuarios

Unete a miles de usuarios satisfechos que han transformado su flujo de trabajo

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados AI Models

Grok-3

xAI

Grok-3 is xAI's flagship reasoning model, featuring deep logic deduction, a 128k context window, and real-time integration with X for live research and coding.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Claude Sonnet 4.5

Anthropic

Anthropic's Claude Sonnet 4.5 delivers world-leading coding (77.2% SWE-bench) and a 200K context window, optimized for the next generation of autonomous agents.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Preguntas Frecuentes Sobre Claude 3.7 Sonnet

Encuentra respuestas a preguntas comunes sobre Claude 3.7 Sonnet