Как парсить Behance: пошаговое руководство по извлечению креативных данных

Узнайте, как выполнять парсинг проектов Behance, портфолио и данных о талантах. Руководство охватывает обход анти-бот систем, рендеринг JavaScript и...

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

- User-Agent Filtering

- AI Bot Blocking

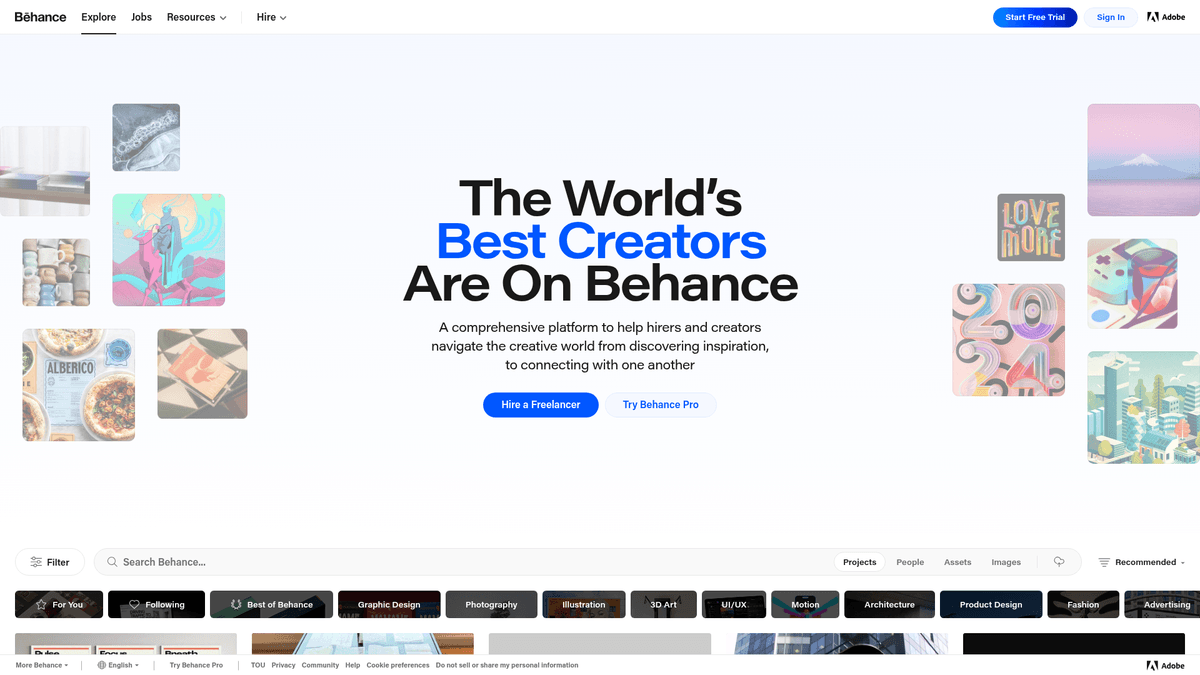

О Behance

Узнайте, что предлагает Behance и какие ценные данные можно извлечь.

Behance — это крупнейшая в мире творческая сеть, принадлежащая Adobe, которая служит ведущей социальной платформой и сервисом для хостинга портфолио создателей контента. Она позволяет профессионалам в области графического дизайна, фотографии, иллюстрации и UI/UX демонстрировать свои работы через галереи проектов. Платформа глубоко интегрирована в экосистему Adobe Creative Cloud, что делает ее главным хабом для творческих талантов по всему миру.

Платформа содержит огромный репозиторий структурированных данных, включая категории проектов, конкретные используемые инструменты (такие как Photoshop или Figma) и подробные профессиональные метаданные. Каждая карточка проекта обычно включает изображения высокого разрешения, описания, количество просмотров, лайков и прямые ссылки на профиль автора. Это делает ресурс незаменимым для компаний, стремящихся понять визуальные тренды или найти высококлассных специалистов.

Парсинг Behance особенно ценен для конкурентной разведки, прогнозирования трендов в индустрии дизайна и подбора топовых кадров на креативные роли. Поскольку данные богаты техническими атрибутами, такими как используемое ПО и теги проектов, они дают представление о том, как развивается креативная индустрия и какие инструменты доминируют в профессиональной среде.

Зачем Парсить Behance?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Behance.

Поиск талантов и рекрутинг

Исследование рынка и трендов дизайна

Конкурентная разведка для креативных агентств

Лидогенерация для софтверных компаний

Агрегация данных для каталогов портфолио

Академические исследования в области цифрового искусства

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Behance.

Продвинутая защита от ботов Cloudflare

Необходимость рендеринга сложного JavaScript

Динамическая пагинация с бесконечной прокруткой

Сложные вложенные CSS-селекторы

Ленивая загрузка (lazy-loading) и защита изображений

Скрапинг Behance с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Behance. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Behance, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Behance без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Behance. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Behance, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Автоматический обход Cloudflare

- Не требует навыков программирования

- Бесшовная работа с бесконечной прокруткой

- Запуск в облаке по расписанию

No-Code Парсеры для Behance

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Behance без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Behance

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Behance без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

# Примечание: это, скорее всего, вызовет блокировку Cloudflare при запуске с IP дата-центра

url = "https://www.behance.net/search/projects?field=graphic+design"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36"

}

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Behance рендерит контент через JS; статический парсинг найдет минимум данных

projects = soup.find_all('div', class_='ProjectCover-root-167')

for project in projects:

title = project.find('a', class_='ProjectCover-title-3_1').text

print(f"Найден проект: {title}")

else:

print(f"Блокировка или ошибка: {response.status_code}")

except Exception as e:

print(f"Ошибка запроса: {e}")Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Behance с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

# Примечание: это, скорее всего, вызовет блокировку Cloudflare при запуске с IP дата-центра

url = "https://www.behance.net/search/projects?field=graphic+design"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36"

}

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Behance рендерит контент через JS; статический парсинг найдет минимум данных

projects = soup.find_all('div', class_='ProjectCover-root-167')

for project in projects:

title = project.find('a', class_='ProjectCover-title-3_1').text

print(f"Найден проект: {title}")

else:

print(f"Блокировка или ошибка: {response.status_code}")

except Exception as e:

print(f"Ошибка запроса: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_behance():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto("https://www.behance.net/search/projects?field=architecture")

# Ожидание загрузки динамического контента

page.wait_for_selector(".ProjectCover-root-167")

# Прокрутка вниз для срабатывания ленивой загрузки

page.mouse.wheel(0, 5000)

page.wait_for_timeout(2000)

projects = page.query_selector_all(".ProjectCover-root-167")

data = []

for p_elem in projects:

title = p_elem.query_selector(".ProjectCover-title-3_1").inner_text()

owner = p_elem.query_selector(".ProjectCover-username-28M").inner_text()

data.append({"title": title, "owner": owner})

print(data)

browser.close()

scrape_behance()Python + Scrapy

import scrapy

from scrapy_playwright.page import PageMethod

class BehanceSpider(scrapy.Spider):

name = "behance"

start_urls = ["https://www.behance.net/search/projects?field=interaction"]

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(

url,

meta={"playwright": True, "playwright_page_methods": [

PageMethod("wait_for_selector", ".ProjectCover-root-167"),

]},

)

def parse(self, response):

for project in response.css(".ProjectCover-root-167"):

yield {

"title": project.css(".ProjectCover-title-3_1::text").get(),

"url": project.css("a::attr(href)").get(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.behance.net/search/projects?field=branding');

// Ожидание загрузки контента

await page.waitForSelector('.ProjectCover-content-3Z_');

const projects = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.ProjectCover-root-167')).map(el => ({

title: el.querySelector('.ProjectCover-title-3_1')?.innerText,

owner: el.querySelector('.ProjectCover-username-28M')?.innerText

}));

});

console.log(projects);

await browser.close();

})();Что Можно Делать С Данными Behance

Изучите практические применения и инсайты из данных Behance.

Анализ креативных трендов

Агентства могут отслеживать, какие творческие направления и стили дизайна набирают больше всего лайков, чтобы прогнозировать отраслевые тренды.

Как реализовать:

- 1Ежемесячно собирайте данные о 5 000 топовых проектах в конкретных творческих областях.

- 2Группируйте данные по категориям и соотношению лайков к просмотрам.

- 3Визуализируйте рост и вовлеченность с течением времени для выявления зарождающейся эстетики.

Используйте Automatio для извлечения данных из Behance и создания этих приложений без написания кода.

Что Можно Делать С Данными Behance

- Анализ креативных трендов

Агентства могут отслеживать, какие творческие направления и стили дизайна набирают больше всего лайков, чтобы прогнозировать отраслевые тренды.

- Ежемесячно собирайте данные о 5 000 топовых проектах в конкретных творческих областях.

- Группируйте данные по категориям и соотношению лайков к просмотрам.

- Визуализируйте рост и вовлеченность с течением времени для выявления зарождающейся эстетики.

- Лидогенерация для разработчиков ПО

IT-компании могут выявлять пользователей конкурирующих инструментов для таргетинга предложений по переходу на свой продукт или специализированных маркетинговых кампаний.

- Собирайте данные о проектах в таких категориях, как UI/UX или 3D-графика.

- Извлекайте поле «Используемые инструменты» из метаданных проектов с помощью глубокого парсинга страниц.

- Фильтруйте упоминания инструментов конкурентов и собирайте профили пользователей для адресных предложений.

- Масштабный поиск кандидатов (Sourcing)

Технологические компании могут создавать базы данных высококлассных дизайнеров, собирая профили с большим количеством лайков в определенных регионах.

- Ищите по конкретным ключевым словам (например, «Product Design») и фильтруйте по местоположению.

- Собирайте ссылки на профили и общее количество лайков для каждого пользователя.

- Экспортируйте список в CRM для рекрутинга для автоматизированного формирования базы талантов.

- Визуальный бенчмаркинг конкурентов

Бренды могут отслеживать, какие типы визуального контента публикуют конкуренты и как на них реагирует сообщество.

- Определите профили Behance конкурирующих агентств или брендов.

- Собирайте заголовки их последних проектов, описания и метрики вовлеченности.

- Сравнивайте рост их популярности со своими собственными показателями.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Behance

Экспертные советы для успешного извлечения данных из Behance.

Мониторинг внутренних XHR-запросов

проверяйте вкладку Network на наличие запросов к внутренним эндпоинтам, которые часто возвращают чистые данные в формате JSON.

Используйте резидентские прокси

резидентские IP необходимы, чтобы избежать обнаружения системой защиты от ботов Cloudflare.

Обработка селекторов изображений

извлекайте URL высокого разрешения из атрибута srcset вместо стандартного src для получения лучшего качества.

Ограничивайте частоту запросов

ограничьте парсинг 1-2 страницами в минуту, чтобы избежать быстрой блокировки IP или срабатывания CAPTCHA.

Имитируйте поведение человека

меняйте user-agents и внедряйте случайные задержки между действиями на странице, чтобы казаться реальным пользователем.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Goodreads: The Ultimate Web Scraping Guide 2025

How to Scrape Bluesky (bsky.app): API and Web Methods

Часто задаваемые вопросы о Behance

Найдите ответы на частые вопросы о Behance