วิธี Scrape HotPads: คู่มือฉบับสมบูรณ์ในการสกัดข้อมูลการเช่าที่พัก

เรียนรู้วิธีการ scrape HotPads.com เพื่อสกัดราคาเช่า รายละเอียดอสังหาริมทรัพย์ และข้อมูลตำแหน่งที่ตั้ง มาสเตอร์เทคนิคการก้าวข้ามระบบ anti-bot...

ตรวจพบการป้องกันบอท

- Akamai Bot Manager

- การตรวจจับบอทขั้นสูงโดยใช้ลายนิ้วมืออุปกรณ์ การวิเคราะห์พฤติกรรม และการเรียนรู้ของเครื่อง เป็นหนึ่งในระบบต่อต้านบอทที่ซับซ้อนที่สุด

- DataDome

- การตรวจจับบอทแบบเรียลไทม์ด้วยโมเดล ML วิเคราะห์ลายนิ้วมืออุปกรณ์ สัญญาณเครือข่าย และรูปแบบพฤติกรรม พบบ่อยในเว็บไซต์อีคอมเมิร์ซ

- Google reCAPTCHA

- ระบบ CAPTCHA ของ Google v2 ต้องมีการโต้ตอบของผู้ใช้ v3 ทำงานเงียบๆ ด้วยคะแนนความเสี่ยง สามารถแก้ได้ด้วยบริการ CAPTCHA

- การจำกัดอัตรา

- จำกัดคำขอต่อ IP/เซสชันตามเวลา สามารถหลีกเลี่ยงได้ด้วยพร็อกซีหมุนเวียน การหน่วงเวลาคำขอ และการสแกรปแบบกระจาย

- การบล็อก IP

- บล็อก IP ของศูนย์ข้อมูลที่รู้จักและที่อยู่ที่ถูกทำเครื่องหมาย ต้องใช้พร็อกซีที่อยู่อาศัยหรือมือถือเพื่อหลีกเลี่ยงอย่างมีประสิทธิภาพ

เกี่ยวกับ HotPads

ค้นพบสิ่งที่ HotPads นำเสนอและข้อมูลที่มีค่าที่สามารถดึงได้

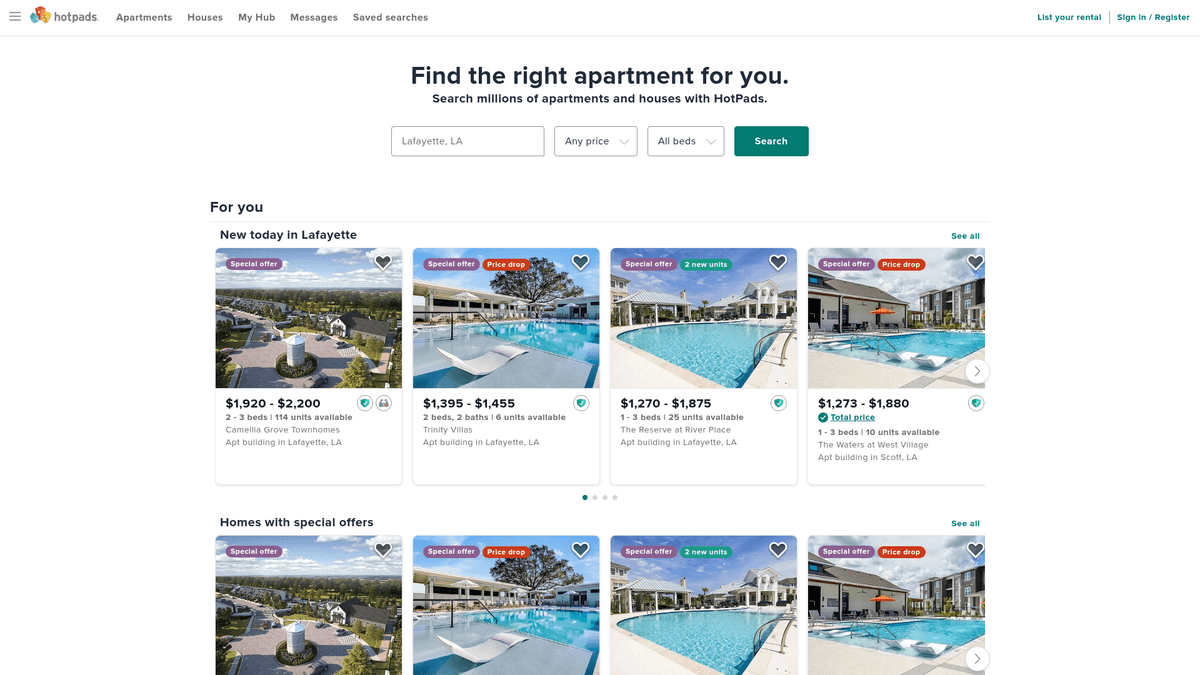

ขุมพลังแห่งการเช่าที่พักในเมือง

HotPads คือโปรแกรมค้นหาที่พักให้เช่าแบบเน้นแผนที่ ซึ่งเชี่ยวชาญในพื้นที่เขตเมือง โดยมีรายการประกาศทั้งอพาร์ตเมนต์ บ้าน และห้องเช่า ในฐานะส่วนหนึ่งของ Zillow Group (ซึ่งรวมถึง Zillow และ Trulia) แพลตฟอร์มนี้จึงใช้ประโยชน์จากฐานข้อมูลอสังหาริมทรัพย์ขนาดมหึมา ทำให้เป็นจุดหมายปลายทางหลักสำหรับผู้เช่าในสหรัฐอเมริกา

ข้อมูลการเช่าที่ครอบคลุม

ข้อมูลใน HotPads มีมูลค่าสูงมากสำหรับการวิเคราะห์ตลาด เนื่องจากมักมีรายการประเภท 'ให้เช่าโดยเจ้าของ' (FRBO) และข้อมูลอพาร์ตเมนต์ขนาดเล็กที่พอร์ทัลขนาดใหญ่อาจพลาดไป สำหรับนักขูดข้อมูล (scrapers) แพลตฟอร์มนี้ถือเป็นแหล่งข้อมูลคุณภาพสูงสำหรับจำนวนที่พักคงเหลือและแนวโน้มราคาแบบเรียลไทม์ ช่วยให้สามารถติดตามการเปลี่ยนแปลงของที่อยู่อาศัยในเมืองได้อย่างละเอียด

ทำไมถึงสำคัญ

การเข้าถึงข้อมูล HotPads ช่วยให้มืออาชีพด้านอสังหาริมทรัพย์และนักวิจัยสามารถวิเคราะห์ตลาดเช่าด้วยความแม่นยำเชิงพื้นที่สูง ไม่ว่าคุณจะกำลังตรวจสอบประสิทธิภาพการจัดการอสังหาริมทรัพย์หรือระบุทำเลอสังหาริมทรัพย์ที่กำลังมาแรง การเน้นที่การอยู่อาศัยในพื้นที่หนาแน่นของแพลตฟอร์มนี้ทำให้มันเป็นทรัพยากรที่ขาดไม่ได้สำหรับข้อมูลเชิงลึกด้านอสังหาริมทรัพย์ในเมือง

ทำไมต้อง Scrape HotPads?

ค้นพบคุณค่าทางธุรกิจและกรณีการใช้งานสำหรับการดึงข้อมูลจาก HotPads

การตรวจสอบตลาดเช่าแบบเรียลไทม์

การวิเคราะห์ราคาคู่แข่งสำหรับเจ้าของที่พัก

การหาลีด (Lead Generation) สำหรับตัวแทนอสังหาริมทรัพย์

การวิจัยการลงทุนเพื่อการซื้ออสังหาริมทรัพย์

การศึกษาความหนาแน่นและจำนวนที่พักในเขตเมือง

ความท้าทายในการ Scrape

ความท้าทายทางเทคนิคที่คุณอาจพบเมื่อ Scrape HotPads

ด่านทดสอบ Akamai 'Press & Hold' ที่เข้มงวด

การโหลดข้อมูลแบบไดนามิกบนแผนที่ (AJAX)

การเปลี่ยนชื่อ CSS class บ่อยครั้ง (Obfuscation)

การจำกัด Rate Limiting บน IP addresses อย่างเคร่งครัด

การตัดข้อมูลในหน้าผลการค้นหาที่จำเป็นต้องใช้ deep links เข้าไปดู

สกัดข้อมูลจาก HotPads ด้วย AI

ไม่ต้องเขียนโค้ด สกัดข้อมูลภายในไม่กี่นาทีด้วยระบบอัตโนมัติที่ขับเคลื่อนด้วย AI

วิธีการทำงาน

อธิบายสิ่งที่คุณต้องการ

บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก HotPads แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

AI สกัดข้อมูล

ปัญญาประดิษฐ์ของเรานำทาง HotPads จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

รับข้อมูลของคุณ

รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

ทำไมต้องใช้ AI ในการสกัดข้อมูล

AI ทำให้การสกัดข้อมูลจาก HotPads เป็นเรื่องง่ายโดยไม่ต้องเขียนโค้ด แพลตฟอร์มที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ของเราเข้าใจว่าคุณต้องการข้อมูลอะไร — แค่อธิบายเป็นภาษาธรรมชาติ แล้ว AI จะสกัดให้โดยอัตโนมัติ

How to scrape with AI:

- อธิบายสิ่งที่คุณต้องการ: บอก AI ว่าคุณต้องการสกัดข้อมูลอะไรจาก HotPads แค่พิมพ์เป็นภาษาธรรมชาติ — ไม่ต้องเขียนโค้ดหรือตัวเลือก

- AI สกัดข้อมูล: ปัญญาประดิษฐ์ของเรานำทาง HotPads จัดการเนื้อหาแบบไดนามิก และสกัดข้อมูลตรงตามที่คุณต้องการ

- รับข้อมูลของคุณ: รับข้อมูลที่สะอาดและมีโครงสร้างพร้อมส่งออกเป็น CSV, JSON หรือส่งตรงไปยังแอปของคุณ

Why use AI for scraping:

- ก้าวข้าม Akamai และ DataDome โดยอัตโนมัติ

- จัดการการเรนเดอร์ JavaScript โดยไม่ต้องตั้งค่าเอง

- ตั้งเวลาการทำงานเพื่อติดตามราคาที่ลดลง

- ส่งออกข้อมูลไปยังรูปแบบโครงสร้าง เช่น CSV หรือ JSON โดยตรง

No-code web scrapers สำหรับ HotPads

ทางเลือกแบบ point-and-click สำหรับการ scraping ด้วย AI

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape HotPads โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

ความท้าทายทั่วไป

เส้นโค้งการเรียนรู้

การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

Selectors เสีย

การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

ปัญหาเนื้อหาไดนามิก

เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

ข้อจำกัด CAPTCHA

เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

การบล็อก IP

การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

No-code web scrapers สำหรับ HotPads

เครื่องมือ no-code หลายตัวเช่น Browse.ai, Octoparse, Axiom และ ParseHub สามารถช่วยคุณ scrape HotPads โดยไม่ต้องเขียนโค้ด เครื่องมือเหล่านี้มักใช้อินเทอร์เฟซแบบภาพเพื่อเลือกข้อมูล แม้ว่าอาจมีปัญหากับเนื้อหาไดนามิกที่ซับซ้อนหรือมาตรการ anti-bot

ขั้นตอนการทำงานทั่วไปกับเครื่องมือ no-code

- ติดตั้งส่วนขยายเบราว์เซอร์หรือสมัครใช้งานแพลตฟอร์ม

- นำทางไปยังเว็บไซต์เป้าหมายและเปิดเครื่องมือ

- เลือกองค์ประกอบข้อมูลที่ต้องการดึงด้วยการชี้และคลิก

- กำหนดค่า CSS selectors สำหรับแต่ละฟิลด์ข้อมูล

- ตั้งค่ากฎการแบ่งหน้าเพื่อ scrape หลายหน้า

- จัดการ CAPTCHA (มักต้องแก้ไขด้วยตนเอง)

- กำหนดค่าการตั้งเวลาสำหรับการรันอัตโนมัติ

- ส่งออกข้อมูลเป็น CSV, JSON หรือเชื่อมต่อผ่าน API

ความท้าทายทั่วไป

- เส้นโค้งการเรียนรู้: การทำความเข้าใจ selectors และตรรกะการดึงข้อมูลต้องใช้เวลา

- Selectors เสีย: การเปลี่ยนแปลงเว็บไซต์อาจทำให้เวิร์กโฟลว์ทั้งหมดเสียหาย

- ปัญหาเนื้อหาไดนามิก: เว็บไซต์ที่ใช้ JavaScript มากต้องการวิธีแก้ไขที่ซับซ้อน

- ข้อจำกัด CAPTCHA: เครื่องมือส่วนใหญ่ต้องการการแทรกแซงด้วยตนเองสำหรับ CAPTCHA

- การบล็อก IP: การ scrape อย่างรุนแรงอาจส่งผลให้ IP ถูกบล็อก

ตัวอย่างโค้ด

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: วิธีนี้มีโอกาสถูกบล็อกโดย Akamai หากไม่ใช้ proxies คุณภาพสูง

url = "https://hotpads.com/san-francisco-ca/apartments-for-rent"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

}

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

# Selectors ตัวอย่าง (อาจมีการเปลี่ยนแปลงได้)

listings = soup.select('.ListingCard-sc-1')

for item in listings:

price = item.select_one('.Price-sc-16o2x1v-0').text

address = item.select_one('.Address-sc-16o2x1v-1').text

print(f"Price: {price}, Address: {address}")

else:

print(f"Blocked or Error: {response.status_code}")

except Exception as e:

print(f"Request failed: {e}")เมื่อไหร่ควรใช้

เหมาะที่สุดสำหรับหน้า HTML แบบ static ที่มี JavaScript น้อย เหมาะสำหรับบล็อก ไซต์ข่าว และหน้าสินค้า e-commerce ธรรมดา

ข้อดี

- ●ประมวลผลเร็วที่สุด (ไม่มี overhead ของเบราว์เซอร์)

- ●ใช้ทรัพยากรน้อยที่สุด

- ●ง่ายต่อการทำงานแบบขนานด้วย asyncio

- ●เหมาะมากสำหรับ API และหน้า static

ข้อจำกัด

- ●ไม่สามารถรัน JavaScript ได้

- ●ล้มเหลวใน SPA และเนื้อหาไดนามิก

- ●อาจมีปัญหากับระบบ anti-bot ที่ซับซ้อน

วิธีสเครปข้อมูล HotPads ด้วยโค้ด

Python + Requests

import requests

from bs4 import BeautifulSoup

# หมายเหตุ: วิธีนี้มีโอกาสถูกบล็อกโดย Akamai หากไม่ใช้ proxies คุณภาพสูง

url = "https://hotpads.com/san-francisco-ca/apartments-for-rent"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

}

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

# Selectors ตัวอย่าง (อาจมีการเปลี่ยนแปลงได้)

listings = soup.select('.ListingCard-sc-1')

for item in listings:

price = item.select_one('.Price-sc-16o2x1v-0').text

address = item.select_one('.Address-sc-16o2x1v-1').text

print(f"Price: {price}, Address: {address}")

else:

print(f"Blocked or Error: {response.status_code}")

except Exception as e:

print(f"Request failed: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_hotpads():

with sync_playwright() as p:

# ใช้ stealth เพื่อหลีกเลี่ยงการตรวจจับโดย Akamai

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36")

page = context.new_page()

page.goto("https://hotpads.com/chicago-il/apartments-for-rent")

# รอให้รายการประกาศโหลดแบบไดนามิก

page.wait_for_selector(".styles__ListingCardContainer-sc-1")

listings = page.query_selector_all(".styles__ListingCardContainer-sc-1")

for listing in listings:

price_el = listing.query_selector(".Price-sc-1")

if price_el:

print(f"Found Listing: {price_el.inner_text()}")

browser.close()

scrape_hotpads()Python + Scrapy

import scrapy

class HotpadsSpider(scrapy.Spider):

name = "hotpads"

start_urls = ["https://hotpads.com/sitemap-rentals-index.xml"]

def parse(self, response):

# Hotpads ใช้ XML sitemaps เพื่อให้การค้นหา URL ทำได้ง่ายขึ้น

for url in response.xpath('//loc/text()').getall():

yield scrapy.Request(url, callback=self.parse_listing)

def parse_listing(self, response):

yield {

'price': response.css('.Price-sc-16o2x1v-0::text').get(),

'address': response.css('.Address-sc-16o2x1v-1::text').get(),

'description': response.css('.Description-sc-1::text').get(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

async function scrape() {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.goto('https://hotpads.com/los-angeles-ca/apartments-for-rent');

await page.waitForSelector('.ListingCard');

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.ListingCard')).map(el => ({

price: el.querySelector('.Price')?.innerText,

address: el.querySelector('.Address')?.innerText

}));

});

console.log(data);

await browser.close();

}

scrape();คุณสามารถทำอะไรกับข้อมูล HotPads

สำรวจการใช้งานจริงและข้อมูลเชิงลึกจากข้อมูล HotPads

การทำดัชนีราคาเช่า

สร้างดัชนีราคาเช่าในพื้นที่เพื่อระบุย่านที่ราคายังต่ำกว่ามูลค่าจริงสำหรับผู้เช่าหรือนักลงทุนที่มีศักยภาพ

วิธีการนำไปใช้:

- 1Scrape ข้อมูลราคารายวันสำหรับรหัสไปรษณีย์เฉพาะ

- 2คำนวณราคาเฉลี่ยต่อตารางฟุต

- 3แสดงภาพแนวโน้มตามช่วงเวลาโดยใช้แดชบอร์ด

ใช้ Automatio เพื่อดึงข้อมูลจาก HotPads และสร้างแอปพลิเคชันเหล่านี้โดยไม่ต้องเขียนโค้ด

คุณสามารถทำอะไรกับข้อมูล HotPads

- การทำดัชนีราคาเช่า

สร้างดัชนีราคาเช่าในพื้นที่เพื่อระบุย่านที่ราคายังต่ำกว่ามูลค่าจริงสำหรับผู้เช่าหรือนักลงทุนที่มีศักยภาพ

- Scrape ข้อมูลราคารายวันสำหรับรหัสไปรษณีย์เฉพาะ

- คำนวณราคาเฉลี่ยต่อตารางฟุต

- แสดงภาพแนวโน้มตามช่วงเวลาโดยใช้แดชบอร์ด

- การหาลูกค้าสำหรับผู้จัดการอาคาร

Scrape รายการ 'ให้เช่าโดยเจ้าของ' (FRBO) เพื่อนำเสนอบริการจัดการอสังหาริมทรัพย์หรือการซ่อมบำรุง

- กรองรายการตามประเภทอสังหาริมทรัพย์และสถานะความเป็นเจ้าของ

- สกัดข้อมูลติดต่อของผู้จัดการอสังหาริมทรัพย์หรือเจ้าของ

- ติดต่อไปยังรายการที่เพิ่งลงประกาศใหม่พร้อมข้อเสนอการบริการ

- ระบบแจ้งเตือนการลงทุน

สร้างระบบแจ้งเตือนอัตโนมัติสำหรับนักลงทุนอสังหาริมทรัพย์เมื่อมีรายการประกาศที่ตรงกับเกณฑ์ผลตอบแทนการลงทุนที่กำหนด

- กำหนดเกณฑ์เป้าหมาย เช่น ราคาสูงสุดและจำนวนห้องนอนขั้นต่ำ

- รัน scraper ทุกๆ ชั่วโมง

- ส่งการแจ้งเตือนไปยัง Slack หรืออีเมลเมื่อพบรายการที่ตรงเงื่อนไข

- รายงานจำนวนที่พักคงเหลือในตลาด

วิเคราะห์การเปลี่ยนแปลงของจำนวนที่พักในตลาดเพื่อให้ข้อมูลเชิงลึกสำหรับการวางผังเมืองหรือสื่อด้านอสังหาริมทรัพย์

- รวบรวมข้อมูลปริมาณรายการที่ประกาศอยู่เทียบกับรายการที่ปิดไปแล้ว

- จัดหมวดหมู่ห้องว่างตามเขตความหนาแน่นของเมือง

- รายงานการเติบโตหรือการลดลงรายเดือนในภาคการเช่าเฉพาะอย่าง

- การวิเคราะห์คู่แข่งสำหรับเจ้าของที่พัก

เจ้าของอสังหาริมทรัพย์สามารถตรวจสอบราคาประกาศในบริเวณใกล้เคียงเพื่อให้แน่ใจว่าราคาของตนเองยังคงแข่งขันได้ในตลาด

- เลือกรัศมีรอบอสังหาริมทรัพย์เป้าหมาย

- Scrape รายการประกาศที่ยังเปิดอยู่ทั้งหมดภายในรัศมีนั้น

- วิเคราะห์สิ่งอำนวยความสะดวกเทียบกับระดับราคาเพื่อเพิ่มรายได้จากการเช่าให้สูงสุด

เพิ่มพลังให้เวิร์กโฟลว์ของคุณด้วย ระบบอัตโนมัติ AI

Automatio รวมพลังของ AI agents การอัตโนมัติเว็บ และการผสานรวมอัจฉริยะเพื่อช่วยให้คุณทำงานได้มากขึ้นในเวลาน้อยลง

เคล็ดลับมืออาชีพสำหรับการ Scrape HotPads

คำแนะนำจากผู้เชี่ยวชาญสำหรับการดึงข้อมูลจาก HotPads อย่างประสบความสำเร็จ

ใช้ Residential Proxies

Akamai ตรวจจับ Datacenter IPs ได้ง่ายมาก ดังนั้นการใช้ Residential Proxies จึงเป็นสิ่งจำเป็นสำหรับการสเกลงาน

การ Crawling ผ่าน Sitemap

ใช้ sitemaps ที่พบใน robots.txt เพื่อค้นหา listing URLs แทนการขูดข้อมูลจากหน้าค้นหาบนแผนที่เพื่อหลีกเลี่ยง rate limits

จัดการเรื่อง Stealth

ใช้ปลั๊กอิน stealth เพื่อเลียนแบบ browser fingerprinting ของจริงและก้ามข้ามด่านทดสอบ JavaScript

การสกัดพิกัด

ค่าละติจูดและลองจิจูดมักจะถูกฝังอยู่ใน JSON state ของหน้าเว็บเพื่อใช้สำหรับฟีเจอร์แผนที่

การสุ่มดีเลย์

ใช้เทคนิค jitter (การสุ่มเวลาหน่วง) ระหว่าง requests เพื่อเลียนแบบพฤติกรรมการใช้งานของมนุษย์และหลีกเลี่ยงการถูกจำกัด rate limiting

เน้นช่วงเวลา Off-Peak

ดำเนินการ scrape ในช่วงเวลาที่มีผู้ใช้งานน้อยในสหรัฐอเมริกา เพื่อลดโอกาสที่จะถูกระบบ bot mitigation ฝั่งเซิร์ฟเวอร์ตรวจจับอย่างเข้มงวด

คำรับรอง

ผู้ใช้ของเราพูดอย่างไร

เข้าร่วมกับผู้ใช้ที่พึงพอใจนับพันที่ได้เปลี่ยนแปลงเวิร์กโฟลว์ของพวกเขา

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ที่เกี่ยวข้อง Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Brown Real Estate NC | Fayetteville Property Scraper

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

คำถามที่พบบ่อยเกี่ยวกับ HotPads

ค้นหาคำตอบสำหรับคำถามทั่วไปเกี่ยวกับ HotPads