Як скрейпити Exploit-DB | Веб-скрейпер Exploit Database

Дізнайтеся, як скрейпити Exploit-DB для отримання даних про вразливості, кодів експлуатації та посилань на CVE для досліджень у сфері кібербезпеки та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

- JavaScript-перевірка

- Потребує виконання JavaScript для доступу до контенту. Прості запити не проходять; потрібен headless-браузер, такий як Playwright або Puppeteer.

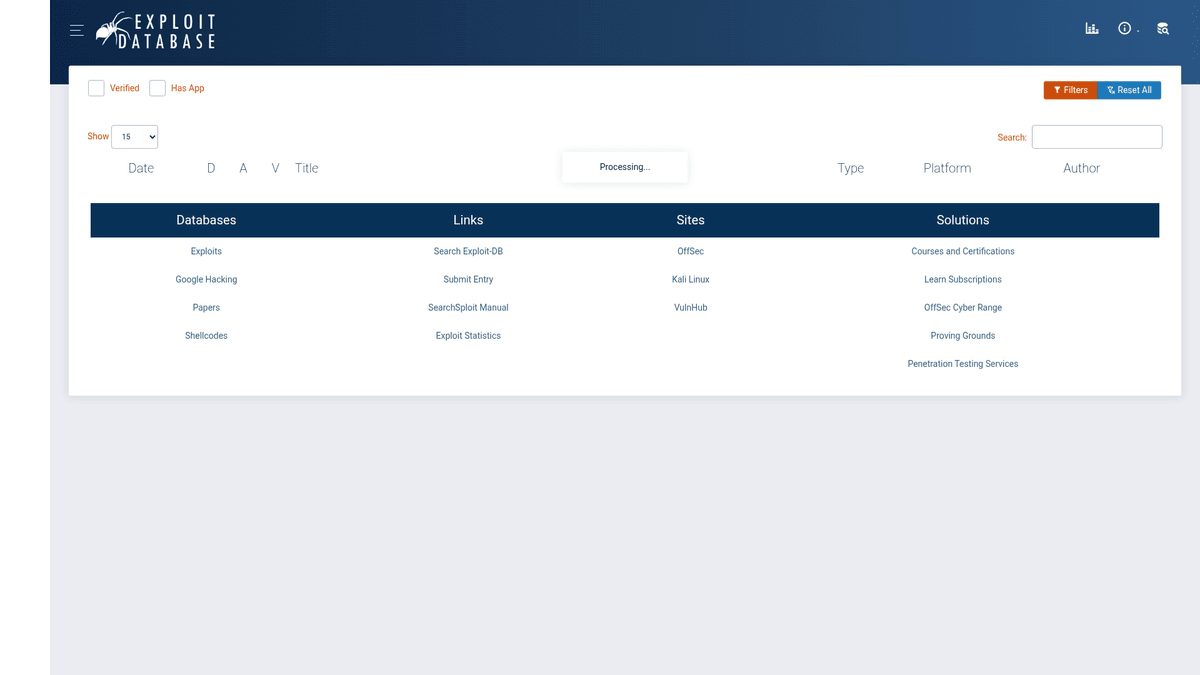

Про Exploit Database

Дізнайтеся, що пропонує Exploit Database та які цінні дані можна витягнути.

Всеосяжний репозиторій вразливостей

Exploit Database (Exploit-DB) — це архів публічних експлуатацій та відповідного вразливого ПЗ, сумісний із CVE, розроблений для використання пентестерами та дослідниками вразливостей. Підтримуваний OffSec (Offensive Security), він слугує центральним хабом для спільноти кібербезпеки, де обмінюються кодом proof-of-concept та результатами досліджень для різних платформ і програм. Цей репозиторій є одним із найнадійніших джерел для професіоналів з безпеки в усьому світі.

Категоризація та глибина даних

Вебсайт організовує дані за детальними категоріями, такими як Remote Exploits, Web Applications, Local Exploits та Shellcodes. Кожен запис зазвичай включає назву експлуатації, дату, автора, платформу, пов'язаний CVE ID та сирий код експлуатації. Такий структурований підхід дозволяє дослідникам швидко перемикатися між різними типами вразливостей та їхнім історичним контекстом.

Стратегічна цінність для операцій з безпеки

Скрейпінг цих даних має велике значення для Security Operations Centers (SOCs) та команд розвідки загроз для кореляції відомих експлуатацій із внутрішніми вразливостями. Автоматизуючи вилучення PoC-коду та метаданих, організації можуть створювати власні сигнатури безпеки, покращувати життєвий цикл управління вразливостями та будувати надійні стрічки threat intelligence.

Чому Варто Парсити Exploit Database?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Exploit Database.

Збір розвідданих про загрози в реальному часі

Синхронізація баз даних вразливостей

Автоматизовані дослідження та розробки у сфері безпеки

Інтеграція зі сканерами вразливостей

Історичний аналіз трендів атак

Створення власних сигнатур безпеки

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Exploit Database.

Агресивний захист Cloudflare, що вимагає розширеного TLS fingerprinting

Динамічне завантаження контенту через AJAX для DataTables

Часте блокування IP при високій частоті запитів

Суворе обмеження швидкості (rate limiting) на завантаження сирого PoC-коду

Складна вкладена структура HTML для деталей експлуатації

Скрапінг Exploit Database за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Exploit Database. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Exploit Database, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Exploit Database без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Exploit Database. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Exploit Database, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Автоматично обробляє виклики Cloudflare та JavaScript

- Виконується нативно для чистого вилучення DataTables

- Заплановані запуски для моніторингу zero-day загроз 24/7

- Інтерфейс без коду (no-code) усуває необхідність підтримки складних методів обходу

- Прямий експорт у структурований JSON для інтеграції з SOC

No-code веб-парсери для Exploit Database

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Exploit Database без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Exploit Database

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Exploit Database без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# Exploit-DB uses Cloudflare; simple requests might be blocked

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Main data is loaded via AJAX, initial HTML is a shell

print('Page Title:', soup.title.text)

except Exception as e:

print(f'Error encountered: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Exploit Database за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# Exploit-DB uses Cloudflare; simple requests might be blocked

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Main data is loaded via AJAX, initial HTML is a shell

print('Page Title:', soup.title.text)

except Exception as e:

print(f'Error encountered: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_exploit_db():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.exploit-db.com/')

# Wait for the DataTables to populate via AJAX

page.wait_for_selector('table#exploits-table')

rows = page.query_selector_all('table#exploits-table tbody tr')

for row in rows[:5]:

print(row.inner_text())

browser.close()

scrape_exploit_db()Python + Scrapy

import scrapy

class ExploitSpider(scrapy.Spider):

name = 'exploit_spider'

start_urls = ['https://www.exploit-db.com/']

def parse(self, response):

# Scrapy needs a JS middleware like scrapy-playwright for this site

for exploit in response.css('table#exploits-table tbody tr'):

yield {

'title': exploit.css('td.title a::text').get(),

'id': exploit.css('td.id::text').get(),

'cve': exploit.css('td.cve a::text').get()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.exploit-db.com/', { waitUntil: 'networkidle2' });

const results = await page.evaluate(() => {

const rows = Array.from(document.querySelectorAll('table#exploits-table tbody tr'));

return rows.map(row => row.innerText);

});

console.log(results.slice(0, 5));

await browser.close();

})();Що Можна Робити З Даними Exploit Database

Досліджуйте практичні застосування та інсайти з даних Exploit Database.

Стрічка розвідки загроз у реальному часі

Створюйте безперервний потік нових експлуатацій, щоб попереджати команди безпеки про виникаючі загрози.

Як реалізувати:

- 1Налаштуйте щоденний запланований скрейпінг головної сторінки

- 2Порівнюйте нові EDB-ID з попередньо зібраними записами

- 3Налаштуйте сповіщення у Slack або електронною поштою про нові критичні експлуатації

Використовуйте Automatio для витягування даних з Exploit Database та створення цих додатків без написання коду.

Що Можна Робити З Даними Exploit Database

- Стрічка розвідки загроз у реальному часі

Створюйте безперервний потік нових експлуатацій, щоб попереджати команди безпеки про виникаючі загрози.

- Налаштуйте щоденний запланований скрейпінг головної сторінки

- Порівнюйте нові EDB-ID з попередньо зібраними записами

- Налаштуйте сповіщення у Slack або електронною поштою про нові критичні експлуатації

- Кореляція вразливостей та патчинг

Допоможіть IT-командам пріоритезувати патчі програмного забезпечення на основі наявності робочого коду експлуатації.

- Витягніть CVE ID та відповідні метадані експлуатацій

- Зіставте їх із внутрішніми списками інвентаризації ПЗ

- Позначте системи з публічно доступними експлуатаціями для негайного встановлення патчів

- Автоматичне створення сигнатур для SIEM

Вилучайте proof-of-concept shellcode для розробки захисних сигнатур виявлення вторгнень.

- Перейдіть на сторінки окремих експлуатацій та зберіть сирий код

- Проаналізуйте код на наявність унікальних байтових патернів або мережевих рядків

- Передайте вилучені патерни в генератори правил для SIEM або IDS/IPS

- Історичний аналіз трендів вразливостей

Аналізуйте дані про експлуатації за десятиліття, щоб зрозуміти, які платформи найчастіше стають цілями з часом.

- Зберіть увесь архів, включаючи дати, платформи та типи

- Агрегуйте дані за платформами та роками

- Візуалізуйте тренди атак за допомогою BI-інструментів, таких як Tableau або PowerBI

- Академічні набори даних з кібербезпеки

Надавайте високоякісні структуровані дані для machine learning моделей, що прогнозують надійність експлуатацій.

- Зберіть дані про верифіковані та неверифіковані експлуатації

- Витягніть вихідний код та атрибути метаданих

- Навчіть моделі класифікувати патерни коду, пов'язані з успішними експлуатаціями

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Exploit Database

Експертні поради для успішного витягування даних з Exploit Database.

Перевірте офіційний репозиторій GitLab для отримання масивів CSV-даних перед початком високонавантаженого скрейпінгу.

Використовуйте headless browser з stealth-плагінами для ефективного проходження перевірок Cloudflare.

Встановіть затримку щонайменше 10–15 секунд між запитами, щоб уникнути IP-блокувань.

Цільтеся в конкретні AJAX-ендпоінти, які сайт використовує для своїх DataTables, щоб отримати чистіший JSON-вивід.

Використовуйте високоякісні резидентні проксі, щоб імітувати легітимний трафік дослідників безпеки.

Очищуйте та нормалізуйте CVE IDs одразу після вилучення для забезпечення цілісності бази даних.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Часті запитання про Exploit Database

Знайдіть відповіді на поширені запитання про Exploit Database