Як скрапити Goodreads: Повний посібник із web scraping 2025

Дізнайтеся, як скрапити Goodreads для отримання даних про книги, відгуків та рейтингів у 2025 році. Посібник охоплює обхід anti-bot, приклади коду на Python та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- DataDome

- Виявлення ботів у реальному часі з ML-моделями. Аналізує цифровий відбиток пристрою, мережеві сигнали та патерни поведінки. Поширений на сайтах електронної комерції.

- Google reCAPTCHA

- Система CAPTCHA від Google. v2 потребує взаємодії користувача, v3 працює приховано з оцінкою ризиків. Можна вирішити за допомогою сервісів CAPTCHA.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Блокування IP

- Блокує відомі IP дата-центрів та позначені адреси. Потребує резидентних або мобільних проксі для ефективного обходу.

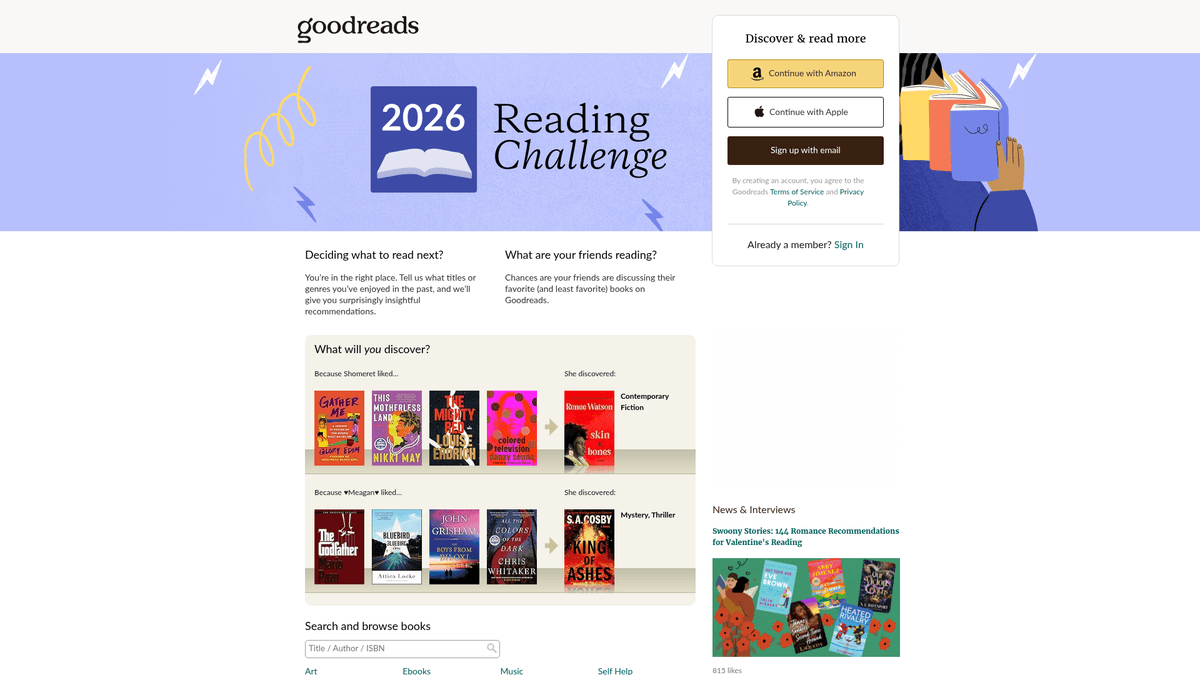

Про Goodreads

Дізнайтеся, що пропонує Goodreads та які цінні дані можна витягнути.

Найбільша у світі соціальна платформа для каталогізації книг

Goodreads — це провідна соціальна мережа для книголюбів, що належить і керується компанією Amazon. Вона слугує величезним сховищем літературних даних, що містить мільйони списків книг, відгуків користувачів, анотацій та списків для читання. Платформа організована за жанрами та користувацькими «полицями», що забезпечує глибоке розуміння глобальних читацьких звичок та літературних тенденцій.

Скарбниця літературних даних

Платформа містить детальні дані, включаючи ISBNs, жанри, бібліографії авторів та детальні настрої читачів. Для бізнесу та дослідників ці дані пропонують глибокий аналіз ринкових трендів та споживчих уподобань. Дані, отримані через web scraping з Goodreads, є безцінними для видавців, авторів та науковців для проведення конкурентного аналізу та виявлення нових літературних прийомів.

Навіщо скрапити дані Goodreads?

Скрапінг цього сайту забезпечує доступ до метрик популярності в реальному часі, конкурентного аналізу для авторів та високоякісних наборів даних для навчання recommendation systems або проведення академічних досліджень у гуманітарних сферах. Це дозволяє користувачам шукати у величезній базі даних, відстежуючи прогрес читання, і пропонує унікальний погляд на те, як різні демографічні групи взаємодіють із книгами.

Чому Варто Парсити Goodreads?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Goodreads.

Проведення досліджень ринку для виявлення тенденцій у видавничій галузі

Аналіз тональності (sentiment analysis) відгуків читачів

Моніторинг популярності трендових видань у реальному часі

Створення просунутих рекомендаційних систем на основі патернів додавання на полиці

Агрегація метаданих для академічних та культурних досліджень

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Goodreads.

Агресивні системи захисту від bot-запитів Cloudflare та DataDome

Велика залежність від JavaScript для рендерингу сучасного інтерфейсу

Невідповідність UI між застарілими та новими сторінками на базі React

Суворий rate limiting, що вимагає складного механізму rotation для proxy

Скрапінг Goodreads за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Goodreads. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Goodreads, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Goodreads без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Goodreads. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Goodreads, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Створення складних скраперів для книг без написання коду

- Автоматична обробка Cloudflare та anti-bot систем

- Хмарне виконання для витягування великих обсягів даних

- Заплановані запуски для щоденного моніторингу змін у рейтингах

- Легка обробка динамічного контенту та нескінченної прокрутки (infinite scroll)

No-code веб-парсери для Goodreads

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Goodreads без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Goodreads

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Goodreads без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Goodreads за допомогою коду

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Launching a browser is necessary for Cloudflare/JS pages

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Wait for the specific data attribute to render

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Target the schema.org markup for more stable selectors

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Standard pagination handling

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads uses modern JS, so we wait for specific components

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();Що Можна Робити З Даними Goodreads

Досліджуйте практичні застосування та інсайти з даних Goodreads.

Прогностичний аналіз бестселерів

Видавці аналізують тональність ранніх відгуків та швидкість додавання на полиці, щоб передбачити майбутні хіти.

Як реалізувати:

- 1Моніторинг лічильників 'Want to Read' для майбутніх книг.

- 2Скрапінг ранніх відгуків Advance Reader Copy (ARC).

- 3Порівняння настроїв із історичними даними про бестселери.

Використовуйте Automatio для витягування даних з Goodreads та створення цих додатків без написання коду.

Що Можна Робити З Даними Goodreads

- Прогностичний аналіз бестселерів

Видавці аналізують тональність ранніх відгуків та швидкість додавання на полиці, щоб передбачити майбутні хіти.

- Моніторинг лічильників 'Want to Read' для майбутніх книг.

- Скрапінг ранніх відгуків Advance Reader Copy (ARC).

- Порівняння настроїв із історичними даними про бестселери.

- Конкурентна розвідка для авторів

Автори відстежують жанрові тренди та динаміку рейтингів, щоб оптимізувати власну творчість та маркетинг.

- Скрапінг найбільш рейтингових книг на полиці конкретного жанру.

- Витяг рекурентних тропів (сюжетних ходів) із відгуків читачів.

- Аналіз динаміки рейтингу після маркетингових кампаній.

- Нішеві рекомендаційні системи

Розробники створюють інструменти для пошуку книг за специфічними складними критеріями, які не підтримуються основним сайтом.

- Скрапінг тегів користувачів та їх перехресна перевірка.

- Картографування рейтингів для пошуку унікальних кореляцій між авторами.

- Виведення результатів через API у веб-додаток.

- Фільтрація книг на основі настроїв

Дослідники використовують NLP для аналізу відгуків, щоб класифікувати книги на основі емоційного впливу, а не лише за жанром.

- Витяг тисяч відгуків користувачів для певної категорії.

- Запуск аналізу тональності та витяг ключових слів.

- Побудова датасету для machine learning model.

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Goodreads

Експертні поради для успішного витягування даних з Goodreads.

Завжди використовуйте residential proxies, щоб обійти блокування Cloudflare 403.

Орієнтуйтеся на стабільні атрибути data-testid, а не на рандомізовані імена класів CSS.

Парсіть тег сценарію __NEXT_DATA__ JSON для надійного витягування метаданих.

Впроваджуйте випадкові затримки від 3 до 7 секунд, щоб імітувати поведінку людини в браузері.

Виконуйте web scraping у години мінімального навантаження, щоб зменшити ризик спрацювання rate limits.

Стежте за змінами UI між застарілими сторінками PHP та новим макетом на базі React.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

Часті запитання про Goodreads

Знайдіть відповіді на поширені запитання про Goodreads