Як скрапити jup.ag: посібник із веб-скрапінгу Jupiter DEX

Дізнайтеся, як скрапити jup.ag для отримання цін на tokens Solana, маршрутів swap та обсягів ринку в реальному часі. Використовуйте офіційні API Jupiter та...

Виявлено захист від ботів

- Cloudflare

- Корпоративний WAF та управління ботами. Використовує JavaScript-перевірки, CAPTCHA та аналіз поведінки. Потребує автоматизації браузера з прихованими налаштуваннями.

- Обмеження частоти запитів

- Обмежує кількість запитів на IP/сесію за час. Можна обійти за допомогою ротації проксі, затримок запитів та розподіленого скрапінгу.

- Цифровий відбиток браузера

- Ідентифікує ботів за характеристиками браузера: canvas, WebGL, шрифти, плагіни. Потребує підміни або реальних профілів браузера.

- Цифровий відбиток браузера

- Ідентифікує ботів за характеристиками браузера: canvas, WebGL, шрифти, плагіни. Потребує підміни або реальних профілів браузера.

Про Jupiter

Дізнайтеся, що пропонує Jupiter та які цінні дані можна витягнути.

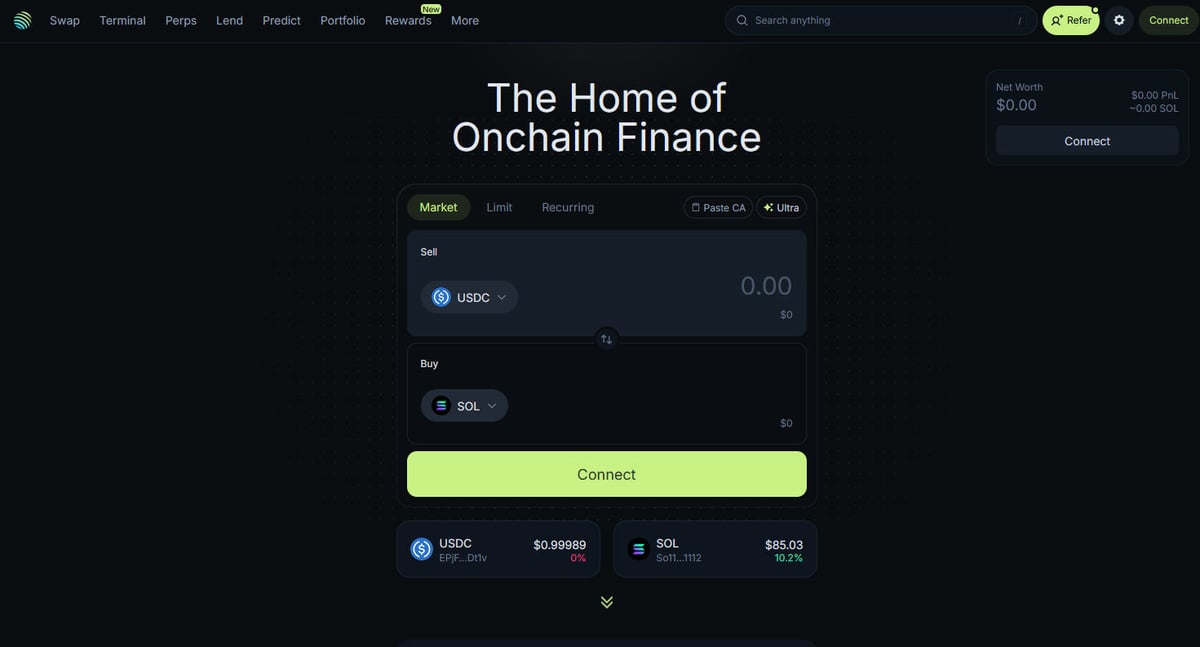

Центр DeFi на Solana

Jupiter — це основний агрегатор ліквідності для блокчейну Solana, що діє як «DeFi Superapp», який оптимізує маршрутизацію угод через сотні пулів ліквідності, щоб забезпечити користувачам найкращі ціни та мінімальне проковзування. Це центральний хаб для on-chain фінансів Solana, що пропонує послуги від простого swap tokens до розширених функцій, таких як торгівля perpetual з кредитним плечем до 250x, лімітні ордери та стратегії DCA. Платформа надає критично важливі дані для екосистеми, включаючи ціни в реальному часі, глибину ліквідності та вичерпні ринкові метрики для тисяч активів.

Технічна архітектура

Веб-сайт побудований на сучасному технічному стеку з використанням Next.js та React, що робить його динамічним односторінковим додатком (SPA). Оскільки ціни та маршрути розраховуються в реальному часі на основі поточного стану блокчейну, фронтенд постійно оновлюється через WebSockets та високочастотні виклики API. Для фахівців із даних, розробників і трейдерів дані Jupiter вважаються золотим стандартом для відстеження настроїв ринку Solana та зміни ліквідності в усій екосистемі.

Чому ці дані важливі

Доступ до цих даних необхідний для створення торгових ботів, ринкових дашбордів та проведення історичного аналізу в одній із найбільш швидкозростаючих блокчейн-мереж. Скрапери часто націлені на Jupiter для моніторингу нових лістингів tokens, відстеження рухів «китів» на ринках perpetual або виявлення цінових розбіжностей для арбітражу. Хоча платформа пропонує офіційні API, прямий веб-скрапінг часто використовується для фіксації точного стану UI та специфічних даних маршрутизації, які можуть бути не повністю представлені в публічних ендпоінтах.

Чому Варто Парсити Jupiter?

Дізнайтеся про бізнес-цінність та сценарії використання для витягування даних з Jupiter.

Моніторинг цін на tokens Solana в реальному часі

Розробка арбітражних торгових ботів між DEX

Відстеження тенденцій обсягу ринку та ліквідності

Виявлення нових лістингів tokens та ринкових настроїв

Агрегація доходності кредитування та ставок фінансування perpetual

Аналіз історичного впливу ціни для великих угод

Виклики Парсингу

Технічні виклики, з якими ви можете зіткнутися при парсингу Jupiter.

Агресивний захист Cloudflare від ботів

Вимога повного рендерингу JavaScript (React/Next.js)

Суворе обмеження частоти запитів за IP на публічних ендпоінтах

Динамічні та обфусковані селектори CSS в інтерфейсі

Високошвидкісні оновлення даних, що потребують з'єднань із низькою latency

Скрапінг Jupiter за допомогою ШІ

Без коду. Витягуйте дані за лічені хвилини з автоматизацією на базі ШІ.

Як це працює

Опишіть, що вам потрібно

Скажіть ШІ, які дані ви хочете витягнути з Jupiter. Просто напишіть звичайною мовою — без коду чи селекторів.

ШІ витягує дані

Наш штучний інтелект навігує по Jupiter, обробляє динамічний контент і витягує саме те, що ви запросили.

Отримайте свої дані

Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Чому варто використовувати ШІ для скрапінгу

ШІ спрощує скрапінг Jupiter без написання коду. Наша платформа на базі штучного інтелекту розуміє, які дані вам потрібні — просто опишіть їх звичайною мовою, і ШІ витягне їх автоматично.

How to scrape with AI:

- Опишіть, що вам потрібно: Скажіть ШІ, які дані ви хочете витягнути з Jupiter. Просто напишіть звичайною мовою — без коду чи селекторів.

- ШІ витягує дані: Наш штучний інтелект навігує по Jupiter, обробляє динамічний контент і витягує саме те, що ви запросили.

- Отримайте свої дані: Отримайте чисті, структуровані дані, готові до експорту в CSV, JSON або відправки безпосередньо у ваші додатки.

Why use AI for scraping:

- Вилучення даних без коду з динамічних SPA

- Автоматична обробка Cloudflare та відбитків браузера

- Заплановане вилучення для безперервного моніторингу ринку

- Прямий експорт даних у Webhooks або Google Sheets

No-code веб-парсери для Jupiter

Альтернативи point-and-click до AI-парсингу

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Jupiter без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

Типові виклики

Крива навчання

Розуміння селекторів та логіки вилучення потребує часу

Селектори ламаються

Зміни на вебсайті можуть зламати весь робочий процес

Проблеми з динамічним контентом

Сайти з великою кількістю JavaScript потребують складних рішень

Обмеження CAPTCHA

Більшість інструментів потребує ручного втручання для CAPTCHA

Блокування IP

Агресивний парсинг може призвести до блокування вашої IP

No-code веб-парсери для Jupiter

Кілька no-code інструментів, таких як Browse.ai, Octoparse, Axiom та ParseHub, можуть допомогти вам парсити Jupiter без написання коду. Ці інструменти зазвичай використовують візуальні інтерфейси для вибору даних, хоча можуть мати проблеми зі складним динамічним контентом чи anti-bot заходами.

Типовий робочий процес з no-code інструментами

- Встановіть розширення браузера або зареєструйтесь на платформі

- Перейдіть на цільовий вебсайт і відкрийте інструмент

- Виберіть елементи даних для вилучення методом point-and-click

- Налаштуйте CSS-селектори для кожного поля даних

- Налаштуйте правила пагінації для парсингу кількох сторінок

- Обробіть CAPTCHA (часто потрібне ручне розв'язання)

- Налаштуйте розклад для автоматичних запусків

- Експортуйте дані в CSV, JSON або підключіть через API

Типові виклики

- Крива навчання: Розуміння селекторів та логіки вилучення потребує часу

- Селектори ламаються: Зміни на вебсайті можуть зламати весь робочий процес

- Проблеми з динамічним контентом: Сайти з великою кількістю JavaScript потребують складних рішень

- Обмеження CAPTCHA: Більшість інструментів потребує ручного втручання для CAPTCHA

- Блокування IP: Агресивний парсинг може призвести до блокування вашої IP

Приклади коду

import requests

def get_jupiter_price(token_address):

# Використання офіційного Jupiter Price API V2 — найнадійніший метод

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Ціна: ${price_info['price']}")

except Exception as e:

print(f"Виникла помилка: {e}")

# Приклад: Отримання ціни SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Коли використовувати

Найкраще для статичних HTML-сторінок з мінімумом JavaScript. Ідеально для блогів, новинних сайтів та простих сторінок товарів e-commerce.

Переваги

- ●Найшвидше виконання (без навантаження браузера)

- ●Найменше споживання ресурсів

- ●Легко розпаралелити з asyncio

- ●Чудово для API та статичних сторінок

Обмеження

- ●Не може виконувати JavaScript

- ●Не працює на SPA та динамічному контенті

- ●Може мати проблеми зі складними anti-bot системами

Як парсити Jupiter за допомогою коду

Python + Requests

import requests

def get_jupiter_price(token_address):

# Використання офіційного Jupiter Price API V2 — найнадійніший метод

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Ціна: ${price_info['price']}")

except Exception as e:

print(f"Виникла помилка: {e}")

# Приклад: Отримання ціни SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Запуск браузера для рендерингу Next.js фронтенду

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Очікування рендерингу елементів списку токенів у DOM

# Примітка: Селектори мають бути оновлені відповідно до поточної збірки UI

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Пряме звернення до JSON-ендпоінту списку токенів, який використовує фронтенд

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Відповідь — це необроблений список JSON усіх верифікованих токенів

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Встановлення реалістичного User-Agent для обходу базових фільтрів

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Перехід на головну сторінку swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Приклад вилучення елемента ціни за допомогою часткового селектора

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Ціну не знайдено';

});

console.log(`Поточна ціна SOL в UI: ${solPrice}`);

await browser.close();

})();Що Можна Робити З Даними Jupiter

Досліджуйте практичні застосування та інсайти з даних Jupiter.

Система сповіщень про ціновий арбітраж

Виявляйте різницю в цінах між Jupiter та іншими Solana DEX для виконання прибуткових угод.

Як реалізувати:

- 1Збирайте курси swap у реальному часі через Price API Jupiter.

- 2Порівнюйте курси з пулами ліквідності Orca та Raydium.

- 3Налаштуйте автоматичні сповіщення або хуки для виконання арбітражних угод.

Використовуйте Automatio для витягування даних з Jupiter та створення цих додатків без написання коду.

Що Можна Робити З Даними Jupiter

- Система сповіщень про ціновий арбітраж

Виявляйте різницю в цінах між Jupiter та іншими Solana DEX для виконання прибуткових угод.

- Збирайте курси swap у реальному часі через Price API Jupiter.

- Порівнюйте курси з пулами ліквідності Orca та Raydium.

- Налаштуйте автоматичні сповіщення або хуки для виконання арбітражних угод.

- Дашборд стану ринку Solana

Створюйте макроогляд активності DeFi на Solana для інвесторів.

- Агрегуйте дані про 24-годинний обсяг і TVL для топових tokens.

- Класифікуйте tokens за секторами (Meme, AI, RWA).

- Візуалізуйте зміни ліквідності в різних класах активів з часом.

- Снайпер нових лістингів tokens

Миттєво виявляйте та аналізуйте нові tokens, що з'являються у верифікованому списку Jupiter.

- Регулярно скрапте ендпоінт списку tokens.

- Порівнюйте нові результати з локальною базою даних, щоб знайти нові додавання.

- Аналізуйте початкову ліквідність та обсяг для оцінки потенціалу token.

- Трекер «китів» та Perps

Моніторте великі позиції та ставки фінансування на ринку Jupiter Perpetuals.

- Збирайте дані про відкритий інтерес та ставки фінансування з розділу Perps.

- Відстежуйте логи великих транзакцій для ідентифікації поведінки гаманців.

- Будуйте моделі настроїв на основі співвідношення long/short позицій для основних активів.

- Сервіс агрегації доходності

Надавайте користувачам найкращі доступні ставки кредитування у сховищах Jupiter Lend.

- Скрапте дані APY для різних стейблкоїнів та пар із SOL.

- Розраховуйте чисту прибутковість після вирахування комісій платформи.

- Автоматизуйте рекомендації щодо ребалансування для оптимізації портфеля.

Прискорте вашу роботу з AI-автоматизацією

Automatio поєднує силу AI-агентів, веб-автоматизації та розумних інтеграцій, щоб допомогти вам досягти більшого за менший час.

Професійні Поради Щодо Парсингу Jupiter

Експертні поради для успішного витягування даних з Jupiter.

Завжди віддавайте пріоритет офіційному API на api.jup.ag перед спробами скрапити HTML-фронтенд.

Використовуйте residential proxies, щоб мінімізувати блокування Cloudflare, оскільки IP-адреси дата-центрів часто вносяться до чорних списків.

Увімкніть HTTP2 у своєму скрапері, щоб відповідати стандартним відбиткам браузера та уникати виявлення.

Перевіряйте з'єднання WebSocket (wss

//) на вкладці мережі для найбільш ефективного стрімінгу цін у реальному часі.

Впроваджуйте надійну обробку помилок для відповідей 403 Forbidden, які вказують на блокування Cloudflare.

Використовуйте ендпоінт https

//token.jup.ag/all, якщо вам потрібен лише статичний список верифікованих адрес tokens.

Відгуки

Що кажуть наші користувачі

Приєднуйтесь до тисяч задоволених користувачів, які трансформували свою роботу

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Пов'язані Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Часті запитання про Jupiter

Знайдіть відповіді на поширені запитання про Jupiter