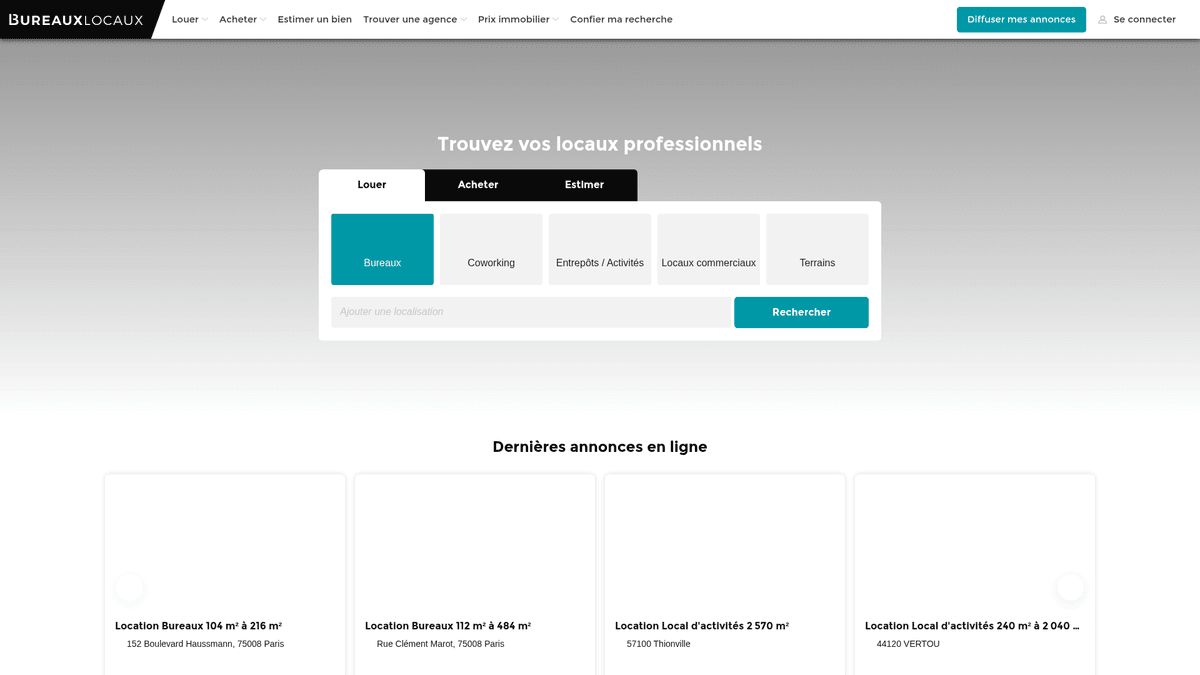

كيفية عمل scrape لموقع BureauxLocaux: دليل بيانات العقارات التجارية

استخرج بيانات العقارات التجارية من BureauxLocaux. قم بعمل scrape لأسعار المكاتب، ومواقع المستودعات، وتفاصيل الوكلاء في جميع أنحاء فرنسا لأبحاث السوق.

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- CSRF Protection

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- User-Agent Filtering

- تحدي JavaScript

- يتطلب تنفيذ JavaScript للوصول إلى المحتوى. الطلبات البسيطة تفشل؛ يلزم متصفح بدون واجهة مثل Playwright أو Puppeteer.

حول BureauxLocaux

اكتشف ما يقدمه BureauxLocaux وما هي البيانات القيمة التي يمكن استخراجها.

سوق العقارات المهنية الرائد في فرنسا

يعد BureauxLocaux المنصة الرقمية الأولى في فرنسا المخصصة للعقارات المهنية، حيث يسهل تأجير وبيع المكاتب والمستودعات والمساحات التجارية ومراكز العمل المشترك (coworking). المنصة مملوكة لـ CoStar Group، وتجمع البيانات من أكثر من 1800 وكالة متخصصة وتستضيف أكثر من 72,000 قائمة نشطة، مما يجعلها مصدراً نهائياً لرؤى العقارات B2B.

ذكاء سوق شامل

توفر المنصة رؤية تفصيلية للمشهد التجاري الفرنسي، بدءاً من مناطق الأعمال الباريسية ذات الطلب المرتفع إلى المراكز اللوجستية في ليون ومارسيليا. وهي تعمل كجسر حيوي بين الباحثين عن العقارات والوسطاء المتخصصين، وتوفر مواصفات فنية مفصلة تتجاوز مجرد نقاط السعر.

لماذا تهمنا هذه البيانات؟

يعد عمل scrape لموقع BureauxLocaux أمراً ضرورياً لمطوري العقارات والمستثمرين والمخططين الحضريين. توفر قوائم المنصة بيانات في الوقت الفعلي عن اتجاهات أسعار الإيجار، ومعدلات الشغور، وتصنيفات أداء الطاقة (DPE)، وهي عوامل حاسمة لبناء نماذج سوق تنبؤية وتحديد فرص الاستثمار عالية العائد.

لماذا تجريد BureauxLocaux؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من BureauxLocaux.

مراقبة تقلبات أسعار الإيجارات التجارية في المدن الكبرى الفرنسية

قياس المحفظة والحصة السوقية للوكالات العقارية المتخصصة

تحديد العملاء المحتملين ذوي الإمكانيات العالية لخدمات تجديد وتجهيز المكاتب

تتبع معدلات شغور المستودعات الصناعية للتخطيط اللوجستي

تحليل نمو مساحات العمل المشترك مقابل عقود إيجار المكاتب التقليدية

جمع بيانات التدريب لنماذج AI الخاصة بتقييم العقارات

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد BureauxLocaux.

تجاوز إدارة البوتات الهجومية من Cloudflare وتحديات JS

استخراج المحتوى الديناميكي الذي يتم تحميله عبر طلبات AJAX الداخلية

التعامل مع CSRF tokens المطلوبة للوصول إلى معلومات الاتصال التفصيلية للوكلاء

توحيد تنسيقات بيانات الأسعار المجزأة (م2/سنة مقابل تكاليف محطة العمل الشهرية)

التكيف مع التغييرات المتكررة في بنية شبكة سمات العقارات

استخرج بيانات BureauxLocaux بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من BureauxLocaux. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح BureauxLocaux، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات BureauxLocaux سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من BureauxLocaux. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح BureauxLocaux، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- يتجاوز أمان Cloudflare بسلاسة دون الحاجة إلى برمجة مخصصة

- يتعامل مع JavaScript rendering تلقائياً لشبكات القوائم الديناميكية

- تسمح عمليات التشغيل المجدولة بمراقبة السوق والتنبيه تلقائياً يومياً

- يستخدم premium residential proxies لتجنب تحديد معدل الطلبات القائم على IP

- المحدد البصري (Visual selector) يسهل استهداف المواصفات الفنية المعقدة للعقارات

أدوات تجريد الويب بدون كود لـBureauxLocaux

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد BureauxLocaux بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـBureauxLocaux

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد BureauxLocaux بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# ملاحظة: قد يتم حظر هذا بواسطة Cloudflare بدون headers أو بروكيسيات متقدمة

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# مثال: اختيار بطاقات القوائم

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'فشل الـ Scraping: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات BureauxLocaux بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# ملاحظة: قد يتم حظر هذا بواسطة Cloudflare بدون headers أو بروكيسيات متقدمة

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# مثال: اختيار بطاقات القوائم

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'فشل الـ Scraping: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# يوصى بالتشغيل مع وضع التخفي أو UA محدد

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# الانتقال إلى نتائج البحث

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# انتظار تحميل القوائم

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "اتصل بالوكيل"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# التكرار عبر كل بطاقة عقار في الصفحة

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# التنقل بين الصفحات: البحث عن رابط الصفحة التالية

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// تعيين User-Agent واقعي

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// استخراج البيانات من عناصر القوائم

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات BureauxLocaux

استكشف التطبيقات العملية والرؤى من بيانات BureauxLocaux.

فهرسة إيجارات العقارات التجارية

يمكن للمحللين الماليين بناء مؤشر ديناميكي لتكاليف تأجير المكاتب لتقديم المشورة لعملاء الشركات بشأن استراتيجية الموقع.

كيفية التنفيذ:

- 1قم بعمل scrape لجميع قوائم المكاتب النشطة في المدن الفرنسية الكبرى أسبوعياً.

- 2احسب سعر المتر المربع سنوياً لكل مدخل.

- 3قم بتجميع البيانات حسب الحي (Arrondissement) لتحديد تجمعات الأسعار.

- 4قم بتمثيل 'خريطة السعر الحرارية' مرئياً باستخدام أداة رسم خرائط مثل Tableau.

استخدم Automatio لاستخراج البيانات من BureauxLocaux وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات BureauxLocaux

- فهرسة إيجارات العقارات التجارية

يمكن للمحللين الماليين بناء مؤشر ديناميكي لتكاليف تأجير المكاتب لتقديم المشورة لعملاء الشركات بشأن استراتيجية الموقع.

- قم بعمل scrape لجميع قوائم المكاتب النشطة في المدن الفرنسية الكبرى أسبوعياً.

- احسب سعر المتر المربع سنوياً لكل مدخل.

- قم بتجميع البيانات حسب الحي (Arrondissement) لتحديد تجمعات الأسعار.

- قم بتمثيل 'خريطة السعر الحرارية' مرئياً باستخدام أداة رسم خرائط مثل Tableau.

- توليد العملاء المحتملين (Lead Gen) للعقارات

يمكن لمقدمي خدمات B2B العثور على الشركات التي تنتقل إلى مساحات جديدة والتي تتطلب إعداد تكنولوجيا المعلومات أو الأثاث أو التأمين.

- استهدف القوائم التي تحمل علامة 'متاحة حديثاً' أو 'جديدة في السوق'.

- استخرج تفاصيل الاتصال بوكالة القائمة للتواصل من أجل الشراكة.

- تتبع إزالة العقارات لتقدير متى نجحت شركة ما في توقيع عقد إيجار.

- قم بأتمتة إدخال CRM لمشاريع تجديد المكاتب الجديدة المحتملة.

- تتبع مدة الشغور

يمكن للباحثين الاقتصاديين مراقبة المدة التي تظل فيها العقارات الصناعية في السوق لتقييم الصحة الاقتصادية المحلية.

- قم بعمل scrape لجميع قوائم المستودعات وتخزين تاريخ 'أول ظهور' لها.

- تحقق باستمرار من القوائم التي لا تزال نشطة مقابل تلك التي تم حذفها.

- احسب متوسط 'الوقت في السوق' (ToM) لكل منطقة صناعية.

- اربط بين ارتفاع ToM وبين فترات الركود الاقتصادي الإقليمي المحدد.

- أتمتة فلاتر الاستثمار

يمكن للمستثمرين تلقي تنبيهات فورية عندما تنخفض أسعار العقارات عن حد معين في مناطق محددة.

- قم بإعداد عملية scrape يومية لفئات محددة مثل 'Vente de Bureaux' (بيع مكاتب).

- قارن السعر اليومي بالمتوسط التاريخي لهذا الرمز البريدي المحدد.

- أرسل إشعاراً إذا تم تسعير العقار بأقل بنسبة 15% من متوسط السوق.

- قم بتصدير الصفقات التي تمت تصفيتها إلى Google Sheet للمراجعة الفورية.

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد BureauxLocaux

نصائح الخبراء لاستخراج البيانات بنجاح من BureauxLocaux.

استخدم residential proxies عالية الجودة من فرنسا تحديداً لتجنب الحظر الجغرافي.

ضع في اعتبارك دائماً مصطلحات 'HT' (بدون ضرائب) و 'HC' (بدون رسوم) في أدوات تحليل الأسعار (parsers) لتجنب انحراف البيانات.

راقب علامة تبويب 'Network' للعثور على نقاط نهاية JSON الداخلية المستخدمة للتحميل الديناميكي.

قم بتدوير User-Agents و browser fingerprints لمنع الاكتشاف بواسطة التحليل السلوكي لـ Cloudflare.

قم بتنفيذ فاصل زمني عشوائي للنوم (3-10 ثوانٍ) بين تحميل الصفحات لمحاكاة سلوك المستخدم البشري.

قم بتخزين Listing Reference ID كمفتاح فريد لتتبع تغيرات الأسعار بمرور الوقت دون تكرار السجلات.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

الأسئلة الشائعة حول BureauxLocaux

ابحث عن إجابات للأسئلة الشائعة حول BureauxLocaux