كيفية كشط بيانات Hugging Face: الدليل التقني الكامل

احترف كشط بيانات Hugging Face لاستخراج الـ models والـ datasets و metadata الخاصة بالـ AI. تعلم كيفية تجاوز حماية Cloudflare وأتمتة جمع البيانات لأبحاث سوق الـ...

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- Bot Detection

حول Hugging Face

اكتشف ما يقدمه Hugging Face وما هي البيانات القيمة التي يمكن استخراجها.

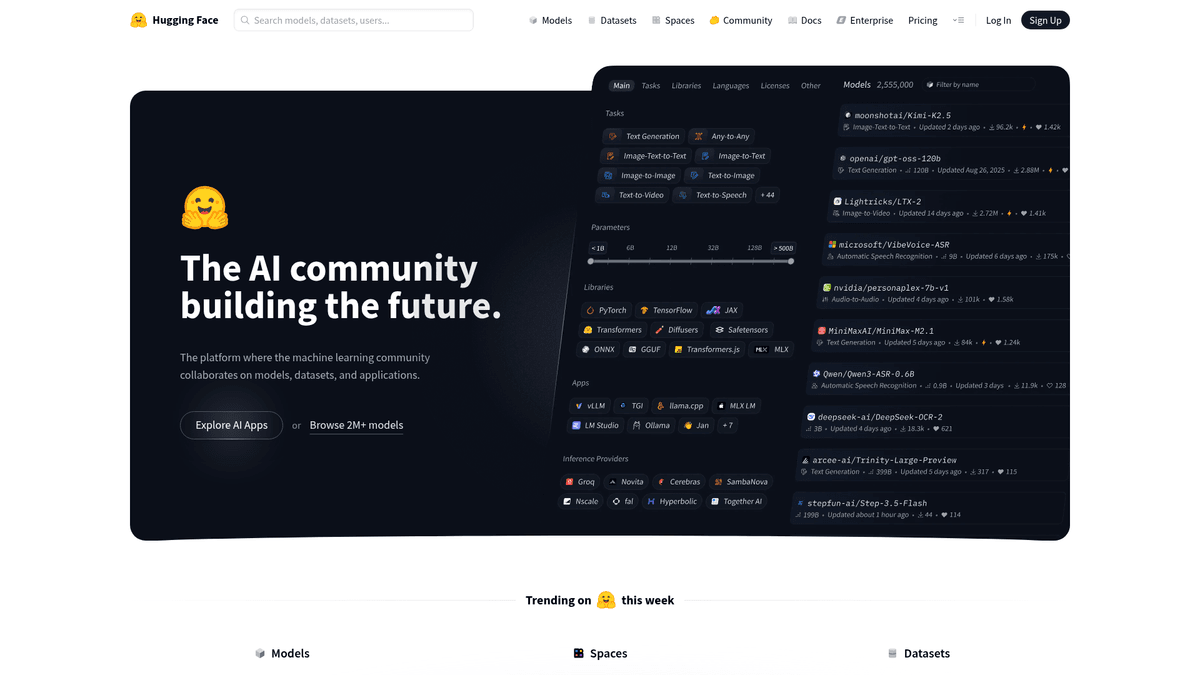

تعد Hugging Face المنصة والمجتمع الرائد في مجالات machine learning و artificial intelligence، وغالباً ما توصف بأنها GitHub الخاص بالـ AI. توفر المنصة مركزاً رئيسياً حيث يشارك الباحثون والمطورون الـ models والـ datasets وتطبيقات الديمو المعروفة باسم Spaces، ويتعاونون فيها. كما تستضيف مساهمات من كيانات تقنية كبرى مثل Google و Meta و Microsoft، جنباً إلى جنب مع مجتمع ضخم من المطورين المستقلين. تحتوي المنصة على مجموعة واسعة من البيانات المنظمة، بما في ذلك مقاييس أداء الـ model، وإعدادات الـ dataset، وسجلات نشاط المستخدمين، ومعلومات توافق المكتبات.

يعتبر كشط بيانات Hugging Face ذا قيمة عالية للمؤسسات التي تسعى لإجراء استخبارات تنافسية، أو تتبع تبني أطر عمل AI معينة، أو تجميع metadata للبحوث الأكاديمية. من خلال استخراج البيانات من المنصة، يمكن للمستخدمين مراقبة الـ models الرائجة، وتحديد كبار المساهمين، والبقاء على اطلاع بالمشهد المتطور بسرعة لـ generative AI. تنظم المنصة المحتوى حسب المهام مثل Natural Language Processing (NLP) و Computer Vision و Audio، مما يجعلها مستودعاً حيوياً لأحدث ما توصل إليه العلم (state-of-the-art) في machine learning.

لماذا تجريد Hugging Face؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Hugging Face.

إجراء أبحاث السوق على الـ models وأطر عمل الـ AI الأكثر شعبية.

إجراء تحليل تنافسي من خلال تتبع إصدارات الـ model من مؤسسات محددة.

تجميع metadata للدراسات الأكاديمية حول تطور الـ AI مفتوح المصدر open-source.

مراقبة الـ datasets الجديدة لصناعات محددة مثل الرعاية الصحية أو التمويل.

بناء دليل لخبراء الـ AI وفرق البحث عالية الأداء.

تحديد التوجهات الناشئة في بنية architectures الخاصة بـ machine learning models.

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Hugging Face.

يعتمد الموقع بشكل كبير على JavaScript rendering لتحميل نتائج البحث وقوائم الـ model.

يمكن لحماية Cloudflare حظر الطلبات الآلية التي لا تحاكي سلوك المتصفح الحقيقي.

تطبق Hugging Face قيوداً صارمة على معدل الطلبات، خاصة عند الوصول إلى Hub API.

هيكل الصفحة لبطاقات الـ Model وملفات Readme ديناميكي ويختلف بشكل كبير.

التغييرات المتكررة في واجهة المستخدم (UI) يمكن أن تؤدي إلى تعطل أدوات الكشط القائمة على CSS دون سابق إنذار.

استخرج بيانات Hugging Face بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Hugging Face. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Hugging Face، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Hugging Face سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Hugging Face. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Hugging Face، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- واجهة بدون كود (No-code) تسمح ببناء كاشطات للـ models والـ datasets بدون خبرة تقنية.

- يتعامل مع المحتوى الديناميكي و JavaScript rendering تلقائياً دون الحاجة لإعدادات إضافية.

- التنفيذ القائم على السحابة يضمن تشغيل مهام الكشط بموثوقية دون استهلاك موارد الجهاز المحلي.

- ميزات مدمجة للتعامل مع الترقيم (pagination) واختيار العناصر المعقدة بفعالية.

- تصدير metadata المستخرجة بسهولة مباشرة إلى Google Sheets أو CSV أو عبر API.

أدوات تجريد الويب بدون كود لـHugging Face

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Hugging Face بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـHugging Face

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Hugging Face بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

url = 'https://huggingface.co/models?sort=downloads'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting model articles

models = soup.find_all('article')

for model in models:

name = model.find('h4').text.strip()

print(f'Model Name: {name}')

except Exception as e:

print(f'Error occurred: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Hugging Face بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://huggingface.co/models?sort=downloads'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting model articles

models = soup.find_all('article')

for model in models:

name = model.find('h4').text.strip()

print(f'Model Name: {name}')

except Exception as e:

print(f'Error occurred: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_hf():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://huggingface.co/models')

# Wait for model list to render

page.wait_for_selector('article')

models = page.query_selector_all('article h4')

for m in models:

print(m.inner_text())

browser.close()

scrape_hf()Python + Scrapy

import scrapy

class HuggingFaceSpider(scrapy.Spider):

name = 'hf_spider'

start_urls = ['https://huggingface.co/models']

def parse(self, response):

for model in response.css('article'):

yield {

'title': model.css('h4::text').get(),

'author': model.css('span.text-gray-400::text').get()

}

# Handle pagination

next_page = response.css('a[aria-label="Next"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://huggingface.co/models');

// Wait for the dynamic content to load

await page.waitForSelector('article');

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('article h4')).map(h => h.innerText);

});

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات Hugging Face

استكشف التطبيقات العملية والرؤى من بيانات Hugging Face.

تحديد توجهات سوق الـ AI

تستفيد الشركات من خلال تحديد مهام الـ AI التي تكتسب أكبر قدر من الزخم عالمياً.

كيفية التنفيذ:

- 1كشط أعداد التحميل لجميع الـ models ضمن فئات مهام محددة شهرياً.

- 2تجميع البيانات لمعرفة نسبة النمو حسب الفئة.

- 3تحديد الـ models الصاعدة التي تظهر طفرات مفاجئة في الشعبية.

استخدم Automatio لاستخراج البيانات من Hugging Face وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Hugging Face

- تحديد توجهات سوق الـ AI

تستفيد الشركات من خلال تحديد مهام الـ AI التي تكتسب أكبر قدر من الزخم عالمياً.

- كشط أعداد التحميل لجميع الـ models ضمن فئات مهام محددة شهرياً.

- تجميع البيانات لمعرفة نسبة النمو حسب الفئة.

- تحديد الـ models الصاعدة التي تظهر طفرات مفاجئة في الشعبية.

- الاستخبارات التنافسية

تتبع شركات التقنية مخرجات المصادر المفتوحة open-source للمنافسين مثل Meta أو Google للبقاء في المقدمة.

- إعداد عملية كشط مستهدفة لملفات تعريف مؤسسات معينة على Hugging Face.

- مراقبة إنشاء مستودعات جديدة أو تحديثات لبطاقات الـ model الحالية.

- تنبيه فرق المنتجات عندما يطلق منافس model جديد في مجال ذي صلة.

- توليد العملاء المحتملين للمواهب التقنية

يجد مسؤولو التوظيف باحثي AI رفيعي المستوى من خلال تحليل جودة المساهمة وتأثيرها على المجتمع.

- استخراج قوائم المؤلفين من الـ models عالية الأداء التي تتجاوز 100 ألف عملية تحميل.

- كشط ملفات تعريف المستخدمين للعثور على وسائل التواصل الاجتماعي المرتبطة أو المواقع الشخصية.

- تصفية الأفراد الذين لديهم سجل ثابت من المساهمات الشائعة في open-source.

- Datasets للبحوث الأكاديمية

يحلل الباحثون الطبيعة التعاونية وتطور نظام البحوث البيئي للـ AI.

- كشط metadata بما في ذلك قوائم المؤلفين، وأعداد الاستشهادات، والانتماءات المؤسسية.

- رسم خرائط للعلاقات بين المنظمات المختلفة والمساهمين الأفراد.

- تطبيق تحليل الشبكات لتصور مراكز نظام البحوث البيئي للـ AI.

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Hugging Face

نصائح الخبراء لاستخراج البيانات بنجاح من Hugging Face.

تحقق دائماً من ملف 'config.json' في مستودع الـ model للحصول على أدق metadata تقنية.

استخدم مكتبة Hugging Face Hub الرسمية بلغة Python بدلاً من كشط البيانات اليدوي (scraping) لتجنب الحظر.

قم بتدوير عناوين IP الخاصة بك باستخدام خدمة residential proxy عالية الجودة إذا كنت تقوم بعمل scraping لآلاف الـ models.

قم بجدولة مهام كشط البيانات خلال ساعات خارج الذروة لضمان سرعة استجابة أعلى وتقليل مخاطر الاكتشاف.

قم بتنظيف البيانات النصية المستخرجة عن طريق إزالة تنسيقات Markdown والروابط (URLs) لجعلها أكثر فائدة للتحليل.

راقب مدونة Hugging Face لمعرفة تحديثات واجهة المستخدم التي قد تغير محددات CSS الخاصة بأداة الـ scraper لديك.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape American Museum of Natural History (AMNH)

الأسئلة الشائعة حول Hugging Face

ابحث عن إجابات للأسئلة الشائعة حول Hugging Face