كيفية سكرابينج Pollen.com: دليل استخراج بيانات الحساسية المحلية

تعرف على كيفية إجراء سكرابينج لموقع Pollen.com للحصول على توقعات الحساسية المحلية، ومستويات حبوب اللقاح، وأهم مسببات الحساسية. احصل على بيانات صحية يومية للبحث...

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- AngularJS Rendering

حول Pollen.com

اكتشف ما يقدمه Pollen.com وما هي البيانات القيمة التي يمكن استخراجها.

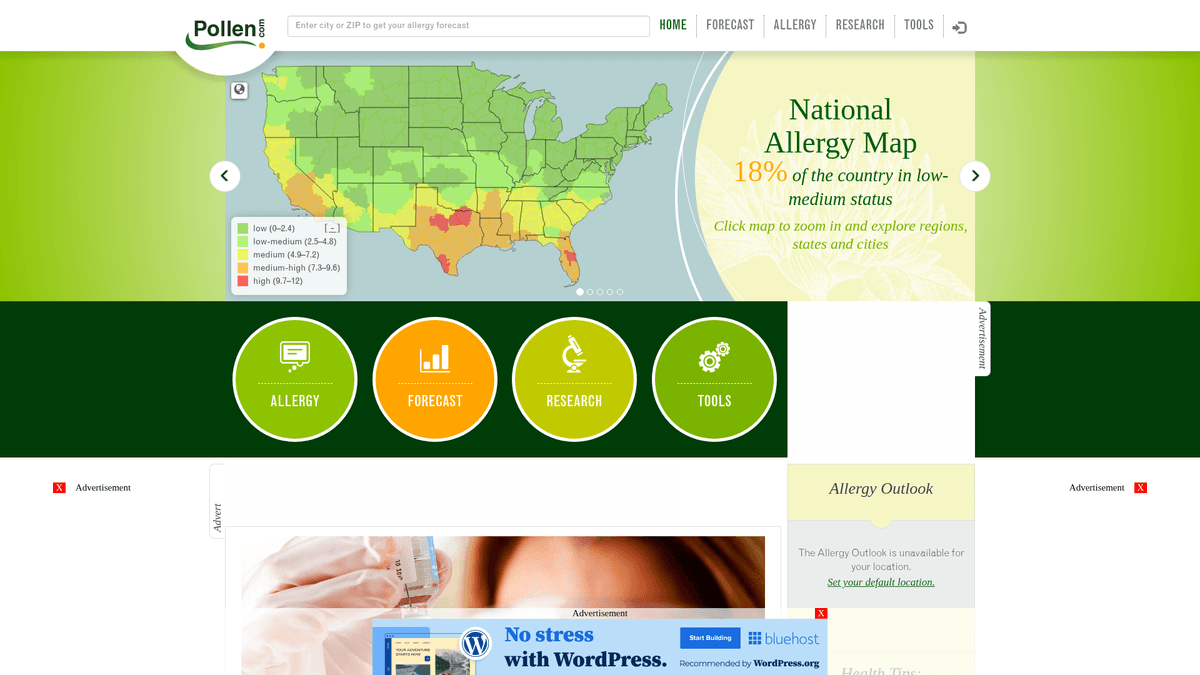

بيانات شاملة عن الحساسية في الولايات المتحدة

يعد Pollen.com بوابة رائدة للصحة البيئية توفر معلومات وتوقعات محلية للغاية عن الحساسية في جميع أنحاء الولايات المتحدة. تملكها وتديرها شركة IQVIA، وهي شركة بارزة في تحليل البيانات الصحية، وتوفر المنصة أعدادًا محددة من حبوب اللقاح وأنواع مسببات الحساسية بناءً على الرموز البريدية. كما تعد موردًا حيويًا للأفراد الذين يعانون من حالات تنفسية موسمية وللمتخصصين الطبيين الذين يتابعون اتجاهات الصحة البيئية.

بيانات قيمة للصحة العامة

يحتوي الموقع على بيانات مهيكلة تشمل مؤشر حبوب اللقاح الذي يتراوح من 0 إلى 12، وفئات من أهم مسببات الحساسية مثل الأشجار والأعشاب والحشائش، وتوقعات مفصلة لمدة 5 أيام. بالنسبة للمطورين والباحثين، توفر هذه البيانات رؤية حول المحفزات البيئية الإقليمية وأنماط الحساسية التاريخية التي يصعب تجميعها من مواقع الطقس العامة.

فائدة للأعمال والأبحاث

تعتبر عملية سكرابينج لموقع Pollen.com ذات قيمة لبناء تطبيقات مراقبة الصحة، وتحسين سلاسل توريد الأدوية لأدوية الحساسية، وإجراء أبحاث أكاديمية حول تأثيرات تغير المناخ على دورات التلقيح. من خلال أتمتة استخراج نقاط البيانات هذه، يمكن للمؤسسات تقديم قيمة فورية لمن يعانون من الحساسية في جميع أنحاء البلاد.

لماذا تجريد Pollen.com؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Pollen.com.

بناء أنظمة تنبيه مخصصة للحساسية للتطبيقات الصحية

التنبؤ باتجاهات الطلب الدوائي لأدوية الحساسية المحلية

إجراء أبحاث بيئية حول مواسم التلقيح الإقليمية

تجميع بيانات صحية محلية دقيقة لبوابات الأخبار والطقس

تحليل أنماط الحساسية التاريخية لتخطيط الصحة العامة في المناطق الحضرية

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Pollen.com.

يتطلب عرض المحتوى الديناميكي باستخدام AngularJS أتمتة المتصفح أو سكرابرز بدون واجهة رسومية (headless)

يتم تحميل بيانات التوقعات الأساسية عبر طلبات API داخلية غير متزامنة محمية بجلسة عمل

يمكن أن تؤدي القيود الصارمة على معدل الطلبات للبحث المتكرر عن الرموز البريدية الجغرافية إلى حظر مؤقت لعنوان IP

غالبًا ما تؤدي حماية البوتات من Cloudflare إلى تفعيل تحديات للوكلاء (user agents) غير التابعين للمتصفحات

استخرج بيانات Pollen.com بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Pollen.com. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Pollen.com، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Pollen.com سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Pollen.com. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Pollen.com، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- معالجة JavaScript التلقائية تتعامل مع بيانات مخططات AngularJS المعقدة دون كود إضافي

- تدوير البروكسي المدمج يتجاوز بنجاح أمان Cloudflare وقيود معدل الطلبات القائمة على IP

- تسمح عمليات التشغيل المجدولة بجمع البيانات اليومية بشكل آلي بالكامل عبر آلاف الرموز البريدية

- الواجهة التي لا تتطلب كودًا (no-code) تجعل من السهل إعداد استخراج البيانات لمناطق جغرافية محددة

أدوات تجريد الويب بدون كود لـPollen.com

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Pollen.com بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـPollen.com

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Pollen.com بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# ملاحظة: هذا الكود يلتقط البيانات الوصفية للأخبار الثابتة.

# تتطلب بيانات التوقعات الأساسية معالجة JavaScript أو الوصول المباشر إلى API داخلي.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# استخراج عناوين الأخبار الأساسية من الشريط الجانبي

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'أحدث أخبار الحساسية: {news}')

except Exception as e:

print(f'حدث خطأ: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Pollen.com بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# ملاحظة: هذا الكود يلتقط البيانات الوصفية للأخبار الثابتة.

# تتطلب بيانات التوقعات الأساسية معالجة JavaScript أو الوصول المباشر إلى API داخلي.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# استخراج عناوين الأخبار الأساسية من الشريط الجانبي

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'أحدث أخبار الحساسية: {news}')

except Exception as e:

print(f'حدث خطأ: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

browser = playwright.chromium.launch(headless=True)

page = browser.new_page()

# الانتقال إلى توقعات رمز بريدي محدد

page.goto('https://www.pollen.com/forecast/current/pollen/20001')

# الانتظار حتى يقوم AngularJS بمعالجة مؤشر حبوب اللقاح الديناميكي

page.wait_for_selector('.forecast-level')

data = {

'pollen_index': page.inner_text('.forecast-level'),

'status': page.inner_text('.forecast-level-desc'),

'allergens': [el.inner_text() for el in page.query_selector_all('.top-allergen-item span')]

}

print(f'بيانات الرمز 20001: {data}')

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class PollenSpider(scrapy.Spider):

name = 'pollen_spider'

start_urls = ['https://www.pollen.com/forecast/current/pollen/20001']

def parse(self, response):

# للمحتوى الديناميكي، استخدم Scrapy-Playwright أو برمجية وسيطة مماثلة

# طريقة parse القياسية هذه تتعامل مع العناصر الثابتة مثل العناوين

yield {

'url': response.url,

'page_title': response.css('title::text').get(),

'news_headlines': response.css('article h2 a::text').getall()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// ضبط User-Agent لمحاكاة متصفح حقيقي

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64)');

await page.goto('https://www.pollen.com/forecast/current/pollen/20001');

// الانتظار حتى يظهر مستوى التوقعات الديناميكي

await page.waitForSelector('.forecast-level');

const data = await page.evaluate(() => ({

pollenIndex: document.querySelector('.forecast-level')?.innerText,

description: document.querySelector('.forecast-level-desc')?.innerText,

location: document.querySelector('h1')?.innerText

}));

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات Pollen.com

استكشف التطبيقات العملية والرؤى من بيانات Pollen.com.

تنبيهات الحساسية المخصصة

يمكن لتطبيقات الصحة المتنقلة تزويد المستخدمين بإشعارات في الوقت الفعلي عندما تصل مستويات حبوب اللقاح إلى مستويات عالية في منطقتهم المحددة.

كيفية التنفيذ:

- 1إجراء سكرابينج للتوقعات اليومية للرموز البريدية المقدمة من المستخدمين

- 2تحديد متى يتجاوز مؤشر حبوب اللقاح عتبة 'عالي' (7.3+)

- 3إرسال تنبيهات دفع تلقائية أو رسائل SMS للمستخدم

استخدم Automatio لاستخراج البيانات من Pollen.com وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Pollen.com

- تنبيهات الحساسية المخصصة

يمكن لتطبيقات الصحة المتنقلة تزويد المستخدمين بإشعارات في الوقت الفعلي عندما تصل مستويات حبوب اللقاح إلى مستويات عالية في منطقتهم المحددة.

- إجراء سكرابينج للتوقعات اليومية للرموز البريدية المقدمة من المستخدمين

- تحديد متى يتجاوز مؤشر حبوب اللقاح عتبة 'عالي' (7.3+)

- إرسال تنبيهات دفع تلقائية أو رسائل SMS للمستخدم

- التنبؤ بالطلب على الأدوية

يمكن لتجار التجزئة في قطاع الأدوية تحسين مستويات مخزونهم من خلال ربط الارتفاعات المحلية في حبوب اللقاح بالطلب المتوقع على مضادات الهيستامين.

- استخراج بيانات التوقعات لمدة 5 أيام عبر المناطق الحضرية الكبرى

- تحديد الفترات القادمة لزيادة نشاط مسببات الحساسية

- تنسيق توزيع المخزون على الصيدليات المحلية قبل وصول الذروة

- التقييم البيئي للعقارات

يمكن لمواقع إدراج العقارات إضافة 'تقييم الحساسية' لمساعدة المشترين ذوي الحساسية في تقييم جودة الهواء في الحي.

- تجميع بيانات حبوب اللقاح التاريخية لأحياء محددة في المدينة

- حساب متوسط درجة كثافة حبوب اللقاح السنوية

- عرض الدرجة ك ميزة مخصصة في صفحة تفاصيل العقارات

- أبحاث تغير المناخ

يمكن لعلماء البيئة تتبع طول وكثافة مواسم التلقيح بمرور الوقت لدراسة التأثيرات المناخية.

- سكرابينج أنواع حبوب اللقاح والمؤشرات اليومية طوال فصلي الربيع والخريف

- مقارنة تواريخ بدء وانتهاء التلقيح مع المتوسطات التاريخية

- تحليل البيانات للبحث عن اتجاهات تشير إلى مواسم حساسية أطول أو أكثر حدة

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Pollen.com

نصائح الخبراء لاستخراج البيانات بنجاح من Pollen.com.

استهدف نقاط نهاية API الداخلية الموجودة في حركة مرور الشبكة للوصول المباشر إلى بيانات JSON.

استخدم بروكسيات سكنية لتدوير عنوان IP الخاص بك وتجنب تفعيل درع البوتات الخاص بـ Cloudflare.

قم بإجراء سكرابينج يوميًا في الصباح الباكر (حوالي الساعة 7 صباحًا بتوقيت EST) للحصول على أحدث تحديثات التوقعات.

تأكد من أن السكرابر الخاص بك ينفذ JavaScript، حيث يستخدم Pollen.com إطار AngularJS لتعبئة أرقام المؤشرات.

قم بإدراج تأخير عشوائي (random sleep) بين 3 إلى 10 ثوانٍ بين طلبات الرموز البريدية المختلفة.

راقب هيكل الموقع بانتظام، حيث يمكن أن تتغير أسماء فئات AngularJS أثناء تحديثات الموقع.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape American Museum of Natural History (AMNH)

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Poll-Maker: A Comprehensive Web Scraping Guide

الأسئلة الشائعة حول Pollen.com

ابحث عن إجابات للأسئلة الشائعة حول Pollen.com