كيفية كشط بيانات We Work Remotely: الدليل الشامل

تعرف على كيفية كشط قوائم الوظائف من We Work Remotely. استخرج مسميات الوظائف، الشركات، الرواتب، والمزيد لأبحاث السوق أو لمجمع الوظائف الخاص بك.

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

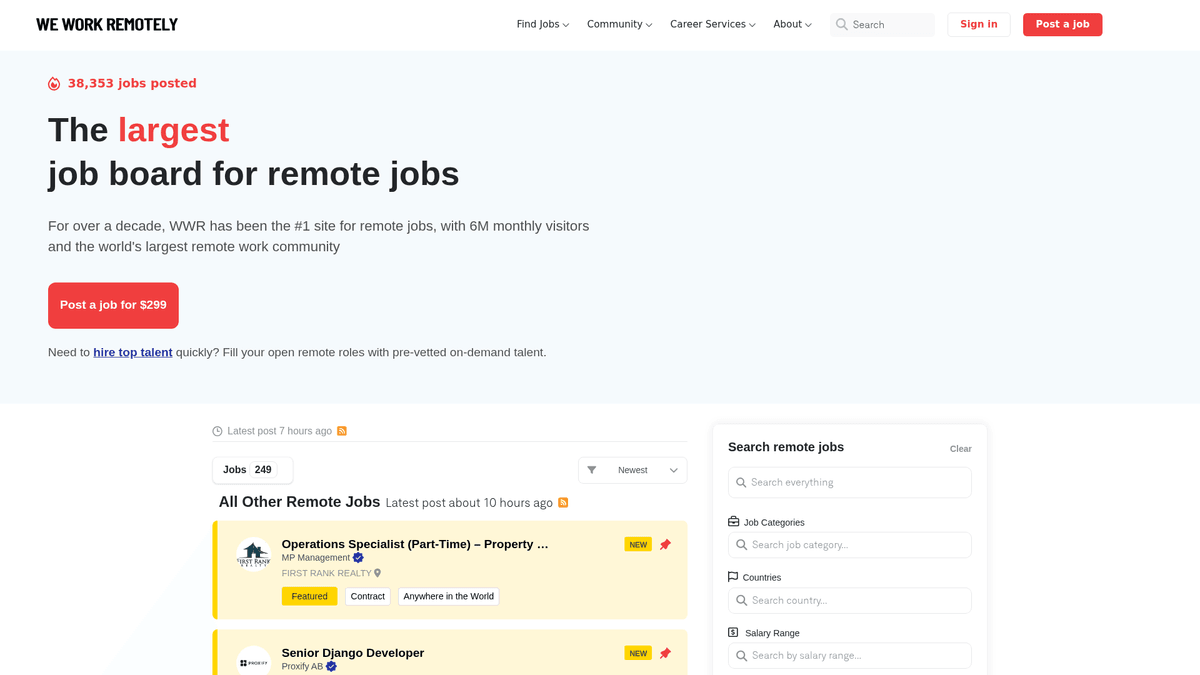

حول We Work Remotely

اكتشف ما يقدمه We Work Remotely وما هي البيانات القيمة التي يمكن استخراجها.

مركز المواهب العالمية عن بُعد

تعد We Work Remotely (WWR) أقدم وأكبر مجتمع للعمل عن بُعد في العالم، حيث تفتخر بأكثر من 6 ملايين زائر شهرياً. وهي وجهة أساسية للشركات التي تبتعد عن النماذج التقليدية القائمة على المكاتب، وتقدم مجموعة متنوعة من القوائم في تطوير البرمجيات، التصميم، التسويق، ودعم العملاء.

بيانات منظمة عالية الجودة

تشتهر المنصة ببياناتها المنظمة للغاية. تحتوي كل قائمة عادةً على متطلبات إقليمية محددة، ونطاقات رواتب، وملفات تعريف تفصيلية للشركات. تجعل هذه البنية من الموقع هدفاً مثالياً لكشط الويب، حيث أن البيانات متسقة وسهلة التصنيف لحالات الاستخدام الثانوية.

القيمة الاستراتيجية لمحترفي البيانات

بالنسبة لمسؤولي التوظيف وباحثي السوق، يعتبر WWR منجماً للذهب. يسمح كشط هذا الموقع بتتبع اتجاهات التوظيف في الوقت الفعلي، وعمل benchmark للرواتب عبر مختلف القطاعات التقنية، وتوليد العملاء المحتملين لخدمات B2B التي تستهدف الشركات التي تعتمد مبدأ العمل عن بُعد أولاً. إنه يوفر رؤية شفافة لسوق العمل العالمي عن بُعد.

لماذا تجريد We Work Remotely؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من We Work Remotely.

بناء مجمع وظائف أو بوابة وظائف متخصصة عن بُعد

إجراء تحليل تنافسي للرواتب عبر الصناعات

تحديد الشركات التي توظف بقوة في مجال العمل عن بُعد

مراقبة الطلب العالمي على مهارات تقنية محددة

توليد عملاء محتملين لمزودي تقنيات الموارد البشرية والمزايا

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد We Work Remotely.

تفعيل حماية Cloudflare المضادة للبوتات

التعامل مع عدم الاتساق في وسوم الموقع الجغرافي

تحليل تنسيقات الرواتب المتنوعة داخل الأوصاف

إدارة حدود معدل IP أثناء عمليات كشف صفحات التفاصيل عالية الكثافة

استخرج بيانات We Work Remotely بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من We Work Remotely. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح We Work Remotely، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات We Work Remotely سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من We Work Remotely. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح We Work Remotely، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- إعداد الكشط بدون كود عبر واجهة مرئية

- معالجة تلقائية لتدابير مكافحة البوتات والـ proxies

- تشغيل مجدول لتحديثات لوحة الوظائف في الوقت الفعلي

- تصدير مباشر إلى JSON أو CSV أو Google Sheets

- تنفيذ سحابي دون استهلاك موارد الجهاز المحلية

أدوات تجريد الويب بدون كود لـWe Work Remotely

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد We Work Remotely بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـWe Work Remotely

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد We Work Remotely بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# إرسال الطلب مع رؤوس مخصصة

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# استهداف قوائم الوظائف

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات We Work Remotely بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# إرسال الطلب مع رؤوس مخصصة

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# استهداف قوائم الوظائف

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# تشغيل متصفح headless

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# انتظار تحميل الحاوية الرئيسية

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# التنقل عبر عناصر القائمة

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// استخراج البيانات باستخدام evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();ماذا يمكنك فعله ببيانات We Work Remotely

استكشف التطبيقات العملية والرؤى من بيانات We Work Remotely.

مجمع وظائف عن بُعد

بناء منصة متخصصة للبحث عن الوظائف لمجالات تقنية محددة مثل Rust أو AI.

كيفية التنفيذ:

- 1كشط WWR يومياً للحصول على القوائم الجديدة

- 2الفلترة باستخدام كلمات مفتاحية وفئات محددة

- 3تخزين البيانات في قاعدة بيانات قابلة للبحث

- 4أتمتة النشر على وسائل التواصل الاجتماعي للوظائف الجديدة

استخدم Automatio لاستخراج البيانات من We Work Remotely وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات We Work Remotely

- مجمع وظائف عن بُعد

بناء منصة متخصصة للبحث عن الوظائف لمجالات تقنية محددة مثل Rust أو AI.

- كشط WWR يومياً للحصول على القوائم الجديدة

- الفلترة باستخدام كلمات مفتاحية وفئات محددة

- تخزين البيانات في قاعدة بيانات قابلة للبحث

- أتمتة النشر على وسائل التواصل الاجتماعي للوظائف الجديدة

- تحليل اتجاهات الرواتب

تحليل بيانات الرواتب عن بُعد لتحديد معايير التعويض العالمية (benchmarks) عبر الأدوار المختلفة.

- استخراج حقول الرواتب من أوصاف الوظائف

- توحيد البيانات في عملة واحدة

- التقسيم حسب الدور الوظيفي ومستوى الخبرة

- إصدار تقارير سوق ربع سنوية

- توليد العملاء لتقنيات الموارد البشرية

تحديد الشركات التي توظف فرقاً عن بُعد بشكل مكثف لبيع برمجيات الموارد البشرية وكشوف المرتبات والمزايا.

- مراقبة قائمة 'أفضل 100 شركة تعمل عن بُعد'

- تتبع تكرار منشورات الوظائف الجديدة

- تحديد صناع القرار في الشركات التي تقوم بالتوظيف

- التواصل مع الشركات بحلول B2B مخصصة

- اتجاهات التوظيف التاريخية

تحليل البيانات طويلة المدى لفهم كيف يتغير الطلب على العمل عن بُعد موسمياً أو اقتصادياً.

- أرشفة القوائم على مدار أكثر من 12 شهراً

- حساب معدلات النمو لكل فئة

- تصوير الاتجاهات باستخدام أدوات ذكاء الأعمال (BI)

- التنبؤ بالطلب المستقبلي على المهارات

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد We Work Remotely

نصائح الخبراء لاستخراج البيانات بنجاح من We Work Remotely.

استخدم نقطة النهاية /remote-jobs.rss للحصول على تغذية XML أنظف وسهلة القراءة برمجياً تتخطى تحليل HTML المعقد.

قم بتدوير residential proxies لتجنب جدران الحماية الخاصة بـ Cloudflare وحظر IP الدائم أثناء عمليات الزحف عالية الكثافة.

قم بتنفيذ تأخيرات زمنية عشوائية بين الطلبات لمحاكاة سلوك التصفح البشري وتجنب حدود rate limits.

قم بتوحيد بيانات الموقع مثل 'Anywhere' إلى 'Global' أو 'Remote' للحصول على فلترة أكثر اتساقاً لقواعد البيانات.

قم بضبط User-Agent الخاص بك على سلسلة متصفح شائعة لتجنب تصنيفك كأداة كشط برمجية بسيطة.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

الأسئلة الشائعة حول We Work Remotely

ابحث عن إجابات للأسئلة الشائعة حول We Work Remotely