Wie man CoinCatapult scrapt: Der ultimative Guide für Krypto-Daten

Erfahren Sie, wie Sie Projektnamen, Vote-Zahlen, Contract-Adressen und Launch-Daten von CoinCatapult extrahieren. Ideal für DeFi-Recherche und Lead-Generierung.

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- IP-Blockierung

- Blockiert bekannte Rechenzentrums-IPs und markierte Adressen. Erfordert Residential- oder Mobile-Proxys zur effektiven Umgehung.

- JavaScript-Challenge

- Erfordert JavaScript-Ausführung zum Zugriff auf Inhalte. Einfache Anfragen scheitern; Headless-Browser wie Playwright oder Puppeteer nötig.

Über CoinCatapult

Entdecken Sie, was CoinCatapult bietet und welche wertvollen Daten extrahiert werden können.

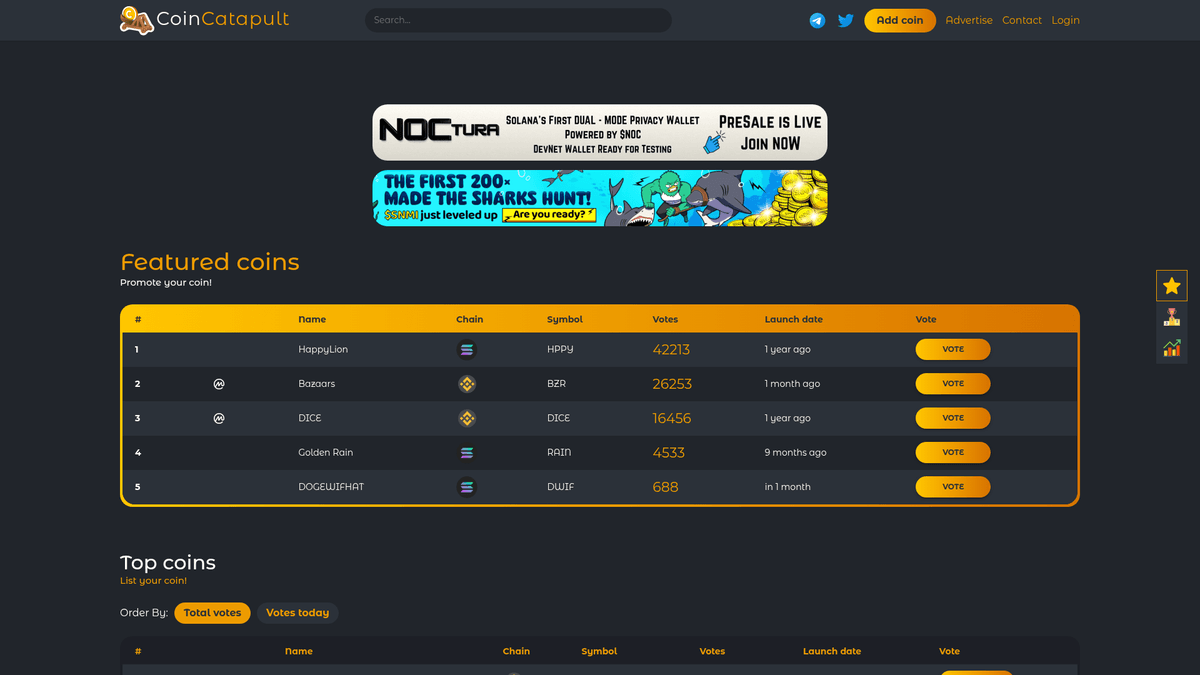

Das Launchpad zur DeFi-Entdeckung

CoinCatapult ist eine beliebte Plattform für Kryptowährungs-Listings und Community-Voting, die sich auf DeFi-Projekte in der Frühphase spezialisiert hat. Sie dient als digitaler Hub, auf dem Entwickler neue Token listen, um Sichtbarkeit zu erlangen, während Trader die Plattform nutzen, um durch Community-getriebene Stimmenzahlen und Popularitätsrankings hochpotenzielle „Gems“ zu entdecken.

Umfassende Listing-Daten

Die Plattform hostet tausende Listings über verschiedene Blockchain-Netzwerke hinweg, einschließlich Solana, Binance Smart Chain und Ethereum. Jeder Eintrag liefert kritische Metadaten wie den Launch-Status, Echtzeit-Stimmenzahlen und Social-Links, was sie zu einer primären Quelle für die Verfolgung der Frequenz neuer Token-Launches macht.

Warum die Daten wichtig sind

Das Scrapen von CoinCatapult ist für Krypto-Marktforscher, Marketing-Agenturen und Blockchain-Entwickler äußerst wertvoll. Durch die Extraktion dieser Daten können Nutzer Trend-Nischen identifizieren, die Wettbewerbslandschaft verschiedener Chains überwachen und Leads für Sicherheits-Audits oder Marketing-Dienstleistungen generieren, die auf Besitzer neuer Projekte abzielen.

Warum CoinCatapult Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von CoinCatapult.

Frühzeitige Projektentdeckung

Identifizieren Sie neue Token-Launches und aufstrebende DeFi-Projekte, bevor sie auf großen Plattformen wie CoinMarketCap an Sichtbarkeit gewinnen.

Analyse der Voting-Geschwindigkeit

Überwachen Sie Community-Voting-Muster in Echtzeit, um den Hype und das soziale Interesse an einem Projekt zu quantifizieren, was oft mit der Marktdynamik korreliert.

Hochwertige Lead-Generierung

Extrahieren Sie offizielle Projektwebsites und verifizierte Social-Media-Links, um eine umfassende Datenbank aktiver Blockchain-Entwickler und Marketingteams aufzubauen.

Trends im Blockchain-Ökosystem

Analysieren Sie, welche Netzwerke wie Solana, Base oder BSC derzeit die aktivsten Projekt-Einreichungen und das stärkste Community-Engagement verzeichnen.

Historisches Tracking des Wachstums

Vergleichen Sie Voting-Metriken aus der Frühphase mit der späteren Preisentwicklung, um prädiktive Modelle für erfolgreiche Kryptowährung-Launches zu entwickeln.

Überwachung des Market Sentiment

Aggregieren Sie tägliche Vote-Zahlen, um die allgemeine Stimmung der 'Degen'-Trading-Community über verschiedene Marktzyklen hinweg zu messen.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von CoinCatapult.

Cloudflare Anti-Bot-Barrieren

Die Website nutzt Cloudflare-Schutzmechanismen, die automatisierte Standardanfragen durch Browser-Fingerprinting und JS-Challenges erkennen und blockieren können.

JavaScript-gerenderte Daten

Kritische Informationen wie Echtzeit-Vote-Zahlen und bestimmte Listing-Details werden über JavaScript geladen, was einen browserbasierten Scraping-Ansatz erfordert.

Aggressives Rate Limiting

Häufige Anfragen von einer einzigen IP-Adresse führen zu temporären oder permanenten Sperren, da die Plattform darauf fokussiert ist, Vote-Manipulationen zu verhindern.

Dynamische Element-Selektoren

Die Tabellenstruktur und CSS-Selektoren können sich regelmäßig ändern, was eine kontinuierliche Wartung der Scraping-Skripte erfordert, um die Datengenauigkeit zu gewährleisten.

Paginierung und Lade-Aktionen

Die Verwendung von 'Load More'-Buttons oder komplexer Paginierung erfordert eine Automatisierung, die Benutzerklicks simulieren kann, um die vollständige Projekthistorie abzurufen.

Scrape CoinCatapult mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von CoinCatapult extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert CoinCatapult, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, CoinCatapult zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von CoinCatapult extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert CoinCatapult, verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Nahtloser Cloudflare-Bypass: Automatio navigiert effektiv durch komplexe Sicherheitsschichten und JS-Challenges, ohne dass der Benutzer eine komplizierte Bypass-Logik schreiben muss.

- Visuelle No-Code-Auswahl: Ordnen Sie Krypto-Datenfelder wie Token-Symbole und Contract-Adressen schnell über eine einfache Point-and-Click-Oberfläche zu.

- Fortgeschrittene Proxy-Rotation: Das integrierte Management für Residential Proxies stellt sicher, dass Scraping-Anfragen über mehrere IPs mit hoher Reputation verteilt werden, um eine Erkennung zu vermeiden.

- Echtzeit-Scheduling: Konfigurieren Sie Bots so, dass sie in spezifischen Intervallen laufen (z. B. alle 15 Minuten), um plötzliche Anstiege beim Voting oder neue Listings sofort zu erfassen.

- Automatisierte Aktionsketten: Erstellen Sie mühelos komplexe Sequenzen, die auf 'Load More' klicken, zu Projektdetails navigieren und Kontaktinformationen in einem einzigen Workflow extrahieren.

No-Code Web Scraper für CoinCatapult

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von CoinCatapult helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für CoinCatapult

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von CoinCatapult helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man CoinCatapult mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_coincatapult():

with sync_playwright() as p:

# Launching with a real browser head can help bypass basic checks

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigate to the site

page.goto('https://coincatapult.com/', wait_until='networkidle')

# Wait for the table to render

page.wait_for_selector('table')

# Extract data using Javascript evaluation

coins = page.evaluate("""() => {

const rows = Array.from(document.querySelectorAll('table tbody tr'));

return rows.map(row => {

const tds = row.querySelectorAll('td');

return {

name: tds[2]?.innerText.trim(),

chain: tds[3]?.querySelector('img')?.alt || 'Unknown',

votes: tds[5]?.innerText.trim()

};

});

}""")

for coin in coins:

print(coin)

browser.close()

if __name__ == '__main__':

scrape_coincatapult()Python + Scrapy

import scrapy

class CoinSpider(scrapy.Spider):

name = 'coincatapult_spider'

start_urls = ['https://coincatapult.com/']

def parse(self, response):

# Iterate through table rows using CSS selectors

for row in response.css('table tbody tr'):

yield {

'name': row.css('td:nth-child(3)::text').get(),

'symbol': row.css('td:nth-child(5)::text').get(),

'votes': row.css('td:nth-child(6)::text').get(),

'launch_date': row.css('td:nth-child(7)::text').get()

}

# Basic pagination handling if a 'Next' link exists

next_page = response.css('ul.pagination li.next a::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic viewport

await page.setViewport({ width: 1280, height: 800 });

// Go to CoinCatapult

await page.goto('https://coincatapult.com/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const results = [];

const rows = document.querySelectorAll('table tbody tr');

rows.forEach(row => {

const cells = row.querySelectorAll('td');

if (cells.length >= 6) {

results.push({

name: cells[2].innerText.trim(),

chain: cells[3].querySelector('img')?.alt || 'N/A',

votes: cells[5].innerText.trim()

});

}

});

return results;

});

console.log(data);

await browser.close();

})();Was Sie mit CoinCatapult-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus CoinCatapult-Daten.

Whale-Alerts in Echtzeit

Automatisiertes System, das Trader benachrichtigt, wenn ein Projekt in kurzer Zeit massives Stimmen-Momentum gewinnt.

So implementieren Sie es:

- 1Scrapen Sie die Spalte 'Votes Today' alle 30 Minuten.

- 2Vergleichen Sie die aktuellen Stimmen mit den Daten des vorherigen Scrapes.

- 3Lösen Sie einen Alert aus, wenn die Stimmenzahl eines Projekts in einer Stunde um mehr als 50 % steigt.

Verwenden Sie Automatio, um Daten von CoinCatapult zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit CoinCatapult-Daten machen können

- Whale-Alerts in Echtzeit

Automatisiertes System, das Trader benachrichtigt, wenn ein Projekt in kurzer Zeit massives Stimmen-Momentum gewinnt.

- Scrapen Sie die Spalte 'Votes Today' alle 30 Minuten.

- Vergleichen Sie die aktuellen Stimmen mit den Daten des vorherigen Scrapes.

- Lösen Sie einen Alert aus, wenn die Stimmenzahl eines Projekts in einer Stunde um mehr als 50 % steigt.

- Krypto-Marketing-Akquise

Identifizieren Sie Besitzer neuer DeFi-Projekte, die professionelle Marketing- oder Listing-Services benötigen könnten.

- Extrahieren Sie täglich Telegram- und Twitter-Links aus dem Bereich 'New Coins'.

- Kategorisieren Sie Projekte nach Blockchain (z. B. SOL, ETH), um spezifische Communities anzusprechen.

- Senden Sie personalisierte Outreach-Nachrichten an die offiziellen Social-Media-Kanäle des Projekts.

- Ecosystem Health Reports

Erstellen Sie Berichte, die zeigen, welche Blockchain-Netzwerke (Solana vs. BSC) mehr Entwickler anziehen.

- Scrapen Sie alle Projekt-Listings und das zugehörige Blockchain-Netzwerk.

- Zählen Sie die Anzahl der neuen Launches pro Netzwerk auf monatlicher Basis.

- Visualisieren Sie die Wachstumstrends, um zu identifizieren, welches Ökosystem den 'Degen'-Markt dominiert.

- Lead-Generierung vor dem Launch

Finden Sie Projekte im Status 'Presale' oder 'Launch Date', um Smart-Contract-Auditing-Dienstleistungen anzubieten.

- Filtern Sie Scraping-Ergebnisse nach Projekten, deren 'Launch Date' in der Zukunft liegt.

- Extrahieren Sie die Contract-Adresse (falls gelistet) oder soziale Kontaktinformationen.

- Bieten Sie Entwicklern Audit-Angebote an, bevor diese im Mainnet live gehen.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von CoinCatapult

Expertentipps für die erfolgreiche Datenextraktion von CoinCatapult.

Residential Proxies priorisieren

Da CoinCatapult als Community-Voting-Plattform fungiert, reagiert sie sehr empfindlich auf Datacenter-IPs; die Verwendung von Residential Proxies ist für hohe Erfolgsquoten unerlässlich.

Zufällige Verzögerungen implementieren

Vermeiden Sie ein vorhersehbares Scraping-Muster, indem Sie zufällige Intervalle zwischen 5 und 20 Sekunden einbauen, um natürliches menschliches Browsing-Verhalten zu imitieren.

Die Kategorie 'Neu' überwachen

Konzentrieren Sie Ihren Scraper auf den Bereich 'Neu', um Projekte sofort nach ihrer Listung zu identifizieren, was Ihnen einen Wettbewerbsvorteil bei der Projektprüfung oder beim Investment verschafft.

Detailseiten für Contracts scrapen

Die Startseite bietet eine Zusammenfassung, aber die verifizierten Contract-Adressen finden sich auf den einzelnen Detailseiten; konfigurieren Sie Ihren Bot so, dass er diesen Links immer folgt.

Mobile User-Agents prüfen

Die Verwendung von mobilen Browser-User-Agents kann im Vergleich zu Desktop-Footprints manchmal zu schnelleren Ladezeiten und weniger Sicherheitsabfragen führen.

Abgleich mit Social-Links

Extrahieren Sie Telegram- und Twitter-URLs zusammen mit den Vote-Zahlen, um die Legitimität des Community-Engagements eines Projekts zu verifizieren.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Häufig gestellte Fragen zu CoinCatapult

Finden Sie Antworten auf häufige Fragen zu CoinCatapult