So scrapen Sie Signal NFX | Leitfaden zum Scraping von Investor- & VC-Datenbanken

Erfahren Sie, wie Sie Investorenprofile, VC-Firmendaten und Lead-Listen von Signal NFX scrapen. Entdecken Sie technische Strategien für Fundraising und...

Anti-Bot-Schutz erkannt

- Cloudflare

- Enterprise-WAF und Bot-Management. Nutzt JavaScript-Challenges, CAPTCHAs und Verhaltensanalyse. Erfordert Browser-Automatisierung mit Stealth-Einstellungen.

- Rate Limiting

- Begrenzt Anfragen pro IP/Sitzung über Zeit. Kann mit rotierenden Proxys, Anfrageverzögerungen und verteiltem Scraping umgangen werden.

- IP-Blockierung

- Blockiert bekannte Rechenzentrums-IPs und markierte Adressen. Erfordert Residential- oder Mobile-Proxys zur effektiven Umgehung.

- Login Wall

- Google reCAPTCHA

- Googles CAPTCHA-System. v2 erfordert Benutzerinteraktion, v3 läuft unsichtbar mit Risikobewertung. Kann mit CAPTCHA-Diensten gelöst werden.

Über Signal (by NFX)

Entdecken Sie, was Signal (by NFX) bietet und welche wertvollen Daten extrahiert werden können.

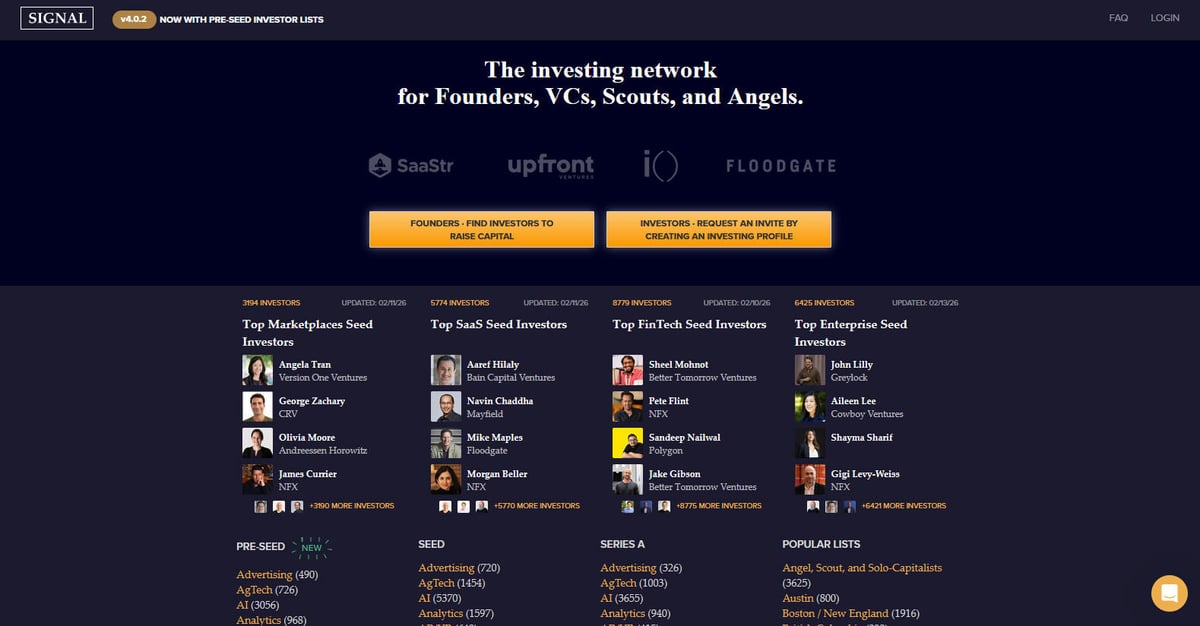

Signal ist ein leistungsstarkes Investment-Netzwerk, das speziell für Gründer, VCs, Scouts und Angel-Investoren entwickelt wurde. Erstellt und gepflegt von NFX, einer führenden Seed-Stage-Venture-Capital-Gesellschaft, dient die Plattform als massives Verzeichnis und Networking-Tool, um das Fundraising für Startups zu erleichtern. Ziel ist es, das Venture-Ökosystem transparenter zu gestalten, indem die Verbindungen zwischen Investoren und Unternehmern kartiert werden – ein dynamisches, datenreiches Umfeld, das manuelle Tabellen ersetzt.

Die Plattform enthält tausende Investorenprofile, kategorisiert nach bevorzugten Investitionsphasen (von Pre-Seed bis Series B), Industriesektoren wie AI, SaaS und FinTech sowie geografischen Regionen. Nutzer finden detaillierte Informationen über Venture-Capital-Firmen, einzelne Partner und deren spezifische Investitionsschwerpunkte, die regelmäßig aktualisiert werden. Jeder Eintrag enthält in der Regel den Fokus des Investors, bevorzugte Phasen, spezifische Investment-Thesen und Präferenzen für direkte Gründer-Intros.

Das Scraping von Signal ist äußerst wertvoll für Gründer, die gezielte Investoren-Listen aufbauen müssen, ohne manuell tausende Einträge zu durchsuchen. Es liefert zudem kritische Daten für Marktforscher, die Venture-Capital-Trends verfolgen, Wettbewerbsanalysen für andere VC-Firmen erstellen und für Sales-Teams, die das Startup-Ökosystem durch Beziehungs- und Intro-Mapping erschließen wollen.

Warum Signal (by NFX) Scrapen?

Entdecken Sie den Geschäftswert und die Anwendungsfälle für die Datenextraktion von Signal (by NFX).

Investoren-Pipelines aufbauen

Gründer können kuratierte Listen von VCs und Angel-Investoren extrahieren, die exakt zu ihrer Finanzierungsphase und ihrem Industriesektor passen, um den Fundraising-Prozess zu optimieren.

Venture-Trends analysieren

Das Scraping sektor-spezifischer Listen ermöglicht es Researchern zu identifizieren, welche Branchen wie AI oder ClimateTech die höchste Dichte an aktiven Frühphasen-Investitionen aufweisen.

B2B-Lead-Generierung

Dienstleister wie Anwaltskanzleien, Recruiter und Marketing-Agenturen können aktive Venture-Firmen identifizieren, um ihre Services den neu finanzierten Portfoliounternehmen anzubieten.

Mapping von Warm-Intros

Durch die Extraktion von Investoren-Beziehungsdaten und Firmenzugehörigkeiten können Entrepreneure die effektivsten sozialen Pfade für die Sicherung von Warm-Intros kartieren.

Competitive Intelligence

Venture Capital-Firmen können den Investmentfokus und die Teamerweiterungen rivalisierender Firmen überwachen, um die Wettbewerbslandschaft des Startup-Ökosystems besser zu verstehen.

Geografische Marktforschung

Identifizieren Sie die wichtigsten Finanzakteure und aktivsten Investoren in spezifischen Regionen wie Israel, Europa oder Lateinamerika für lokalisierte Markteintrittsstrategien.

Scraping-Herausforderungen

Technische Herausforderungen beim Scrapen von Signal (by NFX).

Komplexe Authentifizierung

Signal verbirgt viele detaillierte Profile und vollständige Investorenlisten hinter einer Login-Wall, was erfordert, dass Scraper Session-Cookies und automatisierte Authentifizierungs-Flows handhaben.

Dynamisches JS-Rendering

Die Plattform setzt stark auf moderne JavaScript-Frameworks, um Inhalte dynamisch über Infinite Scroll und AJAX zu laden, wodurch traditionelle HTML-Parser ineffektiv werden.

Aggressive Bot-Erkennung

NFX nutzt Cloudfront und andere Sicherheitsebenen, die auf hochfrequente Anfragen, typische Bot-Fingerprints und IP-Adressen von Rechenzentren prüfen.

Verschachtelte Datenstruktur

Die Extraktion vollständiger Daten erfordert das Navigieren durch mehrere Ebenen, einschließlich Firmenseiten, Partner-Unterseiten und sektorspezifische Kategorie-Tags.

Rate Limiting und Throttling

Der Zugriff auf Hunderte von Profilen in kurzer Zeit löst oft temporäre IP-Sperren oder CAPTCHA-Herausforderungen aus, die massenhafte Datenextraktion verhindern sollen.

Scrape Signal (by NFX) mit KI

Kein Code erforderlich. Extrahiere Daten in Minuten mit KI-gestützter Automatisierung.

So funktioniert's

Beschreibe, was du brauchst

Sag der KI, welche Daten du von Signal (by NFX) extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

KI extrahiert die Daten

Unsere künstliche Intelligenz navigiert Signal (by NFX), verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

Erhalte deine Daten

Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Warum KI zum Scraping nutzen

KI macht es einfach, Signal (by NFX) zu scrapen, ohne Code zu schreiben. Unsere KI-gestützte Plattform nutzt künstliche Intelligenz, um zu verstehen, welche Daten du möchtest — beschreibe es einfach in natürlicher Sprache und die KI extrahiert sie automatisch.

How to scrape with AI:

- Beschreibe, was du brauchst: Sag der KI, welche Daten du von Signal (by NFX) extrahieren möchtest. Tippe es einfach in natürlicher Sprache ein — kein Code oder Selektoren nötig.

- KI extrahiert die Daten: Unsere künstliche Intelligenz navigiert Signal (by NFX), verarbeitet dynamische Inhalte und extrahiert genau das, was du angefordert hast.

- Erhalte deine Daten: Erhalte saubere, strukturierte Daten, bereit zum Export als CSV, JSON oder zum direkten Senden an deine Apps und Workflows.

Why use AI for scraping:

- Müheloses Login-Management: Automatio ermöglicht es Ihnen, den Login-Prozess visuell aufzuzeichnen und Sessions zu speichern, sodass der Bot ohne manuelles Eingreifen auf geschützte Investorendaten zugreifen kann.

- Integrierter Infinite Scroll: Das Tool bewältigt dynamisches Laden mühelos, scrollt automatisch durch lange Investorenlisten und erfasst die Daten, sobald sie im Browser erscheinen.

- Menschenähnliche Interaktion: Automatio imitiert natürliches Browsing-Verhalten und lässt sich mit Residential Proxies integrieren, um die Cloudfront-Sicherheit zu umgehen und Erkennung zu vermeiden.

- Visuelle Datenauswahl: Nutzer können per Point-and-Click komplexe Datenpunkte wie Investment-Thesen oder Kontaktpräferenzen auswählen, unabhängig von der zugrunde liegenden HTML-Komplexität.

- No-Code CRM-Synchronisierung: Exportieren Sie gescrapte Investorendaten automatisch direkt nach Google Sheets oder in CRMs, sodass keine benutzerdefinierten Skripte zur Formatierung und Datenübertragung nötig sind.

No-Code Web Scraper für Signal (by NFX)

Point-and-Click-Alternativen zum KI-gestützten Scraping

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Signal (by NFX) helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

Häufige Herausforderungen

Lernkurve

Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

Selektoren brechen

Website-Änderungen können den gesamten Workflow zerstören

Probleme mit dynamischen Inhalten

JavaScript-lastige Seiten erfordern komplexe Workarounds

CAPTCHA-Einschränkungen

Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

IP-Sperrung

Aggressives Scraping kann zur Sperrung Ihrer IP führen

No-Code Web Scraper für Signal (by NFX)

Verschiedene No-Code-Tools wie Browse.ai, Octoparse, Axiom und ParseHub können Ihnen beim Scrapen von Signal (by NFX) helfen. Diese Tools verwenden visuelle Oberflächen zur Elementauswahl, haben aber Kompromisse im Vergleich zu KI-gestützten Lösungen.

Typischer Workflow mit No-Code-Tools

- Browser-Erweiterung installieren oder auf der Plattform registrieren

- Zur Zielwebseite navigieren und das Tool öffnen

- Per Point-and-Click die zu extrahierenden Datenelemente auswählen

- CSS-Selektoren für jedes Datenfeld konfigurieren

- Paginierungsregeln zum Scrapen mehrerer Seiten einrichten

- CAPTCHAs lösen (erfordert oft manuelle Eingabe)

- Zeitplanung für automatische Ausführungen konfigurieren

- Daten als CSV, JSON exportieren oder per API verbinden

Häufige Herausforderungen

- Lernkurve: Das Verständnis von Selektoren und Extraktionslogik braucht Zeit

- Selektoren brechen: Website-Änderungen können den gesamten Workflow zerstören

- Probleme mit dynamischen Inhalten: JavaScript-lastige Seiten erfordern komplexe Workarounds

- CAPTCHA-Einschränkungen: Die meisten Tools erfordern manuelle Eingriffe bei CAPTCHAs

- IP-Sperrung: Aggressives Scraping kann zur Sperrung Ihrer IP führen

Code-Beispiele

import requests

from bs4 import BeautifulSoup

# Signal erfordert einen Login für den vollen Datenzugriff. Dieses Beispiel nutzt eine Session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In einem realen Szenario müssten Sie hier zuerst Login-Daten per POST senden

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Investor-Cards in der Liste finden

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firma: {firm}')

except Exception as e:

print(f'Fehler beim Scraping von Signal: {e}')Wann verwenden

Am besten für statische HTML-Seiten, bei denen Inhalte serverseitig geladen werden. Der schnellste und einfachste Ansatz, wenn kein JavaScript-Rendering erforderlich ist.

Vorteile

- ●Schnellste Ausführung (kein Browser-Overhead)

- ●Geringster Ressourcenverbrauch

- ●Einfach zu parallelisieren mit asyncio

- ●Ideal für APIs und statische Seiten

Einschränkungen

- ●Kann kein JavaScript ausführen

- ●Scheitert bei SPAs und dynamischen Inhalten

- ●Kann bei komplexen Anti-Bot-Systemen Probleme haben

Wie man Signal (by NFX) mit Code scrapt

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signal erfordert einen Login für den vollen Datenzugriff. Dieses Beispiel nutzt eine Session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In einem realen Szenario müssten Sie hier zuerst Login-Daten per POST senden

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Investor-Cards in der Liste finden

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firma: {firm}')

except Exception as e:

print(f'Fehler beim Scraping von Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Zum Login navigieren

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'ihre_email@beispiel.de')

page.fill('input[name="password"]', 'ihr_passwort')

page.click('button:has-text("Log In")')

# Warten, bis die Listenseite nach dem Login geladen ist

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Scrollen, um Infinite-Inhalte zu laden

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Investor gefunden: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# Hinweis: Erfordert scrapy-playwright für JavaScript-Rendering

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# Scrapy-Logik für Infinite Scroll würde einen benutzerdefinierten Playwright-Handler erfordern,

# um nach unten zu scrollen, bevor die Response an parse zurückgegeben wirdNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// Zuerst Login durchführen

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'ihre_email');

await page.type('#user_password', 'ihr_passwort');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();Was Sie mit Signal (by NFX)-Daten machen können

Entdecken Sie praktische Anwendungen und Erkenntnisse aus Signal (by NFX)-Daten.

Automatisierung des Fundraising-Outreach

Gründer können die Daten nutzen, um Investoren zu identifizieren und zu priorisieren, die am ehesten in ihre spezifische Phase und ihren Sektor investieren.

So implementieren Sie es:

- 1Listen von Investoren in Ihrer Branche scrapen (z. B. 'Top AI Seed Investors').

- 2Ergebnisse nach 'Zuletzt aktualisiert' filtern, um aktive Geldgeber zu finden.

- 3Export in ein CRM wie HubSpot oder Pipedrive zur Nachverfolgung.

- 4Profil-Links nutzen, um gemeinsame Kontakte für eine warme Einleitung zu identifizieren.

Verwenden Sie Automatio, um Daten von Signal (by NFX) zu extrahieren und diese Anwendungen ohne Code zu erstellen.

Was Sie mit Signal (by NFX)-Daten machen können

- Automatisierung des Fundraising-Outreach

Gründer können die Daten nutzen, um Investoren zu identifizieren und zu priorisieren, die am ehesten in ihre spezifische Phase und ihren Sektor investieren.

- Listen von Investoren in Ihrer Branche scrapen (z. B. 'Top AI Seed Investors').

- Ergebnisse nach 'Zuletzt aktualisiert' filtern, um aktive Geldgeber zu finden.

- Export in ein CRM wie HubSpot oder Pipedrive zur Nachverfolgung.

- Profil-Links nutzen, um gemeinsame Kontakte für eine warme Einleitung zu identifizieren.

- Wettbewerbsanalyse der VC-Landschaft

Venture-Firmen können die Fokusbereiche und Teamerweiterungen anderer Firmen überwachen, um im Ökosystem wettbewerbsfähig zu bleiben.

- Regelmäßiges Scraping des Bereichs 'Firms' auf Signal, um Änderungen zu verfolgen.

- Identifizieren, welche Firmen neue 'Scouts' oder 'Angels' in ihr Netzwerk aufnehmen.

- Veränderungen im Investitionsschwerpunkt durch Überwachung der Sektorlisten-Zahlen im Zeitverlauf tracken.

- Geografische Expansionsstrategie

Unternehmen oder Investoren, die in neue Märkte eintreten wollen, können die wichtigsten Finanzakteure in spezifischen Regionen identifizieren.

- Regionalspezifische Listen wie 'LatAm', 'Israel' oder 'MENA' scrapen.

- Investoren nach Firmentyp (VC vs. Angel) kategorisieren, um den Kapitalmix zu verstehen.

- Das lokale Finanzierungsumfeld kartieren, um potenzielle Lead-Investoren für den Markteintritt zu finden.

- Beziehungs- und Intro-Mapping

Soziale Verbindungen analysieren, um den Weg des geringsten Widerstands für warme Einleitungen bei hochkarätigen VCs zu finden.

- Daten zu gegenseitigen Verbindungen und Social-Graph-Infos aus Investorenprofilen extrahieren.

- Die gescrapten Verbindungen mit dem eigenen LinkedIn-Netzwerk abgleichen.

- Outreach basierend auf der Stärke bestehender Netzwerkknoten priorisieren.

- Marktforschung zu aufstrebenden Sektoren

Analysieren, welche neuen Branchen die höchste Dichte im Venture-Graph gewinnen, um den nächsten Trend vorherzusagen.

- Spezifische Sektor-Tags und Mengen über verschiedene Finanzierungsphasen hinweg scrapen.

- Wachstum des Investoreninteresses in bestimmten Kategorien in Quartalsintervallen berechnen.

- Berichte für Stakeholder erstellen, wohin das 'Smart Money' aktuell fließt.

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Profi-Tipps für das Scrapen von Signal (by NFX)

Expertentipps für die erfolgreiche Datenextraktion von Signal (by NFX).

Gezielte sektor-spezifische URLs nutzen

Anstatt die gesamte Website zu crawlen, sollten Sie spezifische 'Investor List'-URLs für Sektoren wie SaaS oder Fintech verwenden, um vorkategorisierte und strukturierte Daten zu erhalten.

Residential Proxies verwenden

Leiten Sie Ihren Scraping-Traffic immer über hochwertige Residential Proxies, um das sofortige IP-Flagging zu vermeiden, das bei Rechenzentrum-Anbietern auf dieser Plattform üblich ist.

Zufällige Verzögerungen implementieren

Fügen Sie zufällige Pausenintervalle zwischen 3 und 7 Sekunden ein, um einen menschlichen Researcher zu simulieren, der die Profile liest. Dies hilft, das Auslösen von Rate Limits zu verhindern.

Session-Cookies wiederverwenden

Um verdächtige Aktivitäten zu minimieren, sollten Sie Ihre Login-Session über mehrere Anfragen hinweg beibehalten, anstatt sich für jede gescrapte Seite ein- und auszuloggen.

Interne XHR-Anfragen überwachen

Nutzen Sie Browser-Developer-Tools, um die Hintergrund-JSON-Endpunkte zu finden, die die Investorenlisten füllen, da diese oft sauberere Daten enthalten als das Roh-HTML.

Scraping in Nebenzeiten

Führen Sie umfangreiche Datenextraktions-Tasks am Wochenende oder in den späten Nachtstunden (US Eastern Time) aus, wenn der allgemeine Traffic und die Sicherheitsüberwachung der Plattform oft weniger restriktiv sind.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Häufig gestellte Fragen zu Signal (by NFX)

Finden Sie Antworten auf häufige Fragen zu Signal (by NFX)