Claude 3.7 Sonnet

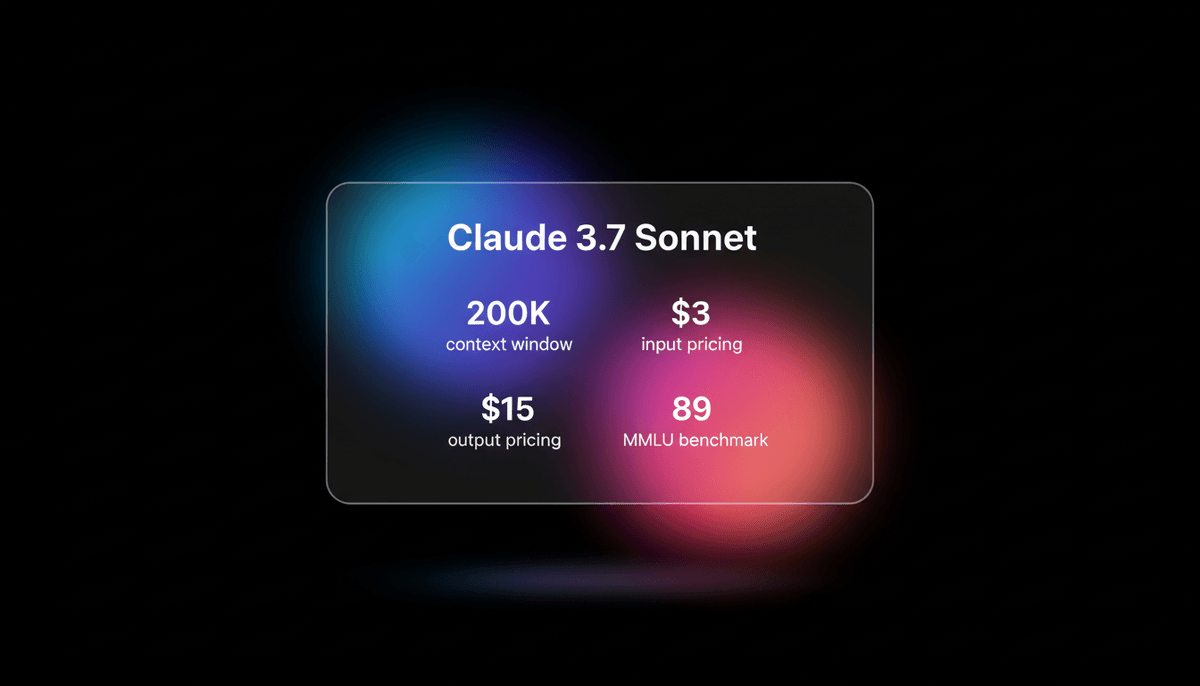

Claude 3.7 Sonnet ist das erste hybrid reasoning model von Anthropic. Es bietet state-of-the-art Coding-Fähigkeiten, ein 200k context window und sichtbare...

Über Claude 3.7 Sonnet

Erfahren Sie mehr über die Fähigkeiten, Funktionen und Einsatzmöglichkeiten von Claude 3.7 Sonnet.

Hybrid Reasoning und Transparenz

Claude 3.7 Sonnet stellt einen Meilenstein in der LLM-Architektur dar und ist das erste „hybrid reasoning“-model von Anthropic. Es erlaubt Nutzern, zwischen Standard-Antworten mit niedriger Latenz und einem „extended thinking“-Modus zu wechseln, der die interne chain-of-thought anzeigt. Diese Transparenz bietet Anwendern einen klaren Einblick in die Logik des models, was es besonders effektiv für komplexe Fehlersuche und kritische Denkaufgaben macht.

Meisterschaft im Software-Engineering

Mit einem starken Fokus auf Software-Engineering und produktionsreife Ergebnisse entwickelt, hat das model neue Branchenstandards in Benchmarks wie SWE-Bench Verified gesetzt. Es brilliert beim „Vibe Coding“, bei dem Entwickler grobe Absichten beschreiben und das model die Implementierung über mehrere Dateien hinweg übernimmt. Es bewältigt komplexe Refactorings und Architektur-Entscheidungen mit einer Präzision, die bisherige frontier models übertrifft.

Riesiger Context und agentic Tools

Mit einem massiven context window von 200.000 tokens und einem agentic Toolset namens Claude Code verwandelt es sich von einem einfachen Chatbot in einen kollaborativen technischen Partner. Es ist in der Lage, ganze Projektlebenszyklen zu verwalten – von der ersten Prüfung der Dokumentation bis hin zu automatisierten Git-Workflows und Testausführungen – und sorgt so für eine schnelle und fehlerfreie Entwicklung.

Anwendungsfälle für Claude 3.7 Sonnet

Entdecken Sie die verschiedenen Möglichkeiten, Claude 3.7 Sonnet für großartige Ergebnisse zu nutzen.

Vibe Coding

Erstellen funktionaler Software von Grund auf durch die Beschreibung der Absicht in natürlicher Sprache.

Advanced Debugging

Nutzung von extended thinking zur Analyse komplexer Logs und Bereitstellung präziser One-Shot-Fixes.

Large Context Analysis

Überprüfung und Refactoring ganzer Codebasen oder umfangreicher technischer Dokumentationen in einem einzigen prompt.

Agentic Development

Unterstützung von Terminal-basierten Tools wie Claude Code zur Automatisierung von Git-Workflows und Testausführungen.

Frontend UI Generation

Erstellung eleganter, wartbarer React- und Svelte-Komponenten mit intuitivem Designgespür.

Factual Research

Analyse massiver PDF-Dokumente und Datensätze mit hoher Genauigkeit und niedrigen Halluzinationsraten.

Stärken

Einschränkungen

API-Schnellstart

anthropic/claude-3.7-sonnet

import Anthropic from '@anthropic-ai/sdk';

const anthropic = new Anthropic({

apiKey: process.env.ANTHROPIC_API_KEY,

});

const msg = await anthropic.messages.create({

model: "claude-3-7-sonnet-20250219",

max_tokens: 1024,

thinking: { type: "enabled", budget_tokens: 1024 },

messages: [{ role: "user", content: "Write a high-performance Rust function for matrix multiplication." }],

});

console.log(msg.content);Installieren Sie das SDK und beginnen Sie in wenigen Minuten mit API-Aufrufen.

Was die Leute über Claude 3.7 Sonnet sagen

Sehen Sie, was die Community über Claude 3.7 Sonnet denkt

“Claude 3.7 Sonnet ist das beste Coding-AI-model der Welt; es hat mich bei anspruchsvollen Aufgaben völlig überzeugt.”

“Mit einem einzigen prompt hat es bei einem komplexen TypeScript-Projekt alles perfekt hinbekommen.”

“Claude Code mit Sonnet 3.7 ist viel besser als Cline und derzeit das beste Tool.”

“Der Qualitätssprung bei Top-Modellen wie 3.7 hat meine Sichtweise grundlegend verändert.”

“Claude 3.7 ist einfach krass, fühlt sich anders an... absolut goated, ohne Witz”

“Der reasoning-Modus von Claude 3.7 ist ein kompletter Paradigmenwechsel für das Debugging von Logik.”

Videos über Claude 3.7 Sonnet

Schauen Sie Tutorials, Rezensionen und Diskussionen über Claude 3.7 Sonnet

“Das neue 3.7 model hat alle anderen Modelle absolut deklassiert... es kann jetzt 70,3 % der GitHub-Issues lösen”

“Die Verwendung einer streng typisierten Sprache zusammen mit TDD sind Wege für die AI, zu validieren, dass der geschriebene Code tatsächlich gültig ist”

“Das model ist unglaublich intelligent bei der Befolgung von Anweisungen”

“Die Performance im SWE-bench ist wirklich wahnsinnig”

“Sichtbares reasoning ist ein Gamechanger für die Transparenz”

“Claude 3.7 Sonnet... es ist wahrscheinlich das beste LLM für Code-Generierung”

“Wenn man die API nutzt, kann man 128.000 tokens in einem Rutsch ausgeben”

“Das Limit von 128k output tokens ist ein massives Upgrade”

“Sein Design-Gespür für Frontend-Komponenten ist unerreicht”

“Tool-Use und agentic Fähigkeiten sind der Kern dieses models”

“Reasoning sollte eine integrierte Fähigkeit von frontier models sein und nicht ein völlig separates Modell”

“Claude 3.7 schafft es, diese Modelle [DeepSeek, o3] um ein beachtliches Stück zu übertreffen”

“Die Latenz ist im reasoning-Modus etwas höher”

“Es schlägt DeepSeek R1 bei mehreren Aufgaben zur Befolgung von Anweisungen”

“Anthropic hat sich wirklich auf produktionsreife Ergebnisse konzentriert”

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Pro-Tipps für Claude 3.7 Sonnet

Expertentipps, um das Beste aus Claude 3.7 Sonnet herauszuholen.

Thinking Budget

Nutzen Sie den 'extended thinking'-Modus gezielt für komplexe Logik oder Architekturplanung, um qualitativ hochwertigere Ergebnisse zu erzielen.

Context Control

Nutzen Sie regelmäßig /clear oder starten Sie Chats neu, um context-Kosten zu sparen und zu verhindern, dass das model träge wird.

Verification

Lassen Sie Claude mit dem Claude Code Tool Tests für den eigenen Code schreiben und ausführen, um die Stabilität in der Produktion zu gewährleisten.

Markdown Specs

Stellen Sie Feature-Anforderungen in strukturierten Markdown-Dateien bereit, um eine bessere Befolgung von Anweisungen bei großen Projekten zu erreichen.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte AI Models

Grok-3

xAI

Grok-3 is xAI's flagship reasoning model, featuring deep logic deduction, a 128k context window, and real-time integration with X for live research and coding.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Claude Sonnet 4.5

Anthropic

Anthropic's Claude Sonnet 4.5 delivers world-leading coding (77.2% SWE-bench) and a 200K context window, optimized for the next generation of autonomous agents.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Häufig gestellte Fragen zu Claude 3.7 Sonnet

Finden Sie Antworten auf häufige Fragen zu Claude 3.7 Sonnet