Claude Sonnet 4.5

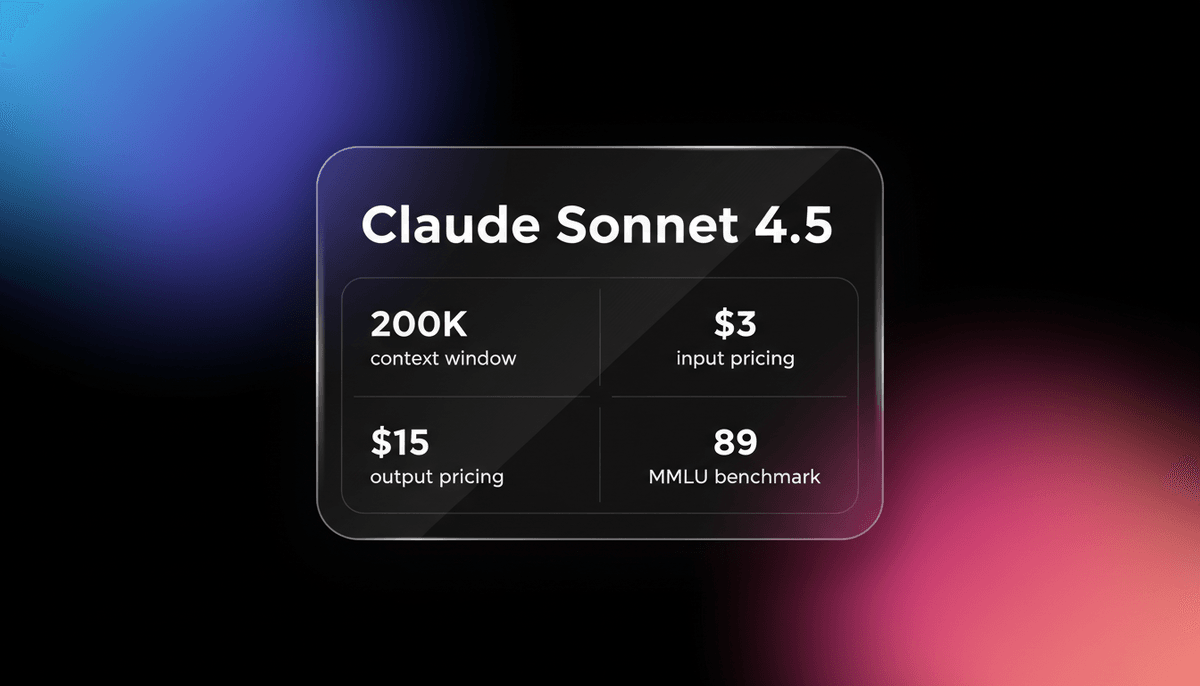

Anthropic’s Claude 4.5 Sonnet bietet branchenführende Coding-Performance (77,2 % im SWE-bench) und ein 200K context window, optimiert für die nächste...

Über Claude Sonnet 4.5

Erfahren Sie mehr über die Fähigkeiten, Funktionen und Einsatzmöglichkeiten von Claude Sonnet 4.5.

**Die Speerspitze der Agentic Intelligence**

Claude Sonnet 4.5 stellt Anthropics bedeutendsten Sprung in der "frontier intelligence" dar, speziell optimiert für die Ära der autonomen AI agents. Veröffentlicht Ende 2025, ist es das branchenweit erste echte "Hybrid Reasoning" Modell, das es Entwicklern ermöglicht, zwischen Hochgeschwindigkeits-Ausführung für Routineaufgaben und vertieftem Denken (extended thinking) für komplexe logische Herausforderungen zu wechseln. Es hat bisherige benchmarks in den Bereichen computer use und Tool-Orchestrierung deutlich übertroffen und ist damit die bevorzugte Engine für terminal-basierte agents und dateiübergreifendes Software-Engineering.

**Präzision und reduzierte Halluzinationen**

Das Modell basiert auf einer Architektur, die logisches Vorgehen nach dem Motto "lieber zweimal messen, einmal schneiden" priorisiert. Dadurch werden Sykophantie und Halluzinationen, wie man sie aus der 3.5-Serie kannte, signifikant reduziert. Mit einem massiven 64.000-token Output-Limit und einem 200.000-token Input-Fenster kann es ganze Repositories erfassen und gleichzeitig vollständige Anwendungsdateien in einem Durchgang generieren. Zudem führt es native "Checkpoints" für agentic Workflows ein, die es agents ermöglichen, Fehler eigenständig zurückzusetzen und zu korrigieren.

**Multimodale Exzellenz und Reasoning-Stärke**

Über das Coding hinaus dominiert Sonnet 4.5 bei der multimodalen Dokumentenanalyse und komplexen Finanzmodellierung. Seine interne Logik ist darauf trainiert, architektonischen Kontext zu priorisieren, wodurch es großflächige Codebasen besser erfassen kann als jeder Vorgänger. Ob bei der Verarbeitung handgeschriebener Notizen oder der Implementierung einer vollständigen Stripe-Integration – Sonnet 4.5 behält ein hohes Maß an faktischer Genauigkeit und Zuverlässigkeit bei der Befolgung von Anweisungen bei.

Anwendungsfälle für Claude Sonnet 4.5

Entdecken Sie die verschiedenen Möglichkeiten, Claude Sonnet 4.5 für großartige Ergebnisse zu nutzen.

Autonome Softwareentwicklung

Nutzen Sie Claude Sonnet 4.5, um in komplexen Codebasen zu navigieren, Features über mehrere Dateien hinweg zu implementieren und Tests unabhängig auszuführen.

Computer-Use Agents

Setzen Sie das Modell ein, um Desktops und Webbrowser für die Datenextraktion, die Navigation in Legacy-Systemen oder repetitive administrative Aufgaben zu steuern.

Agentic Search für Unternehmen

Orchestrieren Sie mehrstufige Suchanfragen und fassen Sie unterschiedliche Informationen aus internen Dokumentationen und dem Live-Web zusammen.

Komplexe Finanzmodellierung

Nutzen Sie den AIME-Score von 87 %, um tiefe logische Schlussfolgerungen aus Finanzberichten und Marktdaten zu ziehen.

Verfeinerung technischer Inhalte

Wandeln Sie Anforderungen auf hoher Ebene in professionelle PRDs, technische Spezifikationen und copy-paste-bereite Codebasen um.

Multimodale Dokumentenanalyse

Verarbeiten Sie Tausende von Seiten mit Diagrammen, handgeschriebenen Notizen und technischen Zeichnungen mit modernsten Vision-Fähigkeiten.

Stärken

Einschränkungen

API-Schnellstart

anthropic/claude-sonnet-4.5

import Anthropic from '@anthropic-ai/sdk';

const anthropic = new Anthropic({

apiKey: process.env.ANTHROPIC_API_KEY,

});

const msg = await anthropic.messages.create({

model: "claude-sonnet-4.5-20250929",

max_tokens: 1024,

messages: [{ role: "user", content: "Implement a rate limiter in Node.js" }],

});

console.log(msg.content[0].text);Installieren Sie das SDK und beginnen Sie in wenigen Minuten mit API-Aufrufen.

Was die Leute über Claude Sonnet 4.5 sagen

Sehen Sie, was die Community über Claude Sonnet 4.5 denkt

“Claude Sonnet 4.5 ist der neue König des AI Coding... es sieht wirklich, wirklich gut aus”

“Sonnet 4.5 leistet wirklich gute Arbeit... es war viel schneller und um einiges besser”

“Ich bin von Sonnet 4.5 überwältigt... dieses Modell entwirft absolut beeindruckende Seiten”

“Der terminal-basierte agent ist wie ein 'Entwickler, der in deinem Terminal lebt'... er kann Codebasen lesen und Tests autonom ausführen”

“Die Preise bleiben die gleichen wie bei 3.5, aber das 'Checkpoints'-Feature macht es für professionelle Workflows 10-mal wertvoller”

“Mit 77,2 % auf SWE-bench ist dies das erste Modell, das sich tatsächlich wie ein Senior Engineer anfühlt”

Videos über Claude Sonnet 4.5

Schauen Sie Tutorials, Rezensionen und Diskussionen über Claude Sonnet 4.5

“Anthropic behauptet, dies sei das 'beste Code-Modell der Welt' mit erheblichen Fortschritten bei reasoning, Mathematik und computer use.”

“Während GPT-5 vielleicht besser für die Planung auf hoher Ebene geeignet ist, ist Claude 4.5 Sonnet derzeit das 'angenehmste' Modell für die Implementierung.”

“Die Geschwindigkeit ist einfach unglaublich und lässt interaktives Coding viel flüssiger wirken.”

“Es beherrscht Bearbeitungen über mehrere Dateien hinweg mit einer Präzision, die wir so noch nicht gesehen haben.”

“Die Reduzierung von Halluzinationen macht es zu einem zuverlässigen Partner für produktiven Code.”

“Claude Sonnet 4.5 war um ein Vielfaches schneller und ein ordentliches Stück besser als GPT-5 Codex.”

“Es hat die gesamte Stripe-Implementierung in 15 Minuten erledigt... mehr als doppelt so schnell wie Opus 4.1.”

“Die Fähigkeit, komplexen Anweisungen für tool-calling zu folgen, ist sein Geheimrezept.”

“Ich sehe weniger Probleme mit 'Sykophantie', bei denen das Modell meinen schlechten Ideen einfach nur zustimmt.”

“Dies ist das erste Modell, dem ich tatsächlich zutrauen würde, einen terminal-basierten agent unbeaufsichtigt laufen zu lassen.”

“Dies ist eine der besten Landingpages, wenn nicht DIE beste, die ich je aus einem prompt erstellt gesehen habe.”

“Es ist ein absolutes Monster... es entwirft absolut beeindruckende Seiten mit wirklich, wirklich gutem Code.”

“Die Vision-Fähigkeiten zur Interpretation von UI-Design wurden deutlich verbessert.”

“Es fühlt sich an, als ob es die ästhetischen Anforderungen versteht, nicht nur die technischen.”

“Sonnet 4.5 ist offiziell der neue benchmark für kreatives Front-End-Engineering.”

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Pro-Tipps für Claude Sonnet 4.5

Expertentipps, um das Beste aus Claude Sonnet 4.5 herauszuholen.

Nutzen Sie CLAUDE.md

Verwenden Sie eine CLAUDE.md-Datei in Ihrem Repository-Root, um dem Modell kurze Zusammenfassungen und Hinweise zu geben; dies reduziert den token-Verbrauch um 30 %.

Hybrid Reasoning Toggle

Verwenden Sie den 'thinking'-Parameter in Ihren API-Aufrufen nur für logikintensive Aufgaben, um bei Routinevorgängen latency und Kosten zu sparen.

Der .claude/context-Ordner

Erstellen Sie eine .claude/context.md-Datei, um Architekturentscheidungen zu speichern; das Modell ist speziell darauf trainiert, diesen Pfad für das Mapping der Codebasis zu priorisieren.

Prompt Caching

Aktivieren Sie prompt caching für statische Dokumentationen oder große Codebasen, um bis zu 90 % der input-Kosten bei wiederholten Abfragen zu sparen.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte AI Models

Grok-3

xAI

Grok-3 is xAI's flagship reasoning model, featuring deep logic deduction, a 128k context window, and real-time integration with X for live research and coding.

Claude 3.7 Sonnet

Anthropic

Claude 3.7 Sonnet is Anthropic's first hybrid reasoning model, delivering state-of-the-art coding capabilities, a 200k context window, and visible thinking.

GPT-5.3 Codex

OpenAI

GPT-5.3 Codex is OpenAI's 2026 frontier coding agent, featuring a 400K context window, 77.3% Terminal-Bench score, and superior logic for complex software...

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Häufig gestellte Fragen zu Claude Sonnet 4.5

Finden Sie Antworten auf häufige Fragen zu Claude Sonnet 4.5