Qwen3-Coder-Next

Qwen3-Coder-Next ist das Elite Apache 2.0 Coding-model von Alibaba Cloud mit einer 80B MoE-Architektur und 256k context window für fortschrittliche lokale...

Über Qwen3-Coder-Next

Erfahren Sie mehr über die Fähigkeiten, Funktionen und Einsatzmöglichkeiten von Qwen3-Coder-Next.

Modell-Übersicht

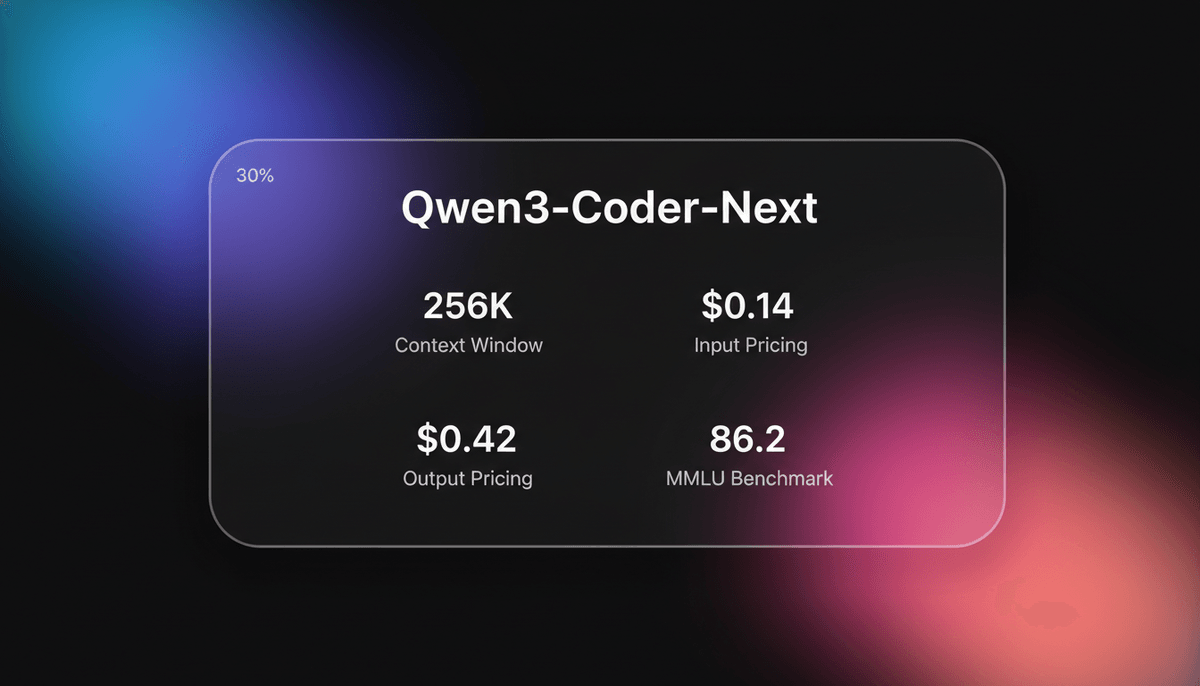

Qwen3-Coder-Next ist ein state-of-the-art Open-Weight-Sprachmodell des Qwen-Teams von Alibaba Cloud, das speziell für agentic coding und lokale Entwicklungsumgebungen optimiert wurde. Basierend auf der Qwen3-Next-80B-A3B-Base-Architektur nutzt es ein hochentwickeltes Mixture-of-Experts (MoE) Design mit Hybrid-Attention (Gated DeltaNet und Gated Attention). Dies erlaubt es dem model, eine massive Wissensbasis von 80 Milliarden parameters beizubehalten, während es nur 3 Milliarden parameters pro token aktiviert. Das Ergebnis ist reasoning auf flagship-Niveau bei einer inference-Geschwindigkeit und einem Speicherbedarf eines deutlich kleineren models.

Fokus auf Agentic-Fähigkeiten

Das model markiert einen Wendepunkt hin zur Skalierung von agentic Training-Signalen anstatt nur der reinen Parameteranzahl. Es wurde mit über 800.000 verifizierbaren Coding-Aufgaben in ausführbaren Umgebungen trainiert, wodurch es lernt, direkt auf Feedback aus der Umgebung zu reagieren. Dieses spezialisierte Trainingsrezept betont Long-Horizon-reasoning, tool use und die Fähigkeit, sich von Ausführungsfehlern zu erholen – Fähigkeiten, die für moderne „vibe coding“ Workflows und autonome agentic Frameworks wie OpenClaw entscheidend sind.

Lokale Performance

Mit einem nativen 256K context window, das weiter extrapoliert werden kann, ist Qwen3-Coder-Next als der leistungsfähigste Local-First-Coding-Assistent positioniert. Veröffentlicht unter der Apache 2.0 Lizenz, befähigt es Entwickler, ganze Codebasen in einer sicheren, privaten Umgebung zu erstellen, zu debuggen und zu deployen, ohne auf proprietäre Cloud-APIs angewiesen zu sein.

Anwendungsfälle für Qwen3-Coder-Next

Entdecken Sie die verschiedenen Möglichkeiten, Qwen3-Coder-Next für großartige Ergebnisse zu nutzen.

Lokale agentic Entwicklung

Betrieb von autonomen Coding-agents, die Software lokal planen, ausführen und debuggen können, ohne dass sensible Daten den Rechner verlassen.

Komplexes Web-Prototyping

Erstellung funktionaler Full-Stack-Anwendungen, einschließlich 3D-Visualisierungen und interaktiver Spiele, aus einfachen Natural-Language-prompts.

Analyse großer Repositories

Nutzung des 256k context window, um komplette Dateistrukturen zu erfassen und für Refactoring und Optimierung zu analysieren.

Automatisierte Sicherheits-Audits

Scannen von Codebasen auf komplexe Schwachstellen wie SQL-Injection und offenliegende Zugangsdaten mit fundierten Korrekturvorschlägen.

Zusammenfassung technischer Forschung

Scraping und Parsing dichter akademischer oder technischer Dokumentationen zur Erstellung organisierter, direkt nutzbarer HTML-Berichte.

Sprachübergreifende Systemmigration

Übersetzung komplexer Geschäftslogik und hardwarespezifischer Constraints zwischen verschiedenen Programmiersprachen mit hoher Genauigkeit.

Stärken

Einschränkungen

API-Schnellstart

alibaba/qwen-3-coder-next

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.DASHSCOPE_API_KEY,

baseURL: 'https://dashscope.aliyuncs.com/compatible-mode/v1'

});

async function main() {

const completion = await client.chat.completions.create({

model: 'qwen-3-coder-next',

messages: [{ role: 'user', content: 'Write a React hook for debouncing a value.' }],

});

console.log(completion.choices[0].message.content);

}

main();Installieren Sie das SDK und beginnen Sie in wenigen Minuten mit API-Aufrufen.

Was die Leute über Qwen3-Coder-Next sagen

Sehen Sie, was die Community über Qwen3-Coder-Next denkt

“Dieses model ist unglaublich gut für das Programmieren und hält dem Vergleich mit der Konkurrenz locker stand”

“Die Architektur ermöglicht eine enorme Kontextlänge, ohne den VRAM-Bedarf explodieren zu lassen”

“Alibaba dominiert den Open-Weights-Bereich mit dieser MoE-Architektur”

“Endlich ein lokales model, das 256k Kontext verarbeitet, ohne sich wie eine Schnecke anzufühlen”

“Ich sehe ein stabiles decoding von ~7,8 tok/s auf der CPU, was für einen lokalen Code-Reviewer völlig ausreicht”

“Qwen3 Coder ist im Grunde der Endgegner für lokale Entwicklungs-Setups.”

Videos über Qwen3-Coder-Next

Schauen Sie Tutorials, Rezensionen und Diskussionen über Qwen3-Coder-Next

“Wir haben hier eine 256k Kontextlänge, die sehr robust ist, besonders für etwas, das man lokal ausführen kann.”

“Wir erhalten unser Ergebnis mit einer Geschwindigkeit von 26,17 tokens pro Sekunde... ein ziemlich umfangreiches Ergebnis.”

“Dies ist ein sehr spannendes model... es zeigt extremes Potenzial für agentic coding.”

“Die Genauigkeit bei Python-Aufgaben ist für ein Open-Weights-model einfach umwerfend.”

“Ich denke, dieses model macht kostenpflichtige Coding-Assistenten für die meisten Entwickler offiziell überflüssig.”

“Es basiert auf einem model mit 3 Milliarden active parameters bei insgesamt 80 Milliarden parameters.”

“Es ist nicht nur ein Coding-AI-model mit 200k context window... es ist absolut intuitiv.”

“Für normale Nutzer reicht es, das model zu bitten, eine Webseite zu scrapen, den Inhalt zu analysieren und einen sauberen Bericht zu erstellen.”

“Die Art und Weise, wie es Multi-File-Projekte lokal handhabt, ist ein Gamechanger für die Privatsphäre.”

“Function calling fühlt sich im Vergleich zur Vorgängerversion viel reaktionsschneller an.”

“Schreibt Geschichten mit 62 tokens pro Sekunde. Boom. Das war schnell.”

“Wir geben jetzt richtig Gas... 150 tokens pro Sekunde mit batching... das ist wahnsinnig.”

“Dieses Autorennspiel war tatsächlich besser als die Version von Claude... das muss man ihm lassen.”

“Die MoE-Architektur glänzt wirklich, wenn man sich die Token-pro-Watt-Effizienz ansieht.”

“Quantization scheint der Logik nicht so sehr zu schaden, wie ich erwartet hätte.”

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Pro-Tipps für Qwen3-Coder-Next

Expertentipps, um das Beste aus Qwen3-Coder-Next herauszuholen.

Hardware-Bandbreitenoptimierung

Stellen Sie bei der 80B-Skala sicher, dass Ihr System Speicher mit hoher Kanalanzahl nutzt, um inference-Engpässe bei reinen CPU-Setups zu vermeiden.

Iteratives Debugging

Geben Sie die runtime-Fehler des models direkt zurück in den prompt; es ist speziell darauf trainiert, Ausführungsfehler zu erkennen und seine Logik zu verfeinern.

Kontextreiches Prompting

Maximieren Sie das 256k context window, indem Sie relevante Abhängigkeitsdateien und Architekturdiagramme bereitstellen, um Halluzinationen zu reduzieren.

Ästhetische Verfeinerung

Fordern Sie bei der Generierung von UIs explizit Farben und CSS-Übergänge an, um die Standardtendenz des models zu minimalistischen Layouts zu überschreiben.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte AI Models

MiniMax M2.5

minimax

MiniMax M2.5 is a SOTA MoE model featuring a 1M context window and elite agentic coding capabilities at disruptive pricing for autonomous agents.

GLM-5

Zhipu (GLM)

GLM-5 is Zhipu AI's 744B parameter open-weight powerhouse, excelling in long-horizon agentic tasks, coding, and factual accuracy with a 200k context window.

GPT-5.4

OpenAI

GPT-5.4 is OpenAI's frontier model featuring a 1.05M context window and Extreme Reasoning. It excels at autonomous UI interaction and long-form data analysis.

Gemini 3.1 Flash-Lite

Gemini 3.1 Flash-Lite is Google's fastest, most cost-efficient model. Features 1M context, native multimodality, and 363 tokens/sec speed for scale.

GPT-5.3 Instant

OpenAI

Explore GPT-5.3 Instant, OpenAI's "Anti-Cringe" model. Features a 128K context window, 26.8% fewer hallucinations, and a natural, helpful tone for everyday...

Gemini 3.1 Pro

Gemini 3.1 Pro is Google's elite multimodal model featuring the DeepThink reasoning engine, a 1M+ context window, and industry-leading ARC-AGI logic scores.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Häufig gestellte Fragen zu Qwen3-Coder-Next

Finden Sie Antworten auf häufige Fragen zu Qwen3-Coder-Next