Comment scraper BureauxLocaux : Guide des données de l'immobilier d'entreprise

Extrayez les données immobilières de BureauxLocaux. Scrapez les prix des bureaux, l'emplacement des entrepôts et les détails des agents en France pour vos...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- CSRF Protection

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- User-Agent Filtering

- Défi JavaScript

- Nécessite l'exécution de JavaScript pour accéder au contenu. Les requêtes simples échouent ; un navigateur headless comme Playwright ou Puppeteer est nécessaire.

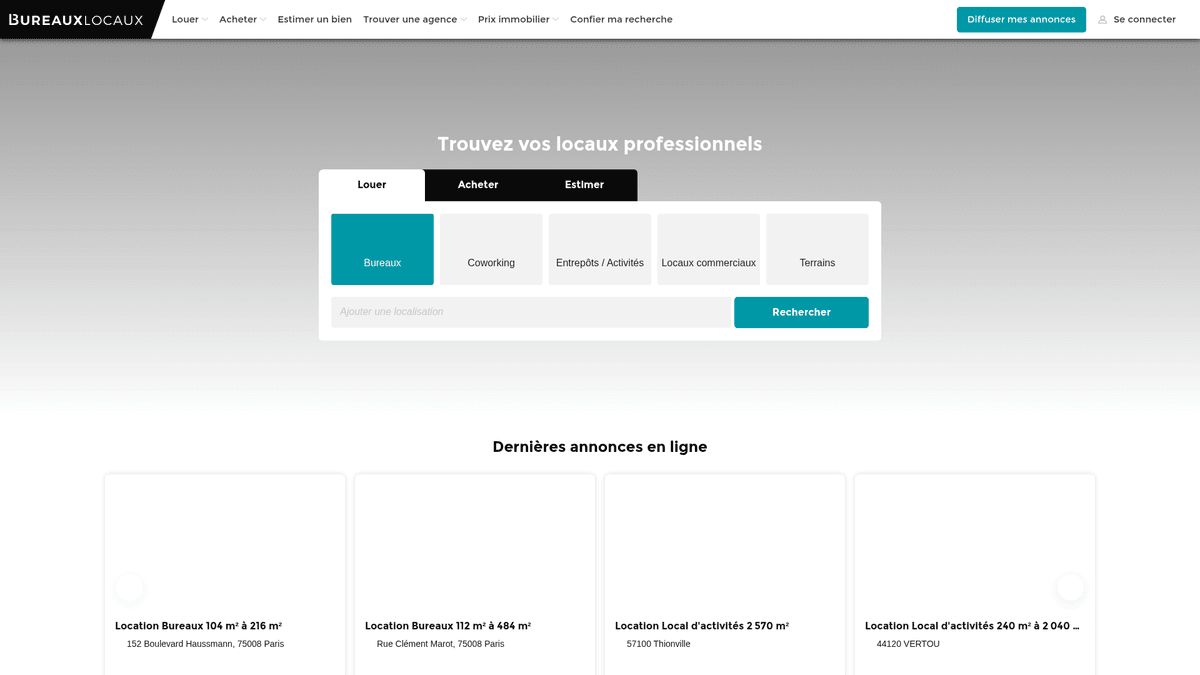

À Propos de BureauxLocaux

Découvrez ce que BureauxLocaux offre et quelles données précieuses peuvent être extraites.

La plateforme de référence de l'immobilier professionnel en France

BureauxLocaux est la première plateforme numérique en France dédiée à l'immobilier professionnel, facilitant la location et la vente de bureaux, d'entrepôts, de locaux commerciaux et d'espaces de coworking. Propriété du CoStar Group, la plateforme centralise les données de plus de 1 800 agences spécialisées et héberge plus de 72 000 annonces actives, ce qui en fait une source incontournable pour l'analyse du marché B2B.

Intelligence de marché complète

La plateforme offre une vue granulaire du paysage commercial français, des quartiers d'affaires parisiens très prisés aux hubs logistiques de Lyon et Marseille. Elle sert de pont vital entre les entreprises en recherche de locaux et les courtiers spécialisés, fournissant des spécifications techniques détaillées qui vont bien au-delà du simple prix.

Pourquoi ces données sont cruciales

Scraper BureauxLocaux est essentiel pour les promoteurs immobiliers, les investisseurs et les urbanistes. Les annonces de la plateforme fournissent des données en temps réel sur les tendances des prix de location, les taux de vacance et les diagnostics de performance énergétique (DPE), des éléments critiques pour construire des modèles de marché prédictifs et identifier des opportunités d'investissement à haut rendement.

Pourquoi Scraper BureauxLocaux?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de BureauxLocaux.

Intelligence du marché immobilier d'entreprise

Surveillez en temps réel les fluctuations des prix de location et de vente pour les bureaux et les entrepôts à travers les différentes régions françaises afin d'identifier les pôles d'activité émergents.

Génération de leads B2B

Identifiez les agences immobilières commerciales spécialisées dans des niches spécifiques comme la logistique ou le commerce de luxe pour proposer des services professionnels tels que l'aménagement de bureaux ou l'assurance.

Sourcing d'opportunités d'investissement

Détectez les propriétés sous-évaluées ou les opportunités de sous-location urgentes dans les quartiers d'affaires parisiens de premier plan en suivant les baisses de prix et la durée de publication des annonces.

Suivi de l'offre industrielle

Analysez la disponibilité et les spécifications techniques des entrepôts industriels et des installations de stockage pour soutenir la planification de la logistique et de la supply chain.

Analyse des indicateurs économiques

Utilisez les taux de vacance commerciale et la disponibilité des surfaces comme indicateurs avancés de la croissance ou du déclin économique régional dans les grandes villes françaises.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de BureauxLocaux.

Protection avancée DataDome

BureauxLocaux utilise DataDome, un système sophistiqué de gestion des bots qui identifie et bloque les navigateurs headless grâce à l'analyse comportementale et du fingerprint.

Infos de contact verrouillées par interaction

Les données sensibles comme les numéros de téléphone des agents sont souvent cachées derrière des boutons nécessitant un clic physique, ce qui peut déclencher des défis de vérification supplémentaires.

Restrictions géographiques du trafic

Le site limite fréquemment ou bloque carrément le trafic provenant d'adresses IP non européennes pour empêcher les tentatives de scraping mondiales tout en servant les utilisateurs locaux.

Formats de données fragmentés

Les prix sont répertoriés de manière incohérente : prix par poste de travail, prix au m2/an ou loyer mensuel total, ce qui nécessite une logique de normalisation complexe lors de l'extraction.

Scrapez BureauxLocaux avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de BureauxLocaux. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur BureauxLocaux, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de BureauxLocaux sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de BureauxLocaux. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur BureauxLocaux, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Contournement de la sécurité DataDome: Automatio est conçu pour naviguer à travers les boucliers anti-bots avancés comme DataDome sans déclencher de blocages, garantissant une collecte de données constante.

- Extraction visuelle de données: Le sélecteur visuel no-code vous permet de pointer et cliquer sur des attributs techniques complexes comme les diagnostics de performance énergétique ou les équipements du bâtiment sans écrire de sélecteurs CSS personnalisés.

- Proxys français intégrés: Connectez facilement des proxys résidentiels français pour imiter un comportement de navigation local, ce qui est essentiel pour accéder aux annonces régionales et éviter les blocages liés à la réputation de l'IP.

- Interactions UI automatisées: Configurez l'outil pour gérer automatiquement la bannière de consentement aux cookies Axeptio et cliquer sur les boutons 'Voir le numéro' pour capturer les coordonnées cachées.

Scrapers Web No-Code pour BureauxLocaux

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper BureauxLocaux sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour BureauxLocaux

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper BureauxLocaux sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

# Note : Cela peut être bloqué par Cloudflare sans headers/proxies avancés

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Exemple : Sélection des cartes d'annonces

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Annonce : {title} | Prix : {price}')

except Exception as e:

print(f'Échec du scraping : {e}')Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper BureauxLocaux avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Note : Cela peut être bloqué par Cloudflare sans headers/proxies avancés

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Exemple : Sélection des cartes d'annonces

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Annonce : {title} | Prix : {price}')

except Exception as e:

print(f'Échec du scraping : {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Le lancement avec un mode furtif (stealth) ou un UA spécifique est recommandé

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Naviguer vers les résultats de recherche

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Attendre que les annonces soient rendues

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contacter l'agent"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Boucle à travers chaque carte de propriété sur la page

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Pagination : Trouver le lien vers la page suivante

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Définir un User-Agent réaliste

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Extraire les données des éléments de l'annonce

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de BureauxLocaux

Explorez les applications pratiques et les insights des données de BureauxLocaux.

Indexation des loyers commerciaux

Les analystes financiers peuvent construire un index dynamique des coûts de location de bureaux pour conseiller les clients entreprises sur leur stratégie d'implantation.

Comment implémenter :

- 1Scraper chaque semaine toutes les annonces de bureaux actives dans les principales villes françaises.

- 2Calculer le prix par mètre carré par an pour chaque entrée.

- 3Grouper les données par arrondissement pour identifier les pôles de prix.

- 4Visualiser la 'Heatmap des prix' à l'aide d'un outil de cartographie comme Tableau.

Utilisez Automatio pour extraire des données de BureauxLocaux et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de BureauxLocaux

- Indexation des loyers commerciaux

Les analystes financiers peuvent construire un index dynamique des coûts de location de bureaux pour conseiller les clients entreprises sur leur stratégie d'implantation.

- Scraper chaque semaine toutes les annonces de bureaux actives dans les principales villes françaises.

- Calculer le prix par mètre carré par an pour chaque entrée.

- Grouper les données par arrondissement pour identifier les pôles de prix.

- Visualiser la 'Heatmap des prix' à l'aide d'un outil de cartographie comme Tableau.

- Génération de leads immobiliers

Les prestataires de services B2B peuvent identifier les entreprises qui emménagent dans de nouveaux espaces nécessitant une installation informatique, du mobilier ou une assurance.

- Cibler les annonces marquées comme 'Récemment disponible' ou 'Nouveau sur le marché'.

- Extraire les coordonnées de l'agence immobilière pour des campagnes de partenariat.

- Suivre la suppression des annonces pour estimer quand une entreprise a signé un bail.

- Automatiser la création d'une fiche CRM pour de nouveaux projets potentiels de rénovation de bureaux.

- Suivi de la durée de vacance

Les chercheurs en économie peuvent surveiller combien de temps les propriétés industrielles restent sur le marché pour évaluer la santé économique locale.

- Scraper toutes les annonces d'entrepôts et enregistrer leur date de première parution.

- Vérifier continuellement quelles annonces sont toujours actives par rapport à celles supprimées.

- Calculer la durée moyenne de mise sur le marché (Time on Market - ToM) pour chaque zone industrielle.

- Corréler un ToM élevé avec des ralentissements économiques régionaux spécifiques.

- Automatisation du filtrage d'investissement

Les investisseurs peuvent recevoir des alertes instantanées lorsque des biens passent sous un certain seuil de prix dans des zones spécifiques.

- Configurer un scraping quotidien pour des catégories spécifiques comme 'Vente de Bureaux'.

- Comparer le prix du jour à la moyenne historique pour ce code postal spécifique.

- Déclencher une notification si une annonce est affichée à un prix 15 % inférieur à la moyenne du marché.

- Exporter les offres filtrées vers un Google Sheet pour une révision immédiate.

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper BureauxLocaux

Conseils d'experts pour extraire avec succès les données de BureauxLocaux.

Prioriser les IP résidentielles françaises

L'utilisation de proxys basés en France est le moyen le plus efficace d'éviter d'être signalé par les filtres de sécurité régionaux du site.

Prendre en compte les suffixes fiscaux

Assurez-vous que vos parseurs de prix reconnaissent les mentions 'HT' (Hors Taxes) et 'HC' (Hors Charges) pour calculer avec précision le coût total des annonces professionnelles.

Surveiller les requêtes XHR internes

Inspectez le trafic réseau pour trouver les points de terminaison JSON internes que le site utilise pour charger les annonces, afin d'obtenir une extraction plus efficace et structurée.

Mettre en œuvre des délais aléatoires

Introduisez des temps d'attente variables entre les chargements de pages et les interactions pour reproduire les comportements de navigation humains et rester en dessous des seuils de rate-limiting.

Gérer les consentements aux cookies en priorité

Assurez-vous que votre scraper interagit avec la modale de consentement aux cookies ou la masque dès l'arrivée sur le site pour éviter qu'elle ne recouvre et bloque l'accès aux éléments de l'annonce.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Questions Fréquentes sur BureauxLocaux

Trouvez des réponses aux questions courantes sur BureauxLocaux