Comment scraper SeLoger Bureaux & Commerces

Découvrez comment scraper SeLoger Bureaux & Commerces pour obtenir des données d'immobilier commercial. Extrayez prix, surfaces et infos d'agences en...

Protection Anti-Bot Détectée

- DataDome

- Détection de bots en temps réel avec des modèles ML. Analyse l'empreinte d'appareil, les signaux réseau et les schémas comportementaux. Courant sur les sites e-commerce.

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Google reCAPTCHA

- Système CAPTCHA de Google. v2 nécessite une interaction utilisateur, v3 fonctionne silencieusement avec un score de risque. Peut être résolu avec des services CAPTCHA.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- Blocage IP

- Bloque les IP de centres de données connues et les adresses signalées. Nécessite des proxys résidentiels ou mobiles pour contourner efficacement.

- Empreinte navigateur

- Identifie les bots par les caractéristiques du navigateur : canvas, WebGL, polices, plugins. Nécessite du spoofing ou de vrais profils de navigateur.

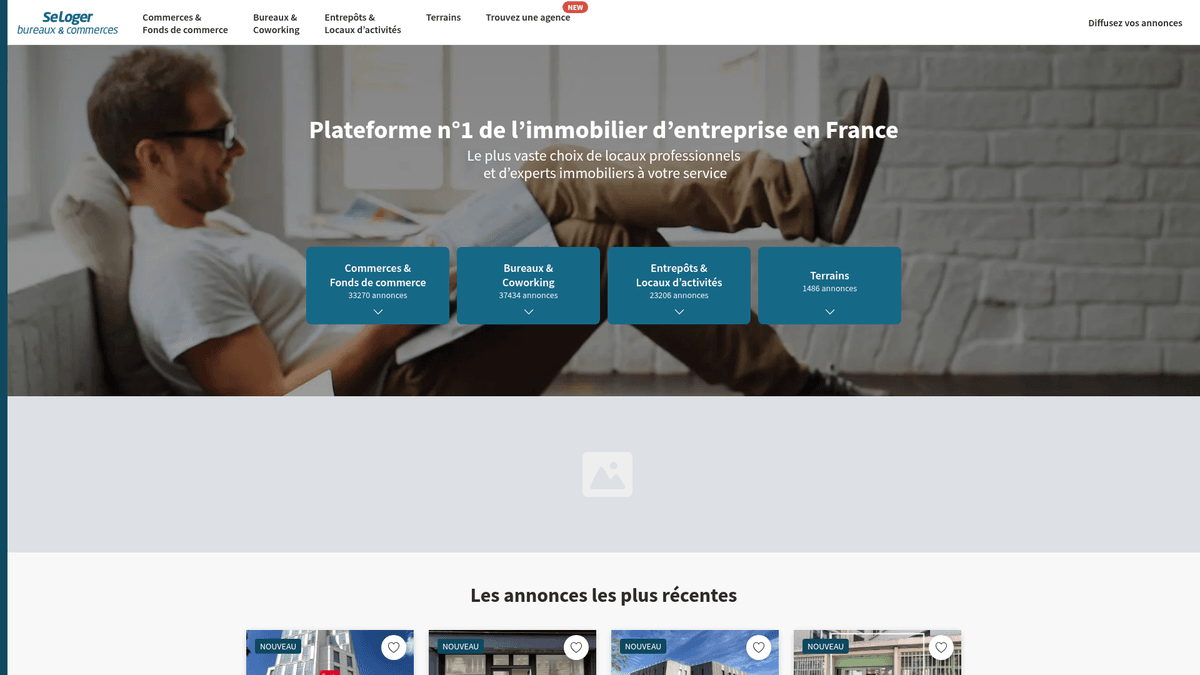

À Propos de SeLoger Bureaux & Commerces

Découvrez ce que SeLoger Bureaux & Commerces offre et quelles données précieuses peuvent être extraites.

Le leader de l'immobilier commercial en France

SeLoger Bureaux & Commerces est le portail immobilier professionnel spécialisé du Groupe SeLoger, le premier réseau immobilier en France. Il sert de place de marché dédiée aux transactions inter-entreprises, proposant des bureaux, des entrepôts, des fonds de commerce et des terrains commerciaux. La plateforme est utilisée par les plus grandes agences nationales et des courtiers indépendants pour entrer en contact avec des investisseurs professionnels et des chefs d'entreprise dans tout le pays.

Valeur des données

Le scraping de ce site est extrêmement précieux pour les investisseurs immobiliers et les analystes de marché qui doivent surveiller le paysage immobilier commercial français. En extrayant les données des annonces actuelles, les entreprises peuvent suivre les tendances du prix au mètre carré, identifier les pôles commerciaux émergents et surveiller les portefeuilles des agences concurrentes. Ces données sont essentielles pour réaliser des estimations immobilières précises et identifier des opportunités d'investissement à haut rendement sur le marché français.

Pourquoi Scraper SeLoger Bureaux & Commerces?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de SeLoger Bureaux & Commerces.

Analyse du rendement commercial

Suivez les rendements locatifs et les prix de vente pour identifier les régions les plus rentables pour les investissements immobiliers commerciaux sur le territoire français.

Suivi de l'inventaire des concurrents

Surveillez la taille des portefeuilles et le roulement des annonces des agences immobilières rivales pour évaluer leur part de marché dans des villes et départements spécifiques.

Prospects de relocalisation d'entreprises

Identifiez les entreprises qui libèrent ou emménagent dans de nouveaux bureaux pour proposer des services B2B tels que le déménagement professionnel, la rénovation intérieure ou l'assurance d'entreprise.

Aperçus du développement urbain

Collectez des données sur les taux de vacance commerciale et la densité des boutiques pour informer les projets d'urbanisme et les stratégies de développement économique local des municipalités.

Alertes de prix en temps réel

Surveillez des départements spécifiques à forte demande pour détecter les nouvelles annonces dont le prix est inférieur à la moyenne du marché afin de saisir des opportunités d'investissement sous-évaluées.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de SeLoger Bureaux & Commerces.

Protection avancée DataDome

La plateforme utilise DataDome pour analyser les mouvements de souris, les signatures matérielles et les schémas comportementaux afin de bloquer instantanément les visiteurs automatisés.

Filtres WAF Cloudflare

Des règles de pare-feu agressives identifient et rejettent les requêtes provenant de datacenters ou celles présentant des empreintes TLS incohérentes qui ne correspondent pas à de vrais navigateurs.

Rendu lourd en JavaScript

En tant qu'application Next.js moderne, le contenu est dynamique, ce qui signifie que les scrapers HTML standards ne voient souvent que des balises vides au lieu des données réelles de l'annonce.

Limites de pagination du contenu

Les résultats de recherche sont souvent limités à un maximum de 1 000 annonces, nécessitant des requêtes de recherche granulaires par code postal pour extraire l'ensemble complet des données.

Éléments de contact masqués

Les numéros de téléphone des agents sont fréquemment dissimulés derrière des boutons interactifs qui nécessitent des déclencheurs d'événements spécifiques pour révéler les données de contact sous-jacentes.

Scrapez SeLoger Bureaux & Commerces avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de SeLoger Bureaux & Commerces. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur SeLoger Bureaux & Commerces, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de SeLoger Bureaux & Commerces sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de SeLoger Bureaux & Commerces. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur SeLoger Bureaux & Commerces, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Évasion anti-bot intégrée: Automatio utilise une technologie avancée pour imiter le matériel et les signatures de navigateur humains, vous permettant de contourner DataDome et Cloudflare sans configuration.

- Sélection visuelle No-code: L'interface visuelle vous permet de pointer et cliquer pour sélectionner les prix, les surfaces et les diagnostics de performance énergétique sans écrire ni maintenir de code complexe.

- Intégration de proxies français: Connectez facilement des proxies résidentiels français pour garantir que vos sessions de scraping apparaissent comme un trafic local légitime provenant du pays cible.

- Flux multi-étapes automatisés: Configurez des séquences complexes incluant le clic sur des boutons masqués et la navigation à travers des structures de pagination profondes, le tout automatiquement dans le cloud.

Scrapers Web No-Code pour SeLoger Bureaux & Commerces

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper SeLoger Bureaux & Commerces sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour SeLoger Bureaux & Commerces

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper SeLoger Bureaux & Commerces sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

# Note : SeLoger utilise DataDome ; les requêtes standards seront probablement bloquées.

# Des bibliothèques spécialisées comme curl_cffi sont recommandées pour le TLS fingerprinting.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Utilisation de impersonate pour contourner les blocs de TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Exemple de sélecteur pour les titres de biens

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Annonce: {title.get_text(strip=True)}')

else:

print(f'Bloqué par l\'anti-bot. Code statut: {response.status_code}')

except Exception as e:

print(f'Erreur rencontrée: {e}')Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper SeLoger Bureaux & Commerces avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Note : SeLoger utilise DataDome ; les requêtes standards seront probablement bloquées.

# Des bibliothèques spécialisées comme curl_cffi sont recommandées pour le TLS fingerprinting.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Utilisation de impersonate pour contourner les blocs de TLS fingerprinting

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Exemple de sélecteur pour les titres de biens

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Annonce: {title.get_text(strip=True)}')

else:

print(f'Bloqué par l\'anti-bot. Code statut: {response.status_code}')

except Exception as e:

print(f'Erreur rencontrée: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_bucom():

async with async_playwright() as p:

# Headless=False aide à éviter certains déclencheurs de détection de bot basiques

browser = await p.chromium.launch(headless=False)

context = await browser.new_context(

user_agent='Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36'

)

page = await context.new_page()

try:

# Cible une catégorie commerciale spécifique et une ville

await page.goto('https://www.seloger-bureaux-commerces.com/achat/bureau/lyon', wait_until='networkidle')

# Attente du rendu des cartes d'annonces

await page.wait_for_selector('div[data-testid="listing-card"]', timeout=15000)

listings = await page.query_selector_all('div[data-testid="listing-card"]')

for card in listings:

title = await card.query_selector('h2')

price = await card.query_selector('span[class*="Price"]')

print(f"Titre: {await title.inner_text()} | Prix: {await price.inner_text()}")

except Exception as e:

print(f'Le scraping a échoué: {e}')

finally:

await browser.close()

asyncio.run(scrape_bucom())Python + Scrapy

import scrapy

class SeLogerBucomSpider(scrapy.Spider):

name = 'bucom_spider'

allowed_domains = ['seloger-bureaux-commerces.com']

start_urls = ['https://www.seloger-bureaux-commerces.com/location/boutique']

custom_settings = {

'DOWNLOAD_DELAY': 5,

'RANDOMIZE_DOWNLOAD_DELAY': True,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'COOKIES_ENABLED': True

}

def parse(self, response):

# Extraction des données depuis le conteneur des résultats

for listing in response.css('div[class*="Card_container"]'):

yield {

'title': listing.css('h2::text').get(),

'price': listing.css('span[class*="Price"]::text').get(),

'surface': listing.css('span[class*="Surface"]::text').get(),

'link': listing.css('a::attr(href)').get()

}

# Gestion simple de la pagination

next_page = response.css('a[class*="PaginationNext"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Émulation d'un comportement humain avec viewport et agent

await page.setViewport({ width: 1280, height: 800 });

try {

await page.goto('https://www.seloger-bureaux-commerces.com/location/bureau/paris', {

waitUntil: 'networkidle2'

});

const results = await page.evaluate(() => {

return Array.from(document.querySelectorAll('a[class*="Card_title"]')).map(el => ({

title: el.innerText,

url: el.href

}));

});

console.log(results);

} catch (err) {

console.error('Erreur d\'extraction :', err);

} finally {

await browser.close();

}

})();Que Pouvez-Vous Faire Avec Les Données de SeLoger Bureaux & Commerces

Explorez les applications pratiques et les insights des données de SeLoger Bureaux & Commerces.

Indice des prix des loyers commerciaux

Établir un benchmark des loyers commerciaux à travers les différents départements français pour l'évaluation immobilière.

Comment implémenter :

- 1Scraper mensuellement toutes les annonces actives pour les régions ciblées.

- 2Nettoyer et normaliser les données de prix et de surface dans une unité standard.

- 3Agréger le prix moyen au mètre carré par ville et par type de bien.

- 4Visualiser les tendances dans un outil BI comme Tableau ou PowerBI.

Utilisez Automatio pour extraire des données de SeLoger Bureaux & Commerces et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de SeLoger Bureaux & Commerces

- Indice des prix des loyers commerciaux

Établir un benchmark des loyers commerciaux à travers les différents départements français pour l'évaluation immobilière.

- Scraper mensuellement toutes les annonces actives pour les régions ciblées.

- Nettoyer et normaliser les données de prix et de surface dans une unité standard.

- Agréger le prix moyen au mètre carré par ville et par type de bien.

- Visualiser les tendances dans un outil BI comme Tableau ou PowerBI.

- Veille concurrentielle des agences

Suivre l'inventaire et la performance des agences immobilières concurrentes sur le marché français.

- Extraire les noms des agents/agences et les numéros de référence des biens.

- Identifier combien de temps les biens restent en ligne avant d'être retirés.

- Analyser la part de marché d'agences spécifiques dans les quartiers à forte valeur.

- Générer des rapports sur les stratégies tarifaires des concurrents.

- Génération de leads pour relocalisation B2B

Identifier les entreprises susceptibles de déménager ou de s'agrandir dans de nouveaux espaces de bureaux.

- Filtrer les annonces marquées comme 'Nouveau' ou 'Disponible immédiatement'.

- Surveiller des immeubles de bureaux spécifiques pour voir quand les locataires actuels partent.

- Croiser les adresses scrapées avec les bases de données d'immatriculation des entreprises.

- Contacter les entreprises en cours de déménagement avec des offres de services adaptées.

- Détection d'arbitrage d'investissement

Signaler automatiquement les propriétés dont le prix est nettement inférieur à la moyenne du marché local.

- Établir des moyennes de référence en utilisant 6 mois de données historiques scrapées.

- Mettre en place un scraper quotidien pour les nouvelles annonces commerciales.

- Calculer le prix au m² pour chaque nouvelle annonce et le comparer à la référence.

- Déclencher une notification email instantanée pour les annonces 20 % en dessous de la moyenne.

- Planification d'expansion commerciale

Trouver l'emplacement idéal pour de nouveaux points de vente en fonction de la disponibilité et des coûts du quartier.

- Scraper la disponibilité des boutiques dans plusieurs centres-villes.

- Cartographier la densité des espaces commerciaux disponibles à l'aide des données GPS.

- Analyser la corrélation entre les proxies de flux piétons et les prix des loyers.

- Exporter les résultats vers un système SIG pour une analyse spatiale.

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper SeLoger Bureaux & Commerces

Conseils d'experts pour extraire avec succès les données de SeLoger Bureaux & Commerces.

Privilégier les IP résidentielles françaises

L'utilisation de proxies résidentiels locaux français est le moyen le plus efficace d'éviter les blocages basés sur la géolocalisation et de réduire l'apparition de captchas.

Extraire les métadonnées JSON-LD

Recherchez les données schema.org dans le code source de la page, car elles fournissent souvent une version plus propre et structurée des détails du bien immobilier.

Aléatoriser le comportement interactif

Implémentez des pauses aléatoires et des vitesses de défilement variables pour rendre vos sessions de navigation automatisées indiscernables d'une étude de marché humaine réelle.

Subdiviser les zones de recherche

Au lieu de rechercher par régions entières, effectuez le scraping par codes postaux individuels pour vous assurer de ne pas atteindre la limite de visibilité des résultats de la plateforme.

Se synchroniser avec la structure du site

Surveillez les mises à jour de la mise en page du site toutes les quelques semaines, car la plateforme ajuste fréquemment les classes CSS pour décourager les méthodes d'extraction de données statiques.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Questions Fréquentes sur SeLoger Bureaux & Commerces

Trouvez des réponses aux questions courantes sur SeLoger Bureaux & Commerces