Comment scraper We Work Remotely : Le guide ultime

Apprenez à scraper les offres d'emploi de We Work Remotely. Extrayez les titres de postes, les entreprises, les salaires et plus encore pour vos études de...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Blocage IP

- Bloque les IP de centres de données connues et les adresses signalées. Nécessite des proxys résidentiels ou mobiles pour contourner efficacement.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

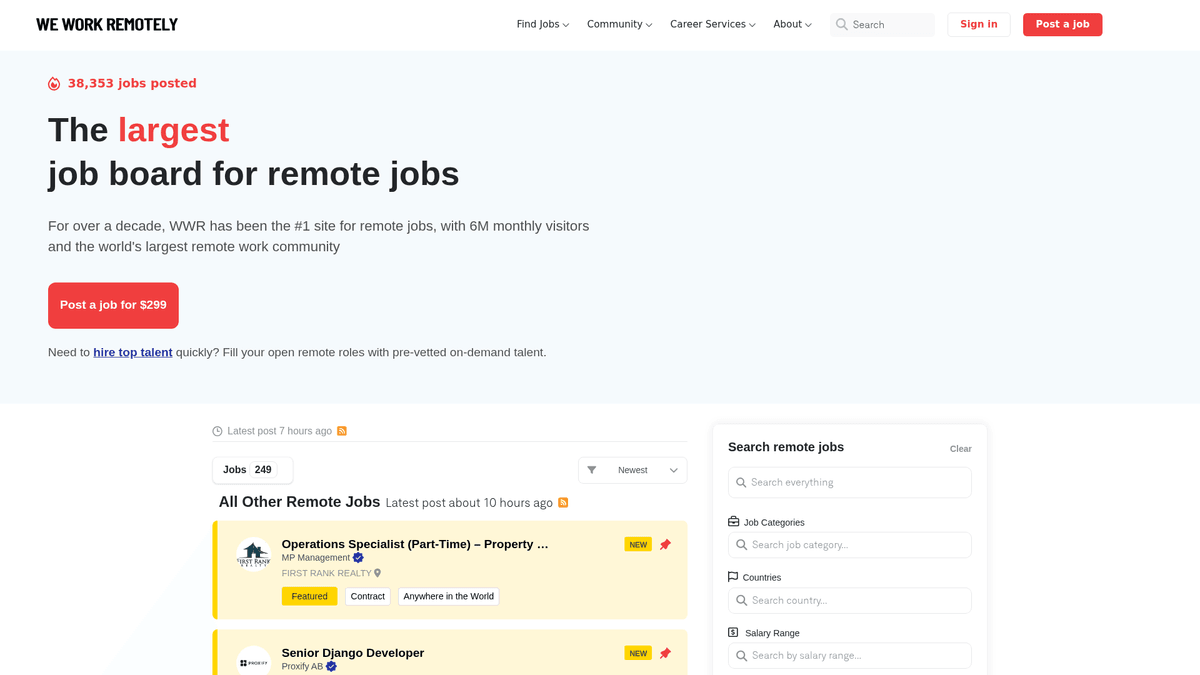

À Propos de We Work Remotely

Découvrez ce que We Work Remotely offre et quelles données précieuses peuvent être extraites.

Le centre mondial des talents en télétravail

We Work Remotely (WWR) est la communauté de télétravail la plus établie au monde, attirant plus de 6 millions de visiteurs mensuels. C'est une destination privilégiée pour les entreprises qui abandonnent les modèles traditionnels basés sur le bureau, offrant une gamme variée d'annonces dans le développement logiciel, le design, le marketing et le support client.

Données structurées de haute qualité

La plateforme est reconnue pour ses données hautement structurées. Chaque annonce contient généralement des exigences régionales spécifiques, des échelles salariales et des profils d'entreprise détaillés. Cette structure en fait une cible idéale pour le web scraping, car les données sont cohérentes et faciles à catégoriser pour des cas d'usage secondaires.

Valeur stratégique pour les professionnels des données

Pour les recruteurs et les chercheurs de marché, WWR est une mine d'or. Le scraping de ce site permet un suivi en temps réel des tendances de recrutement, un benchmark des salaires dans différents secteurs techniques et la génération de leads pour les services B2B ciblant les entreprises « remote-first ». Il offre une vue transparente du marché mondial du travail à distance.

Pourquoi Scraper We Work Remotely?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de We Work Remotely.

Analyse de la demande du marché

Suivez les langages de programmation, les frameworks et les soft skills qui sont à la mode dans le paysage du travail à distance pour anticiper les évolutions du marché.

Benchmark des salaires

Extrayez les données salariales des annonces pour créer des rapports de rémunération complets pour les entreprises remote-first dans divers rôles techniques et créatifs.

Génération de leads B2B

Identifiez les entreprises qui développent activement leurs équipes à distance pour proposer des services spécialisés comme les technologies RH, les solutions de paie ou le conseil en recrutement.

Agrégation d'offres d'emploi de niche

Alimentez un job board spécialisé en filtrant et en agrégeant des annonces de haute qualité dans des niches spécifiques comme le Web3, l'AI ou le Design.

Veille concurrentielle

Surveillez la vitesse d'embauche et les préférences géographiques de vos concurrents pour comprendre leur stratégie de croissance et leurs zones d'expansion potentielles.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de We Work Remotely.

Détection de bots Cloudflare

WWR utilise la couche de sécurité de Cloudflare, qui peut détecter et bloquer les scripts automatisés standards qui n'imitent pas correctement le comportement d'un navigateur humain.

Données salariales non structurées

Les informations sur les salaires sont souvent intégrées dans les descriptions textuelles sous divers formats, nécessitant des schémas regex complexes pour les extraire et les normaliser en valeurs numériques.

Chargement de contenu dynamique

Naviguer entre les listes générales et la pagination 'Load More' nécessite un scraper capable de gérer des requêtes asynchrones sans perdre l'intégrité des données.

Structures HTML variables

Les annonces mises en avant et les annonces standards utilisent parfois des classes CSS légèrement différentes, nécessitant des sélecteurs flexibles pour s'assurer qu'aucun emploi n'est oublié.

Scrapez We Work Remotely avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de We Work Remotely. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur We Work Remotely, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de We Work Remotely sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de We Work Remotely. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur We Work Remotely, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Gestion automatisée anti-bot: Automatio gère nativement la rotation des proxies et le fingerprinting du navigateur pour contourner Cloudflare et d'autres mesures de sécurité sans configuration manuelle.

- Sélection visuelle No-Code: Sélectionnez facilement les titres de postes, les noms d'entreprises et les descriptions à l'aide d'une interface pointer-cliquer plutôt que d'écrire des sélecteurs CSS ou XPath complexes.

- Surveillance planifiée: Configurez votre scraper pour qu'il s'exécute chaque heure ou chaque jour afin de détecter et d'extraire automatiquement les nouvelles offres d'emploi à distance dès qu'elles sont publiées.

- Exportation de données fluide: Transférez directement vos offres d'emploi scrapées vers Google Sheets, Airtable ou un Webhook pour alimenter votre application ou votre CRM en temps réel.

Scrapers Web No-Code pour We Work Remotely

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper We Work Remotely sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour We Work Remotely

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper We Work Remotely sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Send request with custom headers

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Target job listings

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper We Work Remotely avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Send request with custom headers

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Target job listings

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Job: {title} | Company: {company}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Launch headless browser

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Wait for the main container to load

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Iterate through listing items

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Extract data using evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de We Work Remotely

Explorez les applications pratiques et les insights des données de We Work Remotely.

Agrégateur d'emplois à distance

Créez une plateforme de recherche d'emploi spécialisée pour des niches techniques spécifiques comme Rust ou l'IA.

Comment implémenter :

- 1Scraper WWR quotidiennement pour les nouvelles annonces

- 2Filtrer par mots-clés et catégories spécifiques

- 3Stocker les données dans une base de données consultable

- 4Automatiser les publications sur les réseaux sociaux pour les nouveaux postes

Utilisez Automatio pour extraire des données de We Work Remotely et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de We Work Remotely

- Agrégateur d'emplois à distance

Créez une plateforme de recherche d'emploi spécialisée pour des niches techniques spécifiques comme Rust ou l'IA.

- Scraper WWR quotidiennement pour les nouvelles annonces

- Filtrer par mots-clés et catégories spécifiques

- Stocker les données dans une base de données consultable

- Automatiser les publications sur les réseaux sociaux pour les nouveaux postes

- Analyse des tendances salariales

Analysez les données salariales du télétravail pour définir des benchmarks de rémunération mondiaux par poste.

- Extraire les champs de salaire des descriptions de poste

- Normaliser les données dans une devise unique

- Segmenter par rôle et niveau d'expérience

- Générer des rapports de marché trimestriels

- Génération de leads pour la HR Tech

Identifiez les entreprises qui recrutent massivement des équipes à distance pour vendre des logiciels de RH, de paie et d'avantages sociaux.

- Surveiller la liste des « Top 100 Remote Companies »

- Suivre la fréquence des nouvelles offres d'emploi

- Identifier les décideurs dans les entreprises qui recrutent

- Prospecter avec des solutions B2B personnalisées

- Tendances historiques de recrutement

Analysez les données à long terme pour comprendre comment la demande de télétravail évolue selon les saisons ou le contexte économique.

- Archiver les annonces sur plus de 12 mois

- Calculer les taux de croissance par catégorie

- Visualiser les tendances à l'aide d'outils BI

- Prédire la demande future en compétences

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper We Work Remotely

Conseils d'experts pour extraire avec succès les données de We Work Remotely.

Analysez d'abord les flux RSS

Consultez les points de terminaison /remote-jobs.rss pour les différentes catégories ; ils offrent du XML structuré nettement plus facile et rapide à parser que le HTML principal.

Utilisez des URL spécifiques aux catégories

Ciblez des URL comme /categories/remote-programming-jobs pour obtenir des résultats plus propres et éviter le bruit de la page d'accueil principale.

Utilisez une rotation de proxies résidentiels

Pour éviter le rate limiting sur les pages de détails, utilisez des proxies résidentiels qui sont moins susceptibles d'être signalés comme des bots par rapport aux IP de datacenter.

Ciblez les métadonnées JSON-LD

De nombreuses pages d'emploi incluent des données structurées au format JSON-LD dans le HTML, ce qui fournit des données propres et prêtes à l'emploi pour les titres et descriptions de postes.

Aléatorisez les intervalles de requête

Implémentez des délais de type humain entre les clics sur les différentes annonces pour empêcher la sécurité du site d'identifier un schéma robotique.

Surveillez la section 'Top 100'

Scrapez la page 'Top 100 Companies' séparément pour identifier les cibles de recrutement à haute valeur qui publient régulièrement sur la plateforme.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Questions Fréquentes sur We Work Remotely

Trouvez des réponses aux questions courantes sur We Work Remotely