Cara Melakukan Scraping WebElements: Panduan Data Tabel Periodik

Ekstrak data unsur kimia yang presisi dari WebElements. Lakukan scraping berat atom, properti fisik, dan riwayat penemuan untuk riset dan aplikasi AI.

Tentang WebElements

Temukan apa yang ditawarkan WebElements dan data berharga apa yang dapat diekstrak.

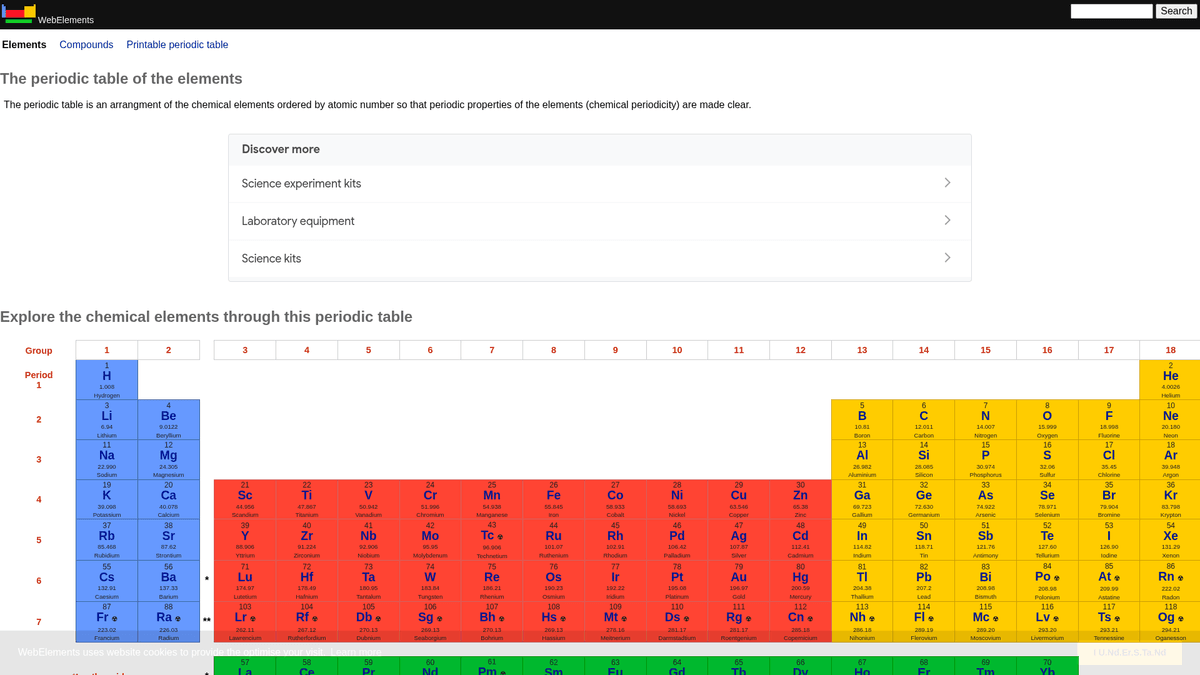

WebElements adalah tabel periodik online terkemuka yang dikelola oleh Mark Winter di University of Sheffield. Diluncurkan pada tahun 1993, ini adalah tabel periodik pertama di World Wide Web dan sejak itu menjadi sumber otoritas tinggi bagi mahasiswa, akademisi, dan ahli kimia profesional. Situs ini menawarkan data terstruktur yang mendalam tentang setiap unsur kimia yang dikenal, mulai dari berat atom standar hingga konfigurasi elektronik yang kompleks.

Nilai dari scraping WebElements terletak pada data ilmiah berkualitas tinggi yang telah ditinjau sejawat. Bagi pengembang yang membangun alat edukasi, peneliti yang melakukan analisis tren di seluruh tabel periodik, atau ilmuwan material yang melatih model machine learning, WebElements menyediakan sumber kebenaran yang andal dan kaya secara teknis yang sulit untuk dikumpulkan secara manual.

Mengapa Melakukan Scraping WebElements?

Temukan nilai bisnis dan kasus penggunaan untuk ekstraksi data dari WebElements.

Pengumpulan data ilmiah berkualitas tinggi untuk pengembangan alat edukasi.

Menggabungkan properti unsur untuk riset ilmu material dan model machine learning.

Pengisian otomatis sistem inventaris laboratorium dengan spesifikasi kimia.

Analisis historis penemuan unsur dan kemajuan ilmiah.

Pembuatan dataset properti kimia yang komprehensif untuk publikasi akademik.

Tantangan Scraping

Tantangan teknis yang mungkin Anda hadapi saat melakukan scraping WebElements.

Data tersebar di beberapa sub-halaman per unsur (misalnya, /history, /compounds).

Tata letak HTML berbasis tabel yang lebih lama memerlukan logika seleksi yang presisi.

Kebingungan nama domain dengan class 'WebElement' milik Selenium saat mencari bantuan.

Scrape WebElements dengan AI

Tanpa koding. Ekstrak data dalam hitungan menit dengan otomatisasi berbasis AI.

Cara Kerjanya

Jelaskan apa yang Anda butuhkan

Beritahu AI data apa yang ingin Anda ekstrak dari WebElements. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

AI mengekstrak data

Kecerdasan buatan kami menjelajahi WebElements, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

Dapatkan data Anda

Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Mengapa menggunakan AI untuk scraping

AI memudahkan scraping WebElements tanpa menulis kode. Platform berbasis kecerdasan buatan kami memahami data apa yang Anda inginkan — cukup jelaskan dalam bahasa sehari-hari dan AI akan mengekstraknya secara otomatis.

How to scrape with AI:

- Jelaskan apa yang Anda butuhkan: Beritahu AI data apa yang ingin Anda ekstrak dari WebElements. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

- AI mengekstrak data: Kecerdasan buatan kami menjelajahi WebElements, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

- Dapatkan data Anda: Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Why use AI for scraping:

- Navigasi tanpa kode (no-code) melalui struktur unsur hierarkis.

- Menangani ekstraksi tabel ilmiah yang kompleks secara otomatis.

- Eksekusi cloud memungkinkan ekstraksi seluruh dataset tanpa downtime lokal.

- Ekspor mudah ke CSV/JSON untuk penggunaan langsung dalam alat analisis ilmiah.

- Pemantauan terjadwal dapat mendeteksi pembaruan pada data unsur yang telah dikonfirmasi.

Web Scraper Tanpa Kode untuk WebElements

Alternatif klik-dan-pilih untuk scraping berbasis AI

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping WebElements tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

Tantangan Umum

Kurva pembelajaran

Memahami selector dan logika ekstraksi membutuhkan waktu

Selector rusak

Perubahan situs web dapat merusak seluruh alur kerja

Masalah konten dinamis

Situs berbasis JavaScript memerlukan solusi yang kompleks

Keterbatasan CAPTCHA

Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

Pemblokiran IP

Scraping agresif dapat menyebabkan IP Anda diblokir

Web Scraper Tanpa Kode untuk WebElements

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping WebElements tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

- Instal ekstensi browser atau daftar di platform

- Navigasi ke situs web target dan buka alat

- Pilih elemen data yang ingin diekstrak dengan point-and-click

- Konfigurasikan selector CSS untuk setiap field data

- Atur aturan paginasi untuk scraping beberapa halaman

- Tangani CAPTCHA (sering memerlukan penyelesaian manual)

- Konfigurasikan penjadwalan untuk eksekusi otomatis

- Ekspor data ke CSV, JSON atau hubungkan melalui API

Tantangan Umum

- Kurva pembelajaran: Memahami selector dan logika ekstraksi membutuhkan waktu

- Selector rusak: Perubahan situs web dapat merusak seluruh alur kerja

- Masalah konten dinamis: Situs berbasis JavaScript memerlukan solusi yang kompleks

- Keterbatasan CAPTCHA: Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

- Pemblokiran IP: Scraping agresif dapat menyebabkan IP Anda diblokir

Contoh Kode

import requests

from bs4 import BeautifulSoup

import time

# URL target untuk unsur tertentu (misalnya, Emas)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Mengekstrak nama unsur dari tag H1

name = soup.find('h1').get_text().strip()

# Mengekstrak Nomor Atom menggunakan logika label tabel

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Unsur: {name}, Nomor Atom: {atomic_number}')

except Exception as e:

print(f'Terjadi kesalahan: {e}')

# Mengikuti rekomendasi robots.txt

time.sleep(1)

scrape_element(url)Kapan Digunakan

Terbaik untuk halaman HTML statis di mana konten dimuat di sisi server. Pendekatan tercepat dan paling sederhana ketika rendering JavaScript tidak diperlukan.

Kelebihan

- ●Eksekusi tercepat (tanpa overhead browser)

- ●Konsumsi sumber daya terendah

- ●Mudah diparalelkan dengan asyncio

- ●Bagus untuk API dan halaman statis

Keterbatasan

- ●Tidak dapat mengeksekusi JavaScript

- ●Gagal pada SPA dan konten dinamis

- ●Mungkin kesulitan dengan sistem anti-bot kompleks

How to Scrape WebElements with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# URL target untuk unsur tertentu (misalnya, Emas)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Mengekstrak nama unsur dari tag H1

name = soup.find('h1').get_text().strip()

# Mengekstrak Nomor Atom menggunakan logika label tabel

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Unsur: {name}, Nomor Atom: {atomic_number}')

except Exception as e:

print(f'Terjadi kesalahan: {e}')

# Mengikuti rekomendasi robots.txt

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Unsur ditautkan dari tabel periodik utama

page.goto('https://www.webelements.com/iron/')

# Tunggu hingga tabel properti muncul

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Ikuti setiap tautan unsur dalam tabel periodik

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Data yang Diekstrak:', data);

await browser.close();

})();Apa yang Dapat Anda Lakukan Dengan Data WebElements

Jelajahi aplikasi praktis dan wawasan dari data WebElements.

Pelatihan AI Ilmu Material

Melatih model machine learning untuk memprediksi properti paduan baru berdasarkan atribut elemental.

Cara mengimplementasikan:

- 1Ekstrak properti fisik untuk semua unsur logam.

- 2Bersihkan dan normalisasi nilai seperti massa jenis dan titik lebur.

- 3Masukkan data ke dalam model regresi atau prediktif material.

- 4Verifikasi prediksi terhadap data paduan eksperimental yang ada.

Gunakan Automatio untuk mengekstrak data dari WebElements dan membangun aplikasi ini tanpa menulis kode.

Apa yang Dapat Anda Lakukan Dengan Data WebElements

- Pelatihan AI Ilmu Material

Melatih model machine learning untuk memprediksi properti paduan baru berdasarkan atribut elemental.

- Ekstrak properti fisik untuk semua unsur logam.

- Bersihkan dan normalisasi nilai seperti massa jenis dan titik lebur.

- Masukkan data ke dalam model regresi atau prediktif material.

- Verifikasi prediksi terhadap data paduan eksperimental yang ada.

- Konten Aplikasi Edukasi

Mengisi tabel periodik interaktif untuk siswa kimia dengan data yang ditinjau sejawat.

- Lakukan scraping nomor atom, simbol, dan deskripsi unsur.

- Ekstrak konteks sejarah dan detail penemuan.

- Atur data berdasarkan golongan dan blok periodik.

- Integrasikan ke dalam antarmuka pengguna dengan struktur kristal visual.

- Analisis Tren Kimia

Memvisualisasikan tren periodik seperti energi ionisasi atau jari-jari atom di seluruh periode dan golongan.

- Kumpulkan data properti untuk setiap unsur dalam urutan numerik.

- Kategorikan unsur ke dalam golongan masing-masing.

- Gunakan library grafik untuk memvisualisasikan tren.

- Identifikasi dan analisis titik data anomali dalam blok tertentu.

- Manajemen Inventaris Laboratorium

Mengisi sistem manajemen kimia secara otomatis dengan data keselamatan fisik dan massa jenis.

- Petakan daftar inventaris internal ke entri WebElements.

- Lakukan scraping data massa jenis, bahaya penyimpanan, dan titik lebur.

- Perbarui database lab terpusat melalui API.

- Hasilkan peringatan keselamatan otomatis untuk unsur berisiko tinggi.

Tingkatkan alur kerja Anda dengan Otomatisasi AI

Automatio menggabungkan kekuatan agen AI, otomatisasi web, dan integrasi cerdas untuk membantu Anda mencapai lebih banyak dalam waktu lebih singkat.

Tips Pro untuk Scraping WebElements

Saran ahli untuk ekstraksi data yang sukses dari WebElements.

Patuhi Crawl-delay

1 yang ditentukan dalam file robots.txt situs tersebut.

Gunakan Nomor Atom sebagai primary key untuk konsistensi database.

Lakukan crawling pada sub-halaman 'history' dan 'compounds' untuk mendapatkan dataset lengkap per unsur.

Fokus pada selector berbasis tabel karena struktur situs ini sangat tradisional dan stabil.

Verifikasi data terhadap standar IUPAC jika digunakan untuk riset kritis.

Simpan nilai numerik seperti massa jenis atau titik lebur sebagai float untuk memudahkan analisis.

Testimoni

Apa Kata Pengguna Kami

Bergabunglah dengan ribuan pengguna puas yang telah mengubah alur kerja mereka

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Terkait Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Pertanyaan yang Sering Diajukan tentang WebElements

Temukan jawaban untuk pertanyaan umum tentang WebElements