Come estrarre dati da BureauxLocaux: Guida ai dati immobiliari commerciali

Estrai dati immobiliari commerciali da BureauxLocaux. Ottieni prezzi di uffici, posizioni di magazzini e dettagli degli agenti in tutta la Francia per ricerche...

Protezione Anti-Bot Rilevata

- Cloudflare

- WAF e gestione bot di livello enterprise. Usa sfide JavaScript, CAPTCHA e analisi comportamentale. Richiede automazione del browser con impostazioni stealth.

- CSRF Protection

- Rate Limiting

- Limita le richieste per IP/sessione nel tempo. Può essere aggirato con proxy rotanti, ritardi nelle richieste e scraping distribuito.

- User-Agent Filtering

- Sfida JavaScript

- Richiede l'esecuzione di JavaScript per accedere al contenuto. Le richieste semplici falliscono; serve un browser headless come Playwright o Puppeteer.

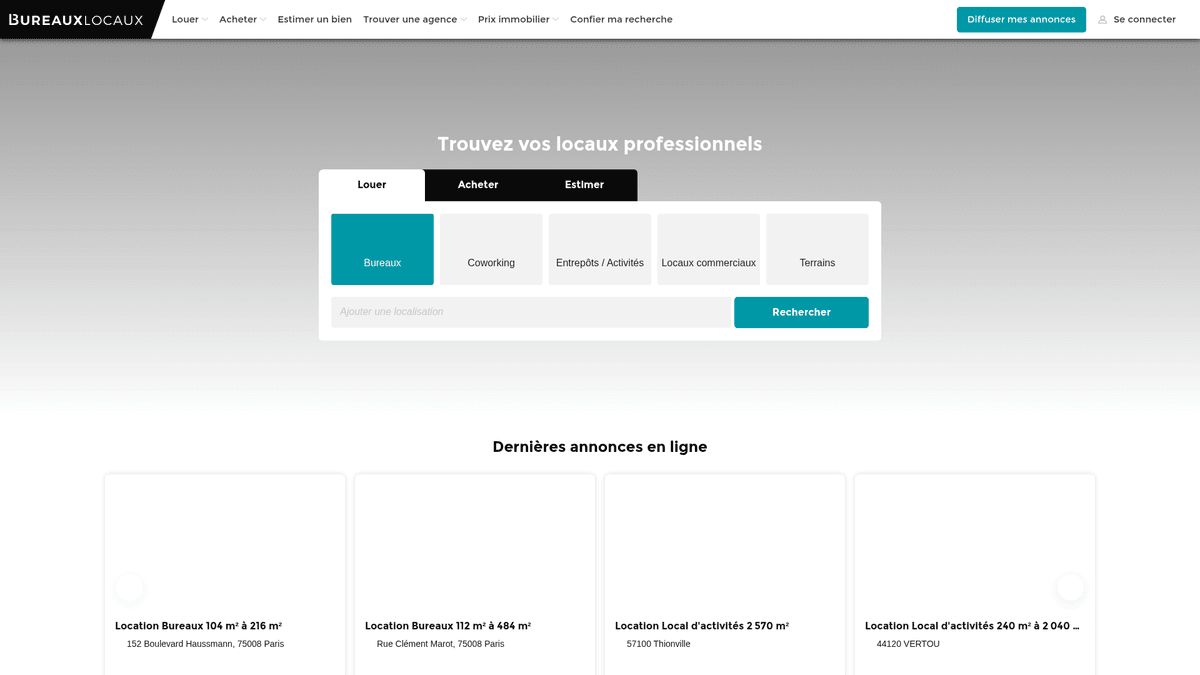

Informazioni Su BureauxLocaux

Scopri cosa offre BureauxLocaux e quali dati preziosi possono essere estratti.

Il Marketplace Immobiliare Professionale Francese

BureauxLocaux è la principale piattaforma digitale in Francia dedicata all'immobiliare professionale, facilitando l'affitto e la vendita di uffici, magazzini, spazi commerciali e hub di coworking. Di proprietà di CoStar Group, la piattaforma centralizza i dati di oltre 1.800 agenzie specializzate e ospita più di 72.000 annunci attivi, rendendola una fonte definitiva per gli insight immobiliari B2B.

Market Intelligence Completa

La piattaforma offre una visione granulare del panorama commerciale francese, dai distretti d'affari parigini ad alta richiesta fino ai poli logistici di Lione e Marsiglia. Funge da ponte vitale tra chi cerca immobili e i broker specializzati, fornendo specifiche tecniche dettagliate che vanno oltre il semplice prezzo.

Perché i dati sono importanti

Estrarre dati da BureauxLocaux è essenziale per sviluppatori immobiliari, investitori e pianificatori urbani. Gli annunci della piattaforma forniscono dati in tempo reale sui trend dei prezzi di affitto, tassi di sfitto e valutazioni delle prestazioni energetiche (DPE), critici per costruire modelli predittivi di mercato e identificare opportunità di investimento ad alto rendimento.

Perché Fare Scraping di BureauxLocaux?

Scopri il valore commerciale e i casi d'uso per l'estrazione dati da BureauxLocaux.

Market Intelligence commerciale

Monitora in tempo reale le fluttuazioni dei prezzi di affitto e vendita per uffici e magazzini in diverse regioni francesi per identificare i poli logistici emergenti.

Lead Generation B2B

Identifica le agenzie immobiliari commerciali specializzate in nicchie specifiche come la logistica o il retail di lusso per offrire servizi professionali come allestimenti per uffici o assicurazioni.

Ricerca di opportunità di investimento

Individua proprietà sottovalutate o opportunità urgenti di sublocazione nei principali distretti commerciali parigini tracciando i cali di prezzo e la durata dell'annuncio.

Tracciamento delle forniture industriali

Analizza la disponibilità e le specifiche tecniche di magazzini industriali e strutture di stoccaggio per supportare la logistica e la pianificazione della supply chain.

Analisi degli indicatori economici

Utilizza i tassi di sfitto commerciale e la disponibilità di metratura come indicatori principali per la crescita o il declino economico regionale nelle principali città francesi.

Sfide dello Scraping

Sfide tecniche che potresti incontrare durante lo scraping di BureauxLocaux.

Protezione avanzata DataDome

BureauxLocaux utilizza DataDome, un sofisticato sistema di gestione dei bot che identifica e blocca i browser headless attraverso l'analisi comportamentale e del fingerprint.

Informazioni di contatto vincolate all'interazione

I dati sensibili come i numeri di telefono degli agenti sono spesso nascosti dietro pulsanti che richiedono un clic fisico per essere rivelati, il che può innescare ulteriori sfide di verifica.

Restrizioni geografiche del traffico

Il sito spesso limita o blocca del tutto il traffico proveniente da indirizzi IP non europei per prevenire tentativi di scraping globale mentre serve gli utenti locali.

Formati di dati frammentati

I prezzi sono elencati in modo incoerente come prezzo per postazione, prezzo per m2/anno o affitto mensile totale, richiedendo una logica di normalizzazione complessa durante l'estrazione.

Scraping di BureauxLocaux con l'IA

Nessun codice richiesto. Estrai dati in minuti con l'automazione basata sull'IA.

Come Funziona

Descrivi ciò di cui hai bisogno

Di' all'IA quali dati vuoi estrarre da BureauxLocaux. Scrivi semplicemente in linguaggio naturale — nessun codice o selettore necessario.

L'IA estrae i dati

La nostra intelligenza artificiale naviga BureauxLocaux, gestisce contenuti dinamici ed estrae esattamente ciò che hai richiesto.

Ottieni i tuoi dati

Ricevi dati puliti e strutturati pronti per l'esportazione in CSV, JSON o da inviare direttamente alle tue applicazioni.

Perché Usare l'IA per lo Scraping

L'IA rende facile lo scraping di BureauxLocaux senza scrivere codice. La nostra piattaforma basata sull'intelligenza artificiale capisce quali dati vuoi — descrivili in linguaggio naturale e l'IA li estrae automaticamente.

How to scrape with AI:

- Descrivi ciò di cui hai bisogno: Di' all'IA quali dati vuoi estrarre da BureauxLocaux. Scrivi semplicemente in linguaggio naturale — nessun codice o selettore necessario.

- L'IA estrae i dati: La nostra intelligenza artificiale naviga BureauxLocaux, gestisce contenuti dinamici ed estrae esattamente ciò che hai richiesto.

- Ottieni i tuoi dati: Ricevi dati puliti e strutturati pronti per l'esportazione in CSV, JSON o da inviare direttamente alle tue applicazioni.

Why use AI for scraping:

- Superamento della sicurezza DataDome: Automatio è progettato per navigare attraverso scudi bot avanzati come DataDome senza innescare blocchi, garantendo una raccolta dati costante.

- Estrazione visiva dei dati: Il selettore visivo no-code ti consente di puntare e cliccare su attributi tecnici complessi come le classi energetiche o i servizi dell'edificio senza scrivere selettori CSS personalizzati.

- Proxy francesi integrati: Connetti facilmente proxy residenziali francesi per imitare il comportamento di navigazione locale, essenziale per accedere agli annunci regionali ed evitare blocchi basati sulla reputazione dell'IP.

- Interazioni UI automatizzate: Configura lo strumento per gestire automaticamente il banner di consenso cookie di Axeptio e cliccare sui pulsanti 'Mostra' per catturare i dettagli di contatto nascosti.

Scraper Web No-Code per BureauxLocaux

Alternative point-and-click allo scraping alimentato da IA

Diversi strumenti no-code come Browse.ai, Octoparse, Axiom e ParseHub possono aiutarti a fare scraping di BureauxLocaux senza scrivere codice. Questi strumenti usano interfacce visive per selezionare i dati, anche se possono avere difficoltà con contenuti dinamici complessi o misure anti-bot.

Workflow Tipico con Strumenti No-Code

Sfide Comuni

Curva di apprendimento

Comprendere selettori e logica di estrazione richiede tempo

I selettori si rompono

Le modifiche al sito web possono rompere l'intero flusso di lavoro

Problemi con contenuti dinamici

I siti con molto JavaScript richiedono soluzioni complesse

Limitazioni CAPTCHA

La maggior parte degli strumenti richiede intervento manuale per i CAPTCHA

Blocco IP

Lo scraping aggressivo può portare al blocco del tuo IP

Scraper Web No-Code per BureauxLocaux

Diversi strumenti no-code come Browse.ai, Octoparse, Axiom e ParseHub possono aiutarti a fare scraping di BureauxLocaux senza scrivere codice. Questi strumenti usano interfacce visive per selezionare i dati, anche se possono avere difficoltà con contenuti dinamici complessi o misure anti-bot.

Workflow Tipico con Strumenti No-Code

- Installare l'estensione del browser o registrarsi sulla piattaforma

- Navigare verso il sito web target e aprire lo strumento

- Selezionare con point-and-click gli elementi dati da estrarre

- Configurare i selettori CSS per ogni campo dati

- Impostare le regole di paginazione per lo scraping di più pagine

- Gestire i CAPTCHA (spesso richiede risoluzione manuale)

- Configurare la pianificazione per le esecuzioni automatiche

- Esportare i dati in CSV, JSON o collegare tramite API

Sfide Comuni

- Curva di apprendimento: Comprendere selettori e logica di estrazione richiede tempo

- I selettori si rompono: Le modifiche al sito web possono rompere l'intero flusso di lavoro

- Problemi con contenuti dinamici: I siti con molto JavaScript richiedono soluzioni complesse

- Limitazioni CAPTCHA: La maggior parte degli strumenti richiede intervento manuale per i CAPTCHA

- Blocco IP: Lo scraping aggressivo può portare al blocco del tuo IP

Esempi di Codice

import requests

from bs4 import BeautifulSoup

# Nota: questo potrebbe essere bloccato da Cloudflare senza header/proxy avanzati

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Esempio: Selezione delle schede degli annunci

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Annuncio: {title} | Prezzo: {price}')

except Exception as e:

print(f'Scraping fallito: {e}')Quando Usare

Ideale per pagine HTML statiche con JavaScript minimo. Perfetto per blog, siti di notizie e pagine prodotto e-commerce semplici.

Vantaggi

- ●Esecuzione più veloce (senza overhead del browser)

- ●Consumo risorse minimo

- ●Facile da parallelizzare con asyncio

- ●Ottimo per API e pagine statiche

Limitazioni

- ●Non può eseguire JavaScript

- ●Fallisce su SPA e contenuti dinamici

- ●Può avere difficoltà con sistemi anti-bot complessi

Come Fare Scraping di BureauxLocaux con Codice

Python + Requests

import requests

from bs4 import BeautifulSoup

# Nota: questo potrebbe essere bloccato da Cloudflare senza header/proxy avanzati

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Esempio: Selezione delle schede degli annunci

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Annuncio: {title} | Prezzo: {price}')

except Exception as e:

print(f'Scraping fallito: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Il lancio con stealth o un UA specifico è raccomandato

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Naviga ai risultati di ricerca

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Attendi il rendering degli annunci

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contact agent"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Ciclo attraverso ogni scheda immobile sulla pagina

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Paginazione: Trova il link alla pagina 'Successiva'

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Imposta un User-Agent realistico

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Estrae i dati dagli elementi degli annunci

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Cosa Puoi Fare Con I Dati di BureauxLocaux

Esplora applicazioni pratiche e insight dai dati di BureauxLocaux.

Indicizzazione degli Affitti Commerciali

Gli analisti finanziari possono costruire un indice dinamico dei costi di affitto degli uffici per consigliare i clienti aziendali sulla strategia di localizzazione.

Come implementare:

- 1Estrai settimanalmente tutti gli annunci di uffici attivi nelle principali città francesi.

- 2Calcola il prezzo per metro quadrato all'anno per ogni voce.

- 3Raggruppa i dati per distretto (Arrondissement) per identificare i cluster di prezzo.

- 4Visualizza la 'Mappa di Calore dei Prezzi' utilizzando uno strumento di mapping come Tableau.

Usa Automatio per estrarre dati da BureauxLocaux e costruire queste applicazioni senza scrivere codice.

Cosa Puoi Fare Con I Dati di BureauxLocaux

- Indicizzazione degli Affitti Commerciali

Gli analisti finanziari possono costruire un indice dinamico dei costi di affitto degli uffici per consigliare i clienti aziendali sulla strategia di localizzazione.

- Estrai settimanalmente tutti gli annunci di uffici attivi nelle principali città francesi.

- Calcola il prezzo per metro quadrato all'anno per ogni voce.

- Raggruppa i dati per distretto (Arrondissement) per identificare i cluster di prezzo.

- Visualizza la 'Mappa di Calore dei Prezzi' utilizzando uno strumento di mapping come Tableau.

- Lead Gen Immobiliare

I fornitori di servizi B2B possono trovare aziende che si trasferiscono in nuovi spazi che richiedono installazioni IT, arredamento o assicurazioni.

- Targetizza gli annunci contrassegnati come 'Recentemente Disponibile' o 'Nuovo sul Mercato'.

- Estrai i dettagli di contatto dell'agenzia per proposte di partnership.

- Monitora la rimozione degli annunci per stimare quando un'azienda ha firmato con successo un contratto di locazione.

- Automatizza l'inserimento in un CRM per nuovi potenziali progetti di ristrutturazione uffici.

- Tracciamento della Durata dello Sfitto

I ricercatori economici possono monitorare quanto tempo le proprietà industriali rimangono sul mercato per valutare lo stato di salute dell'economia locale.

- Estrai tutti gli annunci di magazzini e memorizza la loro data di 'Prima Visualizzazione'.

- Verifica continuamente quali annunci sono ancora attivi rispetto a quelli rimossi.

- Calcola il 'Time on Market' (ToM) medio per ogni zona industriale.

- Correla l'alto ToM con specifici rallentamenti economici regionali.

- Automazione del Filtro Investimenti

Gli investitori possono ricevere avvisi istantanei quando le proprietà scendono sotto una certa soglia di prezzo in aree specifiche.

- Imposta uno scraping giornaliero per categorie specifiche come 'Vente de Bureaux'.

- Confronta il prezzo giornaliero con la media storica per quello specifico codice postale.

- Attiva una notifica se un annuncio ha un prezzo inferiore del 15% rispetto alla media di mercato.

- Esporta le offerte filtrate in un Google Sheet per una revisione immediata.

Potenzia il tuo workflow con l'automazione AI

Automatio combina la potenza degli agenti AI, dell'automazione web e delle integrazioni intelligenti per aiutarti a fare di piu in meno tempo.

Consigli Pro per lo Scraping di BureauxLocaux

Consigli esperti per estrarre con successo i dati da BureauxLocaux.

Priorità agli IP residenziali francesi

L'utilizzo di proxy basati in Francia è il modo più efficace per evitare di essere segnalati dai filtri di sicurezza regionali del sito.

Gestione dei suffissi fiscali

Assicurati che i tuoi parser di prezzo riconoscano 'HT' (Hors Taxes) e 'HC' (Hors Charges) per calcolare accuratamente il costo totale degli annunci commerciali.

Monitoraggio delle richieste XHR interne

Ispeziona il traffico di rete per trovare gli endpoint JSON interni utilizzati dal sito per popolare gli annunci, garantendo un'estrazione più efficiente e strutturata.

Implementazione di ritardi casuali

Introduci tempi di attesa variabili tra il caricamento delle pagine e le interazioni per replicare i pattern di navigazione umana e rimanere al di sotto delle soglie di rate-limiting.

Gestione immediata del consenso cookie

Assicurati che il tuo scraper interagisca con il modal del consenso cookie o lo nasconda non appena atterra sulla pagina, per evitare che si sovrapponga bloccando l'accesso agli elementi dell'annuncio.

Testimonianze

Cosa dicono i nostri utenti

Unisciti a migliaia di utenti soddisfatti che hanno trasformato il loro workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Correlati Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Domande frequenti su BureauxLocaux

Trova risposte alle domande comuni su BureauxLocaux