Budget Bytesのスクレイピング方法:レシピとコストデータの抽出

Budget Bytesをスクレイピングして、レシピの材料、栄養成分、1人あたりのコストデータを抽出する方法を学びましょう。献立作成や価格分析に最適です。

ボット対策検出

- Cloudflare

- エンタープライズ級のWAFとボット管理。JavaScriptチャレンジ、CAPTCHA、行動分析を使用。ステルス設定でのブラウザ自動化が必要。

- レート制限

- 時間あたりのIP/セッションごとのリクエストを制限。ローテーションプロキシ、リクエスト遅延、分散スクレイピングで回避可能。

- Request Throttling

Budget Bytesについて

Budget Bytesが提供するものと抽出可能な貴重なデータを発見してください。

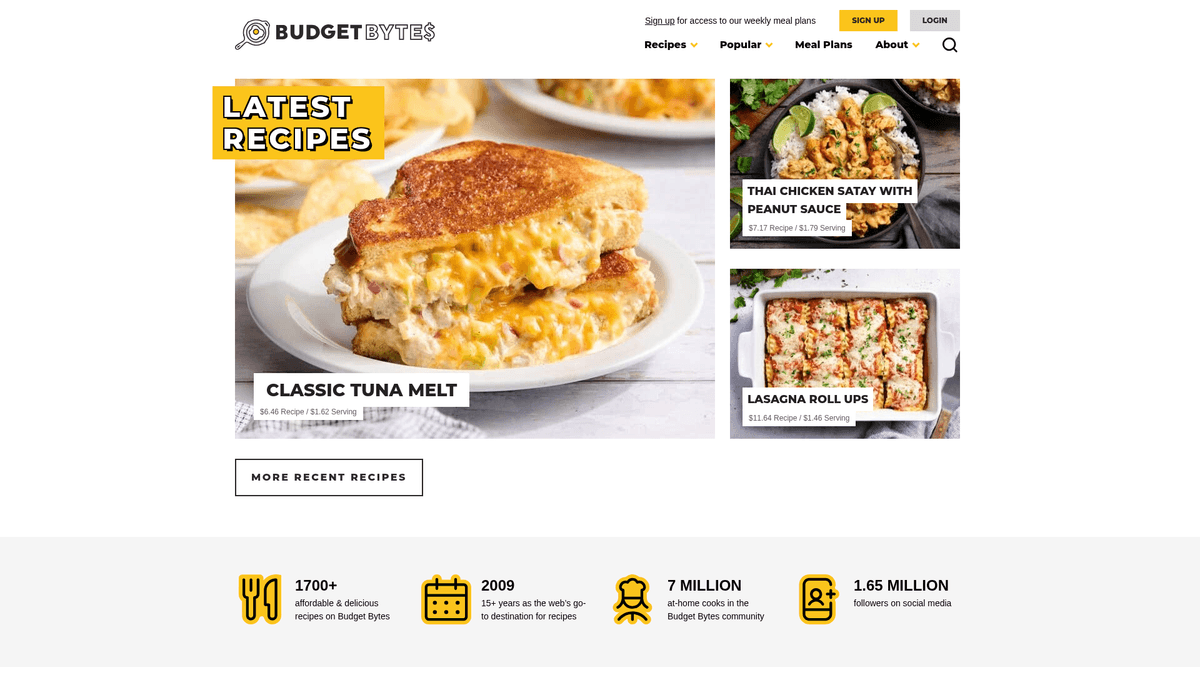

予算に優しい料理の権威

Budget Bytes は、低予算向けに考案された美味しいレシピを提供することに特化した、非常に人気のある料理ウェブサイトです。2009年に Beth Moncel によって設立されたこのプラットフォームは、学生や家族、そして風味を最大限に引き出しつつ食品廃棄を最小限に抑えたいと考えているすべての人にとって、欠かせないリソースとなっています。このサイトは、すべての材料の価格を計算してレシピの総コストと1人あたりのコストを算出する、緻密なコスト分析で有名です。

包括的なレシピデータ

ウェブサイトには、作り置き用のお弁当からワンポット料理、ベジタリアン、スロークッカー向けオプションまで、1,700以上のレシピが掲載されています。各リストには、詳細な材料、ステップバイステップの写真、栄養情報、ユーザーレビューが含まれています。この構造化されたアプローチにより、美食と経済学の接点に興味がある人々にとって、このサイトはデータの宝庫となっています。

なぜ Budget Bytes をスクレイピングするのか

このデータをスクレイピングすることは、いくつかの理由で非常に価値があります。低コストの食事アイデアを集約したり、材料コスト分析を通じて食品インフレを追跡したり、栄養研究のためのデータセットを作成したりすることが可能になります。献立作成アプリや食料品比較ツールの開発者は、現実世界の価格に基づいた手頃で健康的な選択肢をユーザーに提供するために、しばしばこのデータを利用しています。

なぜBudget Bytesをスクレイピングするのか?

Budget Bytesからのデータ抽出のビジネス価値とユースケースを発見してください。

材料コスト分析による食品価格インフレの監視

家計管理アプリ向けの低コストな食事アイデアの集約

手頃な価格のダイエットに関する栄養学的研究の実施

予算のしきい値に基づいた食料品買い物リストの自動作成

レシピのトレンドと人気の食品カテゴリの分析

フードデリバリーサービス向けの競合価格ベンチマークの作成

スクレイピングの課題

Budget Bytesのスクレイピング時に遭遇する可能性のある技術的課題。

Cloudflare のセキュリティヘッダーとボット検知の回避

WordPress Recipe Maker (WPRM) ブロックからの構造化データの抽出

材料リストにおける一貫性のない計量単位の処理

WordPress REST API エンドポイントのレート制限(rate limits)の管理

動的な「1人あたりのコスト」文字列の数値へのパース

Budget BytesをAIでスクレイピング

コーディング不要。AI搭載の自動化で数分でデータを抽出。

仕組み

必要なものを記述

Budget Bytesから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

AIがデータを抽出

人工知能がBudget Bytesをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

データを取得

CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

なぜスクレイピングにAIを使うのか

AIを使えば、コードを書かずにBudget Bytesを簡単にスクレイピングできます。人工知能搭載のプラットフォームが必要なデータを理解します — 自然言語で記述するだけで、AIが自動的に抽出します。

How to scrape with AI:

- 必要なものを記述: Budget Bytesから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

- AIがデータを抽出: 人工知能がBudget Bytesをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

- データを取得: CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

Why use AI for scraping:

- 複雑なスクレイパーを即座に構築できるノーコード環境

- Cloudflare およびアンチボットチャレンジの自動処理

- 毎週追加される新しいレシピを自動的に取得するための実行スケジュール設定

- ライブコスト追跡のための Google スプレッドシートとの直接連携

Budget Bytes用ノーコードWebスクレイパー

AI搭載スクレイピングのポイント&クリック代替手段

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにBudget Bytesをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

一般的な課題

学習曲線

セレクタと抽出ロジックの理解に時間がかかる

セレクタの破損

Webサイトの変更によりワークフロー全体が壊れる可能性がある

動的コンテンツの問題

JavaScript多用サイトは複雑な回避策が必要

CAPTCHAの制限

ほとんどのツールはCAPTCHAに手動介入が必要

IPブロック

過度なスクレイピングはIPのブロックにつながる可能性がある

Budget Bytes用ノーコードWebスクレイパー

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにBudget Bytesをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

- ブラウザ拡張機能をインストールするかプラットフォームに登録する

- ターゲットWebサイトに移動してツールを開く

- ポイント&クリックで抽出するデータ要素を選択する

- 各データフィールドのCSSセレクタを設定する

- 複数ページをスクレイピングするためのページネーションルールを設定する

- CAPTCHAに対処する(多くの場合手動解決が必要)

- 自動実行のスケジュールを設定する

- データをCSV、JSONにエクスポートするかAPIで接続する

一般的な課題

- 学習曲線: セレクタと抽出ロジックの理解に時間がかかる

- セレクタの破損: Webサイトの変更によりワークフロー全体が壊れる可能性がある

- 動的コンテンツの問題: JavaScript多用サイトは複雑な回避策が必要

- CAPTCHAの制限: ほとんどのツールはCAPTCHAに手動介入が必要

- IPブロック: 過度なスクレイピングはIPのブロックにつながる可能性がある

コード例

import requests

from bs4 import BeautifulSoup

# ターゲット URL

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# ブラウザを模倣するための標準ヘッダー

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# 基本的なレシピデータの抽出

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Error: {e}')いつ使うか

JavaScriptが最小限の静的HTMLページに最適。ブログ、ニュースサイト、シンプルなEコマース製品ページに理想的。

メリット

- ●最速の実行(ブラウザオーバーヘッドなし)

- ●最小限のリソース消費

- ●asyncioで簡単に並列化

- ●APIと静的ページに最適

制限事項

- ●JavaScriptを実行できない

- ●SPAや動的コンテンツで失敗

- ●複雑なアンチボットシステムで苦戦する可能性

コードでBudget Bytesをスクレイピングする方法

Python + Requests

import requests

from bs4 import BeautifulSoup

# ターゲット URL

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# ブラウザを模倣するための標準ヘッダー

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# 基本的なレシピデータの抽出

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Error: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_budget_bytes():

async with async_playwright() as p:

# ブラウザの起動

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

# レシピページへ移動

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/')

# レシピコンテナの読み込みを待機

await page.wait_for_selector('.wprm-recipe-container')

# page.evaluate 経由でデータを抽出

recipe_data = await page.evaluate('''() => {

return {

title: document.querySelector('.wprm-recipe-name')?.innerText,

total_cost: document.querySelector('.wprm-recipe-cost')?.innerText,

calories: document.querySelector('.wprm-nutrition-label-text-nutrition-value-calories')?.innerText

}

}''')

print(recipe_data)

await browser.close()

asyncio.run(scrape_budget_bytes())Python + Scrapy

import scrapy

class BudgetBytesSpider(scrapy.Spider):

name = 'budget_bytes'

# よりクリーンなデータ抽出のために WordPress REST API を使用

start_urls = ['https://www.budgetbytes.com/wp-json/wp/v2/posts?per_page=20']

def parse(self, response):

posts = response.json()

for post in posts:

yield {

'id': post.get('id'),

'title': post.get('title', {}).get('rendered'),

'url': post.get('link'),

'published_date': post.get('date'),

'slug': post.get('slug')

}

# ヘッダーにページネーションがあれば追跡する

# (ロジックは簡略化のため省略)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// 基本的なブロックを回避するために user agent を設定

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36');

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const title = document.querySelector('.wprm-recipe-name')?.textContent;

const costPerServing = document.querySelector('.cost-per')?.textContent;

const items = Array.from(document.querySelectorAll('.wprm-recipe-ingredient')).map(i => i.textContent.trim());

return { title, costPerServing, items };

});

console.log(data);

await browser.close();

})();Budget Bytesデータで何ができるか

Budget Bytesデータからの実用的なアプリケーションとインサイトを探索してください。

食品価格インフレトラッカー

さまざまなレシピカテゴリにわたって材料レベルの価格設定をスクレイピングし、食料品コストのリアルタイムの変化を監視します。

実装方法:

- 1上位100レシピの「1人あたりのコスト」フィールドを毎週スクレイピングするようスケジュール。

- 2前月比で数値を比較し、最も価格が上昇しているカテゴリを特定。

- 3特定の材料(卵や乳製品など)とレシピ総額の相関関係を視覚化。

Automatioを使用してBudget Bytesからデータを抽出し、コードを書かずにこれらのアプリケーションを構築しましょう。

Budget Bytesデータで何ができるか

- 食品価格インフレトラッカー

さまざまなレシピカテゴリにわたって材料レベルの価格設定をスクレイピングし、食料品コストのリアルタイムの変化を監視します。

- 上位100レシピの「1人あたりのコスト」フィールドを毎週スクレイピングするようスケジュール。

- 前月比で数値を比較し、最も価格が上昇しているカテゴリを特定。

- 特定の材料(卵や乳製品など)とレシピ総額の相関関係を視覚化。

- スマート献立プランナーアプリ

ユーザーの厳格な1日の予算に基づいてレシピを提案する栄養アプリのデータベースを構築します。

- レシピ名、1人あたりのコスト、食事制限タグ(ヴィーガン、GFなど)をスクレイピング。

- 1人あたり2ドル未満のレシピをフィルタリング。

- モバイルアプリで使用するためにデータを API にエクスポート。

- マクロ栄養素・コスト最適化ツール

予算が限られているアスリートやフィットネス愛好家のために、最高の「1ドルあたりのタンパク質」レシピを見つけます。

- 栄養データ(タンパク質含有量)とレシピのコストデータの両方を抽出。

- すべてのエントリに対して独自の「タンパク質/コスト」比率を計算。

- レシピをランク付けして、最も効率的な高タンパク低予算の食事を見つける。

- 在庫管理提案エンジン

サイトから抽出された一般的なパントリーの材料に基づいてレシピを特定し、ユーザーが食品廃棄物を減らすのを支援します。

- 材料リストをスクレイピングして正規化し、検索可能なデータベースにする。

- ユーザーが手元にある材料を入力できるようにする。

- ユーザーの入力とスクレイピングしたデータを照合し、次に作るべき最も低コストな食事を提案する。

ワークフローを強化する AI自動化

AutomatioはAIエージェント、ウェブ自動化、スマート統合のパワーを組み合わせ、より短時間でより多くのことを達成するお手伝いをします。

Budget Bytesスクレイピングのプロのヒント

Budget Bytesからデータを正常に抽出するための専門家のアドバイス。

HTMLをパースすることなく、高速で構造化されたJSONデータを取得するには、/wp-json/wp/v2/posts にある WordPress REST API にアクセスしてください。

headセクション内の 'ld+json' スクリプトタグを探すことで、調理時間や栄養成分を含む Schema.org のレシピメタデータを抽出できます。

大量のスクレイピング中に Cloudflare のセキュリティレイヤーによってトリガーされる 403 Forbidden エラーを回避するには、レジデンシャルプロキシを使用してください。

サーバーへの負荷を考慮し、一時的な IP ブラックリスト登録を避けるため、リクエスト間に3〜5秒の遅延(delay)を実装してください。

異なるレシピ形式間でも一貫したセレクターを利用するために、'WPRM' (WordPress Recipe Maker) の CSS クラスを確認してください。

データエクスポート時の画像リンク切れを防ぐため、スクレイピングした画像はローカルまたは CDN 経由で保存してください。

お客様の声

ユーザーの声

ワークフローを変革した何千人もの満足したユーザーに加わりましょう

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

関連 Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Budget Bytesについてのよくある質問

Budget Bytesに関するよくある質問への回答を見つけてください