BureauxLocauxをスクレイピングする方法:商業用不動産データガイド

BureauxLocauxから商業用不動産データを抽出。市場調査のために、フランス全土のオフィス価格、倉庫の所在地、エージェントの詳細情報をスクレイピングします。

ボット対策検出

- Cloudflare

- エンタープライズ級のWAFとボット管理。JavaScriptチャレンジ、CAPTCHA、行動分析を使用。ステルス設定でのブラウザ自動化が必要。

- CSRF Protection

- レート制限

- 時間あたりのIP/セッションごとのリクエストを制限。ローテーションプロキシ、リクエスト遅延、分散スクレイピングで回避可能。

- User-Agent Filtering

- JavaScriptチャレンジ

- コンテンツにアクセスするにはJavaScriptの実行が必要。単純なリクエストは失敗。PlaywrightやPuppeteerなどのヘッドレスブラウザが必要。

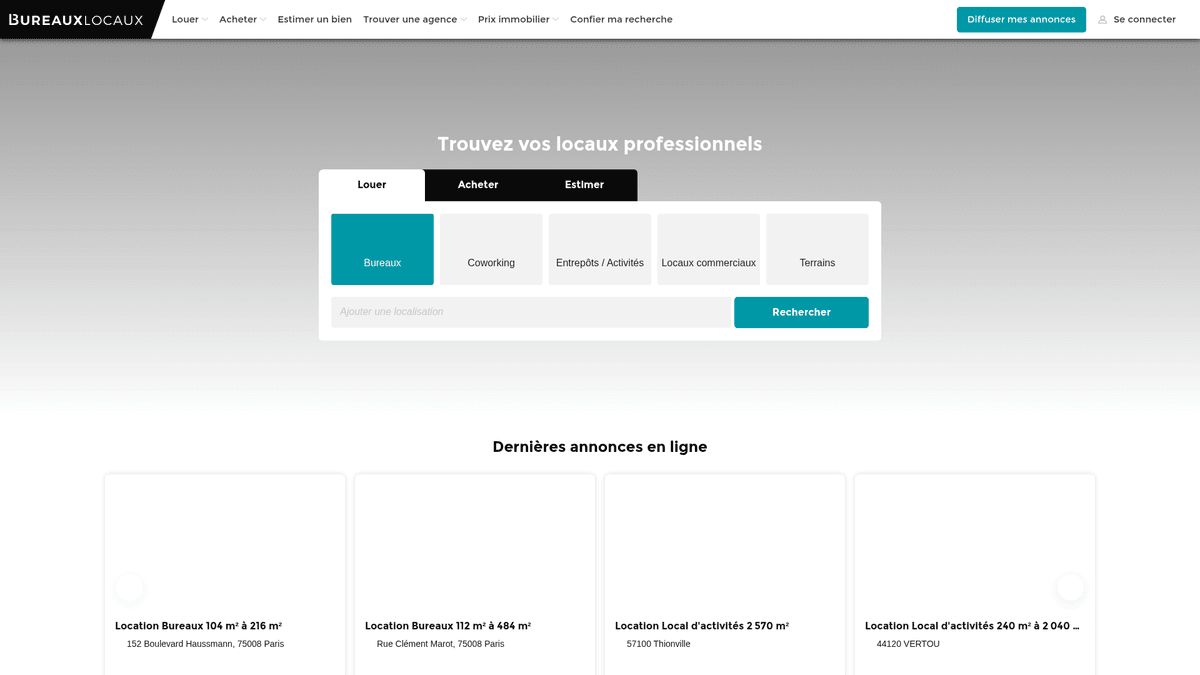

BureauxLocauxについて

BureauxLocauxが提供するものと抽出可能な貴重なデータを発見してください。

フランスを代表するプロフェッショナル向け不動産マーケットプレイス

BureauxLocauxは、オフィス、倉庫、店舗スペース、コワーキングハブの賃貸および売買に特化したフランス随一のデジタルプラットフォームです。CoStar Group傘下のこのプラットフォームは、1,800以上の専門エージェンシーからのデータを集約し、72,000件以上のアクティブなリスティングを掲載しており、B2B不動産インサイトの決定的な情報源となっています。

網羅的なマーケットインテリジェンス

需要の高いパリのビジネス街からリヨンやマルセイユの物流拠点まで、フランスの商業景観を詳細に把握することができます。物件を探しているユーザーと専門ブローカーを繋ぐ重要な架け橋として機能し、単なる価格情報に留まらない詳細な技術仕様を提供しています。

なぜこのデータが重要なのか

BureauxLocauxのスクレイピングは、不動産開発業者、投資家、都市計画者にとって不可欠です。プラットフォームのリスティングからは、賃料推移、空室率、エネルギー性能(DPE)格付けなどのリアルタイムデータが得られ、これらは予測市場モデルの構築や高利回りの投資機会の特定に極めて重要です。

なぜBureauxLocauxをスクレイピングするのか?

BureauxLocauxからのデータ抽出のビジネス価値とユースケースを発見してください。

フランス主要都市における商業賃料の変動を監視する

専門不動産エージェンシーのポートフォリオと市場シェアをベンチマークする

オフィス改修や内装サービスの潜在的なリードを特定する

物流計画のために産業用倉庫の空室率を追跡する

コワーキングスペースの成長と従来のオフィスリースの比較分析を行う

不動産評価AIモデルのトレーニングデータを収集する

スクレイピングの課題

BureauxLocauxのスクレイピング時に遭遇する可能性のある技術的課題。

強力なCloudflareボット管理とJavaScriptチャレンジのバイパス

内部AJAXリクエスト経由で読み込まれる動的コンテンツの抽出

詳細なエージェント連絡先にアクセスするために必要なCSRFトークンの処理

断片化された価格データ形式の正規化(m2/年 vs 月額ワークステーションコスト)

物件属性グリッドの頻繁な構造変更への対応

BureauxLocauxをAIでスクレイピング

コーディング不要。AI搭載の自動化で数分でデータを抽出。

仕組み

必要なものを記述

BureauxLocauxから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

AIがデータを抽出

人工知能がBureauxLocauxをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

データを取得

CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

なぜスクレイピングにAIを使うのか

AIを使えば、コードを書かずにBureauxLocauxを簡単にスクレイピングできます。人工知能搭載のプラットフォームが必要なデータを理解します — 自然言語で記述するだけで、AIが自動的に抽出します。

How to scrape with AI:

- 必要なものを記述: BureauxLocauxから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

- AIがデータを抽出: 人工知能がBureauxLocauxをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

- データを取得: CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

Why use AI for scraping:

- カスタムコーディングなしでCloudflareのセキュリティをシームレスにバイパス

- 動的なリスティンググリッドに対するJavaScriptレンダリングを自動処理

- スケジュール実行により、日次の市場監視とアラート通知を自動化可能

- プレミアム住宅用プロキシを使用してIPベースのレート制限を回避

- ビジュアルセレクターにより、複雑な物件仕様のターゲット指定が容易

BureauxLocaux用ノーコードWebスクレイパー

AI搭載スクレイピングのポイント&クリック代替手段

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにBureauxLocauxをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

一般的な課題

学習曲線

セレクタと抽出ロジックの理解に時間がかかる

セレクタの破損

Webサイトの変更によりワークフロー全体が壊れる可能性がある

動的コンテンツの問題

JavaScript多用サイトは複雑な回避策が必要

CAPTCHAの制限

ほとんどのツールはCAPTCHAに手動介入が必要

IPブロック

過度なスクレイピングはIPのブロックにつながる可能性がある

BureauxLocaux用ノーコードWebスクレイパー

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにBureauxLocauxをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

- ブラウザ拡張機能をインストールするかプラットフォームに登録する

- ターゲットWebサイトに移動してツールを開く

- ポイント&クリックで抽出するデータ要素を選択する

- 各データフィールドのCSSセレクタを設定する

- 複数ページをスクレイピングするためのページネーションルールを設定する

- CAPTCHAに対処する(多くの場合手動解決が必要)

- 自動実行のスケジュールを設定する

- データをCSV、JSONにエクスポートするかAPIで接続する

一般的な課題

- 学習曲線: セレクタと抽出ロジックの理解に時間がかかる

- セレクタの破損: Webサイトの変更によりワークフロー全体が壊れる可能性がある

- 動的コンテンツの問題: JavaScript多用サイトは複雑な回避策が必要

- CAPTCHAの制限: ほとんどのツールはCAPTCHAに手動介入が必要

- IPブロック: 過度なスクレイピングはIPのブロックにつながる可能性がある

コード例

import requests

from bs4 import BeautifulSoup

# 注意: 高度なヘッダーやプロキシがない場合、Cloudflareによってブロックされる可能性があります

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# 例: リスティングカードを選択

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'スクレイピング失敗: {e}')いつ使うか

JavaScriptが最小限の静的HTMLページに最適。ブログ、ニュースサイト、シンプルなEコマース製品ページに理想的。

メリット

- ●最速の実行(ブラウザオーバーヘッドなし)

- ●最小限のリソース消費

- ●asyncioで簡単に並列化

- ●APIと静的ページに最適

制限事項

- ●JavaScriptを実行できない

- ●SPAや動的コンテンツで失敗

- ●複雑なアンチボットシステムで苦戦する可能性

コードでBureauxLocauxをスクレイピングする方法

Python + Requests

import requests

from bs4 import BeautifulSoup

# 注意: 高度なヘッダーやプロキシがない場合、Cloudflareによってブロックされる可能性があります

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# 例: リスティングカードを選択

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'スクレイピング失敗: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# ステルス設定または特定のUAでの起動を推奨

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# 検索結果ページへ移動

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# リスティングが表示されるのを待機

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "エージェントに問い合わせ"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# ページ上の各物件カードをループ処理

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# ページネーション: 「次へ」リンクを取得

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// 現実的なUser-Agentを設定

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// リスティング要素からデータを抽出

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();BureauxLocauxデータで何ができるか

BureauxLocauxデータからの実用的なアプリケーションとインサイトを探索してください。

商業賃料インデックス作成

金融アナリストは、オフィス賃料コストの動的インデックスを構築し、企業の立地戦略についてクライアントにアドバイスできます。

実装方法:

- 1フランス主要都市のすべてのアクティブなオフィス物件を毎週スクレイピングする。

- 2各物件の1平方メートルあたりの年間賃料を算出する。

- 3地区(Arrondissement)ごとにデータをグループ化し、価格クラスターを特定する。

- 4Tableauなどのマッピングツールを使用して「価格ヒートマップ」を可視化する。

Automatioを使用してBureauxLocauxからデータを抽出し、コードを書かずにこれらのアプリケーションを構築しましょう。

BureauxLocauxデータで何ができるか

- 商業賃料インデックス作成

金融アナリストは、オフィス賃料コストの動的インデックスを構築し、企業の立地戦略についてクライアントにアドバイスできます。

- フランス主要都市のすべてのアクティブなオフィス物件を毎週スクレイピングする。

- 各物件の1平方メートルあたりの年間賃料を算出する。

- 地区(Arrondissement)ごとにデータをグループ化し、価格クラスターを特定する。

- Tableauなどのマッピングツールを使用して「価格ヒートマップ」を可視化する。

- 不動産リードジェネレーション

B2Bサービスプロバイダーは、ITセットアップ、什器、保険を必要とする新しいスペースへの移転企業を見つけることができます。

- 「最近公開」または「新着物件」とマークされたリスティングをターゲットにする。

- 提携の打診のために、掲載エージェンシーの連絡先詳細を抽出する。

- 物件の掲載終了を追跡し、企業がいつリース契約を締結したかを推定する。

- 新規のオフィス改修プロジェクト候補としてCRMへの登録を自動化する。

- 空室期間の追跡

経済研究者は、産業用物件が市場に留まる期間を監視することで、地域経済の健全性を測定できます。

- すべての倉庫物件をスクレイピングし、「初掲載日」を保存する。

- どのリスティングがまだアクティブで、どれが削除されたかを継続的に検証する。

- 各工業地帯の平均「市場滞留期間」(ToM)を算出する。

- 高いToMと特定の地域の景気後退との相関関係を分析する。

- 投資フィルターの自動化

投資家は、特定のエリアで物件価格が一定の閾値を下回った際に、即座にアラートを受け取ることができます。

- 「Vente de Bureaux(オフィス売買)」などの特定カテゴリーに対して日次スクレイピングを設定する。

- 当日の価格を、その郵便番号の過去の平均価格と比較する。

- 市場平均より15%以上安く設定された物件があれば通知を飛ばす。

- フィルタリングされた案件を即座に確認できるようGoogleスプレッドシートにエクスポートする。

ワークフローを強化する AI自動化

AutomatioはAIエージェント、ウェブ自動化、スマート統合のパワーを組み合わせ、より短時間でより多くのことを達成するお手伝いをします。

BureauxLocauxスクレイピングのプロのヒント

BureauxLocauxからデータを正常に抽出するための専門家のアドバイス。

地域制限によるブロックを避けるため、フランスに特化した高品質な住宅用プロキシを使用してください。

データの偏りを防ぐため、価格パーサーでは必ず「HT」(税別)と「HC」(管理費別)を考慮してください。

ブラウザの「ネットワーク」タブを監視して、動的読み込みに使用されている内部のJSONエンドポイントを特定してください。

Cloudflareの行動分析による検出を防ぐため、User-Agentとブラウザフィンガープリントをローテーションさせてください。

人間のような挙動を模倣するため、ページ読み込みの間にランダムなスリープ間隔(3〜10秒)を設定してください。

レコードの重複を避け、時間の経過に伴う価格変動を追跡するために、リスティング参照IDを一意のキーとして保存してください。

お客様の声

ユーザーの声

ワークフローを変革した何千人もの満足したユーザーに加わりましょう

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

関連 Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

BureauxLocauxについてのよくある質問

BureauxLocauxに関するよくある質問への回答を見つけてください