Hoe WebElements te scrapen: Gids voor periodiek systeem data

Extraheer nauwkeurige gegevens over chemische elementen van WebElements. Scrape atoomgewichten, fysieke eigenschappen en ontdekkingsgeschiedenis voor onderzoek...

Over WebElements

Ontdek wat WebElements biedt en welke waardevolle gegevens kunnen worden geëxtraheerd.

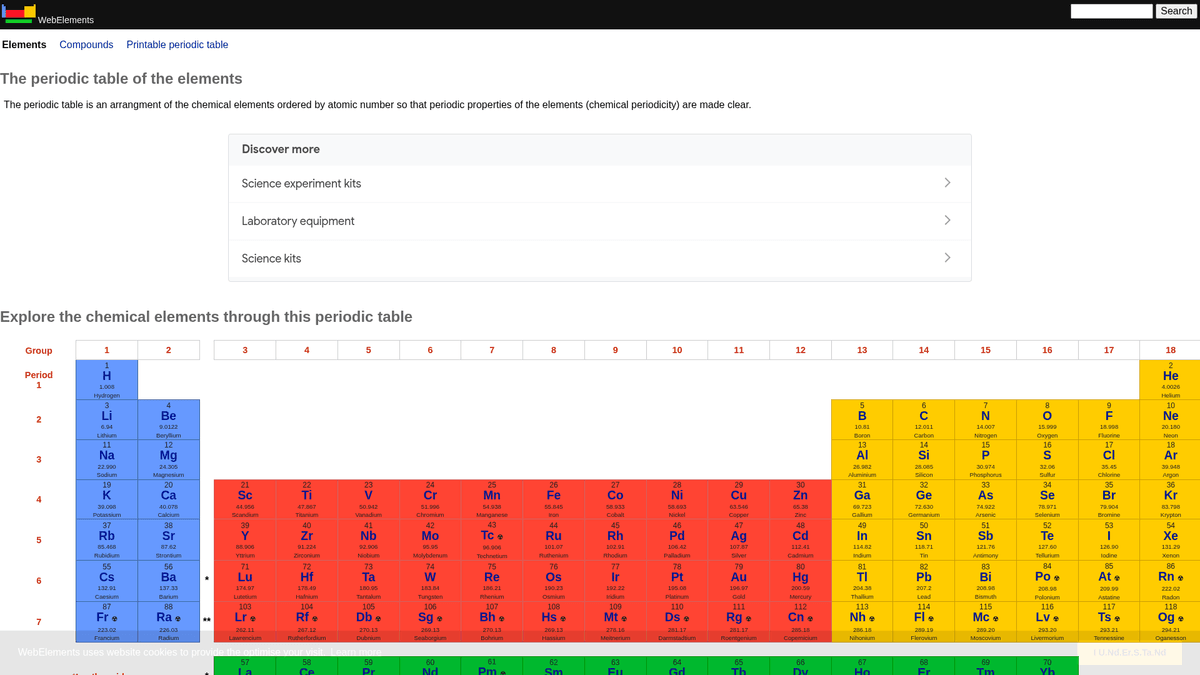

WebElements is een toonaangevend online periodiek systeem dat wordt onderhouden door Mark Winter aan de Universiteit van Sheffield. Het werd gelanceerd in 1993 en was het eerste periodiek systeem op het World Wide Web. Sindsdien is het uitgegroeid tot een autoriteitsbron voor studenten, academici en professionele chemici. De site biedt diepgaande, gestructureerde data over elk bekend chemisch element, van standaard atoomgewichten tot complexe elektronenconfiguraties.

De waarde van het scrapen van WebElements ligt in de hoogwaardige, peer-reviewed wetenschappelijke data. Voor ontwikkelaars die educatieve tools bouwen, onderzoekers die trendanalyses uitvoeren over het periodiek systeem, of materiaalwetenschappers die machine learning modellen trainen, biedt WebElements een betrouwbare en technisch rijke bron van waarheid die handmatig moeilijk te verzamelen is.

Waarom WebElements Scrapen?

Ontdek de zakelijke waarde en gebruiksmogelijkheden voor data-extractie van WebElements.

Verzamelen van hoogwaardige wetenschappelijke data voor de ontwikkeling van educatieve tools.

Aggregeren van eigenschappen van elementen voor materiaalkundig onderzoek en machine learning modellen.

Geautomatiseerd vullen van laboratoriumvoorraadsystemen met chemische specificaties.

Historische analyse van ontdekkingen van elementen en wetenschappelijke vooruitgang.

Creatie van uitgebreide datasets met chemische eigenschappen voor academische publicaties.

Scraping Uitdagingen

Technische uitdagingen die u kunt tegenkomen bij het scrapen van WebElements.

Data is verspreid over meerdere subpagina's per element (bijv. /history, /compounds).

Oudere tabel-gebaseerde HTML-lay-outs vereisen nauwkeurige selectielogica.

Verwarring over de domeinnaam met de 'WebElement'-klasse van Selenium bij het zoeken naar ondersteuning.

Scrape WebElements met AI

Geen code nodig. Extraheer gegevens in minuten met AI-aangedreven automatisering.

Hoe het werkt

Beschrijf wat je nodig hebt

Vertel de AI welke gegevens je wilt extraheren van WebElements. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

AI extraheert de gegevens

Onze kunstmatige intelligentie navigeert WebElements, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

Ontvang je gegevens

Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Waarom AI gebruiken voor scraping

AI maakt het eenvoudig om WebElements te scrapen zonder code te schrijven. Ons AI-aangedreven platform gebruikt kunstmatige intelligentie om te begrijpen welke gegevens je wilt — beschrijf het in natuurlijke taal en de AI extraheert ze automatisch.

How to scrape with AI:

- Beschrijf wat je nodig hebt: Vertel de AI welke gegevens je wilt extraheren van WebElements. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

- AI extraheert de gegevens: Onze kunstmatige intelligentie navigeert WebElements, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

- Ontvang je gegevens: Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Why use AI for scraping:

- No-code navigatie door hiërarchische elementstructuren.

- Behandelt de extractie van complexe wetenschappelijke tabellen automatisch.

- Cloud-uitvoering maakt extractie van volledige datasets mogelijk zonder lokale downtime.

- Eenvoudige export naar CSV/JSON voor direct gebruik in wetenschappelijke analysetools.

- Geplande monitoring kan updates van bevestigde elementgegevens detecteren.

No-Code Web Scrapers voor WebElements

Point-and-click alternatieven voor AI-aangedreven scraping

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen WebElements te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

Veelvoorkomende Uitdagingen

Leercurve

Het begrijpen van selectors en extractielogica kost tijd

Selectors breken

Websitewijzigingen kunnen je hele workflow kapotmaken

Problemen met dynamische content

JavaScript-zware sites vereisen complexe oplossingen

CAPTCHA-beperkingen

De meeste tools vereisen handmatige interventie voor CAPTCHAs

IP-blokkering

Agressief scrapen kan leiden tot blokkering van je IP

No-Code Web Scrapers voor WebElements

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen WebElements te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

- Browserextensie installeren of registreren op het platform

- Navigeren naar de doelwebsite en de tool openen

- Data-elementen selecteren met point-and-click

- CSS-selectors configureren voor elk dataveld

- Paginatieregels instellen voor het scrapen van meerdere pagina's

- CAPTCHAs afhandelen (vereist vaak handmatige oplossing)

- Planning configureren voor automatische uitvoering

- Data exporteren naar CSV, JSON of verbinden via API

Veelvoorkomende Uitdagingen

- Leercurve: Het begrijpen van selectors en extractielogica kost tijd

- Selectors breken: Websitewijzigingen kunnen je hele workflow kapotmaken

- Problemen met dynamische content: JavaScript-zware sites vereisen complexe oplossingen

- CAPTCHA-beperkingen: De meeste tools vereisen handmatige interventie voor CAPTCHAs

- IP-blokkering: Agressief scrapen kan leiden tot blokkering van je IP

Codevoorbeelden

import requests

from bs4 import BeautifulSoup

import time

# Doel-URL voor een specifiek element (bijv. Goud)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# De elementnaam extraheren uit de H1-tag

name = soup.find('h1').get_text().strip()

# Atoomnummer extraheren met behulp van tabel-label-logica

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atoomnummer: {atomic_number}')

except Exception as e:

print(f'Er is een fout opgetreden: {e}')

# Aanbevelingen uit robots.txt opvolgen

time.sleep(1)

scrape_element(url)Wanneer Gebruiken

Ideaal voor statische HTML-pagina's met minimale JavaScript. Perfect voor blogs, nieuwssites en eenvoudige e-commerce productpagina's.

Voordelen

- ●Snelste uitvoering (geen browser overhead)

- ●Laagste resourceverbruik

- ●Makkelijk te paralleliseren met asyncio

- ●Uitstekend voor API's en statische pagina's

Beperkingen

- ●Kan geen JavaScript uitvoeren

- ●Faalt op SPA's en dynamische content

- ●Kan moeite hebben met complexe anti-bot systemen

Hoe WebElements te Scrapen met Code

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# Doel-URL voor een specifiek element (bijv. Goud)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# De elementnaam extraheren uit de H1-tag

name = soup.find('h1').get_text().strip()

# Atoomnummer extraheren met behulp van tabel-label-logica

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atoomnummer: {atomic_number}')

except Exception as e:

print(f'Er is een fout opgetreden: {e}')

# Aanbevelingen uit robots.txt opvolgen

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Elementen worden gelinkt vanaf het hoofd-periodiek systeem

page.goto('https://www.webelements.com/iron/')

# Wacht tot de tabel met eigenschappen aanwezig is

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Volg elke element-link in het periodiek systeem

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Geëxtraheerde Data:', data);

await browser.close();

})();Wat U Kunt Doen Met WebElements Data

Verken praktische toepassingen en inzichten uit WebElements data.

AI-training voor materiaalkunde

Machine learning modellen trainen om de eigenschappen van nieuwe legeringen te voorspellen op basis van elementaire kenmerken.

Hoe te implementeren:

- 1Extraheer fysieke eigenschappen voor alle metallische elementen.

- 2Reinig en normaliseer waarden zoals dichtheid en smeltpunten.

- 3Voer de data in regressie- of voorspellende materiaalmodellen in.

- 4Verifieer voorspellingen tegen bestaande experimentele legeringsdata.

Gebruik Automatio om data van WebElements te extraheren en deze applicaties te bouwen zonder code te schrijven.

Wat U Kunt Doen Met WebElements Data

- AI-training voor materiaalkunde

Machine learning modellen trainen om de eigenschappen van nieuwe legeringen te voorspellen op basis van elementaire kenmerken.

- Extraheer fysieke eigenschappen voor alle metallische elementen.

- Reinig en normaliseer waarden zoals dichtheid en smeltpunten.

- Voer de data in regressie- of voorspellende materiaalmodellen in.

- Verifieer voorspellingen tegen bestaande experimentele legeringsdata.

- Inhoud voor educatieve apps

Interactieve periodieke systemen vullen voor scheikundestudenten met peer-reviewed data.

- Scrape atoomnummers, symbolen en elementbeschrijvingen.

- Extraheer historische context en details over de ontdekking.

- Organiseer de data per periodieke groep en blok.

- Integreer in een gebruikersinterface met visuele kristalstructuren.

- Chemische trendanalyse

Periodieke trends zoals ionisatie-energie of atoomradius visualiseren over perioden en groepen.

- Verzamel eigendomsgegevens voor elk element in numerieke volgorde.

- Categoriseer elementen in hun respectievelijke groepen.

- Gebruik grafische bibliotheken om trends te visualiseren.

- Identificeer en analyseer afwijkende datapunten in specifieke blokken.

- Laboratorium voorraadbeheer

Chemische managementsystemen automatisch vullen met fysieke veiligheids- en dichtheidsgegevens.

- Koppel interne inventarislijsten aan WebElements-items.

- Scrape gegevens over dichtheid, opslaggevaren en smeltpunten.

- Update de centrale laboratoriumdatabase via een API.

- Genereer automatische veiligheidswaarschuwingen voor elementen met een hoog risico.

Supercharge je workflow met AI-automatisering

Automatio combineert de kracht van AI-agents, webautomatisering en slimme integraties om je te helpen meer te bereiken in minder tijd.

Pro Tips voor het Scrapen van WebElements

Expertadvies voor het succesvol extraheren van gegevens uit WebElements.

Respecteer de Crawl-delay

1 zoals gespecificeerd in het robots.txt-bestand van de site.

Gebruik het atoomnummer als primaire sleutel voor databaseconsistentie.

Crawl de subpagina's 'history' en 'compounds' voor een volledige dataset per element.

Focus op tabel-gebaseerde selectors aangezien de sitestructuur zeer traditioneel en stabiel is.

Verifieer data aan de hand van IUPAC-standaarden als deze worden gebruikt voor kritisch onderzoek.

Sla numerieke waarden zoals dichtheid of smeltpunten op als floats voor eenvoudigere analyse.

Testimonials

Wat onze gebruikers zeggen

Sluit je aan bij duizenden tevreden gebruikers die hun workflow hebben getransformeerd

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Gerelateerd Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Veelgestelde vragen over WebElements

Vind antwoorden op veelvoorkomende vragen over WebElements