Jak scrapować Budget Bytes: Ekstrakcja przepisów i danych o kosztach

Dowiedz się, jak scrapować Budget Bytes, aby wyodrębnić składniki przepisów, wartości odżywcze i dane o kosztach za porcję. Idealne do planowania posiłków i...

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Request Throttling

O Budget Bytes

Odkryj, co oferuje Budget Bytes i jakie cenne dane można wyodrębnić.

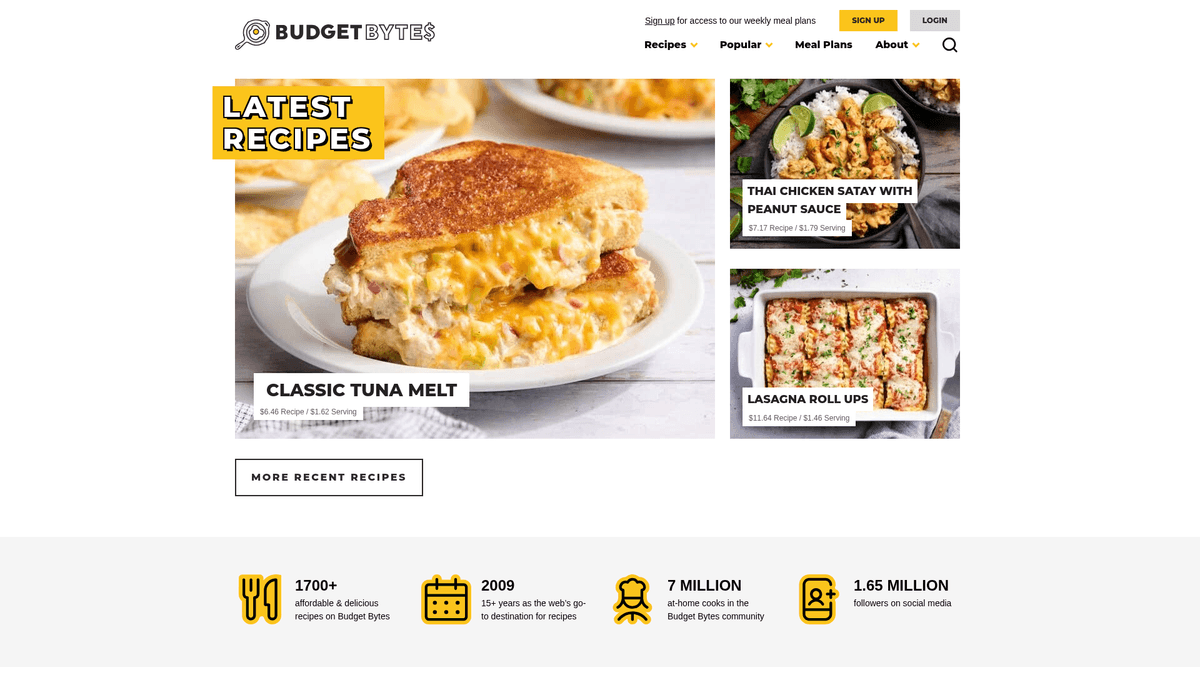

Autorytet w dziedzinie taniego gotowania

Budget Bytes to niezwykle popularny serwis kulinarny dedykowany dostarczaniu pysznych przepisów zaprojektowanych z myślą o niskich budżetach. Założona przez Beth Moncel w 2009 roku platforma stała się głównym źródłem informacji dla studentów, rodzin i każdego, kto chce zminimalizować marnowanie żywności przy jednoczesnym zachowaniu pełni smaku. Witryna słynie ze skrupulatnych zestawień kosztów, obliczając cenę każdego składnika, aby podać całkowity koszt przepisu oraz koszt jednej porcji.

Kompleksowe dane o przepisach

W serwisie znajduje się ponad 1700 przepisów, od zestawów meal prep i dań jednogarnkowych, po opcje wegetariańskie i przepisy z wolnowaru. Każda pozycja zawiera szczegółowe składniki, zdjęcia krok po kroku, informacje o wartościach odżywczych i recenzje użytkowników. Tak ustrukturyzowane podejście sprawia, że witryna jest skarbnicą danych dla osób zainteresowanych połączeniem gastronomii i ekonomii.

Dlaczego warto scrapować Budget Bytes

Scrapowanie tych danych jest niezwykle wartościowe z kilku powodów. Pozwala na agregację pomysłów na tanie posiłki, śledzenie inflacji żywności poprzez analizę kosztów składników oraz tworzenie zbiorów danych do badań nad odżywianiem. Deweloperzy aplikacji do planowania posiłków i narzędzi do porównywania cen produktów spożywczych często korzystają z tych danych, aby oferować użytkownikom niedrogie, zdrowe opcje oparte na realnych punktach cenowych.

Dlaczego Scrapować Budget Bytes?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Budget Bytes.

Monitorowanie inflacji cen żywności poprzez analizę kosztów składników

Agregowanie pomysłów na tanie posiłki dla aplikacji finansów osobistych

Prowadzenie badań żywieniowych nad niedrogim odżywianiem

Budowanie automatycznych list zakupów w oparciu o progi budżetowe

Analiza trendów kulinarnych i popularnych kategorii żywności

Tworzenie konkurencyjnych benchmarków cenowych dla usług dostawy jedzenia

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Budget Bytes.

Omijanie nagłówków bezpieczeństwa Cloudflare i detekcji botów

Wyodrębnianie ustrukturyzowanych danych z bloków WordPress Recipe Maker (WPRM)

Obsługa niespójnych jednostek miar na listach składników

Zarządzanie rate limits na punktach końcowych WordPress REST API

Parsowanie dynamicznych ciągów znaków kosztu za porcję na wartości numeryczne

Scrapuj Budget Bytes z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Budget Bytes. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Budget Bytes, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Budget Bytes bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Budget Bytes. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Budget Bytes, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Środowisko no-code do natychmiastowego budowania złożonych scraperów

- Automatyczna obsługa wyzwań Cloudflare i systemów anti-bot

- Harmonogram uruchomień w celu automatycznego przechwytywania nowych cotygodniowych przepisów

- Bezpośrednia integracja z Google Sheets do śledzenia kosztów na żywo

Scrapery No-Code dla Budget Bytes

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Budget Bytes bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Budget Bytes

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Budget Bytes bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Adres URL

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# Standardowe nagłówki imitujące przeglądarkę

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Ekstrakcja podstawowych danych przepisu

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Błąd: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Budget Bytes za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Adres URL

url = 'https://www.budgetbytes.com/creamy-mushroom-pasta/'

# Standardowe nagłówki imitujące przeglądarkę

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Ekstrakcja podstawowych danych przepisu

data = {

'title': soup.find('h1').get_text(strip=True),

'cost_per': soup.find('span', class_='cost-per').get_text(strip=True) if soup.find('span', class_='cost-per') else 'N/A',

'ingredients': [li.get_text(strip=True) for li in soup.find_all('li', class_='wprm-recipe-ingredient')]

}

print(data)

except Exception as e:

print(f'Błąd: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_budget_bytes():

async with async_playwright() as p:

# Uruchomienie przeglądarki

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

# Nawigacja do strony przepisu

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/')

# Oczekiwanie na załadowanie kontenera przepisu

await page.wait_for_selector('.wprm-recipe-container')

# Ekstrakcja danych via page.evaluate

recipe_data = await page.evaluate('''() => {

return {

title: document.querySelector('.wprm-recipe-name')?.innerText,

total_cost: document.querySelector('.wprm-recipe-cost')?.innerText,

calories: document.querySelector('.wprm-nutrition-label-text-nutrition-value-calories')?.innerText

}

}''')

print(recipe_data)

await browser.close()

asyncio.run(scrape_budget_bytes())Python + Scrapy

import scrapy

class BudgetBytesSpider(scrapy.Spider):

name = 'budget_bytes'

# Użycie WordPress REST API dla czystszej ekstrakcji danych

start_urls = ['https://www.budgetbytes.com/wp-json/wp/v2/posts?per_page=20']

def parse(self, response):

posts = response.json()

for post in posts:

yield {

'id': post.get('id'),

'title': post.get('title', {}).get('rendered'),

'url': post.get('link'),

'published_date': post.get('date'),

'slug': post.get('slug')

}

# Obsługa paginacji, jeśli jest dostępna w nagłówkach

# (Logika pominięta dla zwięzłości)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Ustawienie user agent, aby uniknąć podstawowych blokad

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36');

await page.goto('https://www.budgetbytes.com/one-pot-creamy-mushroom-pasta/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const title = document.querySelector('.wprm-recipe-name')?.textContent;

const costPerServing = document.querySelector('.cost-per')?.textContent;

const items = Array.from(document.querySelectorAll('.wprm-recipe-ingredient')).map(i => i.textContent.trim());

return { title, costPerServing, items };

});

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi Budget Bytes

Poznaj praktyczne zastosowania i wnioski z danych Budget Bytes.

Tracker inflacji cen żywności

Monitoruj w czasie rzeczywistym zmiany kosztów zakupów spożywczych, scrapując ceny poszczególnych składników w różnych kategoriach przepisów.

Jak wdrożyć:

- 1Zaplanuj cotygodniowy scraping pola kosztu za porcję dla 100 najpopularniejszych przepisów.

- 2Porównuj wartości miesiąc do miesiąca, aby zidentyfikować najszybciej drożejące kategorie.

- 3Wizualizuj korelację między konkretnymi składnikami (np. jajkami lub nabiałem) a całkowitą ceną przepisu.

Użyj Automatio do wyodrębnienia danych z Budget Bytes i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Budget Bytes

- Tracker inflacji cen żywności

Monitoruj w czasie rzeczywistym zmiany kosztów zakupów spożywczych, scrapując ceny poszczególnych składników w różnych kategoriach przepisów.

- Zaplanuj cotygodniowy scraping pola kosztu za porcję dla 100 najpopularniejszych przepisów.

- Porównuj wartości miesiąc do miesiąca, aby zidentyfikować najszybciej drożejące kategorie.

- Wizualizuj korelację między konkretnymi składnikami (np. jajkami lub nabiałem) a całkowitą ceną przepisu.

- Aplikacja Inteligentny Planer Posiłków

Zasila bazę danych aplikacji dietetycznej, która sugeruje przepisy na podstawie rygorystycznego dziennego budżetu użytkownika.

- Scrapuj nazwy przepisów, koszt za porcję i tagi dietetyczne (Wegańskie, GF).

- Filtruj przepisy, których koszt mieści się w progu 2 USD za porcję.

- Eksportuj dane do API na potrzeby aplikacji mobilnej.

- Optymalizator makroskładników do ceny

Znajdź najlepsze przepisy pod kątem 'ilości białka na dolara', aby pomóc sportowcom lub entuzjastom fitnessu oszczędzać na diecie.

- Wyodrębnij zarówno dane o wartościach odżywczych (gramy białka), jak i dane o kosztach przepisu.

- Oblicz niestandardowy stosunek białka do ceny dla każdego wpisu.

- Rankuj przepisy, aby znaleźć najbardziej efektywne, wysokobiałkowe posiłki budżetowe.

- Silnik sugestii zarządzania zapasami

Pomóż użytkownikom redukować marnowanie żywności poprzez identyfikację przepisów opartych na powszechnych składnikach spiżarni wyodrębnionych z witryny.

- Scrapuj i normalizuj listy składników do przeszukiwalnej bazy danych.

- Pozwól użytkownikom wprowadzać składniki, które mają w domu.

- Dopasuj dane wejściowe użytkownika do scrapowanych danych, aby zasugerować najtańszy posiłek do przygotowania.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Budget Bytes

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Budget Bytes.

Uzyskaj dostęp do WordPress REST API pod adresem /wp-json/wp/v2/posts, aby pobierać szybkie, strukturalne dane JSON bez konieczności parsowania HTML.

Zlokalizuj tagi skryptu 'ld+json' w sekcji head, aby wyodrębnić metadane przepisów Schema.org, w tym czas przygotowania i wartości odżywcze.

Używaj residential proxies, aby omijać błędy 403 Forbidden wywoływane przez warstwę zabezpieczeń Cloudflare podczas masowego scrapowania.

Zastosuj opóźnienie 3-5 sekund między żądaniami, aby szanować serwer i uniknąć tymczasowego blokowania adresu IP.

Szukaj klas CSS 'WPRM' (WordPress Recipe Maker), aby uzyskać spójne selektory dla różnych formatów przepisów.

Zapisuj scrapowane obrazy lokalnie lub poprzez linki CDN, aby zapobiec wygasaniu odniesień do zdjęć w eksportowanych danych.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Często Zadawane Pytania o Budget Bytes

Znajdź odpowiedzi na częste pytania o Budget Bytes