Jak scrapować BureauxLocaux: Przewodnik po danych nieruchomości komercyjnych

Pozyskuj dane o nieruchomościach komercyjnych z BureauxLocaux. Scrapuj ceny biur, lokalizacje magazynów i dane agentów we Francji dla analiz rynkowych.

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- CSRF Protection

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- User-Agent Filtering

- Wyzwanie JavaScript

- Wymaga wykonania JavaScript, aby uzyskać dostęp do treści. Proste żądania nie przejdą; potrzebna przeglądarka headless jak Playwright lub Puppeteer.

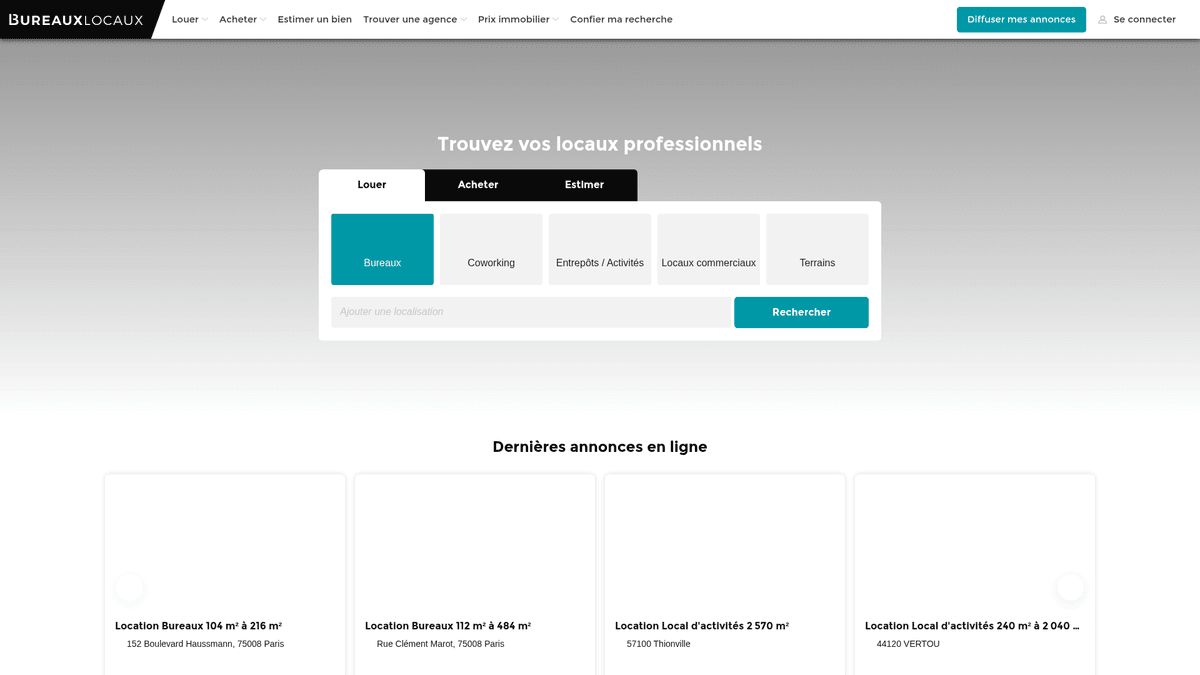

O BureauxLocaux

Odkryj, co oferuje BureauxLocaux i jakie cenne dane można wyodrębnić.

Francuski portal nieruchomości komercyjnych

BureauxLocaux to wiodąca platforma cyfrowa we Francji dedykowana nieruchomościom profesjonalnym, ułatwiająca wynajem i sprzedaż biur, magazynów, powierzchni handlowych i hubów coworkingowych. Należąca do CoStar Group, platforma centralizuje dane od ponad 1800 wyspecjalizowanych agencji i hostuje ponad 72 000 aktywnych ogłoszeń, będąc definitywnym źródłem wiedzy o nieruchomościach B2B.

Kompleksowa analityka rynkowa

Platforma oferuje szczegółowy wgląd we francuski krajobraz komercyjny, od prestiżowych dzielnic biznesowych Paryża po centra logistyczne w Lyonie i Marsylii. Służy jako kluczowy most między poszukującymi nieruchomości a wyspecjalizowanymi brokerami, dostarczając szczegółowych specyfikacji technicznych wykraczających poza proste zestawienia cenowe.

Dlaczego te dane są ważne

Scrapowanie BureauxLocaux jest niezbędne dla deweloperów, inwestorów i urbanistów. Ogłoszenia na platformie dostarczają danych w czasie rzeczywistym na temat trendów cen wynajmu, wskaźników pustostanów i ocen wydajności energetycznej (DPE), które są krytyczne do budowania predykcyjnych modeli rynkowych i identyfikacji okazji inwestycyjnych o wysokiej stopie zwrotu.

Dlaczego Scrapować BureauxLocaux?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z BureauxLocaux.

Monitorowanie wahań cen wynajmu komercyjnego w metropoliach Francji

Analiza porównawcza portfolio i udziału w rynku wyspecjalizowanych agencji nieruchomości

Identyfikacja potencjalnych leadów dla usług renowacji i wykańczania biur

Śledzenie wskaźników pustostanów w magazynach przemysłowych dla planowania logistyki

Analiza wzrostu przestrzeni coworkingowych w porównaniu do tradycyjnego najmu biur

Gromadzenie danych treningowych dla real estate valuation AI model

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania BureauxLocaux.

Omijanie agresywnego zarządzania botami Cloudflare i wyzwań JS

Wyodrębnianie dynamicznej treści ładowanej przez wewnętrzne żądania AJAX

Obsługa tokenów CSRF wymaganych do dostępu do szczegółowych danych kontaktowych agentów

Normalizacja pofragmentowanych formatów danych cenowych (m2/rok vs miesięczne koszty stanowiska pracy)

Adaptacja do częstych zmian struktury w siatce atrybutów nieruchomości

Scrapuj BureauxLocaux z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z BureauxLocaux. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po BureauxLocaux, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie BureauxLocaux bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z BureauxLocaux. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po BureauxLocaux, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Płynne omijanie zabezpieczeń Cloudflare bez pisania niestandardowego kodu

- Automatyczna obsługa renderowania JavaScript dla dynamicznych siatek ogłoszeń

- Zaplanowane uruchomienia pozwalają na automatyczne codzienne monitorowanie rynku i alerty

- Wykorzystuje rezydencjalne proxy premium, aby uniknąć rate limiting opartego na IP

- Wizualny selektor ułatwia targetowanie złożonych specyfikacji technicznych nieruchomości

Scrapery No-Code dla BureauxLocaux

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu BureauxLocaux bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla BureauxLocaux

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu BureauxLocaux bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Uwaga: Może zostać zablokowane przez Cloudflare bez zaawansowanych nagłówków/proxy

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Przykład: Wybieranie kart ogłoszeń

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Ogłoszenie: {title} | Cena: {price}')

except Exception as e:

print(f'Scraping nie powiódł się: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować BureauxLocaux za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Uwaga: Może zostać zablokowane przez Cloudflare bez zaawansowanych nagłówków/proxy

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Przykład: Wybieranie kart ogłoszeń

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Ogłoszenie: {title} | Cena: {price}')

except Exception as e:

print(f'Scraping nie powiódł się: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Zalecane uruchomienie ze stealth lub specyficznym UA

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Nawigacja do wyników wyszukiwania

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Czekaj na wyrenderowanie ogłoszeń

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Kontakt z agentem"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Pętla przez każdą kartę ogłoszenia na stronie

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Paginacja: Znajdź link do następnej strony

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Ustawienie realistycznego User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Wyodrębnianie danych z elementów ogłoszeń

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi BureauxLocaux

Poznaj praktyczne zastosowania i wnioski z danych BureauxLocaux.

Indeksowanie czynszów komercyjnych

Analitycy finansowi mogą budować dynamiczny indeks kosztów wynajmu biur, aby doradzać klientom korporacyjnym w zakresie strategii lokalizacyjnej.

Jak wdrożyć:

- 1Scrapuj co tydzień wszystkie aktywne ogłoszenia biurowe w głównych miastach Francji.

- 2Oblicz cenę za metr kwadratowy rocznie dla każdego wpisu.

- 3Grupuj dane według dzielnic (Arrondissement), aby zidentyfikować klastry cenowe.

- 4Wizualizuj „mapę cieplną cen” za pomocą narzędzi takich jak Tableau.

Użyj Automatio do wyodrębnienia danych z BureauxLocaux i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi BureauxLocaux

- Indeksowanie czynszów komercyjnych

Analitycy finansowi mogą budować dynamiczny indeks kosztów wynajmu biur, aby doradzać klientom korporacyjnym w zakresie strategii lokalizacyjnej.

- Scrapuj co tydzień wszystkie aktywne ogłoszenia biurowe w głównych miastach Francji.

- Oblicz cenę za metr kwadratowy rocznie dla każdego wpisu.

- Grupuj dane według dzielnic (Arrondissement), aby zidentyfikować klastry cenowe.

- Wizualizuj „mapę cieplną cen” za pomocą narzędzi takich jak Tableau.

- Lead Gen w nieruchomościach

Dostawcy usług B2B mogą znaleźć firmy przenoszące się do nowych przestrzeni, które wymagają konfiguracji IT, mebli lub ubezpieczenia.

- Targetuj ogłoszenia oznaczone jako „Ostatnio dostępne” lub „Nowe na rynku”.

- Wyodrębnij dane kontaktowe agencji wystawiającej ogłoszenie w celu nawiązania partnerstwa.

- Śledź usunięcia nieruchomości, aby oszacować, kiedy firma pomyślnie podpisała umowę najmu.

- Automatyzuj wpisy w CRM dla nowych potencjalnych projektów renowacji biur.

- Śledzenie czasu trwania pustostanów

Badacze ekonomiczni mogą monitorować, jak długo nieruchomości przemysłowe pozostają na rynku, aby ocenić kondycję lokalnej gospodarki.

- Scrapuj wszystkie ogłoszenia magazynów i zapisuj datę „pierwszego pojawienia się”.

- Stale weryfikuj, które ogłoszenia są nadal aktywne, a które zostały usunięte.

- Oblicz średni „czas na rynku” (ToM) dla każdej strefy przemysłowej.

- Koreluj wysoki ToM ze specyficznymi regionalnymi spowolnieniami gospodarczymi.

- Automatyzacja filtrów inwestycyjnych

Inwestorzy mogą otrzymywać natychmiastowe alerty, gdy ceny nieruchomości spadną poniżej określonego progu w wybranych obszarach.

- Skonfiguruj codzienne scrapowanie dla specyficznych kategorii, takich jak „Vente de Bureaux”.

- Porównuj codzienną cenę z historyczną średnią dla danego kodu pocztowego.

- Uruchom powiadomienie, jeśli ogłoszenie jest wycenione o 15% poniżej średniej rynkowej.

- Eksportuj przefiltrowane oferty do Google Sheet w celu natychmiastowego przeglądu.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania BureauxLocaux

Porady ekspertów dotyczące skutecznej ekstrakcji danych z BureauxLocaux.

Używaj wysokiej jakości rezydencjalnych proxy specyficznych dla Francji, aby uniknąć blokad opartych na regionie.

Zawsze uwzględniaj „HT” (Hors Taxes) i „HC” (Hors Charges) w swoich parserach cen, aby uniknąć zniekształcenia danych.

Monitoruj kartę „Network”, aby znaleźć wewnętrzne endpointy JSON używane do dynamicznego ładowania.

Rotuj User-Agents i browser fingerprints, aby zapobiec wykryciu przez analizę behawioralną Cloudflare.

Zaimplementuj losowy interwał uśpienia (3-10 sekund) między ładowaniami stron, aby naśladować zachowanie człowieka.

Przechowuj Listing Reference ID jako unikalny klucz, aby śledzić zmiany cen w czasie bez duplikowania rekordów.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Często Zadawane Pytania o BureauxLocaux

Znajdź odpowiedzi na częste pytania o BureauxLocaux