Jak pobierać dane z Pollen.com: Przewodnik po ekstrakcji lokalnych danych o alergiach

Dowiedz się, jak pobierać dane z Pollen.com w celu uzyskania lokalnych prognoz alergii, poziomów pyłków i głównych alergenów. Pobieraj codzienne dane zdrowotne...

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- AngularJS Rendering

O Pollen.com

Odkryj, co oferuje Pollen.com i jakie cenne dane można wyodrębnić.

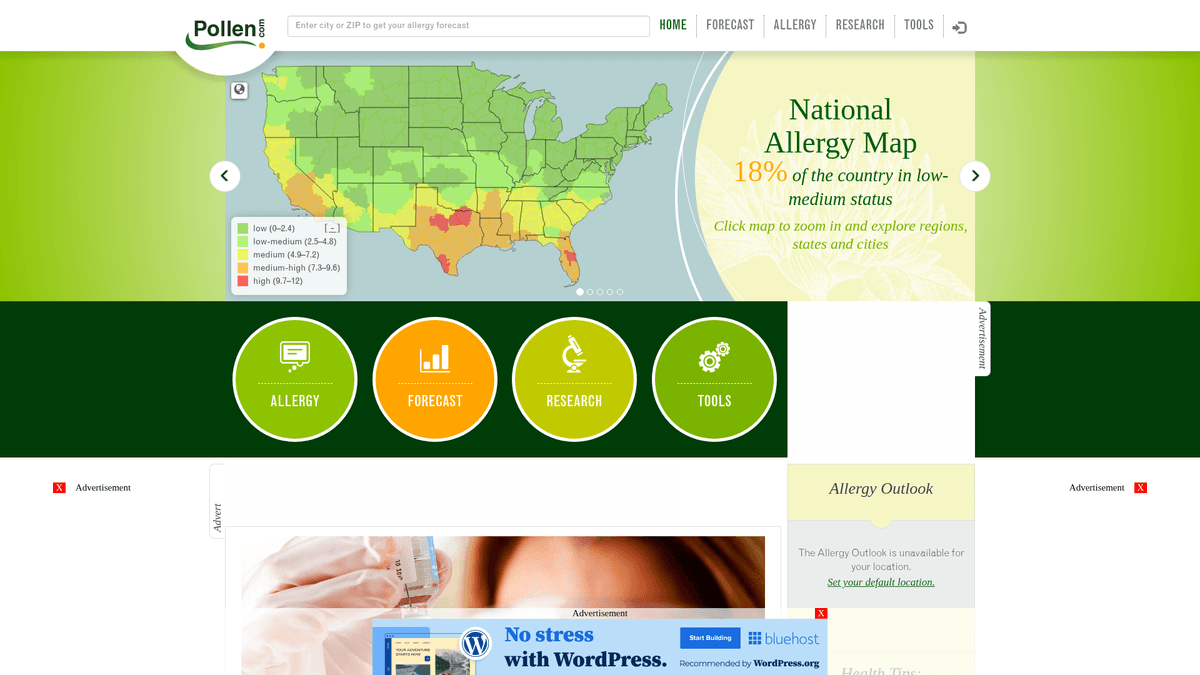

Kompleksowe dane o alergiach w USA

Pollen.com to wiodący portal poświęcony zdrowiu środowiskowemu, dostarczający wysoce zlokalizowane informacje o alergiach i prognozy w całych Stanach Zjednoczonych. Platforma, której właścicielem i operatorem jest IQVIA, prominentna firma zajmująca się analityką danych zdrowotnych, oferuje konkretne stężenia pyłków i rodzaje alergenów na podstawie kodów pocztowych. Służy jako kluczowe źródło informacji dla osób zmagających się z sezonowymi schorzeniami układu oddechowego oraz dla pracowników medycznych śledzących trendy w zdrowiu środowiskowym.

Cenne dane dla zdrowia publicznego

Większość danych strukturalnych na stronie obejmuje wskaźnik pyłkowy w skali od 0 do 12, kategorie głównych alergenów, takich jak drzewa, chwasty i trawy, oraz szczegółowe prognozy 5-dniowe. Dla programistów i badaczy dane te dostarczają wglądu w regionalne czynniki środowiskowe i historyczne wzorce alergii, które są trudne do zagregowania z ogólnych serwisów pogodowych.

Użyteczność biznesowa i badawcza

Scraping Pollen.com jest wartościowy do budowania aplikacji monitorujących zdrowie, optymalizacji łańcuchów dostaw farmaceutycznych dla leków na alergię oraz prowadzenia badań akademickich nad wpływem zmian klimatu na cykle pylenia. Automatyzując ekstrakcję tych punktów danych, organizacje mogą dostarczać wartość w czasie rzeczywistym osobom cierpiącym na alergie w całym kraju.

Dlaczego Scrapować Pollen.com?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Pollen.com.

Buduj personalizowane systemy alertów alergicznych dla aplikacji zdrowotnych

Przewiduj trendy popytu farmaceutycznego na lokalne leki na alergię

Prowadź badania środowiskowe nad regionalnymi sezonami pylenia

Agreguj hiper-lokalne dane zdrowotne dla portali informacyjnych i pogodowych

Analizuj historyczne wzorce alergii dla miejskiego planowania zdrowia publicznego

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Pollen.com.

Dynamiczne renderowanie treści za pomocą AngularJS wymaga automatyzacji przeglądarki lub scraperów typu headless

Główne dane prognozy są ładowane przez asynchroniczne, wewnętrzne wywołania API, które są chronione sesją

Rygorystyczne limity zapytań (rate limiting) przy powtarzających się wyszukiwaniach geograficznych kodów pocztowych mogą prowadzić do tymczasowych blokad IP

Ochrona przed botami Cloudflare często uruchamia wyzwania dla programów typu user agent niebędących przeglądarkami

Scrapuj Pollen.com z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Pollen.com. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Pollen.com, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Pollen.com bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Pollen.com. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Pollen.com, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Automatyczne renderowanie JavaScript obsługuje złożone dane wykresów AngularJS bez dodatkowego kodu

- Wbudowana rotacja proxy skutecznie omija zabezpieczenia Cloudflare i limity zapytań oparte na IP

- Zaplanowane uruchomienia pozwalają na w pełni zautomatyzowane codzienne zbieranie danych z tysięcy kodów pocztowych

- Interfejs no-code ułatwia konfigurację ekstrakcji danych dla konkretnych regionów geograficznych

Scrapery No-Code dla Pollen.com

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Pollen.com bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Pollen.com

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Pollen.com bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Uwaga: To przechwytuje statyczne metadane wiadomości.

# Główne dane prognozy wymagają renderowania JavaScript lub bezpośredniego dostępu do wewnętrznego API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Wyodrębnij podstawowe tytuły wiadomości z paska bocznego

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Najnowsze wiadomości o alergiach: {news}')

except Exception as e:

print(f'Wystąpił błąd: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Pollen.com za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Uwaga: To przechwytuje statyczne metadane wiadomości.

# Główne dane prognozy wymagają renderowania JavaScript lub bezpośredniego dostępu do wewnętrznego API.

url = 'https://www.pollen.com/forecast/current/pollen/20001'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Wyodrębnij podstawowe tytuły wiadomości z paska bocznego

news = [a.text.strip() for a in soup.select('article h2 a')]

print(f'Najnowsze wiadomości o alergiach: {news}')

except Exception as e:

print(f'Wystąpił błąd: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

browser = playwright.chromium.launch(headless=True)

page = browser.new_page()

# Nawiguj do prognozy dla konkretnego kodu pocztowego

page.goto('https://www.pollen.com/forecast/current/pollen/20001')

# Czekaj, aż AngularJS wyrenderuje dynamiczny wskaźnik pyłkowy

page.wait_for_selector('.forecast-level')

data = {

'pollen_index': page.inner_text('.forecast-level'),

'status': page.inner_text('.forecast-level-desc'),

'allergens': [el.inner_text() for el in page.query_selector_all('.top-allergen-item span')]

}

print(f'Dane dla 20001: {data}')

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class PollenSpider(scrapy.Spider):

name = 'pollen_spider'

start_urls = ['https://www.pollen.com/forecast/current/pollen/20001']

def parse(self, response):

# W przypadku treści dynamicznych użyj Scrapy-Playwright lub podobnego middleware

# Ta standardowa metoda parse obsługuje elementy statyczne, takie jak nagłówki

yield {

'url': response.url,

'page_title': response.css('title::text').get(),

'news_headlines': response.css('article h2 a::text').getall()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Ustaw User-Agent, aby naśladować prawdziwą przeglądarkę

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64)');

await page.goto('https://www.pollen.com/forecast/current/pollen/20001');

// Czekaj, aż pojawi się dynamiczny poziom prognozy

await page.waitForSelector('.forecast-level');

const data = await page.evaluate(() => ({

pollenIndex: document.querySelector('.forecast-level')?.innerText,

description: document.querySelector('.forecast-level-desc')?.innerText,

location: document.querySelector('h1')?.innerText

}));

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi Pollen.com

Poznaj praktyczne zastosowania i wnioski z danych Pollen.com.

Personalizowane alerty alergiczne

Aplikacje mobilne dla zdrowia mogą dostarczać użytkownikom powiadomienia w czasie rzeczywistym, gdy poziom pyłków osiągnie wysoki poziom w ich konkretnej okolicy.

Jak wdrożyć:

- 1Pobieraj codzienne prognozy dla kodów pocztowych przesłanych przez użytkowników

- 2Zidentyfikuj, kiedy wskaźnik pyłkowy przekroczy 'Wysoki' próg (7.3+)

- 3Wysyłaj automatyczne powiadomienia push lub alerty SMS do użytkownika

Użyj Automatio do wyodrębnienia danych z Pollen.com i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Pollen.com

- Personalizowane alerty alergiczne

Aplikacje mobilne dla zdrowia mogą dostarczać użytkownikom powiadomienia w czasie rzeczywistym, gdy poziom pyłków osiągnie wysoki poziom w ich konkretnej okolicy.

- Pobieraj codzienne prognozy dla kodów pocztowych przesłanych przez użytkowników

- Zidentyfikuj, kiedy wskaźnik pyłkowy przekroczy 'Wysoki' próg (7.3+)

- Wysyłaj automatyczne powiadomienia push lub alerty SMS do użytkownika

- Prognozowanie popytu na leki

Sprzedawcy farmaceutyczni mogą optymalizować stany magazynowe poprzez korelację lokalnych skoków pylenia z przewidywanym popytem na leki przeciwhistaminowe.

- Wyodrębnij dane z 5-dniowej prognozy dla głównych regionów metropolitalnych

- Zidentyfikuj nadchodzące okresy wysokiej aktywności alergenów

- Koordynuj dystrybucję zapasów do lokalnych aptek przed wystąpieniem szczytu

- Ocena środowiskowa nieruchomości

Serwisy z ogłoszeniami nieruchomości mogą dodać 'Ranking Alergiczny', aby pomóc wrażliwym kupującym ocenić jakość powietrza w okolicy.

- Agreguj historyczne dane o pyłkach dla konkretnych dzielnic miast

- Oblicz średni roczny wynik intensywności pylenia

- Wyświetl wynik jako niestandardową funkcję na stronie szczegółów nieruchomości

- Badania nad zmianami klimatu

Naukowcy zajmujący się środowiskiem mogą śledzić długość i intensywność sezonów pylenia w czasie, aby badać wpływ klimatu.

- Pobieraj codzienne gatunki pyłków i wskaźniki w sezonach wiosennym i jesiennym

- Porównaj daty rozpoczęcia i zakończenia pylenia ze średnimi historycznymi

- Analizuj dane pod kątem trendów wskazujących na dłuższe lub bardziej intensywne sezony alergiczne

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Pollen.com

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Pollen.com.

Celuj w wewnętrzne punkty końcowe API znalezione w ruchu sieciowym, aby uzyskać bezpośredni dostęp do danych JSON.

Używaj rezydencjalnych serwerów proxy do rotacji adresu IP i unikaj aktywowania ochrony przed botami Cloudflare.

Wykonuj scraping codziennie wczesnym rankiem (około godziny 7:00 czasu EST), aby przechwycić najświeższe aktualizacje prognoz.

Upewnij się, że Twój scraper wykonuje JavaScript, ponieważ Pollen.com używa AngularJS do wypełniania wskaźników.

Wprowadź losowe opóźnienie (sleep delay) od 3 do 10 sekund między żądaniami dla różnych kodów pocztowych.

Regularnie monitoruj strukturę witryny, ponieważ nazwy klas AngularJS mogą ulec zmianie podczas aktualizacji strony.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape American Museum of Natural History (AMNH)

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Poll-Maker: A Comprehensive Web Scraping Guide

Często Zadawane Pytania o Pollen.com

Znajdź odpowiedzi na częste pytania o Pollen.com