Jak scrapować SeLoger Bureaux & Commerces

Dowiedz się, jak scrapować SeLoger Bureaux & Commerces, aby pozyskać dane o nieruchomościach komercyjnych. Wyodrębniaj ceny, powierzchnie i dane agencji,...

Wykryto ochronę przed botami

- DataDome

- Wykrywanie botów w czasie rzeczywistym za pomocą modeli ML. Analizuje odcisk urządzenia, sygnały sieciowe i wzorce zachowań. Częsty na stronach e-commerce.

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Google reCAPTCHA

- System CAPTCHA Google. v2 wymaga interakcji użytkownika, v3 działa cicho z oceną ryzyka. Można rozwiązać za pomocą usług CAPTCHA.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- Fingerprinting przeglądarki

- Identyfikuje boty po cechach przeglądarki: canvas, WebGL, czcionki, wtyczki. Wymaga spoofingu lub prawdziwych profili przeglądarki.

O SeLoger Bureaux & Commerces

Odkryj, co oferuje SeLoger Bureaux & Commerces i jakie cenne dane można wyodrębnić.

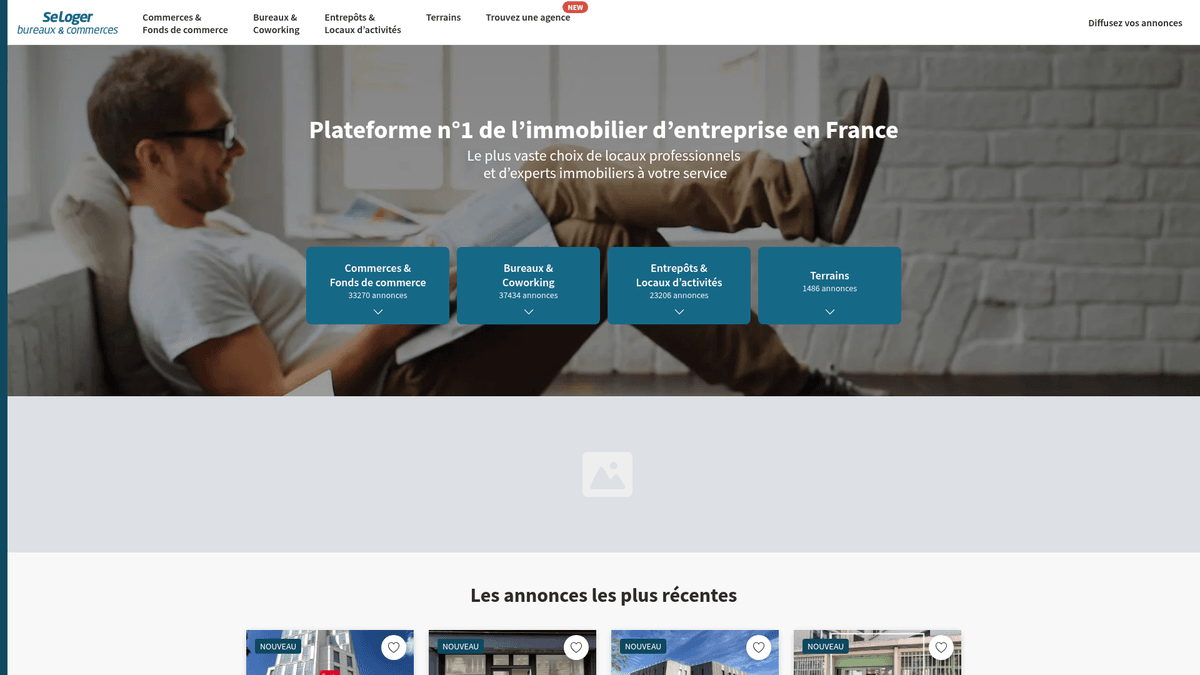

Lider francuskich nieruchomości komercyjnych

SeLoger Bureaux & Commerces to specjalistyczny portal nieruchomości profesjonalnych należący do Grupy SeLoger, wiodącej sieci nieruchomości we Francji. Służy jako dedykowany rynek dla transakcji B2B, obejmujący powierzchnie biurowe, magazyny, lokale handlowe i grunty pod inwestycje komercyjne. Platforma jest wykorzystywana przez główne agencje krajowe i niezależnych brokerów do łączenia się z profesjonalnymi inwestorami i właścicielami firm w całym kraju.

Wartość danych

Scrapowanie tej strony jest niezwykle cenne dla inwestorów nieruchomości i analityków rynkowych, którzy muszą monitorować francuski rynek nieruchomości komercyjnych. Wyodrębniając aktualne dane o ogłoszeniach, firmy mogą śledzić trendy cen za metr kwadratowy, identyfikować wschodzące centra handlowe i monitorować portfele konkurencyjnych agencji. Dane te są niezbędne do przeprowadzania dokładnych wycen nieruchomości i identyfikowania wysokodochodowych okazji inwestycyjnych na rynku francuskim.

Dlaczego Scrapować SeLoger Bureaux & Commerces?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z SeLoger Bureaux & Commerces.

Przeprowadzanie badań francuskiego rynku nieruchomości i analiza trendów komercyjnych.

Automatyzacja monitorowania cen nieruchomości inwestycyjnych w różnych departamentach.

Generowanie leadów dla dostawców usług B2B, takich jak firmy przeprowadzkowe lub dostawcy mebli biurowych.

Zbieranie danych wywiadowczych o zasięgu portali nieruchomości i portfelach agencji.

Gromadzenie danych historycznych do budowy automatycznych modeli wyceny nieruchomości.

Monitorowanie nowych okazji handlowych pod kątem planowania ekspansji biznesowej.

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania SeLoger Bureaux & Commerces.

Agresywna ochrona DataDome, która wykrywa i blokuje standardowe przeglądarki headless browser.

Znaczne ryzyko prawne związane z komercyjnym ponownym wykorzystaniem danych w oparciu o wcześniejsze precedensy.

Wymóg stosowania wyrafinowanych technik podszywania się pod fingerprint TLS i JA3.

Częste zmiany w strukturze front-end DOM, które niszczą statyczne selektory CSS.

Rygorystyczne ograniczanie liczby żądań (rate limiting) i automatyczne blokowanie IP przy żądaniach o wysokiej częstotliwości.

Scrapuj SeLoger Bureaux & Commerces z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z SeLoger Bureaux & Commerces. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po SeLoger Bureaux & Commerces, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie SeLoger Bureaux & Commerces bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z SeLoger Bureaux & Commerces. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po SeLoger Bureaux & Commerces, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Automatycznie obsługuje złożone systemy anti-bot, takie jak DataDome i Cloudflare.

- Nie wymaga znajomości programowania do skonfigurowania przepływów wyodrębniania nieruchomości dla dowolnej kategorii.

- Działa w chmurze z zaawansowanym harmonogramem, aby codziennie śledzić nowe ogłoszenia.

- Omija wyzwania związane z renderowaniem JavaScript bez konieczności ręcznej konfiguracji przeglądarki.

- Eksportuje ustrukturyzowane dane bezpośrednio do Google Sheets, CSV lub przez Webhooks.

Scrapery No-Code dla SeLoger Bureaux & Commerces

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu SeLoger Bureaux & Commerces bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla SeLoger Bureaux & Commerces

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu SeLoger Bureaux & Commerces bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Uwaga: SeLoger używa DataDome; standardowe żądania requests prawdopodobnie zostaną zablokowane.

# Zalecane są specjalistyczne biblioteki jak curl_cffi do fingerprintingu TLS.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Użycie impersonate, aby ominąć blokady fingerprintingu TLS

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Przykładowy selektor dla tytułów nieruchomości

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Ogłoszenie: {title.get_text(strip=True)}')

else:

print(f'Zablokowane przez Anti-Bot. Kod statusu: {response.status_code}')

except Exception as e:

print(f'Napotkano błąd: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować SeLoger Bureaux & Commerces za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Uwaga: SeLoger używa DataDome; standardowe żądania requests prawdopodobnie zostaną zablokowane.

# Zalecane są specjalistyczne biblioteki jak curl_cffi do fingerprintingu TLS.

from curl_cffi import requests as c_requests

url = 'https://www.seloger-bureaux-commerces.com/location/bureau/paris'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

try:

# Użycie impersonate, aby ominąć blokady fingerprintingu TLS

response = c_requests.get(url, headers=headers, impersonate='chrome120')

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Przykładowy selektor dla tytułów nieruchomości

titles = soup.select('a[class*="Card_title"]')

for title in titles:

print(f'Ogłoszenie: {title.get_text(strip=True)}')

else:

print(f'Zablokowane przez Anti-Bot. Kod statusu: {response.status_code}')

except Exception as e:

print(f'Napotkano błąd: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def scrape_bucom():

async with async_playwright() as p:

# Headless=False pomaga uniknąć niektórych podstawowych wyzwalaczy detekcji botów

browser = await p.chromium.launch(headless=False)

context = await browser.new_context(

user_agent='Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36'

)

page = await context.new_page()

try:

# Celuj w konkretną kategorię komercyjną i miasto

await page.goto('https://www.seloger-bureaux-commerces.com/achat/bureau/lyon', wait_until='networkidle')

# Czekaj na wyrenderowanie kart ogłoszeń

await page.wait_for_selector('div[data-testid="listing-card"]', timeout=15000)

listings = await page.query_selector_all('div[data-testid="listing-card"]')

for card in listings:

title = await card.query_selector('h2')

price = await card.query_selector('span[class*="Price"]')

print(f"Tytuł: {await title.inner_text()} | Cena: {await price.inner_text()}")

except Exception as e:

print(f'Scrapowanie nie powiodło się: {e}')

finally:

await browser.close()

asyncio.run(scrape_bucom())Python + Scrapy

import scrapy

class SeLogerBucomSpider(scrapy.Spider):

name = 'bucom_spider'

allowed_domains = ['seloger-bureaux-commerces.com']

start_urls = ['https://www.seloger-bureaux-commerces.com/location/boutique']

custom_settings = {

'DOWNLOAD_DELAY': 5,

'RANDOMIZE_DOWNLOAD_DELAY': True,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'COOKIES_ENABLED': True

}

def parse(self, response):

# Wyodrębnij dane z kontenera wyników ogłoszeń

for listing in response.css('div[class*="Card_container"]'):

yield {

'title': listing.css('h2::text').get(),

'price': listing.css('span[class*="Price"]::text').get(),

'surface': listing.css('span[class*="Surface"]::text').get(),

'link': listing.css('a::attr(href)').get()

}

# Prosta obsługa paginacji

next_page = response.css('a[class*="PaginationNext"]::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer-extra');

const StealthPlugin = require('puppeteer-extra-plugin-stealth');

puppeteer.use(StealthPlugin());

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Emulacja zachowania człowieka za pomocą viewportu i agenta

await page.setViewport({ width: 1280, height: 800 });

try {

await page.goto('https://www.seloger-bureaux-commerces.com/location/bureau/paris', {

waitUntil: 'networkidle2'

});

const results = await page.evaluate(() => {

return Array.from(document.querySelectorAll('a[class*="Card_title"]')).map(el => ({

title: el.innerText,

url: el.href

}));

});

console.log(results);

} catch (err) {

console.error('Błąd ekstrakcji:', err);

} finally {

await browser.close();

}

})();Co Możesz Zrobić Z Danymi SeLoger Bureaux & Commerces

Poznaj praktyczne zastosowania i wnioski z danych SeLoger Bureaux & Commerces.

Indeks cen wynajmu komercyjnego

Ustal benchmark dla czynszów komercyjnych w różnych departamentach Francji w celu wyceny nieruchomości.

Jak wdrożyć:

- 1Scrapuj wszystkie aktywne ogłoszenia co miesiąc dla wybranych regionów.

- 2Wyczyść i znormalizuj dane o cenach i powierzchni do standardowej jednostki.

- 3Agreguj średnią cenę za metr kwadratowy według miasta i typu nieruchomości.

- 4Wizualizuj trendy w narzędziu BI, takim jak Tableau lub PowerBI.

Użyj Automatio do wyodrębnienia danych z SeLoger Bureaux & Commerces i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi SeLoger Bureaux & Commerces

- Indeks cen wynajmu komercyjnego

Ustal benchmark dla czynszów komercyjnych w różnych departamentach Francji w celu wyceny nieruchomości.

- Scrapuj wszystkie aktywne ogłoszenia co miesiąc dla wybranych regionów.

- Wyczyść i znormalizuj dane o cenach i powierzchni do standardowej jednostki.

- Agreguj średnią cenę za metr kwadratowy według miasta i typu nieruchomości.

- Wizualizuj trendy w narzędziu BI, takim jak Tableau lub PowerBI.

- Monitorowanie agencji konkurencyjnych

Śledź zasoby i wyniki rywalizujących agencji nieruchomości na rynku francuskim.

- Wyodrębnij nazwy agentów/agencji oraz numery referencyjne nieruchomości.

- Zidentyfikuj, jak długo nieruchomości pozostają na liście przed usunięciem.

- Analizuj udział w rynku konkretnych agencji w prestiżowych dzielnicach.

- Generuj raporty dotyczące strategii cenowych konkurencji.

- Lead Generation dla przeprowadzek B2B

Identyfikuj firmy, które prawdopodobnie będą się przenosić lub rozszerzać działalność o nowe powierzchnie biurowe.

- Filtruj ogłoszenia oznaczone jako 'Nowe' lub 'Dostępne od zaraz'.

- Monitoruj konkretne biurowce, aby zobaczyć, kiedy obecni najemcy się wyprowadzają.

- Porównuj scrapowane adresy z bazami danych rejestracji firm.

- Kontaktuj się z firmami zmieniającymi siedzibę, oferując im dopasowane usługi.

- Odkrywanie arbitrażu inwestycyjnego

Automatycznie flaguj nieruchomości wystawione znacznie poniżej lokalnej średniej rynkowej.

- Ustal średnie bazowe, korzystając z 6-miesięcznych historycznych scrapowanych danych.

- Skonfiguruj codzienny scraper dla nowych ogłoszeń komercyjnych.

- Oblicz cenę za m2 dla każdego nowego ogłoszenia i porównaj z bazą.

- Uruchom natychmiastowe powiadomienie e-mail dla ofert o 20% poniżej średniej.

- Planowanie ekspansji handlowej

Znajdź idealną lokalizację dla nowych sklepów na podstawie dostępności i kosztów w danej okolicy.

- Scrapuj dostępność lokali handlowych (butików) w wielu centrach miast.

- Mapuj zagęszczenie dostępnych powierzchni komercyjnych przy użyciu danych GPS.

- Analizuj korelację między natężeniem ruchu pieszego a cenami wynajmu.

- Eksportuj wyniki do systemu GIS w celu analizy przestrzennej.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania SeLoger Bureaux & Commerces

Porady ekspertów dotyczące skutecznej ekstrakcji danych z SeLoger Bureaux & Commerces.

Używaj wysokiej jakości francuskich rezydencjalnych proxy, aby wtopić się w legalny ruch lokalny.

Podziel zapytania według konkretnych kodów pocztowych (np. 75001, 75008), aby obejść limit 1 000 widocznych wyników.

Często rotuj fingerprinty TLS i nagłówki przeglądarki, aby uniknąć detekcji JA3 przez DataDome.

Wdróż losowe opóźnienia imitujące zachowanie człowieka (3-10 sekund) oraz ruchy myszy między interakcjami na stronie.

Monitoruj kartę sieciową pod kątem wywołań API 'next/data'; często zawierają one czyste obiekty JSON ze szczegółami nieruchomości.

Zawsze dołączaj nagłówek Referer wskazujący na stronę główną SeLoger podczas wykonywania żądań do głębokich linków.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Często Zadawane Pytania o SeLoger Bureaux & Commerces

Znajdź odpowiedzi na częste pytania o SeLoger Bureaux & Commerces