Jak scrapować We Work Remotely: Kompletny przewodnik

Dowiedz się, jak scrapować ogłoszenia o pracę z We Work Remotely. Wyodrębnij tytuły ofert, firmy, zarobki i więcej dla badań rynkowych lub własnego agregatora.

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

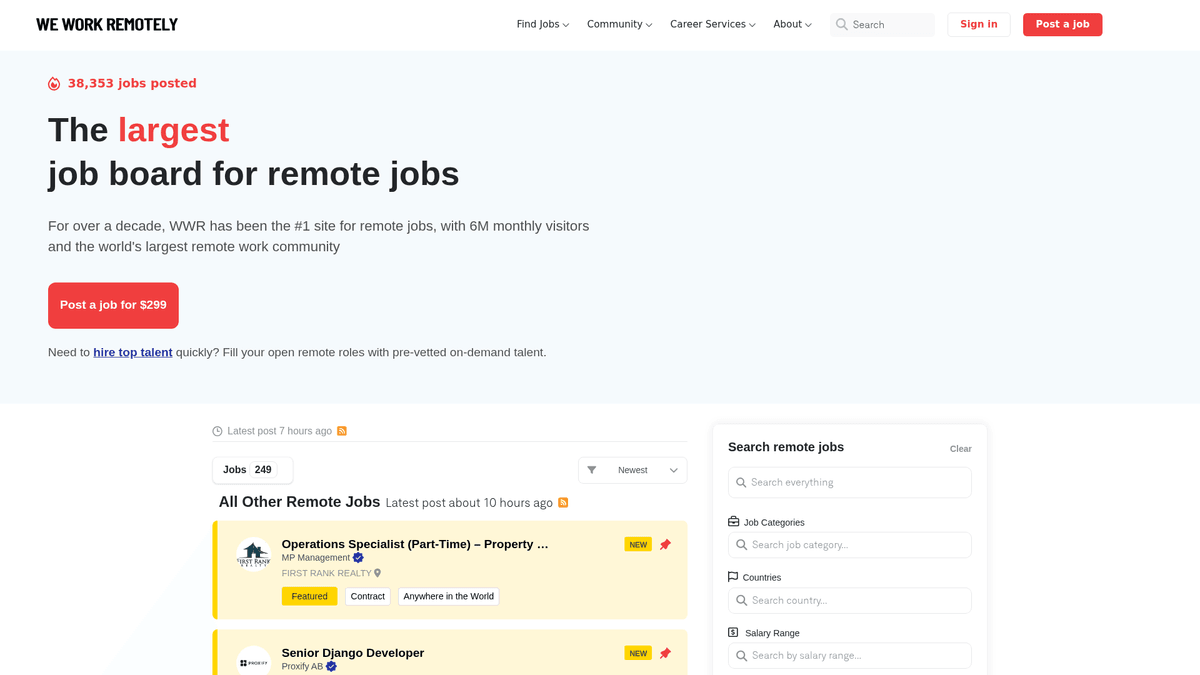

O We Work Remotely

Odkryj, co oferuje We Work Remotely i jakie cenne dane można wyodrębnić.

Centrum globalnych talentów zdalnych

We Work Remotely (WWR) to najbardziej ugruntowana społeczność pracy zdalnej na świecie, ciesząca się ponad 6 milionami odwiedzających miesięcznie. Służy jako główny cel dla firm odchodzących od tradycyjnych modeli biurowych, oferując różnorodne ogłoszenia w obszarach programowania, designu, marketingu i obsługi klienta.

Wysokiej jakości dane strukturyzowane

Platforma znana jest z wysoce strukturyzowanych danych. Każde ogłoszenie zazwyczaj zawiera specyficzne wymagania regionalne, widełki salary oraz szczegółowe profile firm. Ta struktura czyni ją idealnym celem dla web scraping, ponieważ dane są spójne i łatwe do kategoryzacji dla wtórnych zastosowań.

Strategiczna wartość dla specjalistów od danych

Dla rekruterów i badaczy rynku WWR to kopalnia złota. Scrapowanie tej strony pozwala na śledzenie trendów zatrudnienia w czasie rzeczywistym, benchmark płacowy w różnych sektorach technicznych oraz generowanie leadów dla usług B2B kierowanych do firm typu remote-first. Zapewnia to transparentny wgląd w globalny rynek pracy zdalnej.

Dlaczego Scrapować We Work Remotely?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z We Work Remotely.

Budowa niszowego agregatora lub portalu pracy zdalnej

Przeprowadzanie konkurencyjnej analizy wynagrodzeń w różnych branżach

Identyfikacja firm agresywnie zatrudniających w przestrzeni zdalnej

Monitorowanie globalnego popytu na konkretne umiejętności techniczne

Generowanie leadów dla dostawców technologii HR i benefitów

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania We Work Remotely.

Wyzwalanie zabezpieczeń anty-botowych Cloudflare

Obsługa niespójności w tagowaniu lokalizacji

Parsowanie zróżnicowanych formatów wynagrodzeń w opisach

Zarządzanie limitami IP (rate limits) podczas scrapowania dużej liczby stron szczegółowych

Scrapuj We Work Remotely z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z We Work Remotely. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po We Work Remotely, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie We Work Remotely bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z We Work Remotely. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po We Work Remotely, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Konfiguracja scrapowania no-code przez interfejs wizualny

- Automatyczna obsługa środków anty-botowych i proxy

- Zaplanowane uruchomienia dla aktualizacji ofert pracy w czasie rzeczywistym

- Bezpośredni eksport do JSON, CSV lub Google Sheets

- Wykonywanie w chmurze bez obciążania lokalnych zasobów

Scrapery No-Code dla We Work Remotely

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu We Work Remotely bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla We Work Remotely

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu We Work Remotely bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Send request with custom headers

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Target job listings

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Praca: {title} | Firma: {company}')

except Exception as e:

print(f'Błąd: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować We Work Remotely za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Send request with custom headers

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Target job listings

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Praca: {title} | Firma: {company}')

except Exception as e:

print(f'Błąd: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Launch headless browser

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Wait for the main container to load

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Iterate through listing items

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Extract data using evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();Co Możesz Zrobić Z Danymi We Work Remotely

Poznaj praktyczne zastosowania i wnioski z danych We Work Remotely.

Agregator ofert pracy zdalnej

Zbuduj wyspecjalizowaną platformę wyszukiwania pracy dla konkretnych nisz technicznych, takich jak Rust lub AI.

Jak wdrożyć:

- 1Codziennie scrapuj WWR w poszukiwaniu nowych ogłoszeń

- 2Filtruj według określonych słów kluczowych i kategorii

- 3Przechowuj dane w bazie danych z możliwością wyszukiwania

- 4Automatyzuj posty w mediach społecznościowych o nowych ofertach

Użyj Automatio do wyodrębnienia danych z We Work Remotely i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi We Work Remotely

- Agregator ofert pracy zdalnej

Zbuduj wyspecjalizowaną platformę wyszukiwania pracy dla konkretnych nisz technicznych, takich jak Rust lub AI.

- Codziennie scrapuj WWR w poszukiwaniu nowych ogłoszeń

- Filtruj według określonych słów kluczowych i kategorii

- Przechowuj dane w bazie danych z możliwością wyszukiwania

- Automatyzuj posty w mediach społecznościowych o nowych ofertach

- Analiza trendów płacowych

Analizuj dane o wynagrodzeniach zdalnych, aby określić globalne benchmarki wynagrodzeń dla różnych stanowisk.

- Wyodrębnij pola salary z opisów stanowisk

- Znormalizuj dane do jednej waluty

- Segmentuj według roli i poziomu doświadczenia

- Generuj kwartalne raporty rynkowe

- Generowanie leadów dla HR Tech

Identyfikuj firmy intensywnie zatrudniające zespoły zdalne, aby sprzedawać oprogramowanie HR, systemy płacowe i pakiety benefitów.

- Monitoruj listę „Top 100 Remote Companies”

- Śledź częstotliwość nowych ogłoszeń o pracę

- Identyfikuj decydentów w firmach rekrutujących

- Prowadź outreach z dopasowanymi rozwiązaniami B2B

- Historyczne trendy zatrudnienia

Analizuj dane długoterminowe, aby zrozumieć, jak popyt na pracę zdalną zmienia się sezonowo lub ekonomicznie.

- Archiwizuj ogłoszenia z okresu ponad 12 miesięcy

- Obliczaj wskaźniki wzrostu dla poszczególnych kategorii

- Wizualizuj trendy za pomocą narzędzi BI

- Przewiduj przyszły popyt na umiejętności

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania We Work Remotely

Porady ekspertów dotyczące skutecznej ekstrakcji danych z We Work Remotely.

Używaj endpointu /remote-jobs.rss, aby uzyskać czystszy, czytelny dla maszyn kanał XML, który pozwala pominąć złożone parsowanie HTML.

Rotuj rezydencjalne serwery proxy, aby uniknąć zabezpieczeń Cloudflare i stałych blokad IP podczas scrapowania na dużą skalę.

Zastosuj losowe opóźnienia między żądaniami, aby naśladować zachowanie człowieka i unikać limitów rate limits.

Normalizuj dane o lokalizacji, takie jak „Anywhere”, na „Global” lub „Remote”, aby uzyskać spójne filtrowanie w bazie danych.

Ustaw User-Agent na ciąg popularnej przeglądarki, aby uniknąć oflagowania jako prosty skrypt do scrapowania.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Często Zadawane Pytania o We Work Remotely

Znajdź odpowiedzi na częste pytania o We Work Remotely