Como fazer Scraping do BureauxLocaux: Guia de Dados de Imóveis Comerciais

Extraia dados de imóveis comerciais do BureauxLocaux. Faça scraping de preços de escritórios, localizações de armazéns e detalhes de corretores em toda a...

Proteção Anti-Bot Detectada

- Cloudflare

- WAF e gestão de bots de nível empresarial. Usa desafios JavaScript, CAPTCHAs e análise comportamental. Requer automação de navegador com configurações stealth.

- CSRF Protection

- Limitação de taxa

- Limita requisições por IP/sessão ao longo do tempo. Pode ser contornado com proxies rotativos, atrasos de requisição e scraping distribuído.

- User-Agent Filtering

- Desafio JavaScript

- Requer execução de JavaScript para acessar o conteúdo. Requisições simples falham; necessário navegador headless como Playwright ou Puppeteer.

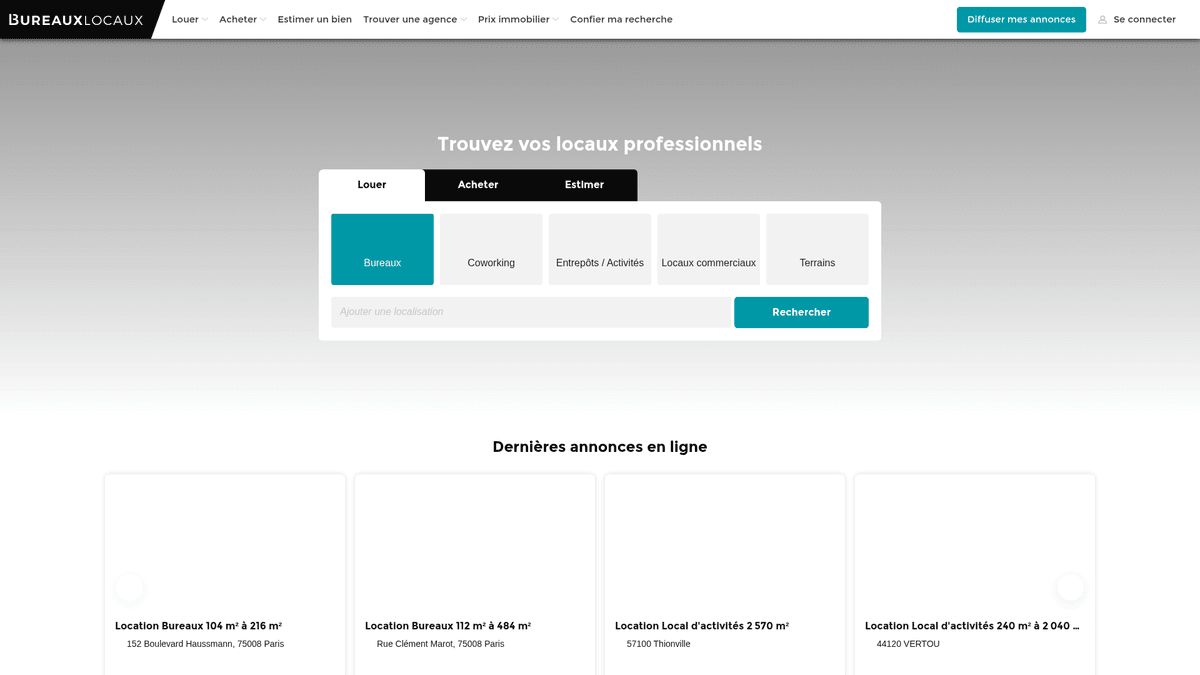

Sobre BureauxLocaux

Descubra o que BureauxLocaux oferece e quais dados valiosos podem ser extraídos.

O Marketplace de Imóveis Profissionais da França

BureauxLocaux é a principal plataforma digital na França dedicada ao setor imobiliário profissional, facilitando o aluguel e a venda de escritórios, armazéns, espaços comerciais e hubs de coworking. Propriedade do CoStar Group, a plataforma centraliza dados de mais de 1.800 agências especializadas e hospeda mais de 72.000 anúncios ativos, tornando-se uma fonte definitiva para insights de propriedades B2B.

Inteligência de Mercado Abrangente

A plataforma oferece uma visão granular do cenário comercial francês, desde distritos de negócios parisienses de alta demanda até centros logísticos em Lyon e Marselha. Ela serve como uma ponte vital entre quem busca imóveis e corretores especializados, fornecendo especificações técnicas detalhadas que vão além dos simples pontos de preço.

Por que os Dados Importam

Fazer o scraping do BureauxLocaux é essencial para desenvolvedores imobiliários, investidores e planejadores urbanos. Os anúncios da plataforma fornecem dados em tempo real sobre tendências de preços de aluguel, taxas de vacância e classificações de desempenho energético (DPE), que são críticos para construir market models preditivos e identificar oportunidades de investimento de alto rendimento.

Por Que Fazer Scraping de BureauxLocaux?

Descubra o valor comercial e os casos de uso para extração de dados de BureauxLocaux.

Inteligência de Mercado Comercial

Monitore flutuações de preços de aluguel e venda em tempo real para escritórios e armazéns em diferentes regiões da França para identificar polos de negócios emergentes.

Geração de Leads B2B

Identifique agências imobiliárias comerciais especializadas em nichos específicos, como logística ou varejo de luxo, para oferecer serviços profissionais como reformas de escritórios ou seguros.

Sourcing de Oportunidades de Investimento

Detecte propriedades subavaliadas ou oportunidades urgentes de sublocação em distritos comerciais nobres de Paris, rastreando quedas de preços e duração dos anúncios.

Rastreamento de Oferta Industrial

Analise a disponibilidade e as especificações técnicas de armazéns industriais e instalações de armazenamento para apoiar o planejamento de logística e supply chain.

Análise de Indicadores Econômicos

Utilize as taxas de vacância comercial e a metragem quadrada disponível como indicadores antecedentes de crescimento ou declínio econômico regional nas principais cidades francesas.

Desafios do Scraping

Desafios técnicos que você pode encontrar ao fazer scraping de BureauxLocaux.

Proteção Avançada do DataDome

O BureauxLocaux utiliza o DataDome, um sistema sofisticado de gerenciamento de bots que identifica e bloqueia navegadores headless por meio de análise comportamental e de fingerprint.

Informações de Contato Bloqueadas por Interação

Dados sensíveis, como números de telefone de corretores, costumam estar ocultos atrás de botões que exigem um clique físico para serem revelados, o que pode acionar desafios de verificação adicionais.

Restrições Geográficas de Tráfego

O site frequentemente limita ou bloqueia totalmente o tráfego vindo de endereços IP não europeus para evitar tentativas globais de scraping, priorizando usuários locais.

Formatos de Dados Fragmentados

Os preços são listados de forma inconsistente, como preço por estação de trabalho, preço por m2/ano ou aluguel mensal total, exigindo uma lógica complexa de normalização durante a extração.

Scrape BureauxLocaux com IA

Sem código necessário. Extraia dados em minutos com automação por IA.

Como Funciona

Descreva o que você precisa

Diga à IA quais dados você quer extrair de BureauxLocaux. Apenas digite em linguagem natural — sem código ou seletores.

A IA extrai os dados

Nossa inteligência artificial navega BureauxLocaux, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

Obtenha seus dados

Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Por Que Usar IA para Scraping

A IA facilita o scraping de BureauxLocaux sem escrever código. Nossa plataforma com inteligência artificial entende quais dados você quer — apenas descreva em linguagem natural e a IA os extrai automaticamente.

How to scrape with AI:

- Descreva o que você precisa: Diga à IA quais dados você quer extrair de BureauxLocaux. Apenas digite em linguagem natural — sem código ou seletores.

- A IA extrai os dados: Nossa inteligência artificial navega BureauxLocaux, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

- Obtenha seus dados: Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Why use AI for scraping:

- Ignorando a Segurança do DataDome: O Automatio foi projetado para navegar por escudos avançados de bots como o DataDome sem disparar bloqueios, garantindo uma coleta de dados consistente.

- Extração Visual de Dados: O seletor visual no-code permite que você aponte e clique em atributos técnicos complexos, como classificações de energia ou comodidades do edifício, sem escrever seletores CSS personalizados.

- Proxies Franceses Integrados: Conecte facilmente proxies residenciais franceses para imitar o comportamento de navegação local, o que é essencial para acessar anúncios regionais e evitar bloqueios por reputação de IP.

- Interações de UI Automatizadas: Configure a ferramenta para lidar automaticamente com o banner de consentimento de cookies da Axeptio e clicar nos botões 'Revelar' para capturar detalhes de contato ocultos.

Scrapers Web No-Code para BureauxLocaux

Alternativas point-and-click ao scraping com IA

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de BureauxLocaux sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

Desafios Comuns

Curva de aprendizado

Compreender seletores e lógica de extração leva tempo

Seletores quebram

Mudanças no site podem quebrar todo o fluxo de trabalho

Problemas com conteúdo dinâmico

Sites com muito JavaScript requerem soluções complexas

Limitações de CAPTCHA

A maioria das ferramentas requer intervenção manual para CAPTCHAs

Bloqueio de IP

Scraping agressivo pode resultar no bloqueio do seu IP

Scrapers Web No-Code para BureauxLocaux

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de BureauxLocaux sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

- Instalar extensão do navegador ou registrar-se na plataforma

- Navegar até o site alvo e abrir a ferramenta

- Selecionar com point-and-click os elementos de dados a extrair

- Configurar seletores CSS para cada campo de dados

- Configurar regras de paginação para scraping de múltiplas páginas

- Resolver CAPTCHAs (frequentemente requer intervenção manual)

- Configurar agendamento para execuções automáticas

- Exportar dados para CSV, JSON ou conectar via API

Desafios Comuns

- Curva de aprendizado: Compreender seletores e lógica de extração leva tempo

- Seletores quebram: Mudanças no site podem quebrar todo o fluxo de trabalho

- Problemas com conteúdo dinâmico: Sites com muito JavaScript requerem soluções complexas

- Limitações de CAPTCHA: A maioria das ferramentas requer intervenção manual para CAPTCHAs

- Bloqueio de IP: Scraping agressivo pode resultar no bloqueio do seu IP

Exemplos de Código

import requests

from bs4 import BeautifulSoup

# Nota: Isso pode ser bloqueado pelo Cloudflare sem headers/proxies avançados

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Exemplo: Selecionando cards de anúncios

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Anúncio: {title} | Preço: {price}')

except Exception as e:

print(f'Falha no scraping: {e}')Quando Usar

Ideal para páginas HTML estáticas com JavaScript mínimo. Perfeito para blogs, sites de notícias e páginas de produtos e-commerce simples.

Vantagens

- ●Execução mais rápida (sem overhead do navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar com asyncio

- ●Ótimo para APIs e páginas estáticas

Limitações

- ●Não pode executar JavaScript

- ●Falha em SPAs e conteúdo dinâmico

- ●Pode ter dificuldades com sistemas anti-bot complexos

Como Fazer Scraping de BureauxLocaux com Código

Python + Requests

import requests

from bs4 import BeautifulSoup

# Nota: Isso pode ser bloqueado pelo Cloudflare sem headers/proxies avançados

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Exemplo: Selecionando cards de anúncios

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Anúncio: {title} | Preço: {price}')

except Exception as e:

print(f'Falha no scraping: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Lançar com stealth ou UA específico é recomendado

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Navegar para os resultados de busca

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Esperar que os anúncios sejam renderizados

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contatar agente"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Percorre cada card de imóvel na página

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Paginação: Encontra o link da 'Próxima' página

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Define um User-Agent realista

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Extrai dados dos elementos da listagem

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();O Que Você Pode Fazer Com Os Dados de BureauxLocaux

Explore aplicações práticas e insights dos dados de BureauxLocaux.

Indexação de Aluguel Comercial

Analistas financeiros podem construir um índice dinâmico de custos de aluguel de escritórios para aconselhar clientes corporativos sobre estratégia de localização.

Como implementar:

- 1Colete todos os anúncios de escritórios ativos nas principais cidades francesas semanalmente.

- 2Calcule o preço por metro quadrado por ano para cada entrada.

- 3Agrupe os dados por distrito (Arrondissement) para identificar clusters de preços.

- 4Visualize o 'Mapa de Calor de Preços' usando uma ferramenta de mapeamento como o Tableau.

Use Automatio para extrair dados de BureauxLocaux e construir essas aplicações sem escrever código.

O Que Você Pode Fazer Com Os Dados de BureauxLocaux

- Indexação de Aluguel Comercial

Analistas financeiros podem construir um índice dinâmico de custos de aluguel de escritórios para aconselhar clientes corporativos sobre estratégia de localização.

- Colete todos os anúncios de escritórios ativos nas principais cidades francesas semanalmente.

- Calcule o preço por metro quadrado por ano para cada entrada.

- Agrupe os dados por distrito (Arrondissement) para identificar clusters de preços.

- Visualize o 'Mapa de Calor de Preços' usando uma ferramenta de mapeamento como o Tableau.

- Geração de Leads Imobiliários

Provedores de serviços B2B podem encontrar empresas que estão se mudando para novos espaços e que precisam de configuração de TI, móveis ou seguros.

- Direcione anúncios marcados como 'Disponível Recentemente' ou 'Novo no Mercado'.

- Extraia os detalhes de contato da agência anunciante para prospecção de parcerias.

- Rastreie a remoção de propriedades para estimar quando uma empresa assinou um contrato com sucesso.

- Automatize uma entrada no CRM para novos projetos potenciais de renovação de escritórios.

- Rastreamento de Duração de Vacância

Pesquisadores econômicos podem monitorar quanto tempo as propriedades industriais permanecem no mercado para avaliar a saúde econômica local.

- Colete todos os anúncios de armazéns e armazene a data em que foram vistos pela primeira vez.

- Verifique continuamente quais anúncios ainda estão ativos em comparação aos removidos.

- Calcule o 'Tempo de Mercado' (ToM) médio para cada zona industrial.

- Correlacione o ToM alto com crises econômicas regionais específicas.

- Automação de Filtro de Investimento

Investidores podem receber alertas instantâneos quando propriedades caem abaixo de um determinado limite de preço em áreas específicas.

- Configure uma coleta diária para categorias específicas como 'Vente de Bureaux'.

- Compare o preço diário com a média histórica para aquele código postal específico.

- Acione uma notificação se um anúncio for precificado 15% abaixo da média do mercado.

- Exporte as ofertas filtradas para uma Google Sheet para revisão imediata.

Potencialize seu fluxo de trabalho com Automacao de IA

Automatio combina o poder de agentes de IA, automacao web e integracoes inteligentes para ajuda-lo a realizar mais em menos tempo.

Dicas Pro para Scraping de BureauxLocaux

Dicas de especialistas para extrair dados com sucesso de BureauxLocaux.

Priorize IPs Residenciais Franceses

Usar proxies baseados na França é a maneira mais eficaz de evitar ser sinalizado pelos filtros de segurança regionais do site.

Considere os Sufixos de Impostos

Certifique-se de que seus parsers de preço reconheçam 'HT' (Hors Taxes) e 'HC' (Hors Charges) para calcular com precisão o custo total dos anúncios comerciais.

Monitore Requisições XHR Internas

Inspecione o tráfego de rede para encontrar os endpoints JSON internos que o site usa para popular os anúncios, permitindo uma extração mais eficiente e estruturada.

Implemente Delays Aleatórios

Introduza tempos de espera variáveis entre o carregamento das páginas e as interações para replicar padrões de navegação humana e permanecer abaixo dos limites de rate-limiting.

Gerencie Consentimentos de Cookies Primeiro

Garanta que seu scraper interaja ou oculte o modal de consentimento de cookies ao carregar a página para evitar que ele sobreponha e bloqueie o acesso aos elementos do anúncio.

Depoimentos

O Que Nossos Usuarios Dizem

Junte-se a milhares de usuarios satisfeitos que transformaram seu fluxo de trabalho

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Perguntas Frequentes Sobre BureauxLocaux

Encontre respostas para perguntas comuns sobre BureauxLocaux