Como fazer scraping do We Work Remotely: O Guia Definitivo

Saiba como extrair listagens de vagas do We Work Remotely. Extraia títulos de vagas, empresas, salários e muito mais para pesquisa de mercado ou para seu...

Proteção Anti-Bot Detectada

- Cloudflare

- WAF e gestão de bots de nível empresarial. Usa desafios JavaScript, CAPTCHAs e análise comportamental. Requer automação de navegador com configurações stealth.

- Bloqueio de IP

- Bloqueia IPs de data centers conhecidos e endereços sinalizados. Requer proxies residenciais ou móveis para contornar efetivamente.

- Limitação de taxa

- Limita requisições por IP/sessão ao longo do tempo. Pode ser contornado com proxies rotativos, atrasos de requisição e scraping distribuído.

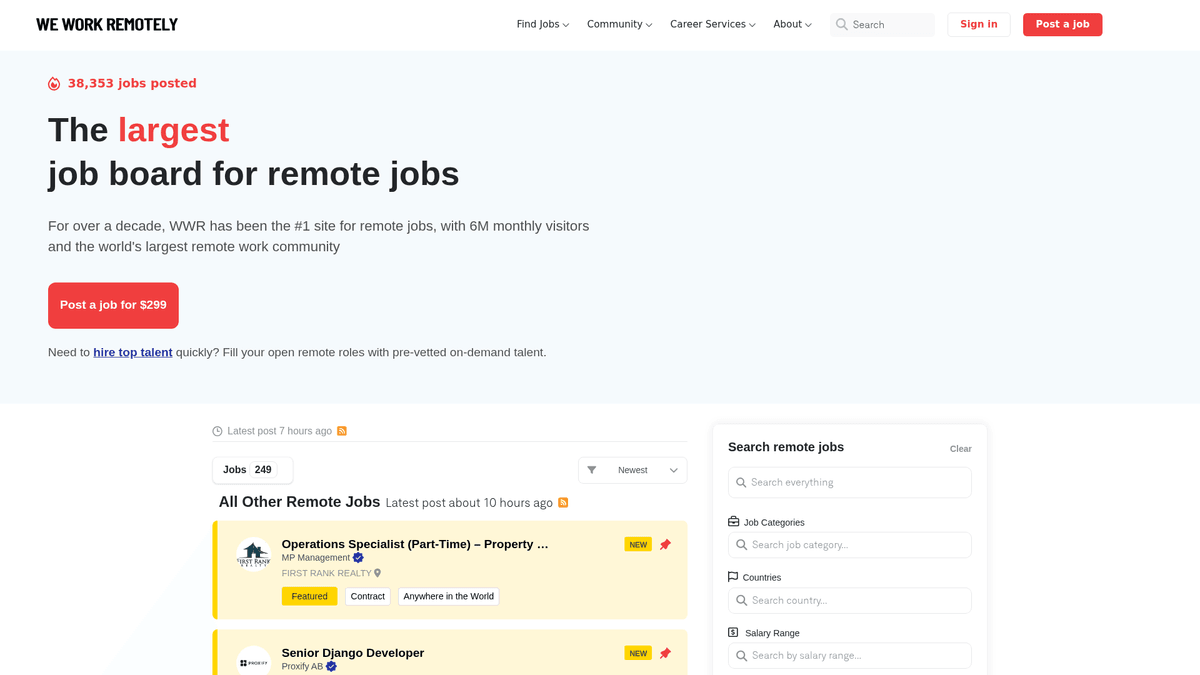

Sobre We Work Remotely

Descubra o que We Work Remotely oferece e quais dados valiosos podem ser extraídos.

O Hub Global para Talentos Remotos

We Work Remotely (WWR) é a comunidade de trabalho remoto mais estabelecida do mundo, contando com mais de 6 milhões de visitantes mensais. Atua como o principal destino para empresas que estão se afastando dos modelos tradicionais baseados em escritórios, oferecendo uma gama diversificada de listagens em desenvolvimento de software, design, marketing e suporte ao cliente.

Dados Estruturados de Alta Qualidade

A plataforma é conhecida por seus dados altamente estruturados. Cada listagem normalmente contém requisitos regionais específicos, faixas salariais e perfis detalhados das empresas. Essa estrutura a torna um alvo ideal para web scraping, já que os dados são consistentes e fáceis de categorizar para casos de uso secundários.

Valor Estratégico para Profissionais de Dados

Para recrutadores e pesquisadores de mercado, o WWR é uma mina de ouro. O scraping deste site permite o acompanhamento em tempo real das tendências de contratação, benchmark de salários em diferentes setores técnicos e geração de leads para serviços B2B focados em empresas remote-first. Ele oferece uma visão transparente do mercado de trabalho remoto global.

Por Que Fazer Scraping de We Work Remotely?

Descubra o valor comercial e os casos de uso para extração de dados de We Work Remotely.

Análise de Demanda de Mercado

Acompanhe quais linguagens de programação, frameworks e soft skills estão em tendência no cenário de trabalho remoto para se antecipar às mudanças do mercado.

Benchmark de Salários

Extraia dados salariais das listagens para criar relatórios de remuneração abrangentes para empresas remote-first em diversos cargos técnicos e criativos.

Geração de Leads B2B

Identifique empresas que estão escalando ativamente suas equipes remotas para oferecer serviços especializados como HR tech, soluções de folha de pagamento ou consultoria de recrutamento.

Agregação de Vagas de Nicho

Alimente um quadro de vagas especializado filtrando e agregando listagens remotas de alta qualidade em nichos específicos como Web3, AI ou Design.

Inteligência Competitiva

Monitore a velocidade de contratação e as preferências geográficas de seus concorrentes para entender sua estratégia de crescimento e potenciais áreas de expansão.

Desafios do Scraping

Desafios técnicos que você pode encontrar ao fazer scraping de We Work Remotely.

Detecção de Bot do Cloudflare

O WWR utiliza a camada de segurança do Cloudflare, que pode detectar e bloquear scripts automatizados padrão que não imitam adequadamente o comportamento de um navegador humano.

Dados Salariais Não Estruturados

As informações salariais são frequentemente inseridas nas descrições de texto em formatos variados, exigindo padrões complexos de regex para extrair e normalizar em valores numéricos.

Carregamento de Conteúdo Dinâmico

Navegar entre as listagens gerais e a paginação 'Carregar Mais' requer um scraper capaz de lidar com requisições assíncronas sem perder a integridade dos dados.

Estruturas HTML Variáveis

Listagens em destaque e listagens padrão às vezes usam classes CSS ligeiramente diferentes, necessitando de seletores flexíveis para garantir que nenhuma vaga seja perdida.

Scrape We Work Remotely com IA

Sem código necessário. Extraia dados em minutos com automação por IA.

Como Funciona

Descreva o que você precisa

Diga à IA quais dados você quer extrair de We Work Remotely. Apenas digite em linguagem natural — sem código ou seletores.

A IA extrai os dados

Nossa inteligência artificial navega We Work Remotely, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

Obtenha seus dados

Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Por Que Usar IA para Scraping

A IA facilita o scraping de We Work Remotely sem escrever código. Nossa plataforma com inteligência artificial entende quais dados você quer — apenas descreva em linguagem natural e a IA os extrai automaticamente.

How to scrape with AI:

- Descreva o que você precisa: Diga à IA quais dados você quer extrair de We Work Remotely. Apenas digite em linguagem natural — sem código ou seletores.

- A IA extrai os dados: Nossa inteligência artificial navega We Work Remotely, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

- Obtenha seus dados: Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Why use AI for scraping:

- Gerenciamento Automatizado de Anti-Bot: O Automatio gerencia nativamente a rotação de proxy e o fingerprinting do navegador para contornar o Cloudflare e outras medidas de segurança sem configuração manual.

- Seleção Visual No-Code: Selecione facilmente títulos de vagas, nomes de empresas e descrições usando uma interface de apontar e clicar em vez de escrever seletores CSS ou XPath complexos.

- Monitoramento Agendado: Configure seu scraper para rodar a cada hora ou dia para detectar e extrair automaticamente as novas vagas remotas no momento em que forem publicadas.

- Exportação de Dados Fluida: Envie diretamente suas listagens de vagas extraídas para Google Sheets, Airtable ou um Webhook para alimentar sua aplicação ou CRM em tempo real.

Scrapers Web No-Code para We Work Remotely

Alternativas point-and-click ao scraping com IA

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de We Work Remotely sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

Desafios Comuns

Curva de aprendizado

Compreender seletores e lógica de extração leva tempo

Seletores quebram

Mudanças no site podem quebrar todo o fluxo de trabalho

Problemas com conteúdo dinâmico

Sites com muito JavaScript requerem soluções complexas

Limitações de CAPTCHA

A maioria das ferramentas requer intervenção manual para CAPTCHAs

Bloqueio de IP

Scraping agressivo pode resultar no bloqueio do seu IP

Scrapers Web No-Code para We Work Remotely

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de We Work Remotely sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

- Instalar extensão do navegador ou registrar-se na plataforma

- Navegar até o site alvo e abrir a ferramenta

- Selecionar com point-and-click os elementos de dados a extrair

- Configurar seletores CSS para cada campo de dados

- Configurar regras de paginação para scraping de múltiplas páginas

- Resolver CAPTCHAs (frequentemente requer intervenção manual)

- Configurar agendamento para execuções automáticas

- Exportar dados para CSV, JSON ou conectar via API

Desafios Comuns

- Curva de aprendizado: Compreender seletores e lógica de extração leva tempo

- Seletores quebram: Mudanças no site podem quebrar todo o fluxo de trabalho

- Problemas com conteúdo dinâmico: Sites com muito JavaScript requerem soluções complexas

- Limitações de CAPTCHA: A maioria das ferramentas requer intervenção manual para CAPTCHAs

- Bloqueio de IP: Scraping agressivo pode resultar no bloqueio do seu IP

Exemplos de Código

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Enviar requisição com headers customizados

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Alvo: listagens de vagas

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Vaga: {title} | Empresa: {company}')

except Exception as e:

print(f'Erro: {e}')Quando Usar

Ideal para páginas HTML estáticas com JavaScript mínimo. Perfeito para blogs, sites de notícias e páginas de produtos e-commerce simples.

Vantagens

- ●Execução mais rápida (sem overhead do navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar com asyncio

- ●Ótimo para APIs e páginas estáticas

Limitações

- ●Não pode executar JavaScript

- ●Falha em SPAs e conteúdo dinâmico

- ●Pode ter dificuldades com sistemas anti-bot complexos

Como Fazer Scraping de We Work Remotely com Código

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://weworkremotely.com/'

headers = {'User-Agent': 'Mozilla/5.0'}

try:

# Enviar requisição com headers customizados

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# Alvo: listagens de vagas

jobs = soup.find_all('li', class_='feature')

for job in jobs:

title = job.find('span', class_='title').text.strip()

company = job.find('span', class_='company').text.strip()

print(f'Vaga: {title} | Empresa: {company}')

except Exception as e:

print(f'Erro: {e}')Python + Playwright

import asyncio

from playwright.async_api import async_playwright

async def run():

async with async_playwright() as p:

# Iniciar navegador headless

browser = await p.chromium.launch(headless=True)

page = await browser.new_page()

await page.goto('https://weworkremotely.com/')

# Aguardar o carregamento do container principal

await page.wait_for_selector('.jobs-container')

jobs = await page.query_selector_all('li.feature')

for job in jobs:

title = await job.query_selector('.title')

if title:

print(await title.inner_text())

await browser.close()

asyncio.run(run())Python + Scrapy

import scrapy

class WwrSpider(scrapy.Spider):

name = 'wwr_spider'

start_urls = ['https://weworkremotely.com/']

def parse(self, response):

# Iterar pelos itens da listagem

for job in response.css('li.feature'):

yield {

'title': job.css('span.title::text').get(),

'company': job.css('span.company::text').get(),

'url': response.urljoin(job.css('a::attr(href)').get())

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://weworkremotely.com/');

// Extrair dados usando evaluate

const jobs = await page.evaluate(() => {

return Array.from(document.querySelectorAll('li.feature')).map(li => ({

title: li.querySelector('.title')?.innerText.trim(),

company: li.querySelector('.company')?.innerText.trim()

}));

});

console.log(jobs);

await browser.close();

})();O Que Você Pode Fazer Com Os Dados de We Work Remotely

Explore aplicações práticas e insights dos dados de We Work Remotely.

Agregador de Vagas Remotas

Construa uma plataforma especializada de busca de emprego para nichos técnicos específicos, como Rust ou AI.

Como implementar:

- 1Fazer scraping diário do WWR em busca de novas listagens

- 2Filtrar por palavras-chave e categorias específicas

- 3Armazenar dados em um banco de dados pesquisável

- 4Automatizar postagens em redes sociais para novas vagas

Use Automatio para extrair dados de We Work Remotely e construir essas aplicações sem escrever código.

O Que Você Pode Fazer Com Os Dados de We Work Remotely

- Agregador de Vagas Remotas

Construa uma plataforma especializada de busca de emprego para nichos técnicos específicos, como Rust ou AI.

- Fazer scraping diário do WWR em busca de novas listagens

- Filtrar por palavras-chave e categorias específicas

- Armazenar dados em um banco de dados pesquisável

- Automatizar postagens em redes sociais para novas vagas

- Análise de Tendências Salariais

Analise dados salariais remotos para determinar benchmarks de remuneração global entre diferentes funções.

- Extrair campos de salário das descrições de vagas

- Normalizar os dados em uma única moeda

- Segmentar por cargo e nível de experiência

- Gerar relatórios de mercado trimestrais

- Geração de Leads para HR Tech

Identifique empresas que estão contratando equipes remotas agressivamente para vender softwares de RH, folha de pagamento e benefícios.

- Monitorar a lista das '100 Melhores Empresas Remotas'

- Rastrear a frequência de novas postagens de vagas

- Identificar tomadores de decisão nas empresas que estão contratando

- Realizar prospecção com soluções B2B personalizadas

- Tendências Históricas de Contratação

Analise dados de longo prazo para entender como a demanda por trabalho remoto muda sazonalmente ou economicamente.

- Arquivar listagens ao longo de mais de 12 meses

- Calcular taxas de crescimento por categoria

- Visualizar tendências usando ferramentas de BI

- Prever a demanda futura por habilidades

Potencialize seu fluxo de trabalho com Automacao de IA

Automatio combina o poder de agentes de IA, automacao web e integracoes inteligentes para ajuda-lo a realizar mais em menos tempo.

Dicas Pro para Scraping de We Work Remotely

Dicas de especialistas para extrair dados com sucesso de We Work Remotely.

Faça o Parse dos Feeds RSS Primeiro

Verifique os endpoints /remote-jobs.rss para várias categorias; eles oferecem XML estruturado, que é significativamente mais fácil e rápido de fazer o parse do que o HTML principal.

Use URLs Específicas por Categoria

Direcione para URLs como /categories/remote-programming-jobs para obter resultados mais limpos e evitar o ruído da landing page principal.

Rotacione Proxies Residenciais

Para evitar rate limiting em páginas de detalhes, use proxies residenciais, que têm menos probabilidade de serem sinalizados como bots em comparação com IPs de datacenter.

Direcione aos Metadados JSON-LD

Muitas páginas de vagas incluem dados estruturados no formato JSON-LD dentro do HTML, o que fornece dados limpos e prontos para uso para títulos e descrições de vagas.

Randomize os Intervalos de Requisição

Implemente atrasos semelhantes aos humanos entre cliques em diferentes listagens de vagas para evitar que a segurança do site identifique um padrão robótico.

Monitore a Seção 'Top 100'

Faça o scrape da página 'Top 100 Companies' separadamente para identificar alvos de contratação de alto valor que anunciam consistentemente na plataforma.

Depoimentos

O Que Nossos Usuarios Dizem

Junte-se a milhares de usuarios satisfeitos que transformaram seu fluxo de trabalho

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Freelancer.com: A Complete Technical Guide

How to Scrape Upwork: A Comprehensive Technical Guide

How to Scrape Arc.dev: The Complete Guide to Remote Job Data

How to Scrape Toptal | Toptal Web Scraper Guide

How to Scrape Guru.com: A Comprehensive Web Scraping Guide

How to Scrape Fiverr | Fiverr Web Scraper Guide

How to Scrape Indeed: 2025 Guide for Job Market Data

How to Scrape Charter Global | IT Services & Job Board Scraper

Perguntas Frequentes Sobre We Work Remotely

Encontre respostas para perguntas comuns sobre We Work Remotely