Cum să extragi date de pe BureauxLocaux: Ghid de date imobiliare comerciale

Extrageți date imobiliare comerciale de pe BureauxLocaux. Scrapre de prețuri birouri, locații depozite și detalii agenți în Franța pentru cercetare de piață.

Protecție anti-bot detectată

- Cloudflare

- WAF și gestionare bot de nivel enterprise. Folosește provocări JavaScript, CAPTCHA și analiză comportamentală. Necesită automatizare browser cu setări stealth.

- CSRF Protection

- Limitarea ratei

- Limitează cererile per IP/sesiune în timp. Poate fi ocolit cu proxy-uri rotative, întârzieri ale cererilor și scraping distribuit.

- User-Agent Filtering

- Provocare JavaScript

- Necesită executarea JavaScript pentru a accesa conținutul. Cererile simple eșuează; este nevoie de un browser headless precum Playwright sau Puppeteer.

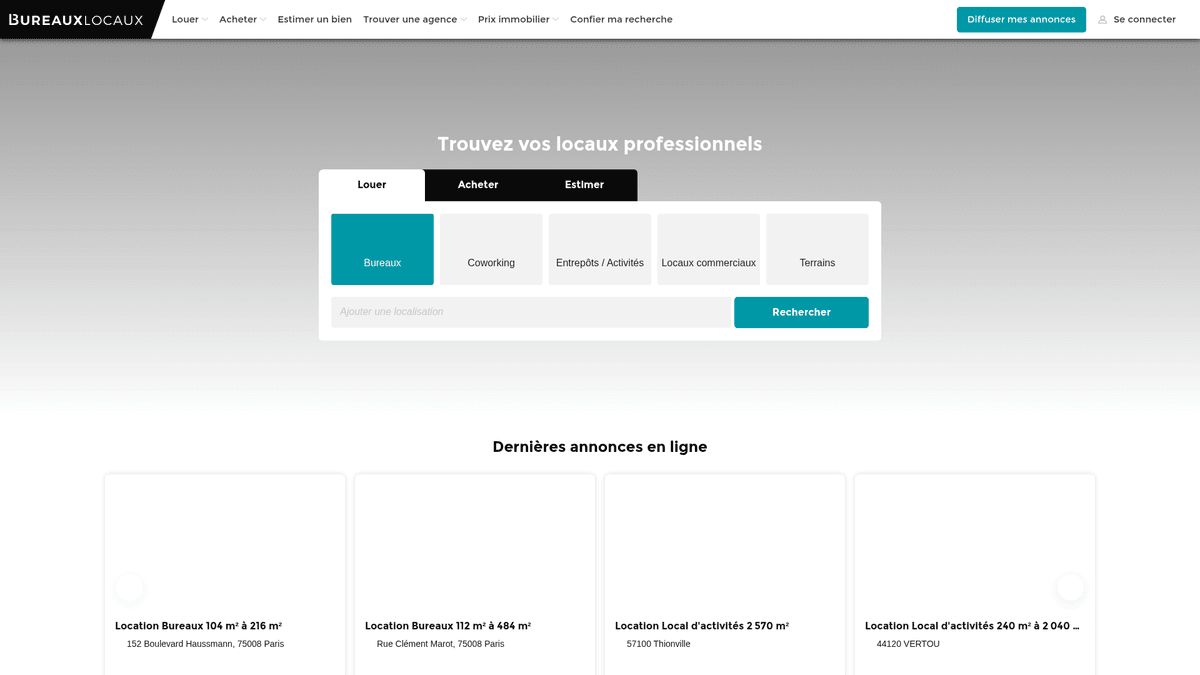

Despre BureauxLocaux

Descoperiți ce oferă BureauxLocaux și ce date valoroase pot fi extrase.

Piața imobiliară profesională din Franța

BureauxLocaux este principala platformă digitală din Franța dedicată imobiliarelor profesionale, facilitând închirierea și vânzarea de birouri, depozite, spații comerciale și hub-uri de coworking. Deținută de CoStar Group, platforma centralizează date de la peste 1.800 de agenții specializate și găzduiește peste 72.000 de listări active, fiind o sursă definitivă pentru insight-uri imobiliare B2B.

Intelligence de piață cuprinzător

Platforma oferă o imagine granulară a peisajului comercial francez, de la districtele de afaceri pariziene cu cerere mare până la hub-urile logistice din Lyon și Marsilia. Aceasta servește ca o punte vitală între cei care caută proprietăți și brokerii specializați, oferind specificații tehnice detaliate care depășesc simplele puncte de preț.

De ce sunt importante datele

Extragerea datelor de pe BureauxLocaux este esențială pentru dezvoltatorii imobiliari, investitori și planificatorii urbani. Listările platformei oferă date în timp real despre tendințele prețurilor de închiriere, ratele de neocupare și ratingurile de performanță energetică (DPE), care sunt critice pentru construirea de modele predictive de piață și identificarea oportunităților de investiții cu randament ridicat.

De Ce Să Faceți Scraping La BureauxLocaux?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din BureauxLocaux.

Monitorizarea fluctuațiilor prețurilor de închiriere comercială în metropolele franceze

Analiza comparativă a portofoliului și a cotei de piață a agențiilor imobiliare specializate

Identificarea lead-urilor cu potențial ridicat pentru servicii de renovare și amenajare a birourilor

Urmărirea ratelor de neocupare a depozitelor industriale pentru planificarea logistică

Analizarea creșterii spațiilor de coworking față de închirierile tradiționale de birouri

Colectarea datelor de antrenare pentru un model de evaluare imobiliară bazat pe AI

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la BureauxLocaux.

Ocolirea managementului agresiv al bot-urilor de la Cloudflare și a provocărilor JS

Extragerea conținutului dinamic încărcat prin cereri AJAX interne

Gestionarea token-urilor CSRF necesare pentru accesarea informațiilor detaliate de contact ale agenților

Normalizarea formatelor fragmentate de date de preț (m2/an vs costuri lunare pe post de lucru)

Adaptarea la schimbările frecvente de structură în grila de atribute a proprietății

Extrage date din BureauxLocaux cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din BureauxLocaux. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează BureauxLocaux, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din BureauxLocaux fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din BureauxLocaux. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează BureauxLocaux, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Ocolește fără probleme securitatea Cloudflare fără codare personalizată

- Gestionează automat randarea JavaScript pentru grilele de listări dinamice

- Rulările programate permit monitorizarea automată a pieței și alerte zilnice

- Utilizează proxy-uri rezidențiale premium pentru a evita limitarea ratei de acces bazată pe IP

- Selectorul vizual facilitează țintirea specificațiilor tehnice complexe ale proprietăților

Scrapere Web No-Code pentru BureauxLocaux

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la BureauxLocaux fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru BureauxLocaux

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la BureauxLocaux fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

from bs4 import BeautifulSoup

# Note: This may be blocked by Cloudflare without advanced headers/proxies

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Example: Selecting listing cards

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape BureauxLocaux with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Note: This may be blocked by Cloudflare without advanced headers/proxies

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9'

}

url = "https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux"

try:

response = requests.get(url, headers=headers, timeout=15)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Example: Selecting listing cards

listings = soup.select('.AnnonceCard')

for item in listings:

title = item.select_one('h2').get_text(strip=True)

price = item.select_one('.price').get_text(strip=True) if item.select_one('.price') else 'N/A'

print(f'Listing: {title} | Price: {price}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_bureaux():

with sync_playwright() as p:

# Launching with stealth or specific UA is recommended

browser = p.chromium.launch(headless=True)

context = browser.new_context(user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36")

page = context.new_page()

# Navigate to the search results

page.goto("https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux", wait_until="networkidle")

# Wait for listings to render

page.wait_for_selector(".AnnonceCard")

listings = page.query_selector_all(".AnnonceCard")

for item in listings:

title = item.query_selector("h2").inner_text()

price = item.query_selector(".price").inner_text() if item.query_selector(".price") else "Contact agent"

print(f"{title}: {price}")

browser.close()

scrape_bureaux()Python + Scrapy

import scrapy

class BureauxSpider(scrapy.Spider):

name = 'bureaux_spider'

start_urls = ['https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux']

def parse(self, response):

# Loop through each property card on the page

for ad in response.css('.AnnonceCard'):

yield {

'title': ad.css('h2::text').get(default='').strip(),

'price': ad.css('.price::text').get(default='').strip(),

'location': ad.css('.location::text').get(default='').strip(),

'url': response.urljoin(ad.css('a::attr(href)').get())

}

# Pagination: Find the 'Next' page link

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/119.0.0.0 Safari/537.36');

await page.goto('https://www.bureauxlocaux.com/immobilier-d-entreprise/annonces/location-bureaux', { waitUntil: 'networkidle2' });

// Extract data from listing elements

const data = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.AnnonceCard'));

return items.map(el => ({

title: el.querySelector('h2')?.innerText.trim(),

price: el.querySelector('.price')?.innerText.trim(),

location: el.querySelector('.location-text')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Ce Puteți Face Cu Datele BureauxLocaux

Explorați aplicațiile practice și informațiile din datele BureauxLocaux.

Indexarea chiriei comerciale

Analiștii financiari pot construi un index dinamic al costurilor de închiriere a birourilor pentru a consilia clienții corporate cu privire la strategia de locație.

Cum se implementează:

- 1Extrageți săptămânal toate listările active de birouri din marile orașe franceze.

- 2Calculați prețul pe metru pătrat pe an pentru fiecare intrare.

- 3Grupați datele pe districte (Arrondissement) pentru a identifica clusterele de prețuri.

- 4Vizualizați un 'Price Heatmap' folosind un instrument de mapping precum Tableau.

Folosiți Automatio pentru a extrage date din BureauxLocaux și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele BureauxLocaux

- Indexarea chiriei comerciale

Analiștii financiari pot construi un index dinamic al costurilor de închiriere a birourilor pentru a consilia clienții corporate cu privire la strategia de locație.

- Extrageți săptămânal toate listările active de birouri din marile orașe franceze.

- Calculați prețul pe metru pătrat pe an pentru fiecare intrare.

- Grupați datele pe districte (Arrondissement) pentru a identifica clusterele de prețuri.

- Vizualizați un 'Price Heatmap' folosind un instrument de mapping precum Tableau.

- Lead Gen imobiliar

Furnizorii de servicii B2B pot găsi companii care se mută în spații noi și care necesită configurare IT, mobilier sau asigurări.

- Țintiți listările marcate ca 'Recent disponibile' sau 'Noi pe piață'.

- Extrageți datele de contact ale agenției care a publicat anunțul pentru parteneriate.

- Urmăriți eliminarea proprietăților pentru a estima când o companie a semnat cu succes un contract de închiriere.

- Automatizați o intrare în CRM pentru noi proiecte potențiale de renovare a birourilor.

- Monitorizarea duratei de neocupare

Cercetătorii economici pot monitoriza cât timp proprietățile industriale rămân pe piață pentru a evalua sănătatea economică locală.

- Extrageți toate listările de depozite și stocați data la care au fost 'Văzute prima dată'.

- Verificați continuu care listări sunt încă active versus cele eliminate.

- Calculați media 'Time on Market' (ToM) pentru fiecare zonă industrială.

- Corelați un ToM ridicat cu recesiuni economice regionale specifice.

- Automatizarea filtrelor de investiții

Investitorii pot primi alerte instantanee atunci când proprietățile scad sub un anumit prag de preț în zone specifice.

- Configurați o extragere zilnică pentru categorii specifice, cum ar fi 'Vente de Bureaux'.

- Comparați prețul zilnic cu media istorică pentru acel cod poștal specific.

- Declanșați o notificare dacă o listare are un preț cu 15% sub media pieței.

- Exportați ofertele filtrate într-un Google Sheet pentru revizuire imediată.

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La BureauxLocaux

Sfaturi de la experți pentru extragerea cu succes a datelor din BureauxLocaux.

Utilizați proxy-uri rezidențiale de înaltă calitate, specifice Franței, pentru a evita blocările bazate pe regiune.

Luați întotdeauna în considerare 'HT' (Hors Taxes) și 'HC' (Hors Charges) în parser-ele de preț pentru a evita denaturarea datelor.

Monitorizați tab-ul 'Network' pentru a găsi endpoint-urile JSON interne utilizate pentru încărcarea dinamică.

Rotați User-Agents și browser fingerprints pentru a preveni detecția prin analiza comportamentală a Cloudflare.

Implementați un interval de sleep aleatoriu (3-10 secunde) între încărcările paginilor pentru a simula comportamentul uman.

Stocați ID-ul de referință al anunțului (Listing Reference ID) ca o cheie unică pentru a urmări modificările de preț în timp, fără a duplica înregistrările.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape Century 21 Property Listings

How to Scrape Geolocaux | Geolocaux Web Scraper Guide

How to Scrape HotPads: A Complete Guide to Extracting Rental Data

How to Scrape Sacramento Delta Property Management

How to Scrape Progress Residential Website

How to Scrape LivePiazza: Philadelphia Real Estate Scraper

How to Scrape Homes.com: Real Estate Data Extraction Guide

How to Scrape Century 21: A Technical Real Estate Guide

Intrebari frecvente despre BureauxLocaux

Gaseste raspunsuri la intrebarile comune despre BureauxLocaux