Cum să extragi date din WebElements: Ghid pentru datele Tabelului Periodic

Extrage date precise despre elementele chimice din WebElements. Extrage greutăți atomice, proprietăți fizice și istoricul descoperirilor pentru cercetare și...

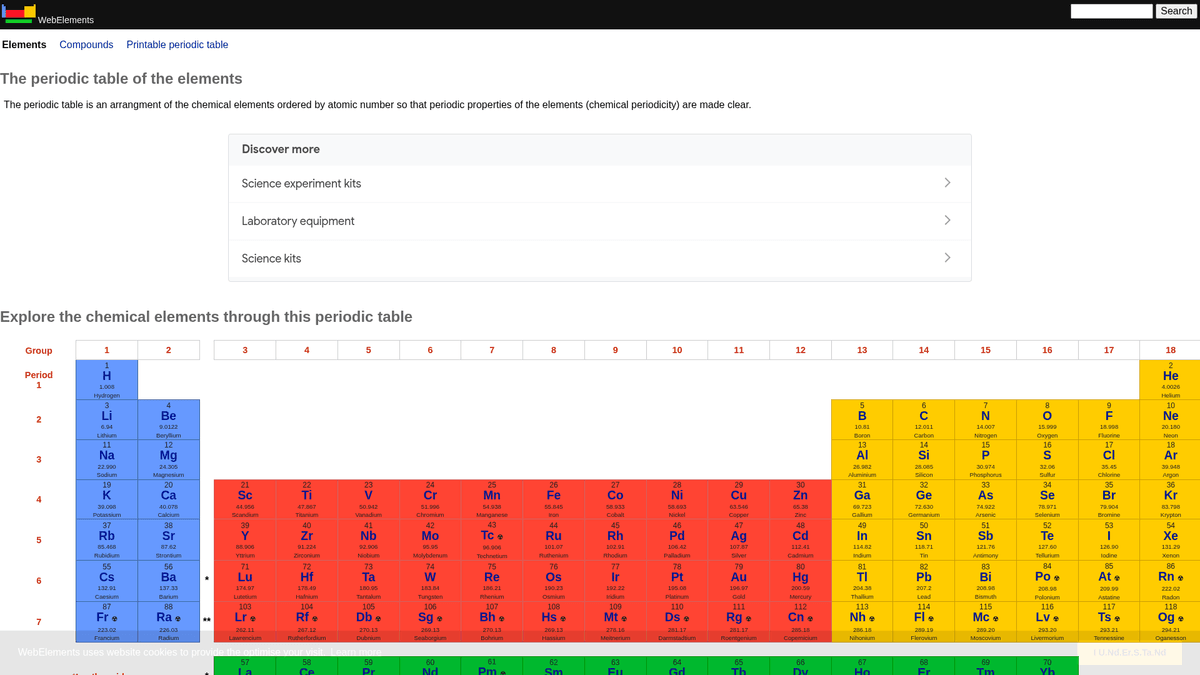

Despre WebElements

Descoperiți ce oferă WebElements și ce date valoroase pot fi extrase.

WebElements este un tabel periodic online de top, întreținut de Mark Winter la Universitatea din Sheffield. Lansat în 1993, a fost primul tabel periodic de pe World Wide Web și a devenit de atunci o resursă cu autoritate ridicată pentru studenți, cadre universitare și chimiști profesioniști. Site-ul oferă date profunde și structurate despre fiecare element chimic cunoscut, de la greutăți atomice standard la configurații electronice complexe.

Valoarea extragerii datelor din WebElements constă în datele sale științifice de înaltă calitate, evaluate de experți. Pentru dezvoltatorii care construiesc instrumente educaționale, cercetătorii care efectuează analize de tendințe în tabelul periodic sau oamenii de știință în materiale care antrenează modele de machine learning, WebElements oferă o sursă de adevăr fiabilă și bogată din punct de vedere tehnic, care este dificil de agregat manual.

De Ce Să Faceți Scraping La WebElements?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din WebElements.

Colectarea de date științifice de înaltă calitate pentru dezvoltarea de instrumente educaționale.

Agregarea proprietăților elementelor pentru cercetarea în știința materialelor și modele de machine learning.

Popularea automată a sistemelor de inventar de laborator cu specificații chimice.

Analiza istorică a descoperirilor elementelor și a progresului științific.

Crearea de seturi de date cuprinzătoare despre proprietățile chimice pentru publicații academice.

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la WebElements.

Datele sunt răspândite pe mai multe sub-pagini per element (ex: /history, /compounds).

Layout-urile HTML vechi bazate pe tabele necesită o logică de selecție precisă.

Confuzia numelui de domeniu cu clasa 'WebElement' din Selenium atunci când cauți asistență.

Extrage date din WebElements cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din WebElements. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează WebElements, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din WebElements fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din WebElements. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează WebElements, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Navigare no-code prin structuri ierarhice de elemente.

- Gestionează automat extragerea tabelelor științifice complexe.

- Execuția în cloud permite extragerea întregului set de date fără timp de nefuncționare local.

- Export ușor în CSV/JSON pentru utilizare directă în instrumente de analiză științifică.

- Monitorizarea programată poate detecta actualizări ale datelor confirmate ale elementelor.

Scrapere Web No-Code pentru WebElements

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la WebElements fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru WebElements

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la WebElements fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

from bs4 import BeautifulSoup

import time

# URL țintă pentru un element specific (ex: Aur)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extragerea numelui elementului din tag-ul H1

name = soup.find('h1').get_text().strip()

# Extragerea Numărului Atomic folosind logica etichetelor de tabel

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'A apărut o eroare: {e}')

# Respectarea recomandărilor din robots.txt

time.sleep(1)

scrape_element(url)Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape WebElements with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

import time

# URL țintă pentru un element specific (ex: Aur)

url = 'https://www.webelements.com/gold/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

def scrape_element(element_url):

try:

response = requests.get(element_url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extragerea numelui elementului din tag-ul H1

name = soup.find('h1').get_text().strip()

# Extragerea Numărului Atomic folosind logica etichetelor de tabel

atomic_number = soup.find('th', string=lambda s: s and 'Atomic number' in s).find_next('td').text.strip()

print(f'Element: {name}, Atomic Number: {atomic_number}')

except Exception as e:

print(f'A apărut o eroare: {e}')

# Respectarea recomandărilor din robots.txt

time.sleep(1)

scrape_element(url)Python + Playwright

from playwright.sync_api import sync_playwright

def run():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Elementele sunt legate din tabelul periodic principal

page.goto('https://www.webelements.com/iron/')

# Așteaptă ca tabelul de proprietăți să fie prezent

page.wait_for_selector('table')

element_data = {

'name': page.inner_text('h1'),

'density': page.locator('th:has-text("Density") + td').inner_text().strip()

}

print(element_data)

browser.close()

run()Python + Scrapy

import scrapy

class ElementsSpider(scrapy.Spider):

name = 'elements'

start_urls = ['https://www.webelements.com/']

def parse(self, response):

# Urmărește fiecare link al elementelor din tabelul periodic

for link in response.css('table a[title]::attr(href)'):

yield response.follow(link, self.parse_element)

def parse_element(self, response):

yield {

'name': response.css('h1::text').get().strip(),

'symbol': response.xpath('//th[contains(text(), "Symbol")]/following-sibling::td/text()').get().strip(),

'atomic_number': response.xpath('//th[contains(text(), "Atomic number")]/following-sibling::td/text()').get().strip(),

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.webelements.com/silver/');

const data = await page.evaluate(() => {

const name = document.querySelector('h1').innerText;

const meltingPoint = Array.from(document.querySelectorAll('th'))

.find(el => el.textContent.includes('Melting point'))

?.nextElementSibling.innerText;

return { name, meltingPoint };

});

console.log('Extracted Data:', data);

await browser.close();

})();Ce Puteți Face Cu Datele WebElements

Explorați aplicațiile practice și informațiile din datele WebElements.

Antrenarea AI în știința materialelor

Antrenarea de modele machine learning pentru a prezice proprietățile noilor aliaje pe baza atributelor elementare.

Cum se implementează:

- 1Extrage proprietățile fizice pentru toate elementele metalice.

- 2Curăță și normalizează valorile precum densitatea și punctele de topire.

- 3Introdu datele în modele de regresie sau modele predictive pentru materiale.

- 4Verifică predicțiile în raport cu datele experimentale existente despre aliaje.

Folosiți Automatio pentru a extrage date din WebElements și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele WebElements

- Antrenarea AI în știința materialelor

Antrenarea de modele machine learning pentru a prezice proprietățile noilor aliaje pe baza atributelor elementare.

- Extrage proprietățile fizice pentru toate elementele metalice.

- Curăță și normalizează valorile precum densitatea și punctele de topire.

- Introdu datele în modele de regresie sau modele predictive pentru materiale.

- Verifică predicțiile în raport cu datele experimentale existente despre aliaje.

- Conținut pentru aplicații educaționale

Popularea tabelelor periodice interactive pentru studenții la chimie cu date evaluate de experți.

- Extrage numerele atomice, simbolurile și descrierile elementelor.

- Extrage contextul istoric și detaliile descoperirii.

- Organizează datele pe grupe și blocuri periodice.

- Integrează-le într-o interfață de utilizator cu structuri cristaline vizuale.

- Analiza tendințelor chimice

Vizualizarea tendințelor periodice, cum ar fi energia de ionizare sau raza atomică, de-a lungul perioadelor și grupelor.

- Colectează date despre proprietăți pentru fiecare element în ordine numerică.

- Categorisește elementele în grupele lor respective.

- Folosește biblioteci grafice pentru a vizualiza tendințele.

- Identifică și analizează punctele de date anormale în blocuri specifice.

- Gestionarea inventarului de laborator

Auto-popularea sistemelor de management chimic cu date de siguranță fizică și densitate.

- Corelează lista de inventar intern cu intrările din WebElements.

- Extrage date despre densitate, pericole de depozitare și puncte de topire.

- Actualizează baza de date centralizată a laboratorului prin API.

- Generează avertismente automate de siguranță pentru elementele cu risc ridicat.

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La WebElements

Sfaturi de la experți pentru extragerea cu succes a datelor din WebElements.

Respectă Crawl-delay

1 specificat în fișierul robots.txt al site-ului.

Folosește Numărul Atomic ca cheie primară pentru consistența bazei de date.

Extrage date din sub-paginile 'history' și 'compounds' pentru un set complet de date per element.

Concentrează-te pe selectori bazați pe tabele, deoarece structura site-ului este extrem de tradițională și stabilă.

Verifică datele conform standardelor IUPAC dacă sunt folosite pentru cercetări critice.

Stochează valorile numerice precum densitatea sau punctele de topire ca float-uri pentru o analiză mai ușoară.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape GitHub | The Ultimate 2025 Technical Guide

How to Scrape Britannica: Educational Data Web Scraper

How to Scrape RethinkEd: A Technical Data Extraction Guide

How to Scrape Worldometers for Real-Time Global Statistics

How to Scrape Wikipedia: The Ultimate Web Scraping Guide

How to Scrape Pollen.com: Local Allergy Data Extraction Guide

How to Scrape Weather.com: A Guide to Weather Data Extraction

How to Scrape American Museum of Natural History (AMNH)

Intrebari frecvente despre WebElements

Gaseste raspunsuri la intrebarile comune despre WebElements